如何了解机器学习并快速入门?

听课(数据科学小组 机器学习小组),看《西瓜书》, 看吴恩达的视频教程,甚至听博客,看知乎问答...

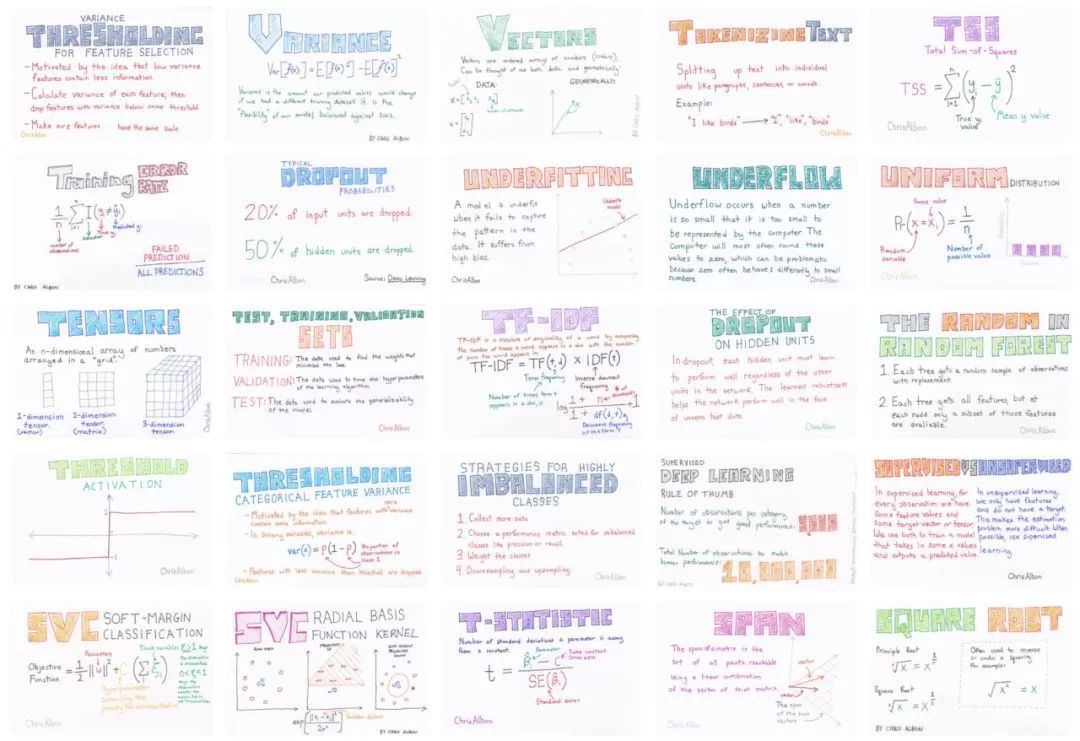

但是, 机器学习是一个集合了计算机、统计学和数学知识的交叉领域. 除了日常阅读和做项目练习,也需要很多枯燥的记忆和理解。单纯读书不容易串联概念,又容易忘记。如果你也读了无数遍“西瓜书”还是记不住什么是AUC值, 翻了几遍“ESL”还是说不清楚混淆矩阵(confusion matrix)中的Precision和Recall哪个是哪个...那么, 像当初记单词一样用炫酷的flashcards每天帮助如何?

吃零食的时候来一张【AUC】

公交车上背一张【拟合度】

吃饭时候来一张【Bagging和Dropout的区别】

看花花时候来一张【贝叶斯误差】

你或许在Twitter或其他网站上看见过 #machinelearningflashcards 的标签。这个卡片的设计人就是Chris Albon, 一名数据科学家,有着十年的统计学习、人工智能和软件工程方面的经验,他还是Reddit数据科学板块的Moderator。

Chris Albon

Ph.D 加州大学戴维斯分校政治学 2012

M.A. 加州大学戴维斯分校政治学系 2010

B.A. 迈阿密大学 2006年 主修政治学,国际研究和宗教研究

首席数据科学家,BRCK,2017年至今

创始人,Machine Learning Flashcards,2017 - 至今

作家,Machine Learning with Python Cookbook

Partially Derivative联合创始人兼联合主办,2014 - 2017

New Knowledge联合创始人兼首席科学官,2015 - 2016

Ushahidi CrisisNET总监,2014 - 2015

Ushahid 数据项目总监,2013年至2014年

FrontlineSMS项目总监,2012-2013

我们再来看一下手绘小卡片是怎样讲解机器学习概念的:

△ 决策树回归:与决策树分类相似,但是使用均方误差或类似的指标来确定分叉,而不是交叉熵或杂质度

△Early Stopping:当确认损失增加的时候,神经网络训练就停止

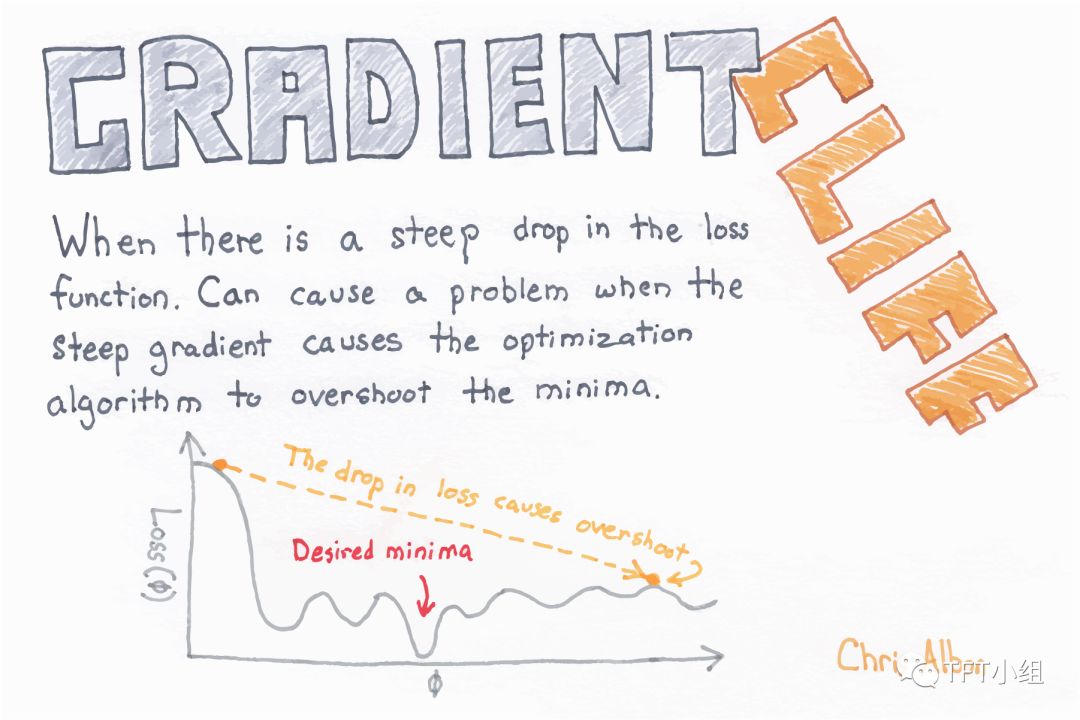

△ 梯度悬崖:当损失函数急剧下降时会产生梯度悬崖。若陡坡导致优化算法的值超过最小值,会引起问题

△ 验证曲线:将某些超取不同的值时所对应的性能指标可视化

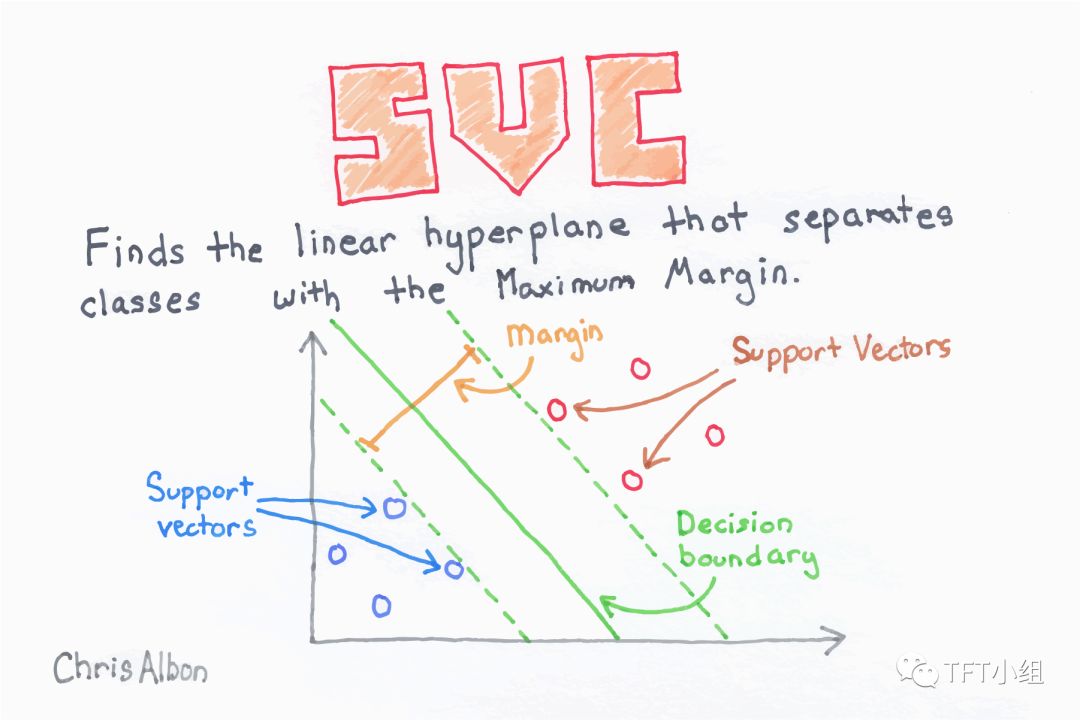

△ 支持向量(解释全在图里了😂)

Chris一直在推特上分享出自己手绘flashcards的图片,同时也在machinelearningflashcards网站上以12美元的价格出售。出售的是flashcards的各种格式的高质量打印版(包括SVG、PDF和PNG格式)。

小组当然也买了一份!

并且!

将它们定做成了实体卡片!

是不是肥常好看?

有哪些幸运儿可以免费获得呢?

看这里!

★★★★★

5月19日~6月23日

数据科学小组

自然语言 循环神经网络 注意力机制...

海量数据知识

+ 七节 案例讲解课

+ 至少4节 实战演练课

+ 完成至少四个实战项目

历时35天 课程+实战

ALL OF THEM

¥1200

仅限第一期

★★★★★

↓↓↓点击【阅读原文】数据科学 立刻开学