作者:罗罗攀 《从零开始学Python网络爬虫》书籍作者

Python爱好者社区专栏作者 Python爬虫爱好者

博客地址:http://www.jianshu.com/u/9104ebf5e177

本系列教程为《机器学习实战》的读书笔记。首先,讲讲写本系列教程的原因:第一,《机器学习实战》的代码由Python2编写,有些代码在Python3上运行已会报错,本教程基于Python3进行代码的修订;第二:之前看了一些机器学习的书籍,没有进行记录,很快就忘记掉了,通过编写教程也是一种复习的过程;第三,机器学习相对于爬虫和数据分析而言,学习难度更大,希望通过本系列文字教程,让读者在学习机器学习的路上少走弯路。

前文传送门:

机器学习实战之KNN算法

本系列教程特点:

哪些读者可以食用:

了解机器学习的基本术语

会Python语言

会numpy和pandas库的使用

写在前面

Logistic回归涉及到高等数学,线性代数,概率论,优化问题。本文尽量以最简单易懂的叙述方式,以少讲公式原理,多讲形象化案例为原则,给读者讲懂Logistic回归。如对数学公式过敏,引发不适,后果自负。

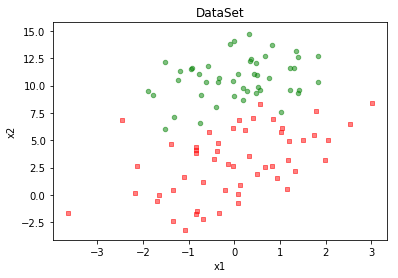

Logistic回归原理与推导

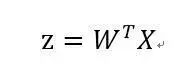

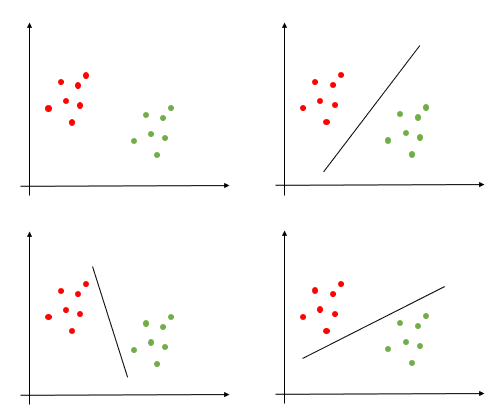

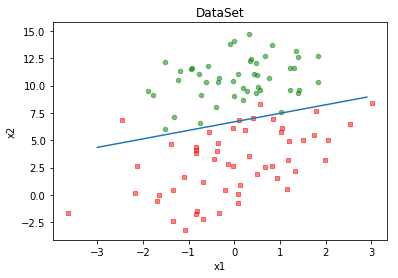

Logistic回归中虽然有回归的字样,但该算法是一个分类算法,如图所示,有两类数据(红点和绿点)分布如下,如果需要对两类数据进行分类,我们可以通过一条直线进行划分(w0 * x0 + w1 * x1+w2 * x2)。当新的样本(x1,x2)需要预测时,带入直线函数中,函数值大于0,则为绿色样本(正样本),否则为红样本(负样本)。 推广到高维空间中,我们需要得到一个超平面(在二维是直线,在三维是平面,在n维是n-1的超平面)切分我们的样本数据,实际上也就是求该超平面的W参数,这很类似于回归,所以取名为Logistic回归。

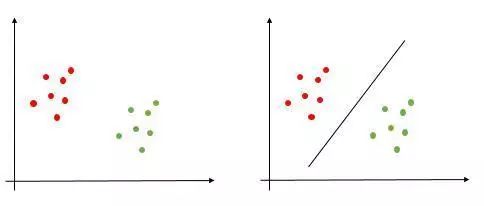

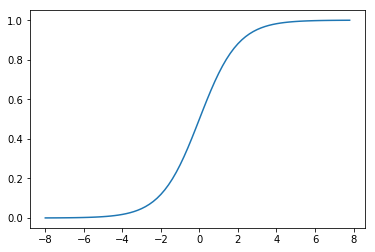

sigmoid函数

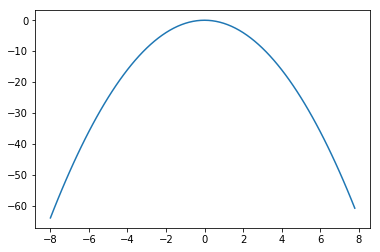

当然,我们不直接使用z函数,我们需要把z值转换到区间[0-1]之间,转换的z值就是判断新样本属于正样本的概率大小。我们使用sigmoid函数完成这个转换过程,公式如下。通过观察sigmoid函数图,如图所示,当z值大于0时,σ值大于0.5,当z值小于0时,σ值小于于0.5。利用sigmoid函数,使得Logistic回归本质上是一个基于条件概率的判别模型。

目标函数

其实,我们现在就是求W,如何求W呢,我们先看下图,我们都能看出第二个图的直线切分的最好,换句话说,能让这些样本点离直线越远越好,这样对于新样本的到来,也具有很好的划分,那如何用公式表示并计算这个目标函数呢?

我们把sigmoid公式应用到z函数中:

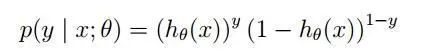

通过条件概率可推出下面公式,对公式进行整合为一个,见下。

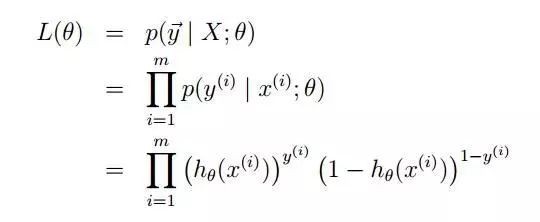

假定样本与样本之间相互独立,那么整个样本集生成的概率即为所有样本生成概率的乘积:

这个公式过于复杂,不太容易求导,这里通过log转换:

这时就需要这个目标函数的值最大,以此求出θ。

梯度上升法

在介绍梯度上升法之前,我们看一个中学知识:求下面函数在x等于多少时,取最大值。

函数图:

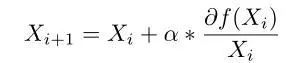

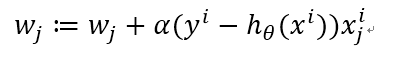

解:求f(x)的导数:2x,令其为0,求得x=0时,取最大值为0。但在函数复杂时,求出导数也很难计算函数的极值,这时就需要使用梯度上升法,通过迭代,一步步逼近极值,公式如下,我们顺着导数的方向(梯度)一步步逼近。

利用梯度算法计算该函数的x值:

def f(x_old):

return -2*x_old

def cal():

x_old = 0

x_new = -6

eps = 0.01

presision = 0.00001

while abs(x_new-x_old)>presision:

x_old=x_new

x_new=x_old+eps*f(x_old)

return x_new

-0.0004892181072978443

目标函数求解

这里,我们对函数求偏导,得到迭代公式如下:

Logistic回归实践

数据情况

读入数据,并绘图显示:

def loadDataSet():

dataMat = [];labelMat = []

fr = open('数据/Logistic/TestSet.txt')

for line in fr.readlines():

lineArr = line.strip().split()

dataMat.append([1.0, float(lineArr[0]), float(lineArr[1])])

labelMat.append(int(lineArr[2]))

return dataMat, labelMat

训练算法

利用梯度迭代公式,计算W:

def sigmoid(inX):

return 1.0/(1 + np.exp(-inX))

def gradAscent(dataMatIn, labelMatIn):

dataMatrix = np.mat(dataMatIn)

labelMat = np.mat(labelMatIn).transpose()

m,n = np.shape(dataMatrix)

alpha = 0.001

maxCycles = 500

weights = np.ones((n,1))

for k in range(maxCycles):

h = sigmoid(dataMatrix * weights)

error = labelMat - h

weights = weights + alpha * dataMatrix.transpose() * error

return weights

通过计算的weights绘图,查看分类结果:

算法优缺点

零基础如何入门学习Python网络爬虫?

小编推荐作者的好书,点击阅读原文即可购买

Python爱好者社区历史文章大合集:

Python爱好者社区历史文章列表(每周append更新一次)

福利:文末扫码立刻关注公众号,“Python爱好者社区”,开始学习Python课程:

福利:文末扫码立刻关注公众号,“Python爱好者社区”,开始学习Python课程:

关注后在公众号内回复“课程”即可获取:

小编的Python入门免费视频课程!!!

【最新免费微课】小编的Python快速上手matplotlib可视化库!!!

崔老师爬虫实战案例免费学习视频。

陈老师数据分析报告制作免费学习视频。

玩转大数据分析!Spark2.X+Python 精华实战课程免费学习视频。