大家好!又到了每周一狗熊会的深度学习时间了。在上一期的笔记分享中,小编和大家介绍了卷积神经网络短暂而令人激动的发展历程、了解了深度学习一些的大咖,并重点对卷积神经网络的基本原理和过程进行了分析。对卷积神经网络的基本结构(卷积-池化-全连接)、尤其是卷积的基本原理和传播机制进行了通俗的解释。那么卷积神经网络具体是如何工作的?又是在图像识别中如何生效的?在每一层的学习中卷积网络都学到了什么?在本节的的分享中,小编将在上一讲的基础上对卷积神经网络在图像识别分类上的工作机制、卷积识别过程进行深入的探讨。并以简单的图像例子来实际验证卷积神经网络的有效性。

自有神经网络以来,可解释性问题一直伴随着神经网络发展始终。曾经一度因为可解释性问题神经网络遭遇发展低谷。在很多人看来,深度神经网络除了输入和输出,中间很深的隐藏层网络就像个黑箱子,你很难解释在模型训练过程中这些黑箱子里发生了什么。作为了一个尚有争论和正在研究的问题,小编不对神经网络的可解释性做过多的解释,我们将从可视化的角度来观察卷积神经网络的每一层在图像识别过程中到底都学到了什么。

一个合理的解释就是卷积神经网络在学习过程中是逐层对图像特征进行识别和检测的。在深度卷积网络中,前几层网络用于检测图像的边缘特征,包括像图像的基轮廓这样的特征,中间的一些网络层用来检测图像物体的部分区域,靠后的一些网络层则用来负责检测到图像中完整的物体。也就是说,深度卷积网络的不同层负责检测输入图像的不同层级的图像特征。

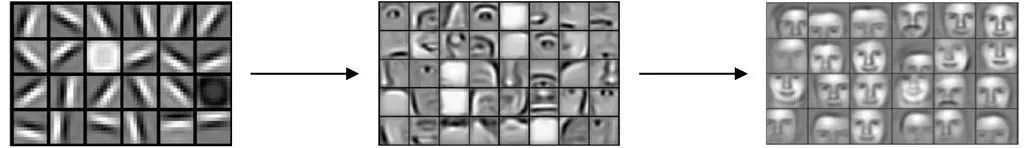

卷积神经网络的人脸检测过程

如上图所示,卷积神经网络在训练过程中,先是检测到横竖这样的较简单的初始级特征,然后中间一些网络检测到人脸的眼睛和鼻子之类的特征,最后再检测到整张人脸。这便是卷积神经网络学习过程中的直观展示。

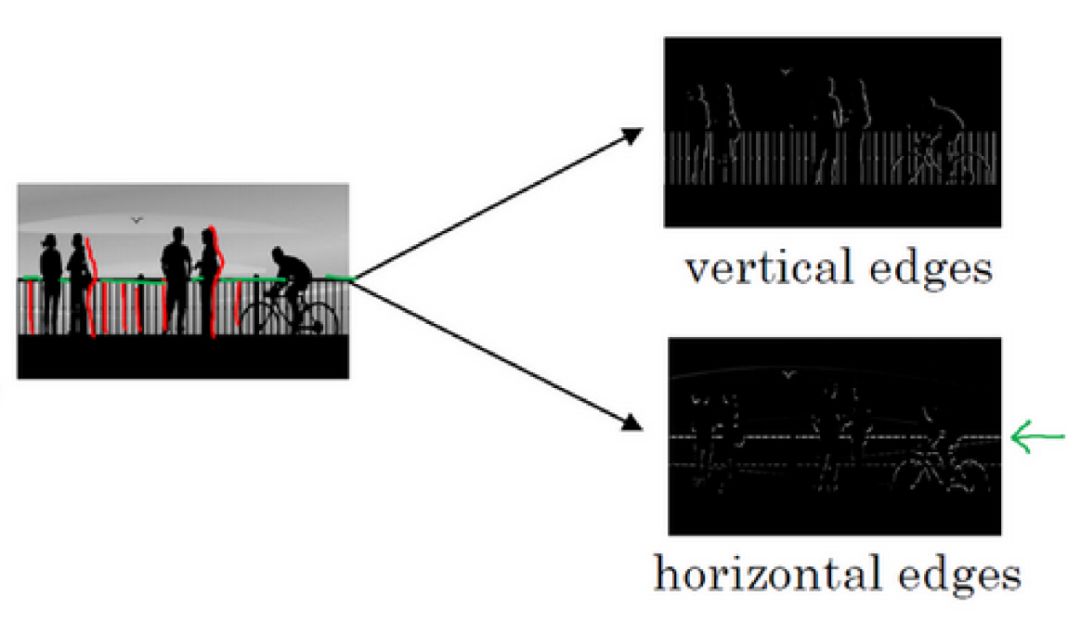

假设现在我们要给计算机看一张图片,想让计算机搞清楚这张图片里都有哪些物体。那么卷积神经网络的第一步就是要做图像做边缘检测。作为图像处理的基本问题,边缘检测的目的就是检测出图像中亮度变化和特征较为明显的点和线。

以下图为例,卷积网络要对这张图片做边缘检测,一开始可能需要检测到图像的一些垂直边缘特征,然后再检测到一些水平的边缘特征:

垂直边缘和水平边缘特征(截图于吴恩达deeplearningai课程)

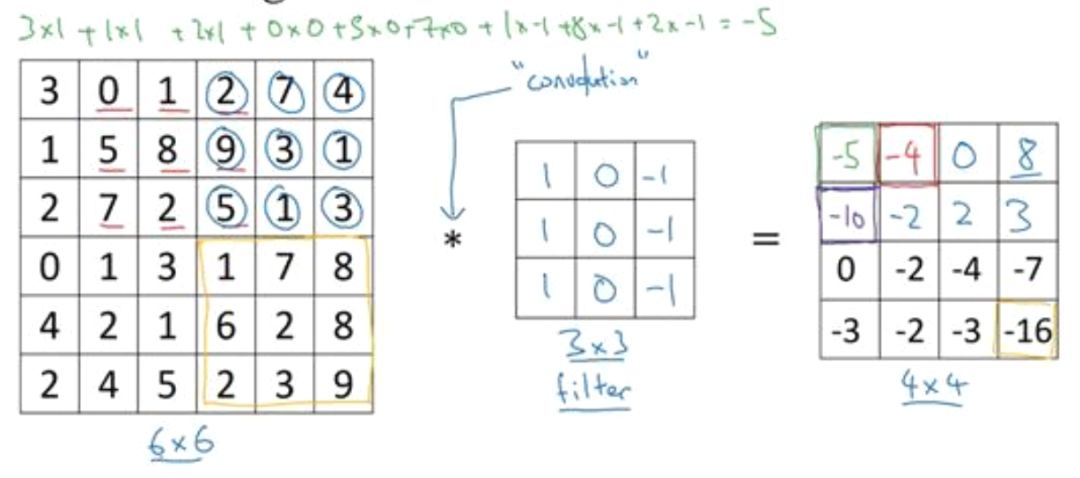

由于上述图像时灰度图,即图像的颜色通道为 1 ,假设该图像的大小为 6x6x1,我们用一个 3x3x1 的具备垂直边缘特征检测功能的卷积核对其进行卷积,得到的输出便是具备垂直边缘特征的特征图。

垂直边缘特征检测过程(截图于吴恩达deeplearningai课程)

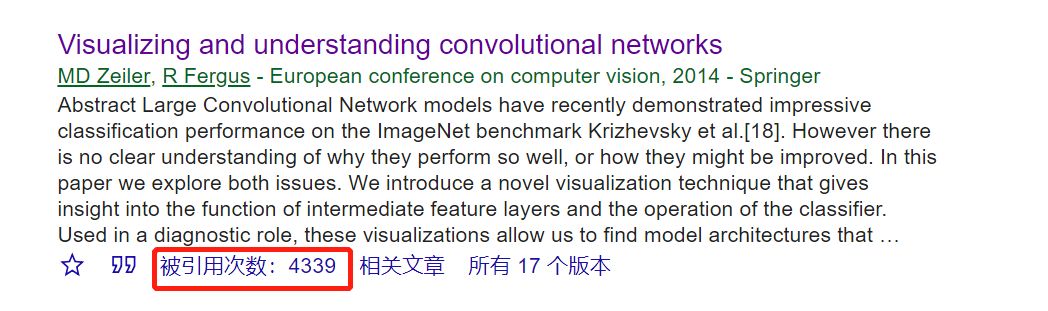

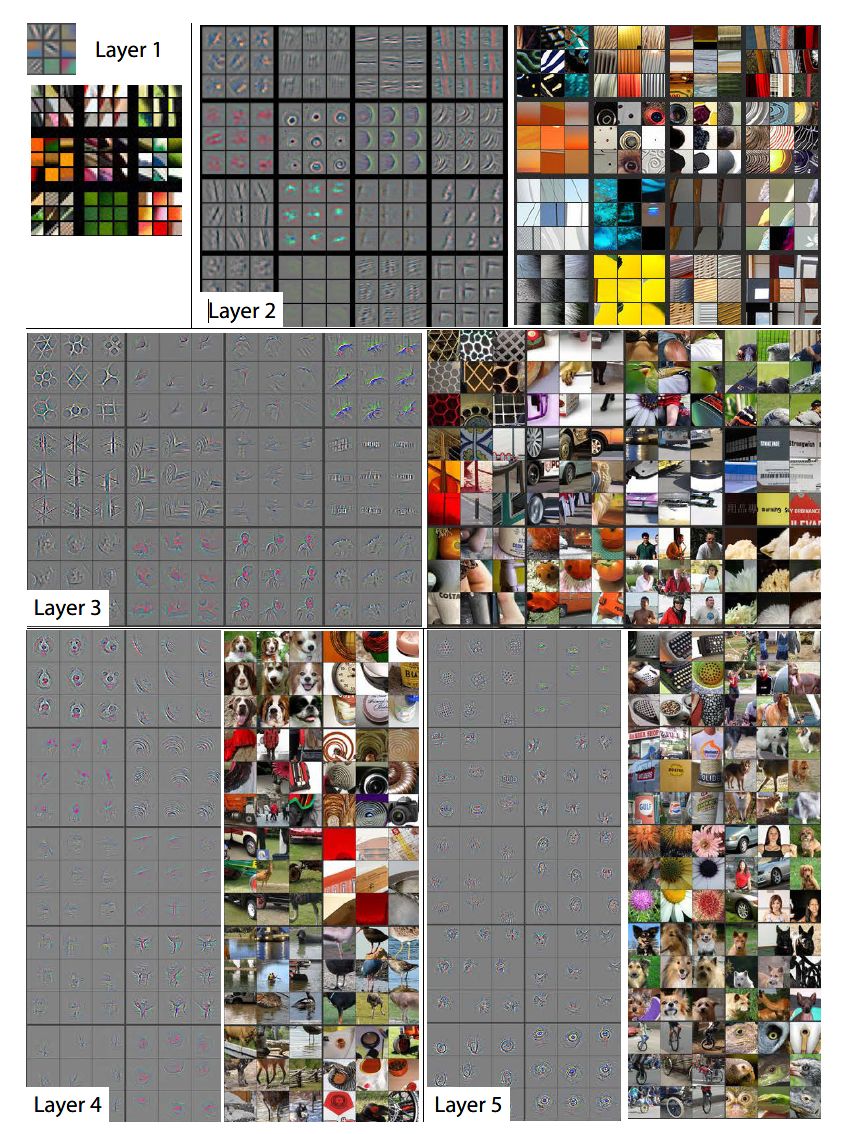

2014 年 Zeiler 等人在 ECCV 上发表了一篇基于可视化角度理解 CNN 的经典论文,可谓是卷积神经网络可视化的开山之作(Visualizing and Understanding Convolutional Networks,2014)。作为学习计算机视觉和深度学习的必读论文,这篇经典的引用次数已达 4339 次,对此卷积神经网络感兴趣的同学一定不要错过了这篇文章。

全篇论文没有用一个公式,完全用试验的方式的展示如何通过卷积神经网络训练过程中的特征可视化展现网络训练以及直观的看到试验中对网络的调整是否有效。论文中的卷积网络训练过程中逐层的特征可视化效果:

卷积过程中逐层特征可视化

以上便是卷积神经网络做图像识别的训练时逐层的可视化直观展示。下面小编使用 Tensorflow 和大家一起学习如何使用卷积神经网络完成一个简单的图像识别的训练任务。

上一讲到现在小编一直在和大家对卷积神经网络的理论进行详细的讲解,特别是卷积过程,却还一直没有实际的来训练一个卷积神经网络。在卷积网络的基本原理讲完的基础上,小编就和大家一起学习如何使用 Tensorflow 基于 mnist 数据集训练的一个简单的卷积神经网络。

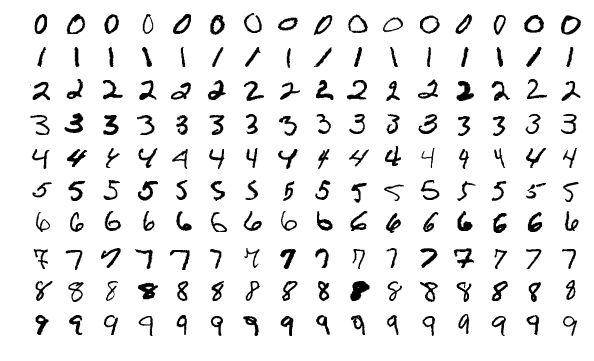

mnist 数据集是 Yann Lecun 大佬基于美国国家标准技术研究所构建的一个研究深度学习的手写数字的数据集。mnist 由 70000 张不同人手写的 0-9 10个数字的灰度图组成。0-9 个数字展示如下:

mnist数据集

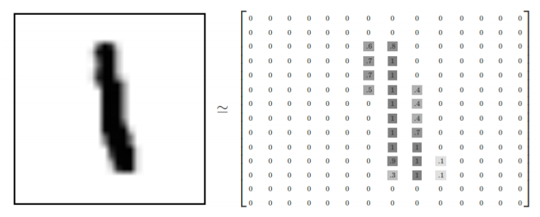

若是从特征角度来看这些数字图片的话,比如说数字 1 和 7 的图片中就存在着大量的垂直边缘特征,对于卷积网络来说检测出识别出它们非常容易。下图是 mnist 中数字 1 的像素点分布。

mnist 数字 1

下面小编就用 Tensorflow 一步步搭建一个简单的手写数字识别网络。

定义初始化模型权重函数:

# 定义权值和偏置初始化函数

def weight_variable(shape):

initial = tf.truncated_normal(shape, stddev=0.1)

return tf.Variable(initial)

def bias_variable(shape):

initial = tf.constant(0.1, shape=shape)

return tf.Variable(initial)

定义卷积和池化函数:

# 定义卷积和池化函数

def conv2d(x, W):

return tf.nn.conv2d(x, W, strides=[1, 1, 1, 1], padding='SAME')

def max_pool_2x2(x):

return tf.nn.max_pool(x, ksize=[1, 2, 2, 1],

strides=[1, 2, 2, 1], padding='SAME')

搭建第一层卷积:

# 第一层卷积核权值和偏置初始化

W_conv1 = weight_variable([5, 5, 1, 32])

b_conv1 = bias_variable([32])

# 对输入图像塑形

x_image = tf.reshape(x, [-1,28,28,1])

# 第一层卷积

h_conv1 = tf.nn.relu(conv2d(x_image, W_conv1) + b_conv1)

# 第一层池化

h_pool1 = max_pool_2x2(h_conv1)

搭建第二层卷积:

# 第二层卷积核权值和偏置初始化

W_conv2 = weight_variable([5, 5, 32, 64])

b_conv2 = bias_variable([64])

# 第二层卷积

h_conv2 = tf.nn.relu(conv2d(h_pool1, W_conv2) + b_conv2)

# 第二层池化

h_pool2 = max_pool_2x2(h_conv2)

搭建全连接层:

# 第一层全连接层权值和偏置初始化

W_fc1 = weight_variable([7 * 7 * 64, 1024])

b_fc1 = bias_variable([1024])

h_pool2_flat = tf.reshape(h_pool2, [-1, 7*7*64])

# 全连接层

h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat, W_fc1) + b_fc1)

设置 dropout 防止过拟合:

# 设置 dropout

keep_prob = tf.placeholder("float")

h_fc1_drop = tf.nn.dropout(h_fc1, keep_prob)

对输出层定义

softmax :

# 第二层全连接层权值和偏置初始化

W_fc2 = weight_variable([1024, 10])

b_fc2 = bias_variable([10])

# softmax 输出层

y_conv = tf.nn.softmax(tf.matmul(h_fc1_drop, W_fc2) + b_fc2)

训练模型并进行预测:

# 模型训练和验证

cross_entropy = -tf.reduce_sum(y_*tf.log(y_conv))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y_conv,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

sess.run(tf.initialize_all_variables())

for i in range(20000):

batch = mnist.train.next_batch(50)

if i%100 == 0:

train_accuracy = accuracy.eval(feed_dict={

x:batch[0], y_: batch[1], keep_prob: 1.0})

print("step %d, training accuracy %g" %(i, train_accuracy))

train_step.run(feed_dict={x: batch[0], y_: batch[1], keep_prob: 0.5})

print("test accuracy %g"%accuracy.eval(feed_dict={

x: mnist.test.images, y_: mnist.test.labels, keep_prob: 1.0}))

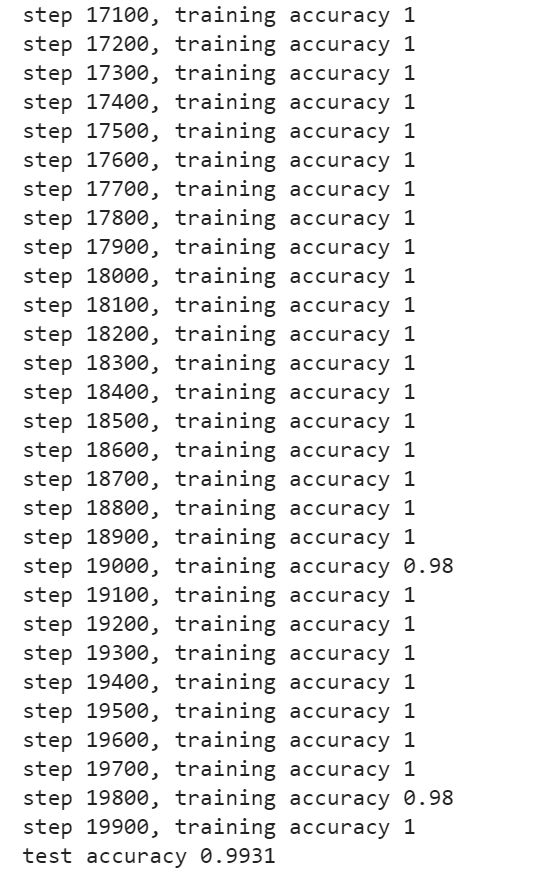

部分迭代过程和预测结果如下:

经过添加两层卷积之后我们的模型预测准确率达到了 0.9931,模型训练的算是比较好了。

本篇笔记小编和大家直观展示卷积神经网络在学习过程中的特征可视化,明确了神经网络是逐层学习图像特征的过程。总体而言,卷积网络的前几层先学习到图像中物体的边缘特征,然后中间层学习到物体的区域特征,最后几层学习到整个物体特征。之后小编和大家展示了如何用 Tensorflow 基于 mnist 数据集快速搭建起一个卷积神经网络图像识别试验。希望大家在弄懂原理的基础上,实际动手写一写程序,实际体会深度学习带来的乐趣。这一期到这里就结束啦,咱们下期见!

【参考资料】

https://www.deeplearning.ai/

http://www.tensorfly.cn/tfdoc/tutorials/mnist_pros.html

作者简介

鲁伟,狗熊会人才计划一期学员。目前在杭州某软件公司从事数据分析和深度学习相关的研究工作,研究方向为贝叶斯统计、计算机视觉和迁移学习。

识别二维码,查看作者更多精彩文章

识别下方二维码成为狗熊会会员!

友情提示:

个人会员不提供数据、代码,

视频only!

个人会员网址:http://teach.xiong99.com.cn