引子

阳志平老师曾提出「学习六思」,第四条是:

输出大于输入:即使在头脑中想象教别人,也能提高学习效率;从学到教,意味着从被动到主动,从依赖到独立。

读罢后,我没有就简单的理解一闪而过,而是产生了一连串的疑问:

1. 输入和输出到底是什么?

2. 在学习过程中有哪些输入和输出?

3. 如何区分输入和输出?

4. 什么是更好的输入和输出?

5. 为什么输出大于输入?

大多数人理解的输出,是所谓的写,输入的过程,就是简简单单地阅读,即:「输入=阅读,输出=记录」,真是这样吗?

「机器学习」的启迪

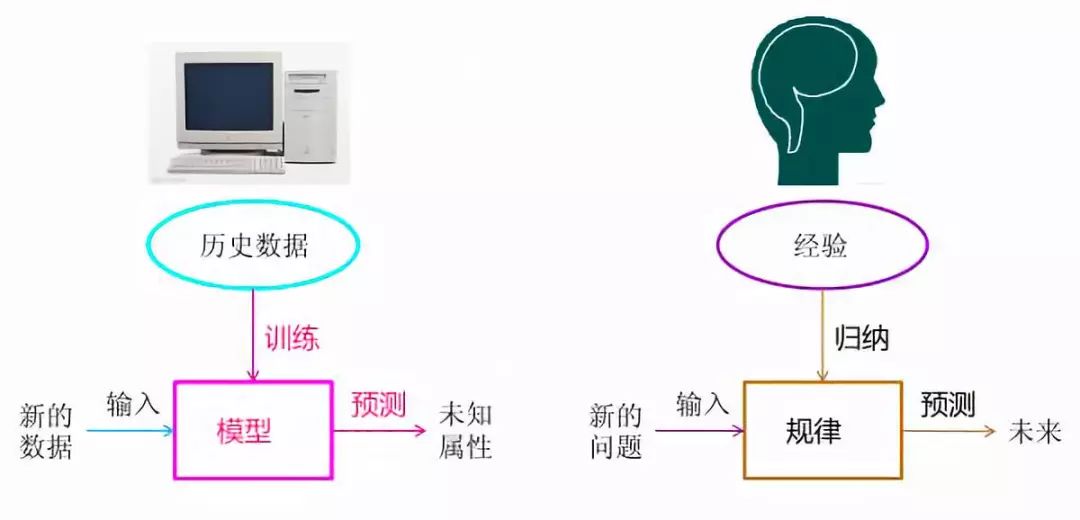

一般抽象的信息处理过程,可以总结为「输入 - 处理 - 输出」,但对于「机器学习」来说,其中处理有一个核心的概念,叫「模型」,对「机器学习」来说,过程就是「输入 - 模型 - 输出」。

「机器学习」的输入包括数据的输入,「机器学习」的「模型」指的是信息处理的数学模型。把数据输入给机器,在计算机进行「机器学习」完之后,它自己会获得到一些新的信息和知识——这些结构的知识,比如对信息分类,类似于人类的经验,会自己形成一个模型,这就是所谓「无监督学习」。

比如在双 11 在购物网站用户发生了一系列的行为,传统数据挖掘是需要事先定义后各种行为关系和分类的,但在「机器学习」中,它可以更加智能化对用户行为数据进行自动分类,从而自己生成一个分类,这就是所谓「聚类」。然后我们就可以拿这个模型去做一些预测。上面就是「机器学习」这一分支的大概过程。

我们的人脑学习的过程也是一样的,也有输入和输出,中间是归纳总结出一个规律的过程。比如我们的视觉和听觉都是我们大脑输入的一部分,当我们接收到这些信息之后,大脑它自己会去做一个深度的思考,或者说做一些知识的连接,通过归纳或者演绎等方法,得到一些规律,然后我们用这个规律来预测指导我们未来的行为或者决策,这就是我们学习的一个过程。下面是一张对比图:

对比机器学习和人脑学习,都有输入和输出,中间有一个环节,如果是机器学习则是模型,如果是人脑则是规律,也可以理解为模型,接下来讨论这三部分:

第一部分是输入,「机器学习」过程中数据的真实性、丰富性,以及数据量是对这个模型来讲,都非常依赖于输入,如果输入的数据足够丰富、足够的真实、没有噪音,那么训练出来的模型,误差会比较小;大脑学习同样依赖输入,丰富真实的数据至关重要,这就要给大脑减少垃圾信息和数据的获取,比如大多数网站或者公众号的碎片知识,因为它会对真实的信息产生干扰,这就是为什么需要获取源头知识、多学科知识,基于原始信息学习到的模型价值更高。

第二部分就是模型本身,机器学习应用中,会尝试使用不同的模型来拟合数据,或者做优化,或者创造模型。大脑学习也一样,尝试不同的方法或者借用更好的经验来总结规律,好的规律和模型能解释更多的现象,解决更多的问题,就像阳志平老师经常会提到芒格的薪资核算模型,就是很好的模型。当然,模型本身也需要不断演化。

第三部分模型能不能预测,或者说预测准确度如何,得到模型之后,就要验证模型到底好不;人类学习一样,通过验证和运用知识来检验学习的效果。

上面三点是「机器学习」和人脑「输入 - 模型 - 输出」的对比,也是知识的迁移,算是把机器学习和人脑学习两个知识打通了。

总结如下:

输入——输入真实丰富的数据、减少垃圾碎片信息多学科「源头知识」、更多的「反常识数据」

模型——不断训练产生更优化的模型。「高阶模型」-如芒格的心智栅格模型,不断演化和创建新模型

输出——通过模型验证新数据。通过预测验证,在生活和工作中测试模型,尤其是压力测试

人脑的记忆模型

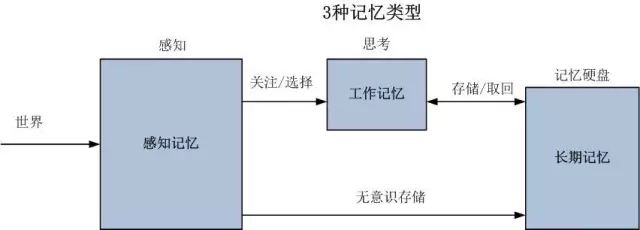

人脑的「工作记忆」模型。

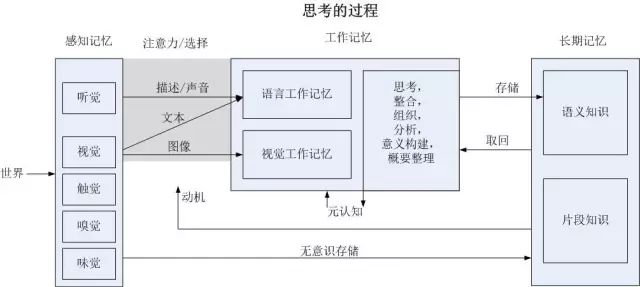

「工作记忆」模型细化之后就是下面这张图:

可以看到,人类有三种记忆类型。第一种「感知记忆」,其中的感知器就是我们的眼睛、耳朵、触觉等感官接口,我们从中能获得外界刺激的各种信息。第二种「工作记忆」,大脑基于「感知记忆」,将信息加载到「工作记忆」中来。「工作记忆」和「感知记忆」的时间非常短,而并且容量是极其有限。第三种记忆就是「长期记忆」。所谓长期性就是针对已有知识的记忆,其记忆容量非常非常大的,几乎就是无限的水平,这要看你能挖掘多少了。「长期记忆」根据来源也分两种,一种是来自于无意识接收至「感知记忆」中所获得的「情景记忆」(episodic),另一部分就是在「工作记忆」加工处理过的「语义记忆」(semantic),以上就是记忆的三种类型。

「长期记忆」这一部分有两个核心的概念,是加州洛杉矶分校的一对夫妻教授(Robert Bjork和Elizabeth Bjork)提出来的一个记忆模型——即通常心理学所说的「必要难度理论」(Desirable Difficulty),认为在记忆过程中有两种强度,一种是「存储强度」,一种是「提取强度」。并且二者在记忆过程中具有以下特点:

1.「存储强度」和记忆的「提取强度」是负相关的,可以理解为输入越快,提取越慢。

2.「存储强度」是只增不减,如果我们在不同时间、空间反复学习同一个知识,存储强度会得到加强。

我们常常有这样的感觉经验,即虽然我们好像记得了很多东西,但最后还是忘了,这其实就是因为「提取强度」的不够。

那么如何提高「存储强度」和「提取强度」呢?可以尝试阳志平老师之前提出的方法:6 个小时以后再记笔记。6 个小时后回忆,记住的反而那些比较重要的东西,重新复习这些内容,就相当于做了一次提取的同时,又做了一次存储,因此我们「长期记忆」过程就会大大加强。如果之前没有练习过,刚开始做会比较困难,可能要绞尽脑汁才能想起一点点东西,但慢慢习惯之后就好了。上面介绍的就是「必要难度理论」。

从记忆模型中得到以下两个结论:

第一,学习知识,重点在于「长期记忆」,也就是最终积累了多少知识。从记忆过程和原理来看,我们在输入端应该少花一些时间,在输出端应该是多花一些时间,因为输出的时候我们也是在提取,而提取不仅会增强我们的「提取强度」,也会加强我们的存储强度。我们越是反复提取已有的知识,以后会更容易提取这些知识。

第二,从另外一个角度可以得出,「输出」大于「输入」。在输入端花的时间应少些,在输出端(提取或生成)上花的时间应多些,因为后者包含了有效学习所必需的“必要难度”,这也从时间上得出了输出的时间应该大于输入的时间,所以输出大于输入有多层含义,也包括提取的次数大于输入的次数。

教是更好地学

从前面讲的理论可以看出,教依赖于被教的对象,写作只依赖自己,这就是为什么写是我们最常用的输出方式,但输出的质量依然取决于提取强度,在教的过程中好的问题会加强提取强度。

这样我们最终走向了「教是更好地学」整个结论。现在有没有什么方法上的例证呢?当然有的,比如「费曼技巧」。

费曼技巧第二条:设想一种场景,你正要向别人传授在白纸上写下你对某个概念的解释, 就好像你正在教导一位新接触这个概念的学生一样。当你这样做的时候, 你会更清楚地意识到关于这个概念你理解了多少, 以及是否还存在理解不清的地方。

费曼技巧是假设一种场景模拟自己在对另外一个人讲。但如果我们身边是有真实的人,这样效果将是最好的。因为作为一种真实的场景,不同于我们凭空想象的那个场景,知识在大脑处理的过程也和相信是不一样的,真实场景中会有「感知记忆」中参与进来。但是我们大多数情况下身边都没有另外一个人,那么就假设有另外一个自己,两个人好像在对话一样,通过自己给自己提问的方式做练习。

无论是回忆还是写笔记,变换时空,在不同情景下提取,加强记忆「提取强度」。比如前面提到 6 小时后记笔记是时间上的「必要难度」,还可以通过更换地点造成地点上的「必要难度」。

前面原理中我们也看到了,其中不同场景下「感知记忆」感知不同的内容会参与进来,因此记忆的内容会重新编码存储到我们的记忆系统中去。就好比,如果你特别伤心或者特别高兴,在特别情绪化的时候,有一些特定内容是更容易记住的。

比如著名的学习大神 Scott Young ,他提到一个细节,在学习一个东西的时候,能否向一个 10 岁的小孩,用比喻的方式解释清楚?用比喻的方式其实就是切换了知识所处的背景(环境)。

古罗马著名斯多亚学派哲学家塞内加(Seneca)曾说过:

While we teach, we learn

而中国古话也说「教学相长」,可见古人也是认识到教对于学的重要性。不过我们今天能从「机器学习」、「工作记忆模型」和「必要难度理论」中得出更确切的结论,也显然比古人更进了一步,让我们可以挖掘更多方法和技巧去实践这种学习方法。■

图片来源:作者绘制。

原创文章,转载授权请联系一休

投稿&合作邮箱:we@openmindclub.com

点击报名,参与开智互联网精英分享会

点击报名,参与开智互联网精英分享会