作者 | Frederico Guth,Teófilo Emidio de Campos

编译 | 夕颜

出品 | AI科技大本营(ID:rgznai100)

【导读】人类可以从很少的样本中学习,显示出了人类卓越的泛化能力,而这一点学习算法仍远做不到。当前,最成功的模型需要大量标记好的数据,但是这些数据昂贵且难以获取,成为实践中使用机器学习的最大障碍之一。最近的研究表明,当前的算法几乎不能对训练期间看到的数据做泛化。在这种情况下,迁移学习显示出巨大潜力,其目的是更有效地利用以前获得的知识来学习新任务。

在本篇系统综述中,作者采用了定量方法来选出对该领域的重大进展,并使用文献计量学耦合性度量来识别出来研究的前沿。另外,本论文还进一步分析了该领域的“经典”与“前沿”之间的语言差异,并预测了有潜力的研究方向。

1 引言

(a)

(b)

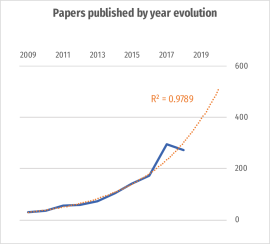

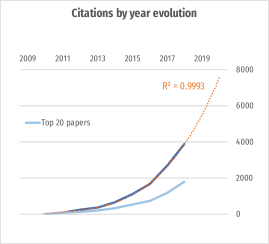

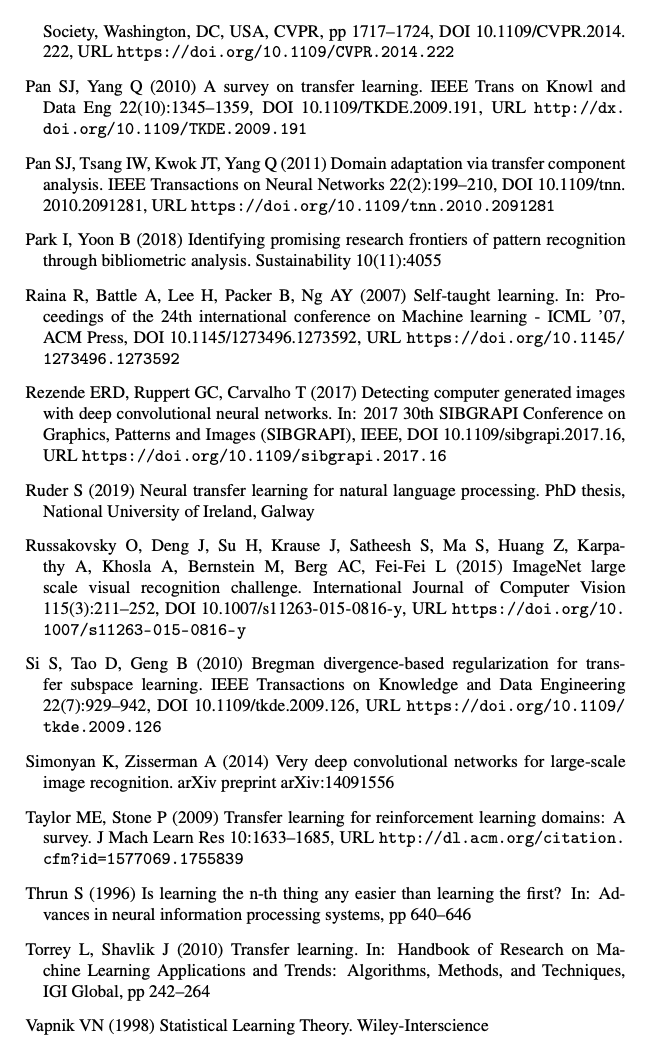

图1:过去10年中有关迁移学习的研究成果(a)和引文(b)的演变,以及具有高确定性系数的指数增长预测

尽管2018年的出版物数量有所减少。在(b)中,被引用次数最多的前20名论文几乎占了引文的一半。(数据来源:Web of Science,2019年3月)

尽管2018年的出版物数量有所减少。在(b)中,被引用次数最多的前20名论文几乎占了引文的一半。(数据来源:Web of Science,2019年3月)

这显示出迁移学习(TL)的巨大潜力,这种方法旨在利用先前的经验来有效地学习新任务。在实践中,TL 倾向于专门应用,其中迁移方法是所用学习算法的简单扩展(torrey)。如此重要但缺乏统一的方法和理论,表明这是一个有潜力的研究领域。正如吴恩达所说:“迁移学习将成为跨行业机器学习成功的下一个动力”。从这个角度来看,人们对此主题的兴趣日益增长是可以理解的(图1)。

1.1 目标

我们的研究问题是:

-

迁移学习的研究前沿是什么?

-

是否可以根据文献计量学进行此评估?

为了回答这些问题,我们将首先回顾文献并揭示该领域的主要贡献以及它们之间的相互关系。

1.2 贡献

-

我们使用TEMAC框架(第2节)介绍了有关迁移学习的文献的最新系统综述。这种方法帮助我们专注于具有较大影响力贡献。

-

我们扩展了TEMAC,使用ScatterText(kessler2017scattertext)分析摘要的语言变化,据我们所知,这是此可视化工具的原始用法。

-

在文献计量分析下,我们确定了研究前沿的方向以及该领域尚待解决的问题。

1.3 概述

在本简介中,我们将介绍相关作品。在下一部分(第2部分)中,我们将解释研究方法和定量分析以支持我们的发现。在第3节中,我们在《文献回顾》中给出了结果。未解决的问题将在第4节中讨论。最后,我们在第5节中总结,提出针对我们研究问题的答案。

2 方法:采用定量方法进行文献回顾

我们的文献综述使用mariano2017revisao(TEMAC)的文献计量方法,以为文献选择提供定量支持。

TEMAC包含:

-

研究准备;

-

数据表示和相互关系;

-

细节、综述和验证。

2.1 研究准备

3月\ nth31日,对图2所示的Clarivate Analytics Web of Science(WoS)进行搜索,结果找到了1,289篇文章。值得注意的是,对该主题的兴趣正在上涨(图1),并且可以预测,三年内文章的数量将翻倍(指数增长,确定系数:

)

)

{tcolorbox}

[colback=yellow!5!white,colframe=gray!75!black,title=Results: 1,289 (from Web of Science Core Collection)]

You searched for:TOPIC: (‘‘transfer learning’’)Refined by:WEB OF SCIENCE CATEGORIES: ( COMPUTER SCIENCE ARTIFICIAL INTELLIGENCE )AND LANGUAGES: ( ENGLISH )AND RESEARCH AREAS: ( COMPUTER SCIENCE )Timespan: 2009-2019.Indexes: SCI-EXPANDED, CPCI-S, ESCI.

Figure 2: “10yearsSearch”: Search parameters on Web of Scienc

第3.5节(研究前沿)仅对近期研究(图3)进行了搜索。

{tcolorbox}

[colback=yellow!5!white,colframe=gray!75!black,title=Results: 384 (from Web of Science Core Collection)]

You searched for:TOPIC: (‘‘transfer learning’’)Refined by:WEB OF SCIENCE CATEGORIES:( COMPUTER SCIENCE ARTIFICIAL INTELLIGENCE )AND LANGUAGES: ( ENGLISH )AND RESEARCH AREAS: ( COMPUTER SCIENCE )AND PUBLICATION YEARS: ( 2019 OR 2018 OR 2017 )AND DOCUMENT TYPES: ( PROCEEDINGS PAPER )Timespan: 2009-2019.Indexes: SCI-EXPANDED, CPCI-S, ESCI.

Figure 3: “3yearsSearch”: Search parameters for frontier analysis

2.2 数据表示和相互关系

在此阶段,我们进行分析(请参阅第3.3节):

-

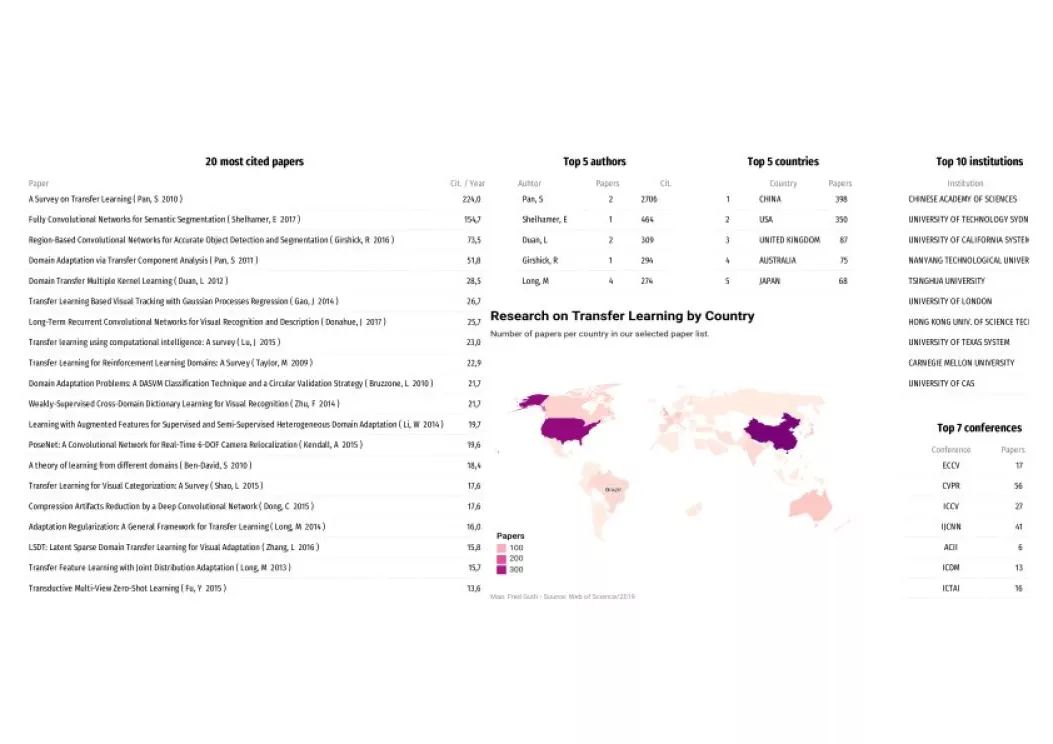

引用最多的文章(图6);

-

文章数量逐年演变(图1(a));

-

引文逐年演变(图1(b));

-

出版和引用最多的作者(图6);

-

出版和引用最多的会议(图6);

-

出版和引用最多的机构(图6);

-

按研究产出划分的国家(图6);

-

关键字频率(图10和12)。

2.3 综述与验证

-

共同引文分析

:共同引文测量在同一参考文献目录中引用两篇论文的频率,并假设它们是同一“知识结构”的“片断”。因此,共引分析通过确定有影响力的作品来描述研究领域的知识传承,但由于这些作品被引用的时间较短,所以不算在研究前沿(Vogel2012)。

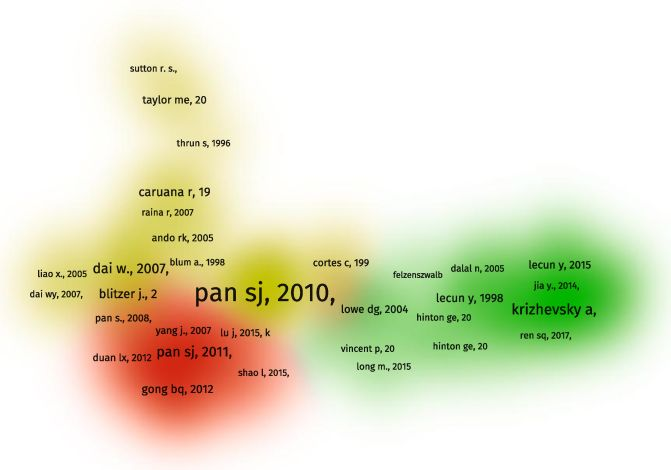

使用免费软件VOSviewer(VOSviewer)对“ 10yearsSearch”所选文章引用的作品进行聚类。这样,确定了三个知识集群(图5)。

-

双耦合分析

:两篇论文至少有一个共同的参考文献时会发生文献耦合。因此,如果论文的参考文献重叠,则认为它们是耦合的(Vogel2012)。由于可以在被引用和被引用的作品中按时间顺序排列,文献耦合使我们能够绘制研究“迭代”地图,从而确定研究的前沿领域。有一点要注意,在这种情况下,处于前沿只是时间上的概率,并不意味着这是一项有前途的工作。定量方法的这一局限性指向需要定性补充以识别“未来的经典”。

在TEMAC框架中,文献耦合的时间不应超出最近三年。在我们的分析中,我们限制时间为2017年至2019年3月期间会议记录中选定的作品(图3),假设这些作品的评审和出版时间较短,因此代表了该领域的更新的内容。

-

文本分析

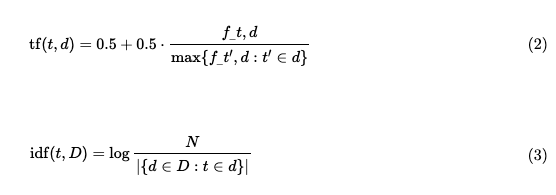

(带有tf-idf的词袋)

:在此分析中,文章被视为词袋,并且使用tf-idf的概念来定义哪些单词可以更好地识别每篇论文。例如,相对于那些解释“ 10yearsSearch”文章的人来说,哪个词更好地解释了前沿研究(见图12)。指标tf-idf定义为:

tf(t.d)是在文件d中单词t的频率,idf(t,D )表示在文件D(语料库)中t的逆文档频率。

N:文件N=|D|中语料库的大小

t出现的文件数量(即

t出现的文件数量(即

为了避免该术语不在语料库中而被零除,将分母调整为:

为了避免该术语不在语料库中而被零除,将分母调整为:

tf-idf 度量是可视化工具 ScatterText(kessler2017scattertext)的基础,该工具用于生成图8和12。

3 文献回顾

3.1 迁移学习历史简介

自 1995 年在 NIPS 上一个主题为“学习如何学习”的研讨会上讨论了机器学习保留和重用先前获得的知识的必要性时,关于迁移学习(或)的研究,尽管有时用不同的名称来称呼(学习如何学习、终身学习、知识迁移)吸引了越来越多的关注(PanYang)(见图1)。

2005 年,DARPA 的一个项目首次使用了“迁移学习”一词,该术语的定义是从一个或多个源任务中提取知识并将其应用于目标任务的目标(PanYang)。在 Web of Science 上进行的搜索可以确认,最早使用“迁移学习”一词的文章出现在 2005 年。

2012 年,Alex Krizhevsky 及其团队在 ImageNet 挑战赛(ILSVRC)中使用的深度神经网络比第二名胜出 41%,这一骄人的成绩激发了深度学习研究呈指数级增长。此结果凸显了数据可用性对于人工智能发展的重要性,使得迁移学习进入一个崭新的时代。尽管使用像 ImageNet 这样的大数据集学习的成本很高,但事实证明,训练有素的模型很适合初始化不同任务的模型(Ruder2019Neural,donahue2014decaf)。这种“ fine-tunning”的方法可以在许多任务上以较少的数据量获得良好的结果(请参见第 3.4.3 节)。

目前,在著名的会议(例如 CVPR、ICCV、ICPR 和 NeurIPS)上,迁移学习已经是一个常见的话题(请参见图 6,Top 10 会议)。

3.2 注释和定义

迁移学习是一个关于领域和任务的概念。根据 Pan Yang 的说法,domain D 由一个特征空间

和编辑分布

和编辑分布

组成,丛中得到样本

组成,丛中得到样本

。例如,在图像分类问题中,X 是具有一定尺寸和通道数量的所有可能图像的空间,

。例如,在图像分类问题中,X 是具有一定尺寸和通道数量的所有可能图像的空间,

是一张图像,S 是训练数据集。

是一张图像,S 是训练数据集。

如果 domain D=

任务 T 可以通过条件分布

任务 T 可以通过条件分布

进行统计定义,即

进行统计定义,即

是

是

时的目标函数,预测其对应的

时的目标函数,预测其对应的

假设

是源域,

是源域,

是源任务,D_T 是目标域,

是源任务,D_T 是目标域,

是目标任务,迁移学习的目的在于使用

是目标任务,迁移学习的目的在于使用

和

和

的知识学习

的知识学习

中的函数

中的函数

,其中

,其中

,

,

3.3 迁移学习研究概述

Pan,S. 是被引用次数最多的作者(参见图6,Top 10 作者),被引用 2706 次。影响力主要源于“迁移学习调查”(A Survey on Transfer Learning,PanYang),该调查是该领域引用次数最多的文章,被引用 2240 次。本文的主要贡献是为迁移学习提供了定义、注释和分类法,这对于研究界具有重要意义。这篇文章发布在影响因子为 2775 的 IEEE 期刊上,在 InCite JCR 的“计算机科学”,“人工智能”类别中排名第 33 位,这意味着它不是迁移学习研究的常用出版物。

中国是该领域中生产力最高的国家,其次是美国和英国。

大多数文章在会议上发表,占比 63%。CVPR 是迁移学习相关文章发布最多的会议,而 ECCV 虽然在产量方面仅排名第四,但却是被引用次数最多的会议。值得注意的是,计算机视觉会议一直是迁移学习研究的最热门场所。另外,值得注意的是,在此列表中缺少以 NLP 为重点的会议,在引用最多的 20 篇文章中,没有一篇和语言相关。

3.4 经典论文

(数据来源:Web of Science(2019 年 3 月),工具:VosViewer(VOSviewer)

图 4:*

图5:共引分析的知识集中点。集中点表示在 10yearsSearch 文章的参考文献列表中被协同引用的论文。)

图 6:

迁移学习研究回顾

图 6:

迁移学习研究回顾

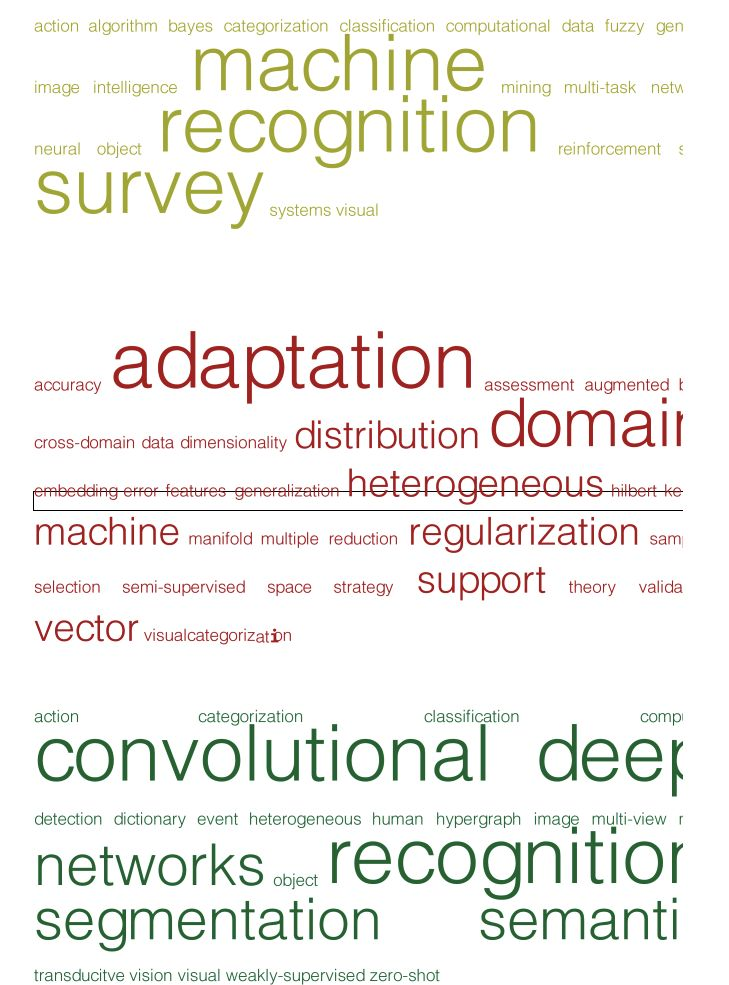

使用 VosViewer 进行的共引分析显示迁移学习相关知识集中在 3 个集群上,可以看到和时间有着很大的关系,可以视为几波波浪:第一波浪潮包含 2011 年之前的出版物(模式是 2006 年),图5 中以黄色显示;第二波浪潮从 2011 年到 2014 年(2012 年模式)为红色;第三波,也是最后一波,图中的绿色表示从 2012 年至今的文章(2014 模式)。

3.4.1 第一波

这一波的主要特征之一是其理论的加强。其中一些论文呈现了整个迁移学习的类别:thrun1996learning 和 Caruana1997 引入了多任务学习,以及辅助任务带来的归纳性 bias 会帮助学习收敛的思想;Chapelle:2010 年有关半监督学习的书;Raina2007 关于自学学习;Vapnik1998 奠定了统计学习理论的基础。

这一次浪潮的另一个组成部分是“域适应”文章,它们旨在了解降维的潜在特征,假设在潜在空间中源域和目标域相似,例如 ando2005framework,Blitzer:2006,DAS:1610075.1610094和 DaumeIII2006。

最后,这一波浪潮中被引用最多的文章是 surveys::PanYang,Taylor:2009:TLR:1577069.1755839;并非巧合,这些文献是在这波浪潮末期出版的,包含了当时的研究材料。

3.4.2 第二波

有关领域适应的文章是第二次浪潮的主流。有些人将注意力集中在诸如 Pan2011 提出的潜在特征上,但是大多数文章尝试从源域中选择与目标域相似的样本:BenDavid2009 从理论角度探讨了域分布的相似性;SiSi2010 试图最小化域之间的差异;这种工作趋势的共同点是基于样本分类器的方法,主要是支持向量机(SVM):Yang2007,Bruzzone2010,LixinDuan2012 等。

我们还发现了有关无监督域自适应的文献:BoqingGong2012,Fernando2013。

值得注意的是,在我们搜索的文章中,这波浪潮没有以调查 “结束”。调查相关的一个很好的例子是《视觉应用领域适应综合调查 》(A Comprehensive Survey on Domain Adaptation for Visual Applications Csurka2017)中的章节。不幸的是,这项工作未被 WoS 索引,因此在我们的搜索结果中找不到。

3.4.3 第三波

第三波包括深度学习环境中的迁移学习方法,我们可以将其称为深度迁移学习。

在这部分,我们可以找到经典的深度学习文献,例如:Hinton2006,这也许是一篇关于深度学习的开创性文章;Bengio2009 提出了表示学习和学习表,列出了可以依次学习的任务项,复杂性逐渐提高。LeCun2015 的论文回顾了关于审查深度学习的本质。此外,我们还可以找到alexnet 在 AlexNet 上发布的文章,该文章在 2012 年 ImageNet 挑战赛(ILSVRC)上比第二名多出 40% 的优势获冠军,从而孕育出当前的深度学习 “淘金热” 。

这一浪潮中的一些文章是关于大型数据集的,这是深度学习成功的重要组成部分:

Deng2009 介绍了 ImageNet,并建议可以将在 ImageNet 上学习的模型用于更有效地学习新领域。

Everingham2009 的主题是 Pascal VOC。Russakovsky2015 分析了 ImageNet 对不同计算机视觉问题的影响,并分析了迁移学习的作用。

还有一些文章介绍了使用预训练模型进行特征提取或可以在训练后使用的模型架构:Girshick2014,介绍了 R-CNN 模型 He2016、ResNet 和 simonyan2014very 对象检测;JialueFan2010 介绍了人员追踪;Long2015 则是关于语义分割的论文;等等。

迁移学习在深度学习中变得无处不在,以致 mahajan2018 中提出如果不使用 ImageNet 在计算机视觉问题中预先训练模型将寸步难行。

因此,我们很难找出一篇专注于迁移学习的文章。值得一提的是:glorot2011domain 建议使用深度神经网络来学习域之间的通用表示形式;donahue2014decaf和Oquab:2014:LTM:2679600.2680210 则为微调方法提供了理论支持。

3.4.4 文本分析结果

被引用 Top 20 的文章几乎占据了被引用论文的一般(图 1b)。因此,我们假设对“ 10yearsSearch”的此子集进行文本分析可以很好地代表整体。

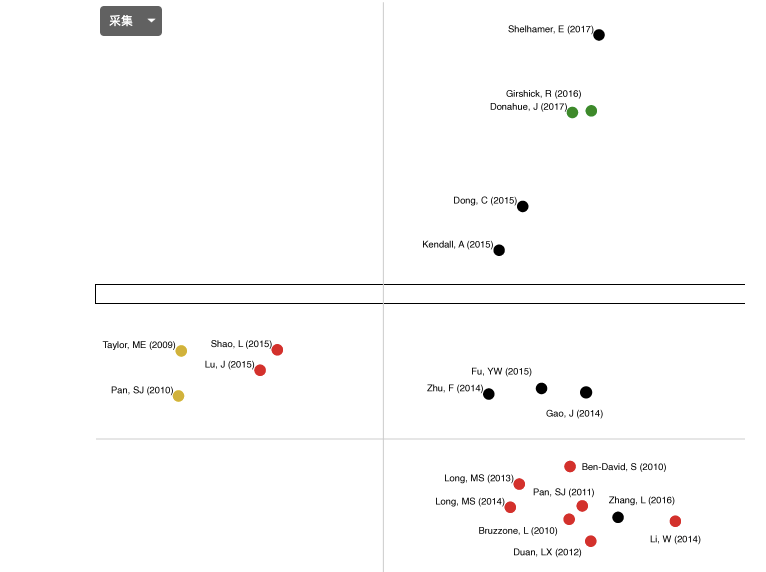

通过不同的方法,我们以与以前相同的方式大致进行聚类。在图8中,每个象限代表图5中的一个群集。这有力地支持了该分析论证。

在图10中,可以看到图8中每个象限的“词云” 。这些术语与第3.4节的定性分析非常吻合。

数据来源:WoS(março/ 2019)工具:ScatterText(kessler2017scattertext)

数据来源:WoS(março/ 2019)工具:ScatterText(kessler2017scattertext)

图7: *

图8:通过词袋的接近程度可视化的前20名最常被引用的文章。

数据来源:WoS(2019年3月)。工具:TagCrowd

数据来源:WoS(2019年3月)。工具:TagCrowd

图9: *

图10:图表8所有象限的词云。

3.5 研究前沿

为了确定迁移学习中的研究前沿,我们进行了两项分析:

3.5.1 文字分析

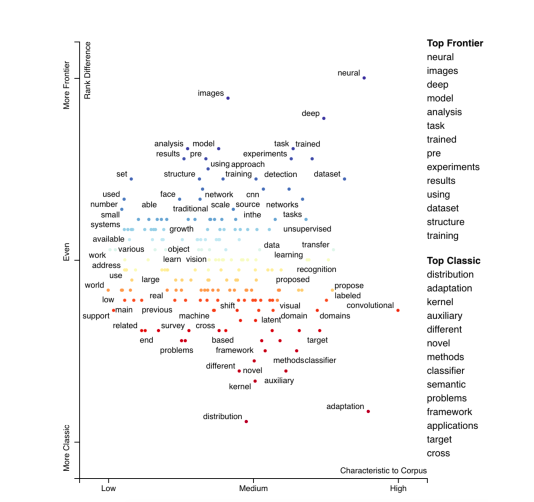

我们使用 ScatterText (kessler2017scattertext)进行可视化,对能够更好地代表术语“3yearsSearch”和更好地代表“10yearsSearch”的术语进行对比,得到图12。

与研究前沿更相关的术语包括是深层的、神经的、图像和诸如 cnn、受过训练的网络和数据集等词汇。这与我们对第3.4.3节中的第三波浪潮的分析相符。与“ 10yearsSearch”更相关的术语是:分布、域、适应、辅助(来自辅助任务)、内核;这与我们在第3.4.2节中第二波浪潮中的发现的非常吻合。

图11: *

数据来源:WoS(2019年3月)。工具:ScatterText(kessler2017scattertext)

图12:在迁移学习上下文中对“前沿”术语与“经典”术语的可视化分析

3.5.2 书目耦合

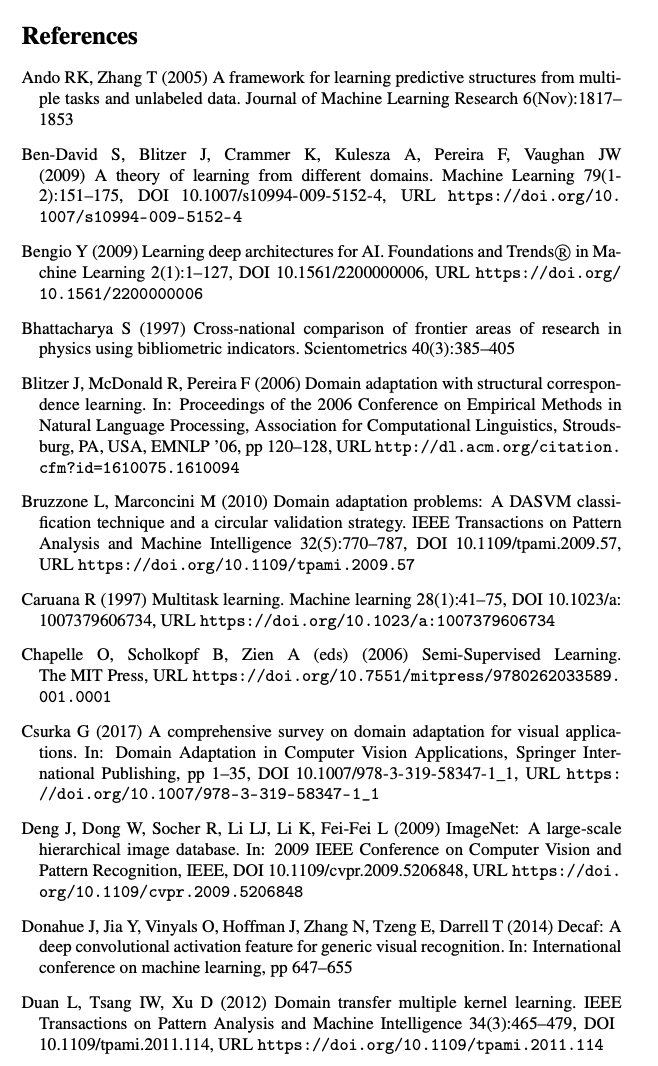

使用 VosViewer (VOSviewer)分析“ 3yearsSearch”文章进行书目耦合分析的结果如图 14 所示。

数据来源:WoS(2019年3月)。工具:VosViewer

数据来源:WoS(2019年3月)。工具:VosViewer

图13: *

图14:书目耦合分析热图

集群中包含 Lucena2017 和 Rezende2017,分别是关于深度卷积网络新问题、人脸反欺诈和伪图像检测上的应用。Venkateswara2017 和 Ge2017 提出了使用深度学习的新领域适应方法。显然,该领域的每项工作都与深度迁移学习有关。

3.5.3 未来的经典

如前所述,使用书目耦合进行的定量分析可以显示哪些文章处于前沿(深度迁移学习中的那些),而不代表和这些文章具有潜力。为此,对候选文章进行定性分析至关重要。

在这种情况下,我们在这里重点介绍一些我们认为有可能成为未来经典的作品:

-

Taskonomy:CVPR 2018 的最佳论文之一,本文探讨了任务之间的关系并对其进行了量化,建立了可用于定义训练序列的图表,从而可以减少特定任务的样本复杂度。

-

ulmfit:通过利用迁移学习,对于某些 NLP 问题,ULMFit 模型的性能比以前的水平提高了18% 至 24%,并凸显了 alexnet 对于计算机视觉的意义。

-

CycleGan:提出针对无监督域传输的生成对抗网络(GAN)。对于 GAN 在迁移学习中的潜力,我们非常乐观。

-

Ruder2019Neural:提出了一种新的分类法,用于在 NLP 上下文中进行迁移学习。

4 未解决的问题

本系统综述使我们能够感知到在现在积累的知识上的一些差距。这些未解决的问题包括:

-

指标:没有用于迁移学习的特定指标。

-

分类法:当前分类法(PanYang)过于关注领域适应,而对归纳迁移学习的关注却很少。另外,我们需要更多像 GAN 和自动编码器一样的更新颖的想法。

-

NLP:除了 Ruder2019Neural 之外,关于迁移学习用于 NLP 的知识还很少。

-

理论:在第一波浪潮中,理论的作用是希望找到有潜力的方法。今天,有些方法在实践中行之有效,但却无法从理论上得到解释。知道为什么也很重要。

5 结论

这篇系统的文献综述指出了深度迁移学习是迁移学习的研究前沿。这是一个非常广泛的子领域,包括:a)使用预训练模型作为新应用程序的特征提取;b)查找域之间的潜在表示;c)域之间无监督的样式转换;等等。在这项工作中,我们以 TEMAC 方法为指导,并用其他分析工具进行了扩展,以验证我们的结论。这样,我们证明了通过对书目数据进行基于定量的分析方法来确定研究前沿的可能性,这种方法使我们能够得到研究问题的答案。

在以后的工作中,仍然需要解决一些重要的问题:首先,PanYang 分类法已经过时,很显然,这种方法侧重于十年前已经完成的工作,且没有为前沿研究文章分类提供太多指导。此外,系统的评价方法还有待改进:1)可以包括 Scopus 和 Google Scholar 等其他基础方法;2)我们可以扩展研究查询,以囊括其他术语,如多任务学习、域适应,甚至一些不再使用的术语,如学习如何学习和终身学习; 3)它可以涵盖最重要的文章的摘要,最好采用像五个W和一个H (hohman2018visual)这样的框架 。

最后,从这篇综述中,我们很清楚地意识到需要改进深度学习的理论,以更好地解释深度神经网络中知识迁移的方式和原因。

参考文献:

原文链接:

https://www.arxiv-vanity.com/papers/1912.08812/

(*本文为AI科技大本营整理文

章,转载请微信联系 1092722531)

推荐阅读

-

-

-

-

-

-

-

-

-

你点的每个“在看”,我都认真当成了AI