【新智元导读】作为AI芯片后入者的三星正提着大刀赶来:据外媒爆料,三星已经接近完成一款AI芯片的研发,其性能已经堪比苹果的A11和华为麒麟970,三星极有可能在2月25日举行的MWC 2018大会上发布Galaxy S9的同时,展示其新AI技术的能力。

据《韩国先驱报》网站报道,三星电子已经基本完成第一款神经处理单元(NPU)的开发工作,准备在今年晚些时候部署到设备上。NPU被广泛称为AI芯片,据称三星将在即将发布的智能手机上搭载这款芯片,此举有助于其手机赶超竞争对手。

“据三星内部人士爆料,三星已经基本完成了服务器AI芯片的开发工作,预计该芯片将出售给服务器厂商。”一名AI专家告诉《韩国先驱报》。

除了CPU、GPU等之外,智能手机上再加上NPU的话,手机本身就可以在没有云服务器帮助的情况下处理、分析和存储智能手机上产生的数据。NPU被广泛认为是智能手机的大脑。

目前,三星在这个领域落后于苹果和华为这两个最大的竞争对手,后两者都已经推出了移动端的AI芯片。苹果公司去年发布了iPhone X,使用NPU实现脸部识别和动画表情符号等人们熟知的功能。紧接着,华为推出了一款能够随时间学习用户习惯的NPU,部署在Mate 10 Pro手机上。

尽管三星对于这个市场是后来者,但那位“AI专家”对韩国先驱报称,“三星已经达到苹果和华为的技术水平,而且在今年下半年肯定会推出更好的芯片。”据报道,三星的芯片每秒运行的速度超过了苹果的A11和华为的麒麟970。

此外,同一消息人士透露,三星可能将在2月25日举行的MWC 2018大会上发布Galaxy S9的同时,展示其新AI技术的能力。

据称三星在人工智能相关项目上投入了大量资金,并与韩国各大学的教授和研究人员合作,以制造出相比竞争对手更安全、更高效的芯片。

该消息人士透露,三星还正在为Galaxy Note 9智能手机开发一款增强的NPU,该款手机预计在今年9月份发布。就像之前的Galaxy Note 7和Note 8一样,Note 9可能成为三星的一个转折点。

正如上文所说,三星的这款AI芯片,主要的竞争对手是苹果和华为。目前,苹果的iPhoneX和华为的Mate10(Pro)、V10等系列手机均已经使用人工智能芯片,成为AI手机的领导者。

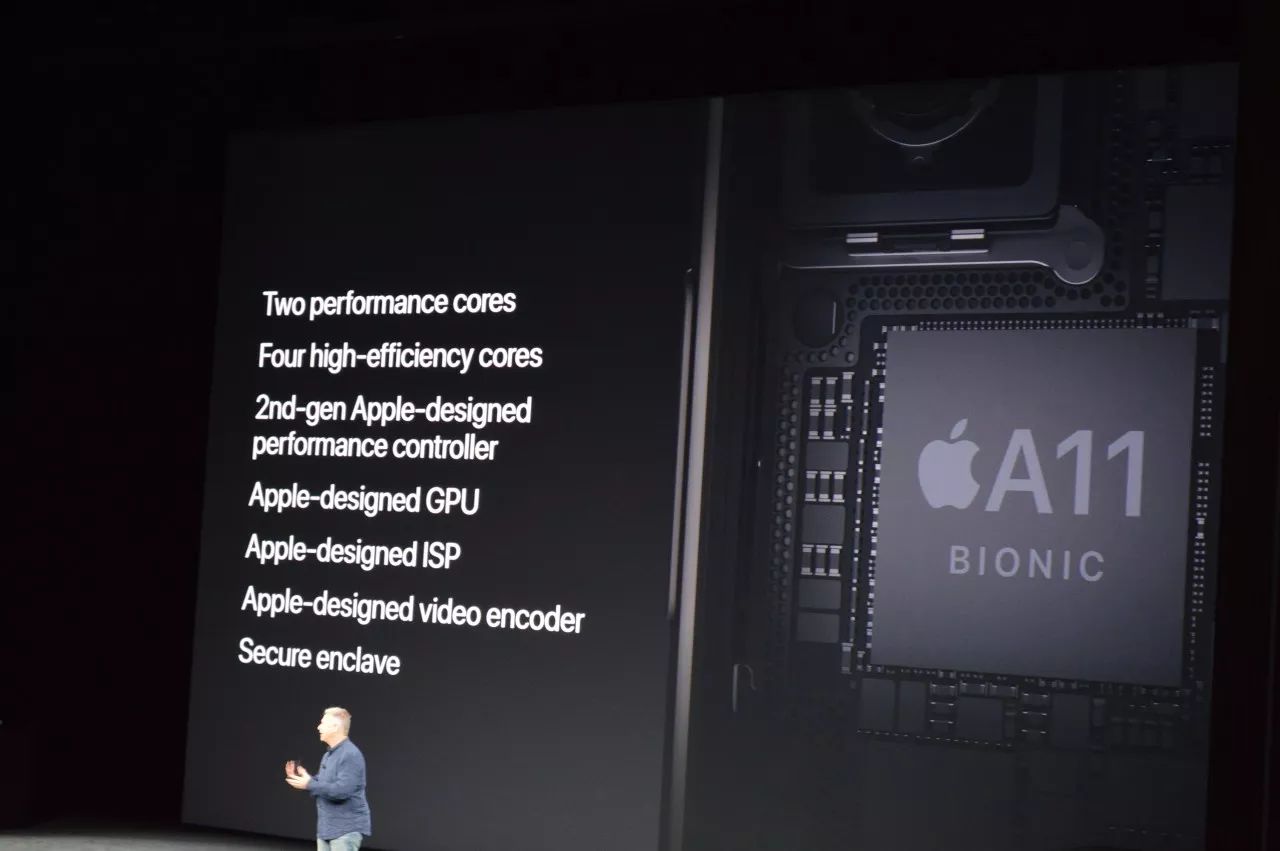

iPhone X中的“A11生物神经网络引擎”(A11 bionic neural engine)芯片,每秒运算次数最高可达6000亿次,相当于0.6TFlops(寒武纪NPU则是1.92TFlops,每秒可以进行19200次浮点运算),采用了六核心设计,由2个高性能核心与4个高能效核心组成。相比A10,其中两个性能核心的速度提升了25%,四个能效核心的速度提升了70%。工艺方面,A11采用了台积电10nm FinFET工艺,集成了43亿个晶体管。

A11能帮助加速人工智能任务,包括Face ID,Animoji和AR应用程序。A11同时支持Core ML,这是苹果在WWDC开发者大会上推出的一款新型机器学习框架。Core ML支持所有主要的神经网络,如DNN、RNN、CNN等,开发者可以把训练完成的机器学习模型封装进App之中。

华为麒麟970芯片,首次采用台积电10nm工艺,集成55亿个晶体管(骁龙835是31亿颗,苹果A10是33亿颗),功耗降低20%。采用4个Cortex A73 核心,4个Cortex A53 核心,GPU为具有12个核心的 Mali-G72 MP12,每秒处理速度可达万亿次。麒麟970芯片内置全新升级自研相机双ISP,支持人工智能场景识别、人脸追焦、智能运动场景检测,同时夜拍效果再次升级。基带方面,麒麟970采用了更先进的4.5G LTE技术,支持全球最高是LTE Cat.18规格,实现目前业界最高的1.2Gbps峰值下载速率。同时内建TEE和inSE安全引擎,拥有更高的安全性。

不过,三星、苹果、华为“三国杀”的局面不会持续很久。

由于智能手机的竞争进入到严重的同质化阶段,跟全面屏一样,人工智能芯片将会是手机厂商下一个“标配”的重点。除了三星、苹果、华为三巨头,还有很多厂商涌入智能手机和AI芯片的竞争,例如最近传闻将于2018年下半年上市的小米——2017年2月,小米自主研发的手机芯片澎湃S1问世,成为国产手机中第二家拥有自主研发芯片能力的手机厂商。

人工智能芯片对手机性能提升、人机交互等功能上有巨大的想象空间,AI手机特别是高端旗舰AI手机的研发能力是能够拉开与对手差距的重要一步,手机市场格局也会随着研发能力逐渐分化,强者更强,弱者更弱的马太效应将逐渐凸显。

由于GPU存在功耗瓶颈,同时用户越来越关心个人隐私安全与时效性,终端智能芯片的发展顺应时代所需。

终端的智能芯片则需要同时具备高性能与低功耗的特征。此外,终端也涵盖了不同的应用场景,都需要针对具体需求,在功耗、延迟、数据吞吐量、加速器方案的选择上做出调整和优化。

新智元对部分移动端能够支撑AI功能的芯片做了梳理:

谷歌:Pixel VisualCore

2017年10月,Google在其官方博客上公开了Pixel2中使用的一颗专用图像处理协处理器——Pixel VisualCore。这是Google在用于服务器的TPU之后推出的第二颗芯片,这次针对的是移动端。Pixel VisualCore由Google与Intel合作设计开发,主要用于图像处理和机器学习。这块芯片由8个IPU(每个包含512个ALU)+1个Cortex-A53核心组成,最大可提供3TFLOPS浮点运算能力。

高通:骁龙845处理器

说到手机芯片,怎能不提高通。高通在2017年12月初正式发布了骁龙845移动平台。骁龙845处理器采用10纳米LPP制程工艺,其中GPU采用Adreno 630,X20 LTE调制解调器、WiFi、影像方面使用Spectra 280ISP,以及Hexagon 685DSP协处理器、音质方面使用高通Aqstic Audio、CPU采用四个2.8GHz大核+四个1.8GHz小核+2MB缓存的Kryo 385 CPU、移动安全芯片,另在845中新增了一块独立内存。AI方面,骁龙845主要通过Kryo 385定制架构、Adreno 630、Hexagon 685在终端异步运算数据。相比835,骁龙845在AI上的计算能力是835的三倍,目前已经可以支持S845GoogleTensorFlow、Facebook Caffe以及Open NeuralNetwork Exchange在内的多款主流深度学习框架。

Movidius VPU Myriad2

2016年9月,Intel发表声明收购了Movidius。Movidius专注于研发高性能视觉处理芯片。现任CEO是原来德州仪器OMAP部门的总经理,它的技术指导委员会也是实力强大,拥有半导体和处理器行业的元老级人物——被苹果收购的 P.A.Semi 创始人丹尼尔·多伯普尔(Daniel Dobberpuhl),卡内基梅隆大学计算机科学/计算机视觉专家金出武雄,以及前苹果 iPhone 和 iPod 部门工程副总裁、资深工程师大卫·图普曼(David Tupman)三人坐镇。

其最新一代的Myriad2视觉处理器主要由SPARC处理器作为主控制器,加上专门的DSP处理器和硬件加速电路來处理专门的视觉和图像信号。这是一款以DSP架构为基础的视觉处理器,在视觉相关的应用领域有极高的能耗比,可以将视觉计算普及到几乎所有的嵌入式系统中。该芯片已被大量应用在Google 3D项目Tango手机、大疆无人机、FLIR智能红外摄像机、海康深眸系列摄像机、华睿智能工业相机等产品中。

寒武纪 1H8和1H16

寒武纪于2016年发布了全球首款商用深度学习专用处理器IP——寒武纪1A处理器。寒武纪1A的横空出世打破了多项记录,受到了业界广泛关注,入选了第三届世界互联网大会评选的十五项“世界互联网领先科技成果”。2017年11月,在公司首次发布会上,CEO陈天石介绍了三款全新的智能处理器IP产品,其中就包括面向低功耗场景视觉应用的寒武纪1H8、拥有更广泛通用性和更高性能的寒武纪1H16。

陈天石介绍说,与寒武纪1A相比,新品在功耗、能效比、成本开销等方面进行了优化,性能功耗比再次实现飞跃,适用范围覆盖了图像识别、安防监控、智能驾驶、无人机、语音识别、自然语言处理等各个重点应用领域。

地平线旭日和征程

2017年12月20日,地平线在北京举行发布会,推出的征程(Journey)和旭日(Sunrise)两款面向计算机视觉的处理器,分别用于无人驾驶和智能摄像头。旭日和征程都属于嵌入式人工智能视觉芯片,分别面向智能驾驶和智能摄像头。地平线首席芯片架构师周峰对新智元介绍,这两款芯片,芯片性能可达到1Tops,实时处理1080P@30帧,每帧可同时对200个目标进行检测、跟踪、识别。 典型功耗做到1.5w。

深鉴听涛

2017年10月24日,深鉴科技召开发布会,正式对外宣布完成约4000万美元A+轮融资,由蚂蚁金服与三星风投领投。CEO姚颂还公布了一系列芯片计划,由深鉴自主研发的芯片“听涛”、“观海”将于2018年第三季度面市。

其中,“听涛”将于2018年上半年完成产品装载,该系列芯片采用台积电28纳米制程,核心使用深鉴自己的亚里士多德架构,峰值性能1.1瓦 4.1 TOPS。亚里士多德架构针对卷积神经网络而设计。目前,卷积神经网络一般用来处理图像相关的智能问题,而此架构灵活与可扩展的特性使它可被应用于各种不同规格的终端中。

异构智能:NovuTensor

在今年 CES 上,NovuMind(中文名称“异构智能”)向业界首次展示其自主研发的第一款高性能、低功耗的 AI 芯片 NovuTensor,号称可能是除了 TPU 之外,世界上跑得最快的单芯片。

NovuMind 方面表示,这是截至目前世界上唯一能够实际运行的、性能达到主流 GPU/TPU 水平而性能/功耗比却远超主流 GPU/TPU 的芯片——在功耗 12w 的情况下,NovuTensor 每秒可识别 300 张图像,每张图像上,最多可检测 8192 个目标,相比目前最先进的桌面服务器 GPU(250W,每秒可识别 666 张图像),仅使用 1/20 电力即可达到其性能的 1/2;而相比目前最先进的移动端或嵌入式芯片,相同用电的情况下,性能是其三倍以上。据了解,本次 CES 展示的仅仅是 FPGA 版本,等正在流片的 ASIC 芯片正式出厂,性能将提高 4 倍,耗电将减少一半,耗能不超过 5 瓦、可进行 15 万亿次运算的超高性能。

GTI 光矛处理器

成立于2017年初的Gyrfalcon Technology Inc.(简称GTI)近期以“光矛处理器 Lightspeeur 2801S”引发业内关注,这也是一家由中国芯片老兵创立的公司,总部位于美国硅谷。其芯片方案基于APiM架构,有28000个并行神经计算核,真正支持片上并行与原位计算,不需要使用外部存储单元,克服了由存储器带宽而导致的性能瓶颈,在效率能耗比方面表现卓越,达到9.3Tops/Watt,无论在训练模式还是推理模式下均可提供高密度计算性能。

在今年的CES上,GTI推出了内置Lightspeeur 2801S芯片的Laceli 人工智能计算棒,可以在1瓦的功率下提供超过每秒9.3万亿次浮点运算的性能,超越英特尔Movidius的神经计算棒,后者每瓦功率范围的运算力则是0.1万亿次。Laceli 人工智能计算棒可以在多种深度学习场景中应用,包括图像和视频识别、理解及描述, 自然语言理解、自然语言处理等。

加入社群

新智元AI技术+产业社群招募中,欢迎对AI技术+产业落地感兴趣的同学,加小助手微信号: aiera2015_1 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名-公司-职位;专业群审核较严,敬请谅解)。

此外,新智元AI技术+产业领域社群(智能汽车、机器学习、深度学习、神经网络等)正在面向正在从事相关领域的工程师及研究人员进行招募。

加入新智元技术社群 共享AI+开放平台