本文共2200字,建议阅读5分钟。

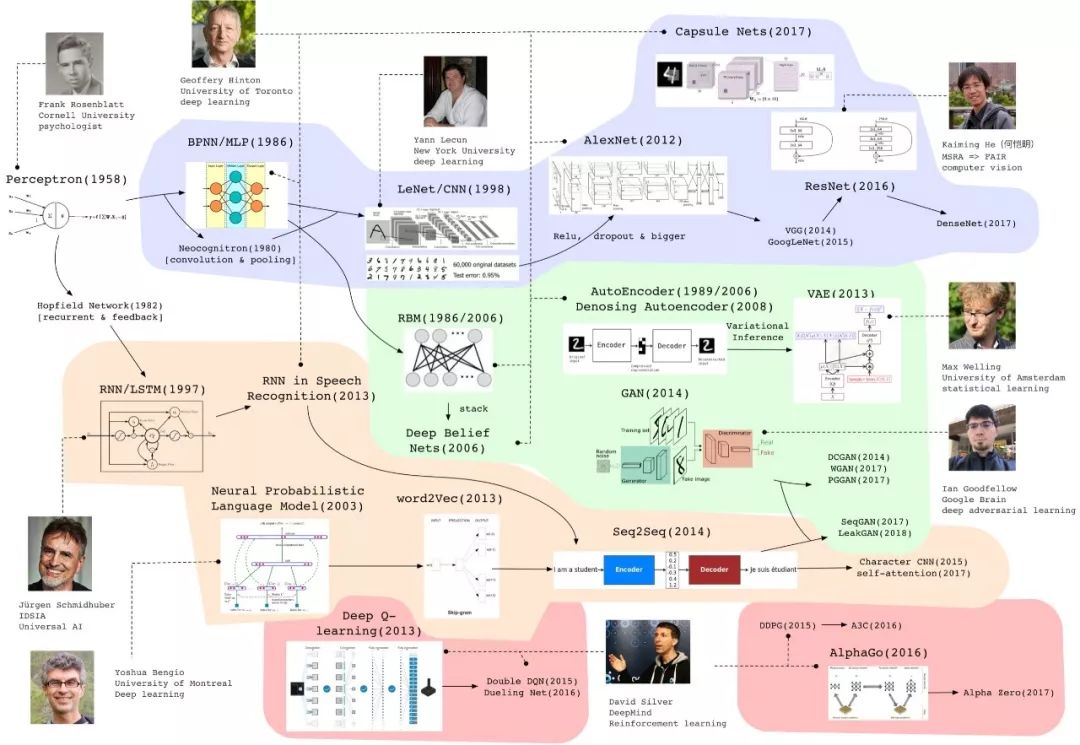

本文为大家梳理深度学习模型近年来的重要进展,文末附梳理图~

唐杰老师学生帮忙整理的Deep Learning模型最近若干年的重要进展。有4条脉络,整理很不错。分享一下。

track1 cv/tensor

1943年出现雏形,1958年研究认知的心理学家Frank发明了感知机,当时掀起一股热潮。后来Marvin Minsky(人工智能大师)和Seymour Papert发现感知机的缺陷:不能处理异或回路、计算能力不足以处理大型神经网络。停滞!

1986年hinton正式地提出反向传播训练MLP,尽管之前有人实际上这么做。

1979年,Fukushima 提出Neocognitron,有了卷积和池化的思想。

1998年,以Yann LeCun为首的研究人员实现了一个七层的卷积神经网络LeNet-5以识别手写数字。

后来svm兴起,这些方法没有很受重视。

2012年,Hinton组的AlexNet在ImageNet上以巨大优势夺冠,兴起深度学习的热潮。其实Alexnet是一个设计精巧的CNN,加上relu、dropout等技巧,并且更大。

这条思路被后人发展,出现了vgg、GooLenet等。

2016年,青年计算机视觉科学家何恺明在层次之间加入跳跃连接,Resnet极大增加了网络深度,效果有很大提升。一个将这个思路继续发展下去的是去年cvpr best paper densenet。

cv领域的特定任务出现了各种各样的模型(Mask-RCNN等),这里不一一介绍。

2017年,hinton认为反省传播和传统神经网络有缺陷,提出Capsule Net。但是目前在cifar等数据集上效果一半,这个思路还需要继续验证和发展。

track2 生成模型

传统的生成模型是要预测联合概率分布P(x,y)。

rbm这个模型其实是一个基于能量的模型,1986年的时候就有,他在2006年的时候重新拿出来作为一个生成模型,并且将其堆叠成为deep belief network,使用逐层贪婪或者wake-sleep的方法训练,不过这个模型效果也一般现在已经没什么人提了。但是从此开始hinton等人开始使用深度学习重新包装神经网络。

Auto-Encoder也是上个世纪80年代hinton就提出的模型,此时由于计算能力的进步也重新登上舞台。bengio等人又搞了denoise Auto-Encoder。

Max welling等人使用神经网络训练一个有一层隐变量的图模型,由于使用了变分推断,并且最后长得跟auto-encoder有点像,被称为Variational auto-encoder。此模型中可以通过隐变量的分布采样,经过后面的decoder网络直接生成样本。

GAN是2014年提出的非常火的模型,他是一个隐的生成模型,通过一个判别器和生成器的对抗训练,直接使用神经网络G隐式建模样本整体的概率分布,每次运行相当于从分布中采样。

DCGAN是一个相当好的卷积神经网络实现,WGAN是通过维尔斯特拉斯距离替换原来的JS散度来度量分布之间的相似性的工作,使得训练稳定。PGGAN逐层增大网络,生成机器逼真的人脸。

track3 sequence learning

1982年出现的hopfield network有了递归网络的思想。1997年Jürgen Schmidhuber发明LSTM,并做了一系列的工作。但是更有影响力的是2013年还是hinton组使用RNN做的语音识别工作,比传统方法高出一大截。

文本方面bengio在svm最火的时期提出了一种基于神经网络的语言模型,后来google提出的word2vec也有一些反向传播的思想。在机器翻译等任务上逐渐出现了以RNN为基础的seq2seq模型,通过一个encoder把一句话的语义信息压成向量再通过decoder输出,当然更多的要和attention的方法结合。

后来前几年大家发现使用以字符为单位的CNN模型在很多语言任务也有不俗的表现,而且时空消耗更少。self-attention实际上就是采取一种结构去同时考虑同一序列局部和全局的信息,google有一篇耸人听闻的attention is all you need的文章。

track4:deep reinforcement learning

这个领域最出名的是deep mind,这里列出的David Silver是一直研究rl的高管。

q-learning是很有名的传统rl算法,deep q-learning将原来的q值表用神经网络代替,做了一个打砖块的任务很有名。后来有测试很多游戏,发在Nature。这个思路有一些进展double dueling,主要是Qlearning的权重更新时序上。

DeepMind的其他工作DDPG、A3C也非常有名,他们是基于policy gradient和神经网络结合的变种(但是我实在是没时间去研究)。

一个应用是AlphaGo大家都知道,里面其实用了rl的方法也有传统的蒙特卡洛搜索技巧。Alpha Zero 是他们搞了一个用alphago框架打其他棋类游戏的游戏,吊打。

(点击查看高清大图)

注:本文获唐老师授权转自其微博。

▼▼▼

唐老师还带领团队研发了研究者社会网络ArnetMiner系统,吸引了220个国家277万个独立IP的访问。AMiner近期持续推出了AI与各领域结合的研究报告,数据派将作为独家媒体合作方陆续发布:

全球知识图谱专家分布、研究流派(附学者名单)

AI+金融:学者、产业、趋势全景报告

全球AI专家分布:人工智能,你真的了解吗?

AI与汽车研究报告:学者、产业、趋势全景报告(附下载)

AMiner权威发布Robotics人才库

AMiner:

清华大学AMiner学术搜索引擎,是一个以科研人员为中心,通过领先的语义分析和挖掘技术,提供在线实时的人才、科技评估报告的情报平台。

系统自上线10年以来,汇集了全球1.3亿科研人员,2.7亿篇论文,吸引了全球超过220个国家800万个独立IP的访问,是除了谷歌scholar之外最大的学术搜索系统。为全球最大学术期刊出版社Elsevier,以及KDD、ICDM、WSDM等20余个重要国际会议提供审稿人推荐及语义信息服务。AMiner项目获2013年中国人工智能学会科学技术进步一等奖,核心理论部分获2013年中国电子学会自然科学二等奖、2017年北京市科技进步一等奖。

了解更多请见官网:www.aminer.cn