来源丨海豚数据科学实验室

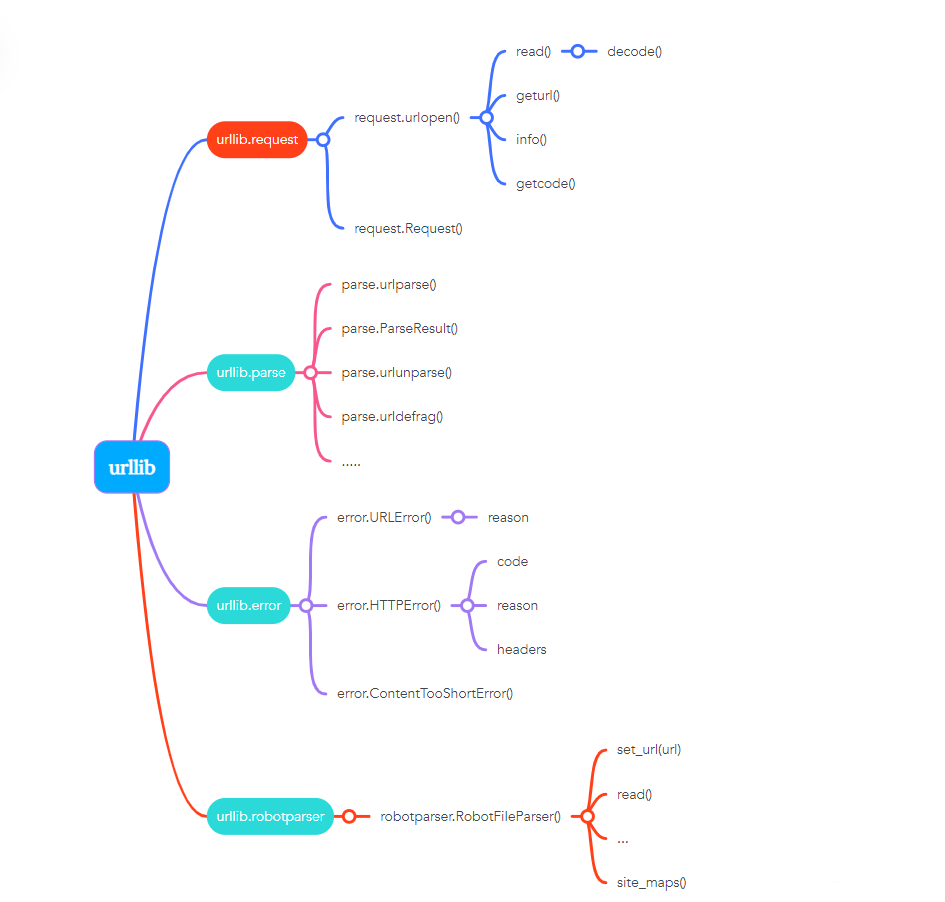

一、Python urllib库

Python urllib 库用于操作网页 URL,并对网页的内容进行抓取处理。

Python3 的 urllib。

urllib 包 包含以下几个模块:

urllib.request - 打开和读取 URL。

urllib.error - 包含 urllib.request 抛出的异常。

urllib.parse - 解析 URL。

urllib.robotparser - 解析 robots.txt 文件。

需要用的就是每个模块的内置方法和函数。大概方法如下图:

urllib.request 定义了一些打开 URL 的函数和类,包含授权验证、重定向、浏览器 cookies等。

urllib.request 可以模拟浏览器的一个请求发起过程。

这里主要介绍两个常用方法,urlopen和Request。

urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None)

url:url 地址。

data:发送到服务器的其他数据对象,默认为 None。

cafile 和 capath:cafile 为 CA 证书, capath 为 CA 证书的路径,使用 HTTPS 需要用到。

context:ssl.SSLContext类型,用来指定 SSL 设置。

import urllib.requesturl=urllib.request.urlopen("https://www.baidu.com")print(url.read().decode('utf-8'))

html>

<html><head><meta http-equiv="Content-Type" content="text/html;charset=utf-8"><meta http-equiv="X-UA-Compatible" content="IE=edge,chrome=1"><meta content="always" name="html{color:#000;overflow-y:scroll;overflow:-moz-scrollbars} body,button,input,select,textarea{font-size:12px;font-family:Arial,sans-serif} h1,h2,h3,h4,h5,h6{font-size:100%} em{font-style:normal} small{font-size:12px} ol,ul{list-style:none} a{text-decoration:none} a:hover{text-decoration:underline} legend{color:#000} fieldset,img{border:0} button,input,select,textarea{font-size:100%} ...

response对象是http.client. HTTPResponse类型,主要包含 read、readinto、getheader、getheaders、fileno 等方法,以及 msg、version、status、reason、debuglevel、closed 等属性。

常用方法:

read():是读取整个网页内容,也可以指定读取的长度,如read(300)。获取到的是二进制的乱码,所以需要用到decode()命令将网页的信息进行解码。

readline() - 读取文件的一行内容。

readlines() - 读取文件的全部内容,它会把读取的内容赋值给一个列表变量。

info():返回HTTPMessage对象,表示远程服务器返回的头信息。

getcode():返回Http状态码。如果是http请求,200请求成功完成;404网址未找到。

geturl():返回请求的url。

2、Request类

我们抓取网页一般需要对 headers(网页头信息)进行模拟,否则网页很容易判定程序为爬虫,从而禁止访问。这时候需要使用到 urllib.request.Request 类:

class urllib.request.Request(url, data=None, headers={}, origin_req_host=None, unverifiable=False, method=None)

url:url 地址。

data:发送到服务器的其他数据对象,默认为 None。

headers:HTTP 请求的头部信息,字典格式。

origin_req_host:请求的主机地址,IP 或域名。

unverifiable:很少用整个参数,用于设置网页是否需要验证,默认是False。。

method:请求方法, 如 GET、POST、DELETE、PUT等。

示例:

import urllib.requesturl = "https://www.baidu.com"headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.122 Safari/537.36"}req = urllib.request.Request(url=url,headers=headers)response = urllib.request.urlopen(req)print(response.read().decode("utf-8"))

urllib.error 模块为 urllib.request 所引发的异常定义了异常类,基础异常类是 URLError。

urllib.error 包含了两个方法,URLError 和 HTTPError。

URLError 是 OSError 的一个子类,用于处理程序在遇到问题时会引发此异常(或其派生的异常),包含的属性 reason 为引发异常的原因。

HTTPError 是 URLError 的一个子类,用于处理特殊 HTTP 错误例如作为认证请求的时候,包含的属性 code 为 HTTP 的状态码, reason 为引发异常的原因,headers 为导致 HTTPError 的特定 HTTP 请求的 HTTP 响应头。

区别:

关系:

1. URLError 示例

from urllib import requestfrom urllib import error

if __name__ == "__main__":

url = "http://www.baiiiduuuu.com/" req = request.Request(url) try: response = request.urlopen(req) html = response.read().decode('utf-8') print(html) except error.URLError as e: print(e.reason)

[Errno -2] Name or service not known

reason:

此错误的原因。它可以是一个消息字符串或另一个异常实例。

2. HTTPError示例

from urllib import request

from urllib import error

if __name__ == "__main__": url = "http://www.baidu.com/no.html" req = request.Request(url) try: response = request.urlopen(req) html = response.read().decode('utf-8') print(html) except error.HTTPError as e: print(e.code)

code

一个 HTTP 状态码,具体定义见 RFC 2616。这个数字的值对应于存放在

http.server.BaseHTTPRequestHandler.responses 代码字典中的某个值。

reason

这通常是一个解释本次错误原因的字符串。

headers

导致 HTTPError 的特定 HTTP 请求的 HTTP 响应头。

3. URLError和HTTPError混合使用

注意:由于HTTPError是URLError的子类,所以捕获的时候HTTPError要放在URLError的上面。

示例:

from urllib import requestfrom urllib import error

if __name__ == "__main__": url = "http://www.baidu.com/no.html" req = request.Request(url) try: response = request.urlopen(req) except error.HTTPError as e:

print(e.code) except error.URLError as e: print(e.code)

from urllib import requestfrom urllib import error

if __name__ == "__main__": url = "http://www.baidu.com/no.html" req = request.Request(url) try: response = request.urlopen(req) except error.URLError as e: if hasattr(e, 'code'):

print("HTTPError") print(e.code) elif hasattr(e, 'reason'): print("URLError") print(e.reason)

模块定义的函数可分为两个主要门类: URL 解析和 URL 转码。

4.1 URL 解析

4.1.1 urlparse()

urllib.parse 用于解析 URL,格式如下:

urllib.parse.urlparse(urlstring, scheme='', allow_fragments=True)

urlstring 为 字符串的 url 地址,scheme 为协议类型。

allow_fragments 参数为 false,则无法识别片段标识符。相反,它们被解析为路径,参数或查询组件的一部分,并 fragment 在返回值中设置为空字符串。

标准链接格式为:

scheme://netloc/path;params?query

对象中包含了六个元素,分别为:协议(scheme)、域名(netloc)、路径(path)、路径参数(params)、查询参数(query)、片段(fragment)。

示例:

from urllib.parse import urlparse

o = urlparse("https://docs.python.org/zh-cn/3/library/urllib.parse.html#module-urllib.parse")

print('scheme :', o.scheme)print('netloc :', o.netloc)print('path :', o.path)print('params :', o.params)print('query :', o.query)

print('fragment:', o.fragment)print('hostname:', o.hostname)

scheme : https netloc : docs.python.org path : /zh-cn/3/library/urllib.parse.html params : query : fragment: module-urllib.parse hostname: docs.python.org

print(o[0])

...print(o[5])

4.1.2 urlunparse()

urlunparse()可以实现URL的构造。(构造URL)

urlunparse()接收一个是一个长度为6的可迭代对象,将URL的多个部分组合为一个URL。若可迭代对象长度不等于6,则抛出异常。

示例:

from urllib.parse import urlunparseurl_compos = ['http','www.baidu.com','index.html','user= test','a=6','comment']print(urlunparse(url_compos))

4.1.3 urlsplit()

urlsplit() 函数也能对 URL 进行拆分,所不同的是, urlsplit() 并不会把 路径参数(params) 从 路径(path) 中分离出来。

当 URL 中路径部分包含多个参数时,使用 urlparse() 解析是有问题的,这时可以使用 urlsplit() 来解析.

4.1.4 urlsplit()

urlunsplit()与 urlunparse()类似,(构造URL),传入对象必须是可迭代对象,且长度必须是5。

示例:

from urllib.parse import urlunspliturl_compos = ['http','www.baidu.com','index.html','user= test','a = 2']print(urlunsplit(url_compos))urlunsplit()

http://www.baidu.com/index.html?user= test

4.1.5 urljoin()

同样可以构造URL。

传递一个基础链接,根据基础链接可以将某一个不完整的链接拼接为一个完整链接.

注:连接两个参数的url, 将第二个参数中缺的部分用第一个参数的补齐,如果第二个有完整的路径,则以第二个为主。

4.2 URL 转码

python中提供urllib.parse模块用来编码和解码,分别是urlencode()与unquote()。

4.2.1 编码quote(string)

URL 转码函数的功能是接收程序数据并通过对特殊字符进行转码并正确编码非 ASCII 文本来将其转为可以安全地用作 URL 组成部分的形式。它们还支持逆转此操作以便从作为 URL 组成部分的内容中重建原始数据,如果上述的 URL 解析函数还未覆盖此功能的话

语法:

urllib.parse.quote(string, safe='/', encoding=None, errors=None)

使用 %xx 转义符替换 string 中的特殊字符。字母、数字和 '_.-~' 等字符一定不会被转码。在默认情况下,此函数只对 URL 的路径部分进行转码。可选的 safe 形参额外指定不应被转码的 ASCII 字符 --- 其默认值为 '/'。

string 可以是 str 或 bytes 对象。

示例:

from urllib import parse

url = "http://www.baidu.com/s?wd={}"

words = "爬虫"

query_string = parse.quote(words)url = url.format(query_string)print(url)

http://www.baidu.com/s?wd=%E7%88%AC%E8%99%AB

4.2.2 编码urlencode()

quote()只能对字符串编码,而urlencode()可以对查询字符串进行编码。

from urllib import parse

query_string = {'wd':'爬虫'}result = parse.urlencode(query_string)

url = 'http://www.baidu.com/s?{}'.format(result)print(url)

http://www.baidu.com/s?wd=%E7%88%AC%E8%99%AB

4.2.3 解码unquote(string)

解码就是对编码后的url进行还原。

示例:

from urllib import parsestring = '%E7%88%AC%E8%99%AB'result = parse.unquote(string)print(result)

执行结果:

urllib.robotparser 用于解析 robots.txt 文件。

robots.txt(统一小写)是一种存放于网站根目录下的 robots 协议,它通常用于告诉搜索引擎对网站的抓取规则。

Robots协议也称作爬虫协议,机器人协议,网络爬虫排除协议,用来告诉爬虫哪些页面是可以爬取的,哪些页面是不可爬取的。它通常是一个robots.txt的文本文件,一般放在网站的根目录上。

当爬虫访问一个站点的时候,会首先检查这个站点目录是否存在robots.txt文件,如果存在,搜索爬虫会根据其中定义的爬取范围进行爬取。如果没有找到这个文件,搜索爬虫会访问所有可直接访问的页面。

urllib.robotparser 提供了 RobotFileParser 类,语法如下:

class urllib.robotparser.RobotFileParser(url='')

这个类提供了一些可以读取、解析 robots.txt 文件的方法:

set_url(url) - 设置 robots.txt 文件的 URL。

read() - 读取 robots.txt URL 并将其输入解析器。

parse(lines) - 解析行参数。

can_fetch(useragent, url) - 如果允许 useragent 按照被解析 robots.txt 文件中的规则来获取 url 则返回 True。

mtime() -返回最近一次获取 robots.txt 文件的时间。这适用于需要定期检查 robots.txt 文件更新情况的长时间运行的网页爬虫。

modified() - 将最近一次获取 robots.txt 文件的时间设置为当前时间。

crawl_delay(useragent) -为指定的 useragent 从 robots.txt 返回 Crawl-delay 形参。如果此形参不存在或不适用于指定的 useragent 或者此形参的 robots.txt 条目存在语法错误,则返回 None。

request_rate(useragent) -以 named tuple RequestRate(requests, seconds) 的形式从 robots.txt 返回 Request-rate 形参的内容。如果此形参不存在或不适用于指定的 useragent 或者此形参的 robots.txt 条目存在语法错误,则返回 None。

site_maps() - 以 list() 的形式从 robots.txt 返回 Sitemap 形参的内容。如果此形参不存在或者此形参的 robots.txt 条目存在语法错误,则返回 None。

点这里👇关注我,记得标星哦~