作者|Sam Liu,Second State 工程师,CNCF WasmEdge 维护者 & Miley Fu,CNCF 大使,WasmEdge DevRel

2023 年 9 月 6 日,Second State 工程师 Sam Liu 在 QCon 全球软件开发大会(北京站)2023 分享了题为《构建未来软件的编程语言》的演讲。该演讲旨在解析当前主流的 Python 和 Docker 方法在为大型语言模型(LLM)应用程序构建基础设施时所面临的挑战,并向听众介绍 Rust + WebAssembly 方法的优势,强调了其在解决与传统方法相关的性能、安全性和效率问题方面的潜力。演讲中,Sam 分享了 Rust 和 WebAssembly 在构建强大的 AI 基础设施方面的实际应用案例,演讲内容丰富,包含参考文献、代码片段和图表等,希望能帮助读者全面理解该主题。本文由 Second State 根据现场演讲整理。

完整幻灯片下载:

https://qcon.infoq.cn/202309/beijing/presentation/5466

在不断发展的技术世界中,由大语言模型驱动的应用程序,通常被称为“LLM 应用”,已成为各种行业技术创新背后的驱动力。随着这些应用程序的普及,用户需求的大量涌入对底层基础设施的性能、安全性和可靠性提出了新的挑战。

Python 和 Docker 一直是构建机器学习应用程序的主流选择。然而,当涉及到为大型语言模型(LLM)应用程序构建基础设施时,这种组合的一些缺点变得更加严重,例如 Python 的性能问题和 Docker 的冷启动问题。本演讲重点关注为 LLM 生态构建基础设施的主要场景,并深入探讨 Python 和 Docker 组合的问题,更重要的是,为什么 Rust + WebAssembly (WASM) 优于 Python + Docker。最后,我们将演示如何在 flows.network 平台上构建一个代码检查机器人。

现有解决方案:Python + Docker 方法

在机器学习领域,Python 几乎称王,主要得益于以下三个特点:

易于学习: Python 是一种高级语言,语法简单,易于学习和使用。对于 AI 新手或需要快速原型设计和测试想法的开发者,这可能至关重要。

庞大的社区: Python 拥有庞大且活跃的开发者社区,这意味着有许多库和工具可用于 AI 开发。对于需要快速找到常见问题解决方案的开发者来说,这是个优势。

灵活性: Python 用途多样,可用于广泛的 AI 任务,包括数据分析、机器学习和自然语言处理。对于需要从事多个 AI 项目的开发者而言很有吸引力。

Docker 容器作为当今最流行的容器管理工具之一,为应用部署提供了极大的便利:

可移植性: Docker 容器被设计为可移植的,这意味着它们可以在不同环境之间轻松移动。对于需要将 AI 应用程序部署到多个平台或云提供商的开发者来说,这可能是一个优势。

隔离: Docker 容器在应用程序和主机操作系统之间提供了高度的隔离,可以提高安全性和稳定性。对于需要高级别安全性的组织来说,这可能是一个优势。

可扩展性: Docker 容器可以轻松扩展或缩小以满足不断变化的需求,这对于需要大量计算或需要处理大型数据集的 AI 应用程序来说是一个优势。

对于传统机器学习应用的开发和部署,Python+Docker 模式展现了其优势。然而,在 LLM 生态的基础设施建设中,却面临着挑战。

Python 和 Docker 的优点自然也带来了一些缺点。然而,在 LLM 生态基础设施建设的过程中,这些缺陷变得更加突出,成为关键障碍。让我们先看看 Python 存在的问题。

Python 是一种解释性语言,这意味着它可能比 C++ 或 Rust 等编译语言慢。当处理需要大量计算的大型数据集或复杂模型时,这可能是一个缺点。

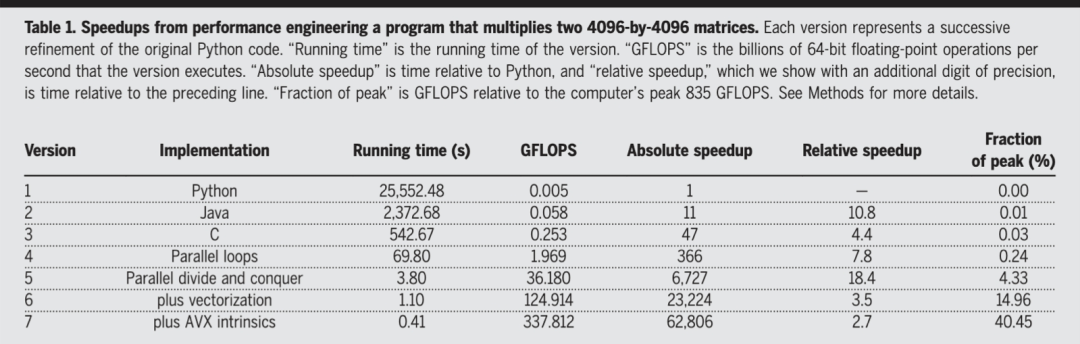

在图 1 中,前三行分别显示了用 Python、Java 和 C 编写的将两个 4096 x 4096 矩阵相乘的编程性能。从“运行时间(秒)”一栏的统计数据可以看出,(1)Java(作为静态编程语言)比 Python(作为动态编程语言)快 10 倍;(2) C(作为非 GC 编程语言)比 Python(作为 GC 编程语言)快 50 倍。

图 1 程序性能工程的加速 将两个 4096×4096 矩阵相乘。

为了改善 Python 语言本身的性能问题,常见的做法是使用 Python 作为负责与用户交互的前端语言,同时选择 C/C++/Rust 等高性能编程语言作为后端 语言来处理繁重的计算任务。Python 生态中很多知名库都采用这种方式来满足高性能计算的需求,比如 Numpy。然而,这种混合编程方法不可避免地需要额外的工具(或库)作为“连接”两种不同编程语言的桥梁。因此,这个过程可能会带来新的问题。

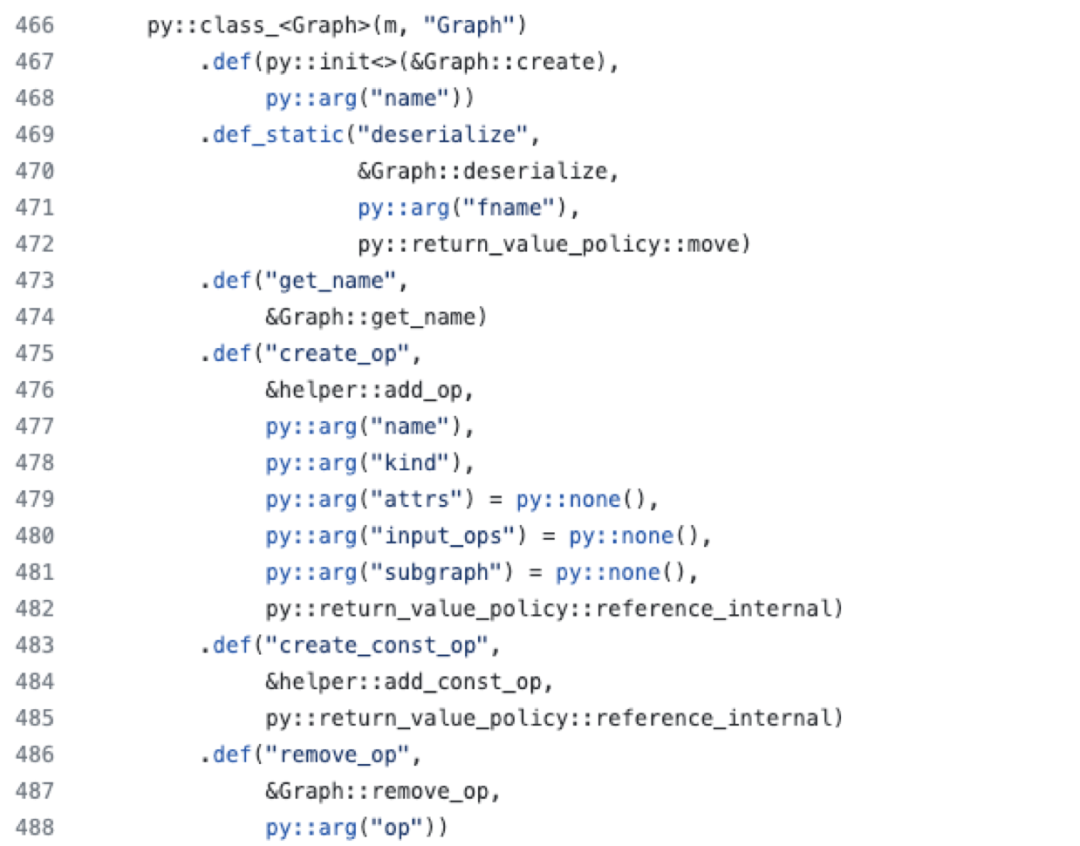

假设我们想要“绑定” Python 和 C++ API,我们必须使用第三方库来自动化这个转换过程,例如 Pybind11。图 2 中的示例代码展示了如何使用 Pybind11 “绑定” C++ 和 Python 程序。不难看出,尽管 Pybind11 极大地简化了转换过程,但添加或删除任何 C++ API 都需要对转换代码进行相应的更改,并且更改的难度与变更内容密切相关。从成本角度来看,这个过程不仅增加了开发者的学习成本,也增加了项目的开发和维护成本。

图 2 将 C++ 和 Python“粘合”在一起。

这些限制凸显了对替代解决方案的需求,例如 Rust + WebAssembly,它有望解决其中一些痛点,并为部署 LLM 应用程序提供更高效、更安全的环境。

AGI 将是由 Rust 和

WebAssembly 构建为什么 Rust 和 WebAssembly 可以成为 AGI 的语言?

性能。 Rust 是一种编译语言,以其极快的性能而闻名。当与基于堆栈的虚拟机的二进制指令格式 WebAssembly 结合使用时,这两个组合有望提供无与伦比的执行速度。

内存安全。 Rust 的突出特点之一是它强调内存安全而不牺牲性能。这确保了应用程序既快速又安全。

并发性。 Rust 的并发性方法是独一无二的。它确保在编译时捕获数据竞争(并发系统中最常见和最具挑战性的错误之一)。这意味着开发者可以编写并发代码,而不必担心引入难以检测的运行时错误。

富有表现力的类型系统。 Rust 拥有强大且富有表现力的类型系统。该系统不仅有助于在编译时捕获错误,而且还允许开发者以清晰简洁的方式表达他们的意图。

现代包管理。 Cargo,Rust 的包管理器,简化了管理依赖项、构建项目甚至发布库的过程。因其易用性和高效性而受到赞誉的工具。

快速增长的生态。 Rust 的生态正在蓬勃发展。像“ndarray”、“llm”、“candle”和“burn”这样的库证明了社区积极参与扩展 Rust 的能力。

Shivraj Jadhav 从多个维度比较了 Docker 容器和 WASM。

表 1 WASM 与 Docker

可移植性。 WebAssembly 被设计为用于编译高级语言的可移植目标,允许部署在 Web 和 服务端,跨不同硬件。

沙箱机制。 WebAssembly 引入了沙箱机制,提供更安全的生产环境。这可以确保代码在隔离的环境中运行,从而最大限度地减少潜在风险。

保护用户数据和系统资源。 WebAssembly 的设计考虑了安全性。它确保用户数据和系统资源免受潜在威胁。

字节码验证。 在执行之前,WebAssembly 字节码会经过验证过程,以防止恶意代码运行。这增加了额外的安全层。

隔离执行环境。 WebAssembly 中的模块在隔离环境中运行。这意味着即使一个模块出现问题,也不会影响其他模块的正常运行。

占用空间更小。 使用 Rust 和 WebAssembly,开发者可以事半功倍。编译后的代码通常要小得多,从而加快加载时间并提高执行效率。

除了上述优点之外,WebAssembly 针对机器学习应用的 WASI-NN 标准也是一个重要因素。

最新发布的 WasmEdge 0.13.5 已经支持使用 Rust 和 Wasm 运行 llama2 系列大模型,包括但不限于我们熟知的 Codellama、Mistral、OpenChat、BELLE-Llama2、Yi-34B 等等。详情请查看 llama-utils。

在本节中,我们将演示如何使用“flows.network”平台构建代码检查代理。在深入讨论具体示例之前,我们首先看一下“Agent”和“flows.network”平台的概念模型。

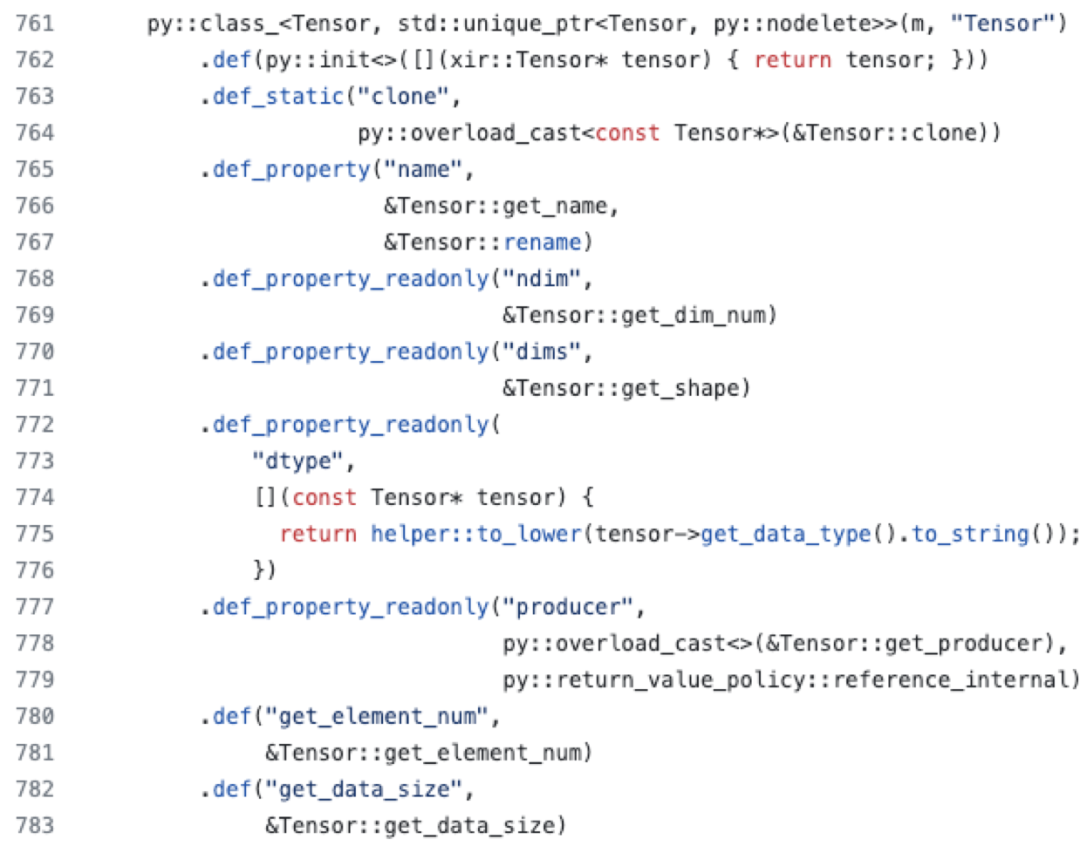

这是 Lilian Weng 提出的基于 LLM 的 AI Agent 的概念框架。

图 3 LLM 驱动的自治代理系统概述

在这个模型中,LLM 函数扮演了智能体大脑的角色,负责核心推理和决策,但它仍然需要额外的模块来启用关键能力:规划、长 / 短期记忆和工具使用。

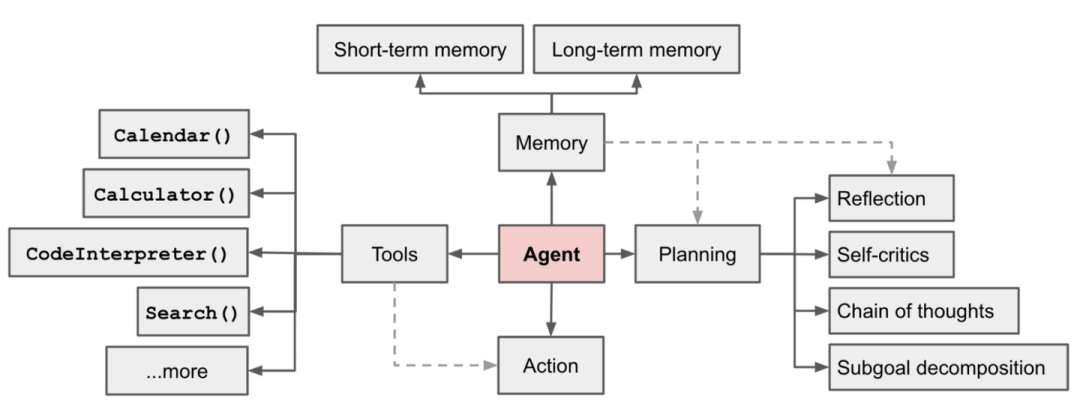

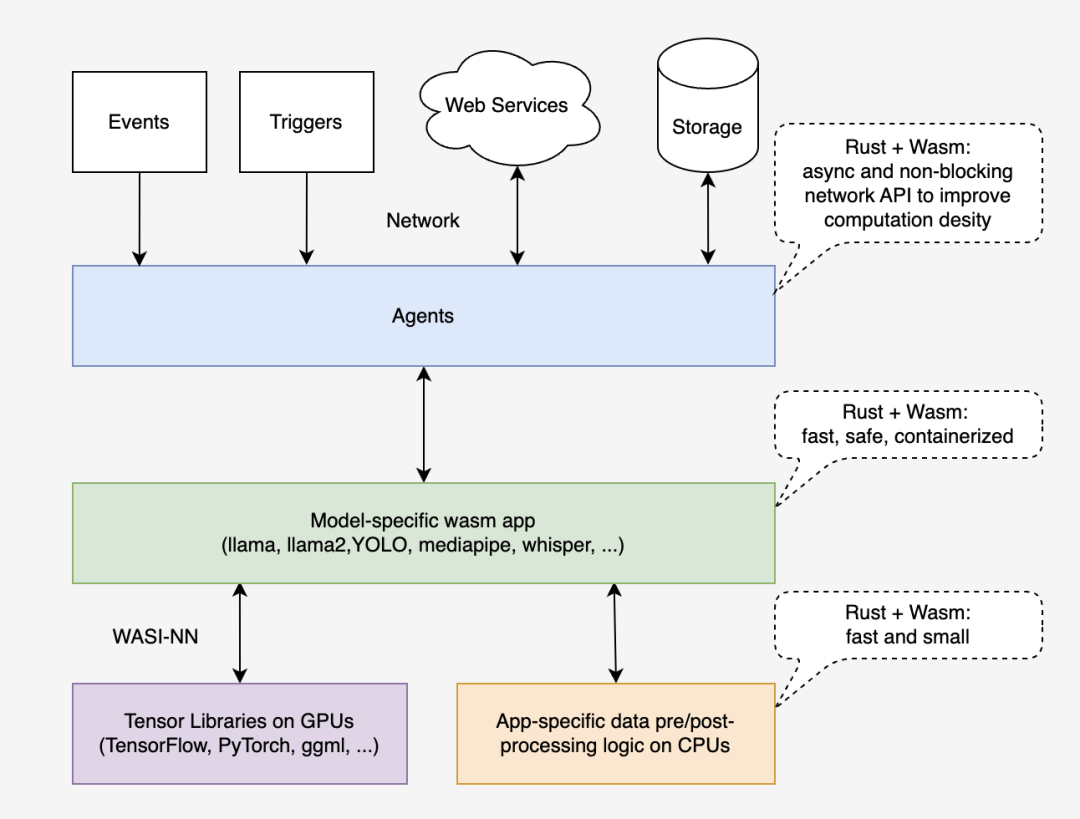

“flows.network”平台是基于与 Lilian 提出的模型类似的理念构建的。图 4 显示了其主要组件。整个平台是用 Rust 编写的,编译为 wasm 模块,并在 WasmEdge Runtime 上运行。

图 4 Flows.network 的主要组件

在“flows.network”平台上,我们提供了一个代理(一个机器人模版)来帮助 GitHub 上开源项目的维护者审核 PR。将其命名为“代码检查机器人”。

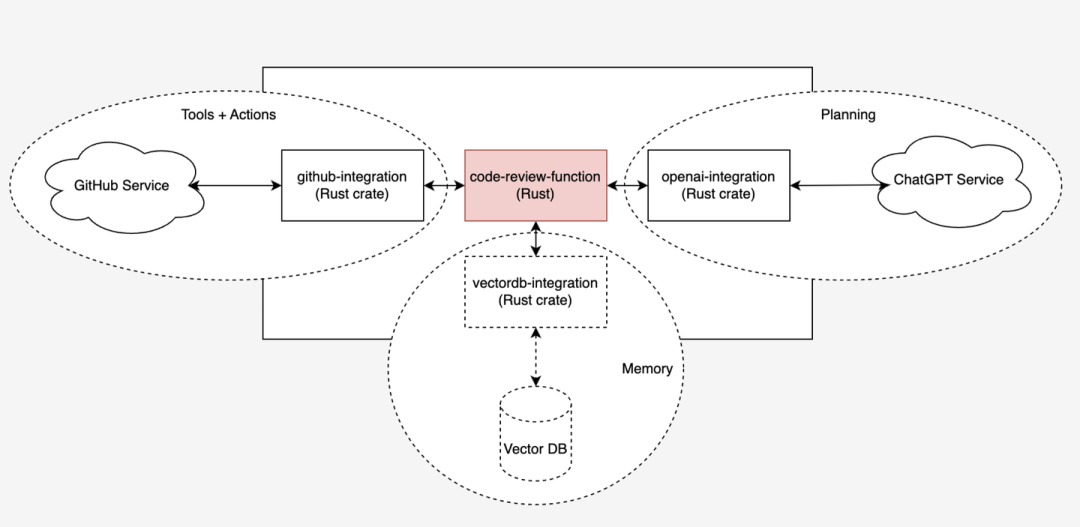

代理的抽象设计如图 5 所示。图中中心的红色块code-review-function 定义了核心代理函数,而红色块周围的每个虚线圆圈与直接连接到图 3 中“代理”块的对应部分相匹配。

图 5 Code Review Bot 抽象设计

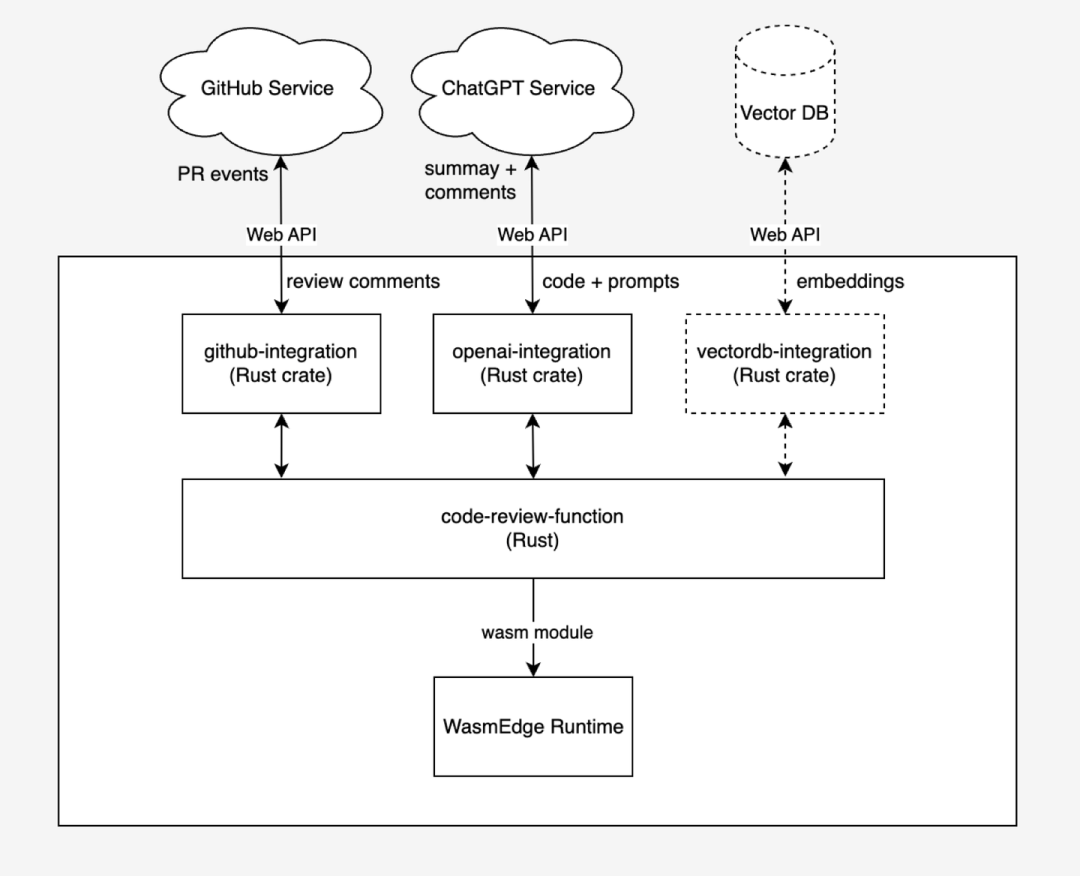

图 6 描述了Code Review Bot的架构。除了 GitHub Service 等外部资源外,代理由 wasm 模块组成,并在 WasmEdge Runtime 上运行。集成 wasm 模块负责通过 Web API 将 WebAssembly 函数连接到外部资源。例如,“code-review-function” wasm 模块将审核中的代码提取为提示词,然后“openai-integration” wasm 模块将提示词发送到 ChatGPT 服务并等待响应;最后,将评论发送到 code-review-function wasm 模块。

图.6 架构代码检查机器人

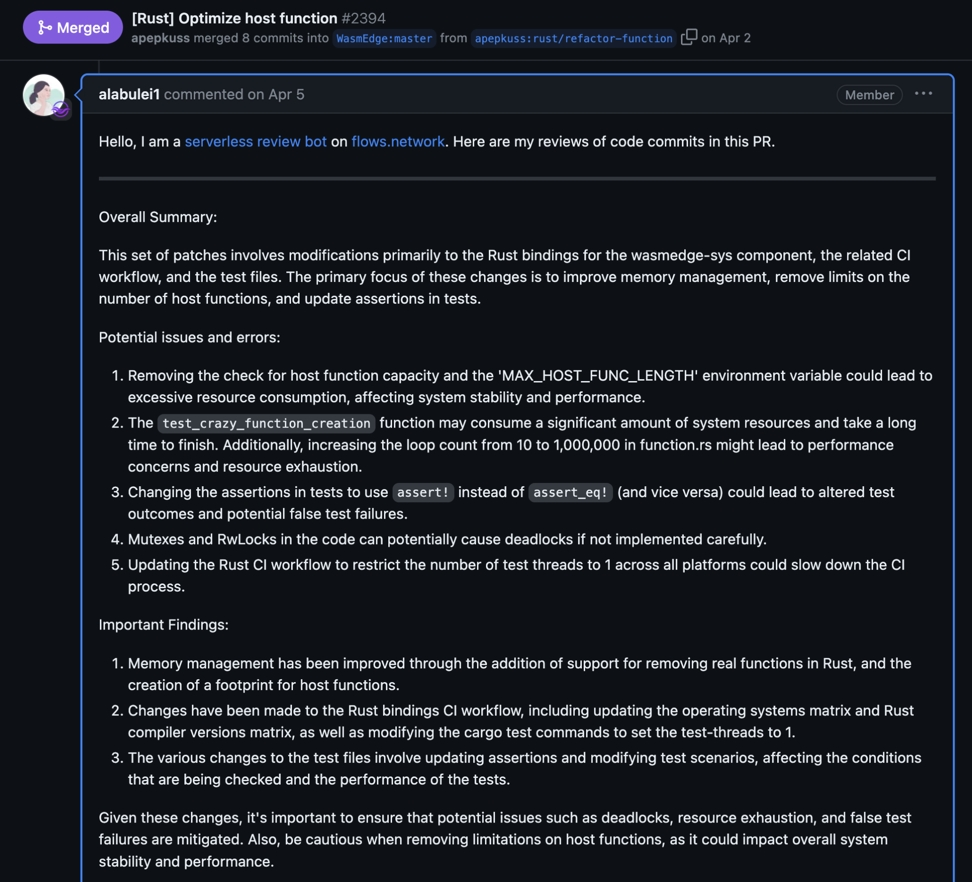

图 7 显示了 Code Review Bot 的 PR 检查摘要示例。它总结了目标 PR,列出了隐藏的风险和重大改变等。这些信息可以帮助检查者将注意力集中在关键部分,节省时间。

图 7 代码检查机器人 PR 审核总结示例

代码检查机器人可以在几分钟内完成部署。如果你想在自己的项目中使用它,可参考本指南。

在 AI 基础设施开发领域,虽然 Python 和 Docker 为我们提供了很好的服务,但探索和采用能够带来更好性能、安全性和效率的新技术也至关重要。Rust 和 WebAssembly 的结合反映了这种演变,为开发者和组织提供了一个有吸引力的替代方案。

参考资料

flows.network: 驱动 AI 工作负载的低代码 Serverless 平台。https://flows.network/

llama-utils: 请访问 https://github.com/second-state/llama-utils

Sam Liu, QCon 北京 2023 演讲嘉宾,Second State 工程师,CNCF WasmEdge 维护者 & Miley Fu,CNCF 大使,WasmEdge DevRel。

收官之战!2023 年最后一场会议——QCon 全球软件开发大会·上海站,将于 12 月 28-29 日在上海·中优城市万豪酒店举办。

此次大会策划了 GenAI 和通用大模型应用探索、AI Agent 与行业融合应用的前景、LLM 时代的性能优化、智能化信创软件 IDE、LLM 时代的大前端技术、高性能网关设计、面向人工智能时代的架构、构建本土编程语言生态的实践、性能工程:提升效率和创新的新方法、LLM 推理加速和大规模服务、现代数据架构演进、建设弹性组织的经验传递、SaaS 云服务弹性架构设计、大模型研究进展与产业应用展望等专题。

大会现已进入 8 折优惠报名最后 10 天,立减 ¥1360。咨询购票可联系票务经理 18514549229(微信同手机号)。更多大会相关资讯可扫码上方二维码了解,或点击「阅读原文」即可查看,12 月,我们上海见!