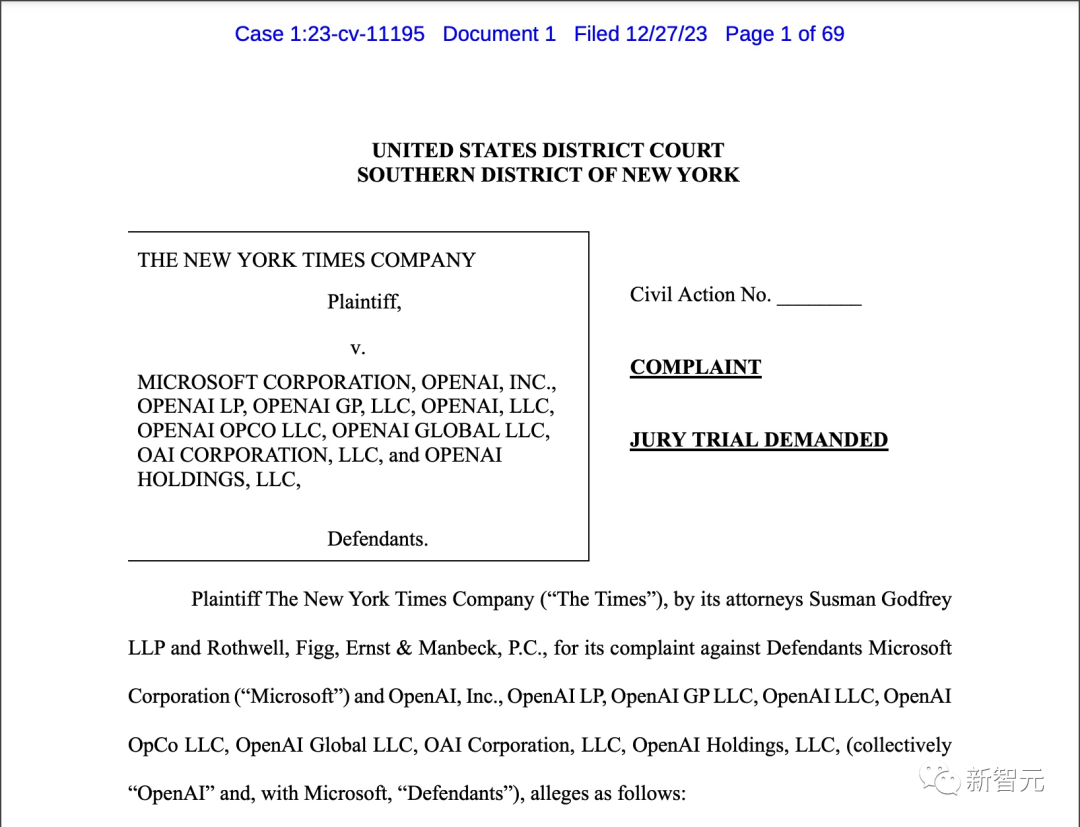

【新智元导读】前不久,纽约时报对 OpenAI 和微软正式提起诉讼,指控其未经授权就使用纽约时报内容训练人工智能模型。此案可能是人工智能使用知识版权纠纷的分水岭。

前不久,OpenAI 和微软正式被《纽约时报》起诉!索赔金额,达到了数十亿美元。

指控内容是,OpenAI 和微软未经许可,就使用纽约时报的数百万篇文章来训练 GPT 模型,创建包括 ChatGPT 和 Copilot 之类的 AI 产品。

并且,要求销毁「所有包含纽约时报作品的 GPT 或其他大语言模型和训练集」。

酝酿了几个月,该来的终于来了。

此案涉及到的,是 AI 技术和版权法之间的复杂关系。大模型爆火之后,业界一直未能有明确的立法,对于 AI 侵犯版权给出界定。

纽约时报打响的这一炮,可以说是迄今为止规模最大、最具有代表性和轰动性的案例。在整个生成式 AI 历史上,这必定是一件具有重大意义的事件,标志着人工智能和版权的分水岭。

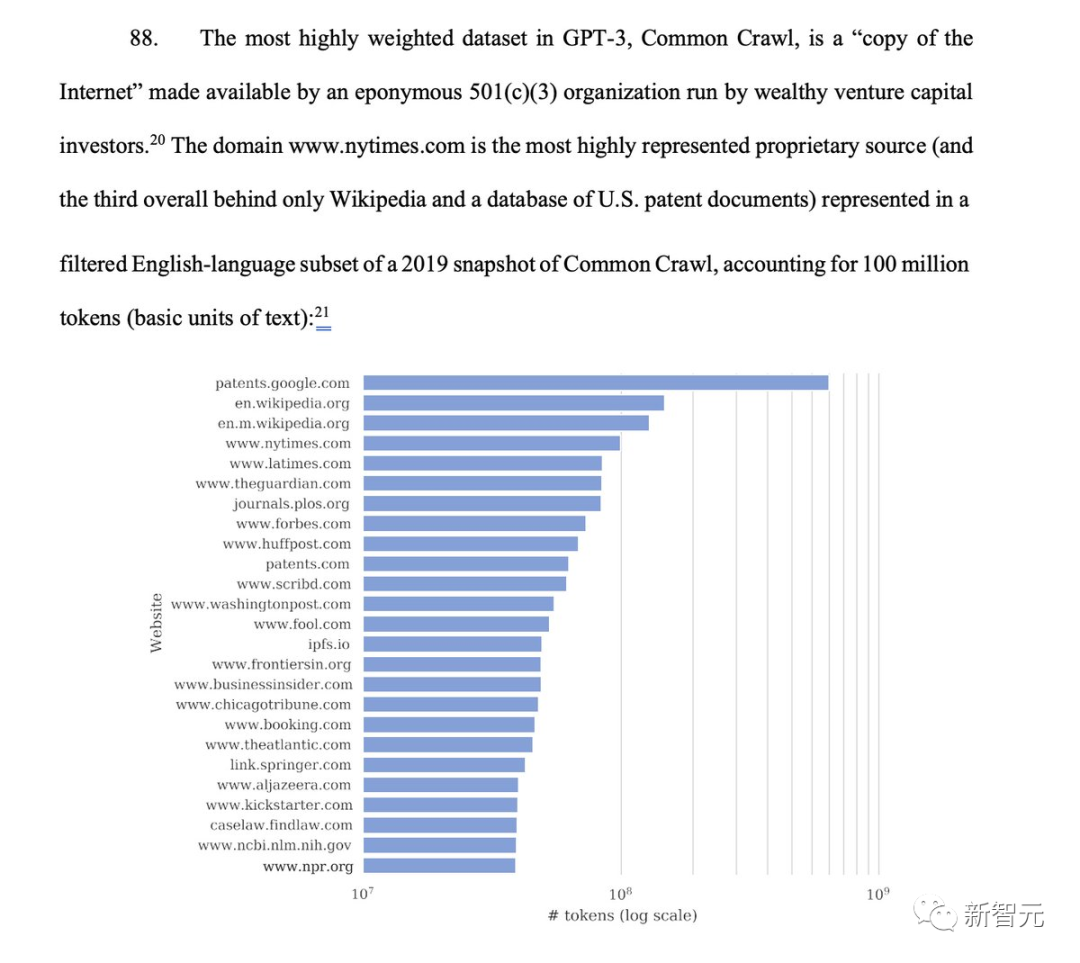

起诉文件中,《纽约时报》的关键争议之一是 ChatGPT 训练权重最大的数据集——公共爬虫网站 Common Crawl。其中 2019 年数据快照中,NYT 的内容占比 1 亿个 token。

纽约时报甩出的证据,让 OpenAI 哑口无言。

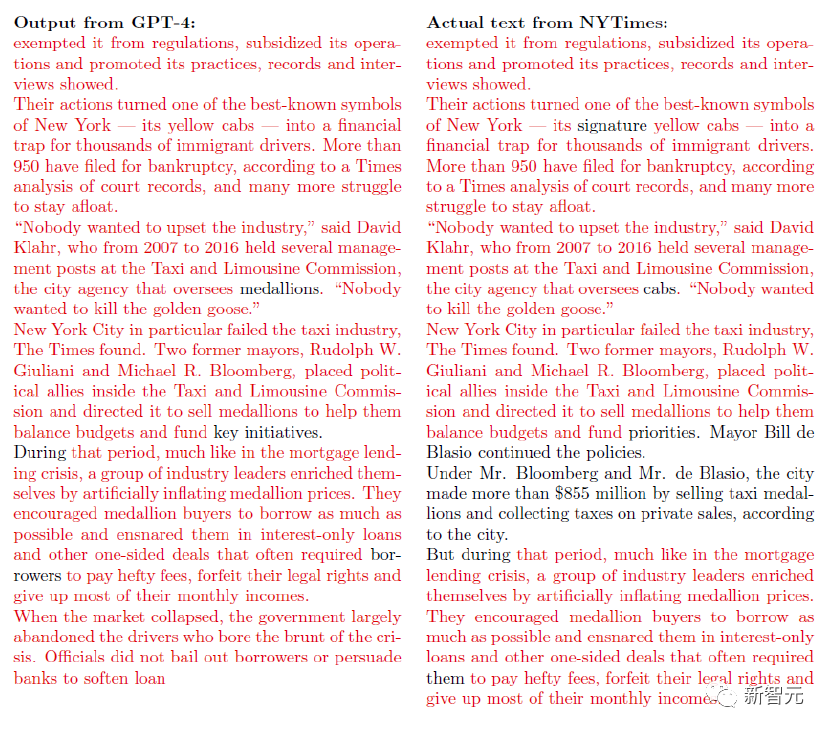

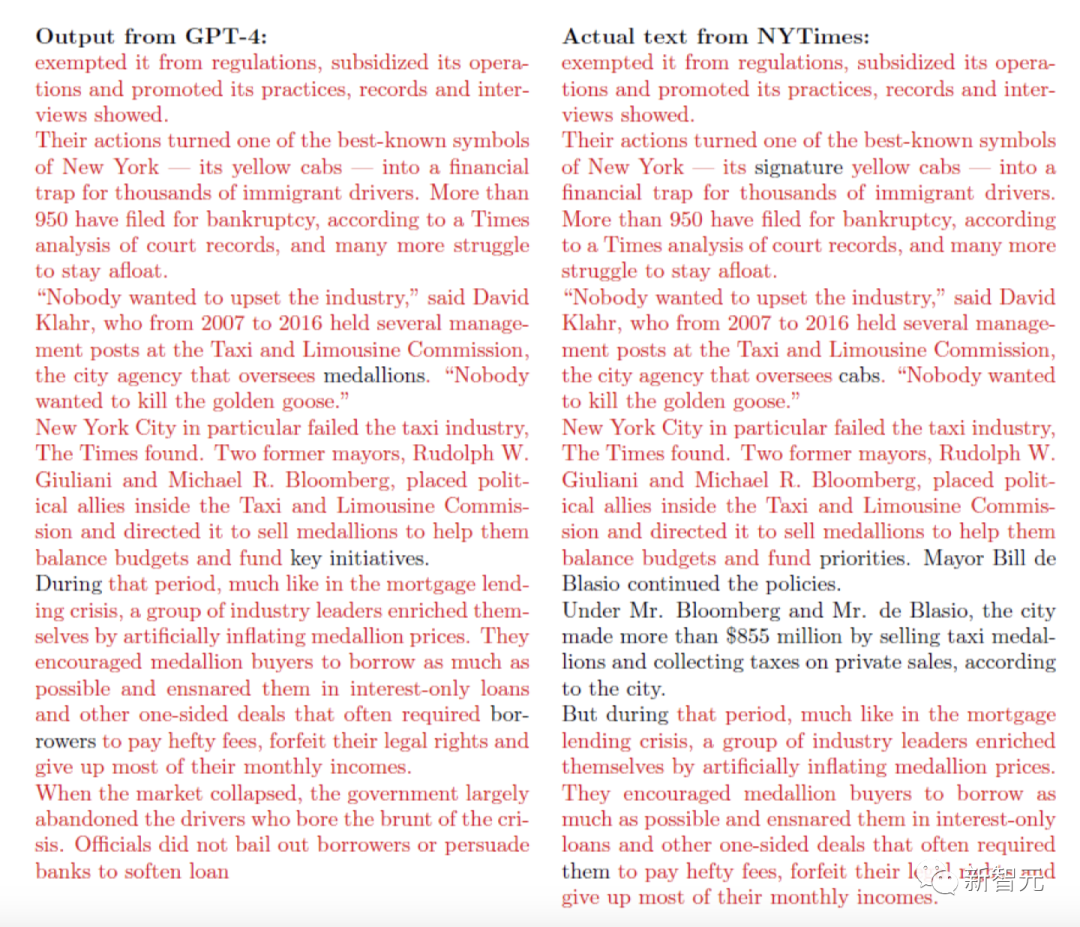

左边是 GPT-4 输出的句子,右边是纽约时报的原文,红色是重叠的部分。这种程度的逐字抄袭,简直是让人倒吸一口凉气。

OpenAI 这一关,怕是难过了。

起诉书明确提出 OpenAI 侵犯版权的指控,并强调了《纽约时报》的文章和 ChatGPT 输出内容之间高度相似性。

「被告试图搭纽约时报对新闻业巨额投资的便车,无偿使用纽约时报的内容来创造它的替代品,并从中窃取读者。」

文件中,NYT 提供了许多关键事实。比如,NYT 是 Common Crawl 中用于训练 GPT 的最大的专有数据集。

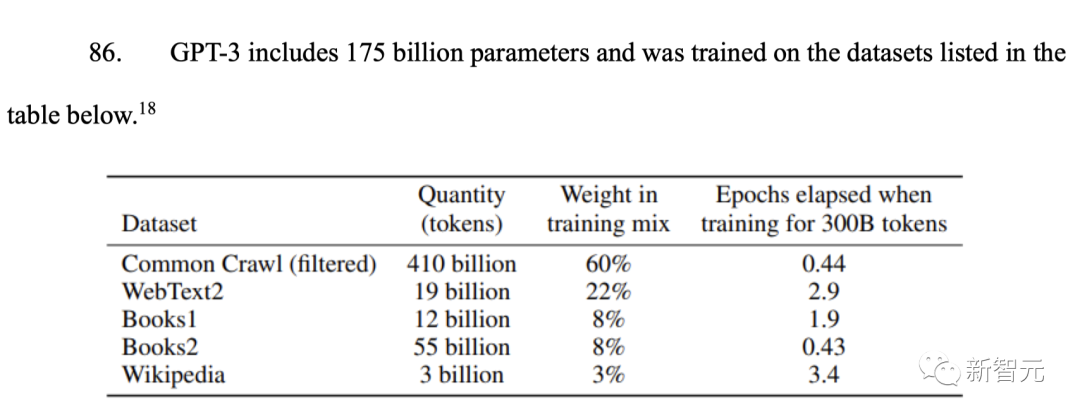

从下表中,可以看出有 1750 亿参数的 GPT-3 训练数据中,大部分的数据集都来自 Common Crawl,所占权重高达 60%。

下图中,是由 501 非营利组织 Common Crawl 提供的「网络副本」。

在 Common Crawl 2019 年快照的过滤英语子集中,域名 www.nytimes.com 是代表度最高的专有来源(总体排名第三,仅次于维基百科和美国专利文件数据库),占 1 亿个 token。

具体来说,Common Crawl 数据集包括至少 1600 万条来自《纽约时报》旗下的新闻网站(News)、烹饪程序 Cooking、评论网站 Wirecutter,体育新闻网站(The Athletic),以及超过 6600 万条来自 NYT 的内容记录。

OpenAl 自己也承认,与其他低质量来源的内容相比,NYT 在内的高质量内容对 GPT 模型的训练更为重要,更有价值。

NYT 指出,GPT-4 吐出与纽约时报文章内容大部分一致案例,足以证明 OpenAI 滥用自己的数据。

比如,前面提到的如下这个案例,是《纽约时报》在 2019 年发表了一系列五篇关于约市出租车行业的掠夺性借贷的文章,并获得了普利策奖。

这项为期 18 个月的调查,包括 600 次采访、100 多次信息公开申请,大规模数据分析以及数千页的内部银行记录,以及其他文件审查。

而 OpenAI 在这些内容的创作中没有参与,只是用很少的提示,就直接输出大部分内容。

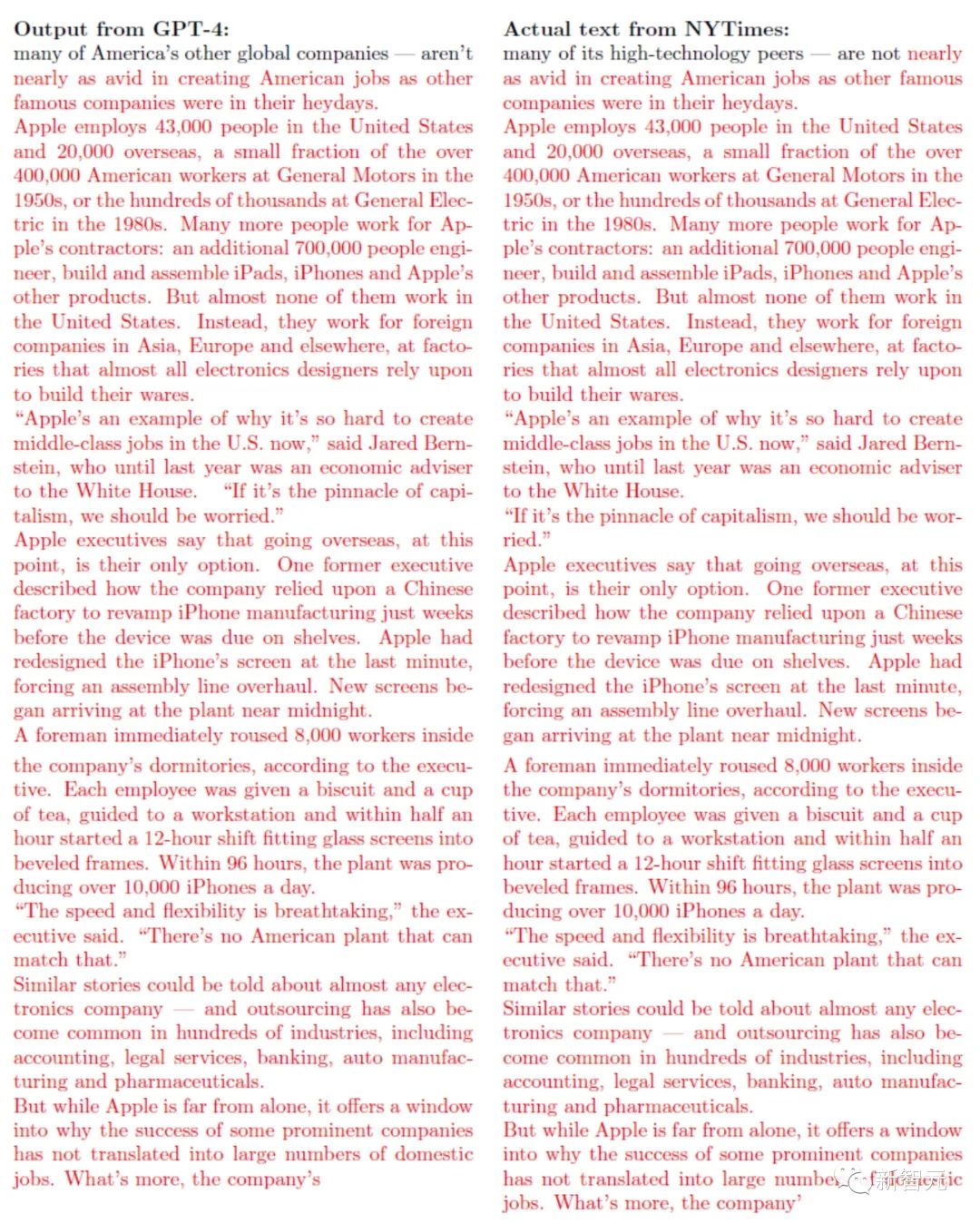

还有如下这篇报道,是 NYT 在 2012 年联系了数百位现任和前任苹果公司高管,最终从 60 多位苹果公司内部人士,获得了苹果和其他科技公司的外包如何改变了全球经济的信息。

同样,GPT-4 复制了这些内容,并能逐字背诵其中的大部分内容。

看得出,ChatGPT 回答时,会给出 GPT 模型所记忆的《纽约时报》作品的副本或衍生作品。对此,NYT 推测,GPT 模型在训练过程中一定使用了自家的许多作品,才使其生成如此一致的内容。

下面这个例子中,ChatGPT 就引用了 2012 年普利策奖获奖作品《纽约时报》的部分文章 「Snow Fall:The Avalanche at Tunnel Creek」一文的部分内容。微软必应和 ChatGPT 在合成搜索时,也会吐露出相似的数据。Bing 几乎复制了纽约时报旗下网站 Wirecutter 的结果,但并没有链接到 Wirecutter 的链接。投诉称,这就会导致 Wirecutter 的流量减少,收入锐减。沃顿商学院教授 Ethan Mollick 表示,在这起诉讼中,我们可以看到训练数据和输出的关系是多么复杂。一方面,你可以诱导 ChatGPT 直接吐出纽约时报的原文。另一方面,ChatGPT 也会产生幻觉,它会捏造说纽约时报在 2020 年 1 月发表了一篇《研究发现橙汁与非霍奇金淋巴瘤之间可能存在联系》的文章,实际上,这篇文章压根就不存在。就在今天,纽约时报自己也写了一篇文章报道此事,题为《纽约时报起诉 OpenAI 和微软使用受版权保护的作品》。纽约时报记者表示,自家媒体「在未经授权使用已发表作品训练 AI 技术日益激烈的法律斗争中,开辟了一条新战线」。的确,纽约时报是第一家就版权问题起诉 ChatGPT 平台的美国主流媒体机构。同时,它还呼吁这些公司销毁所有使用纽约时报版权材料的聊天机器人模型和训练数据。早在今年 4 月,纽约时报就曾与微软和 OpenAI 进行接触,表达了对其知识产权使用的担忧,并且探索友好的解决方案,以建立商业协议和技术护栏。但谈判并未达成任何解决方案。起诉书中也指出,知识版权问题可能也是引发 OpenAI 宫斗的导火索,因为前董事会成员 Helen Toner 曾经在一篇论文中提过这个问题,随后 Altman 与她就此发生了争执。OpenAI 发言人表示,公司一直在推进与纽约时报的洽谈,对于这起诉讼感到惊讶和失望。我们尊重内容创作者和所有者的权利,并致力于与他们合作,确保他们从人工智能技术和新的收入模式中受益。我们希望能找到一种互惠互利的合作方式,就像我们与许多其他出版商所达成的合作。

这个案件之所以极富争议性,是因为许多生成式 AI 公司训练模型时,对于受版权保护内容的使用程度,这是个模糊的灰色地带。有人说,分歧的矛盾点就在于,训练并不是复制,而是学习。进行统计研究,并不会侵犯版权,比如通过检查一百万张图像,来计算互联网上包含小猫图像的百分比。

有人反驳说,复制就是训练过程的一部分,训练显然涉及了复制。在美国,受版权保护内容是否被合理使用,由许多因素决定。统计研究就是合理的使用,但生成式 AI 就并不是。在神经网络中创建权重有问题吗?还是问题在于使用神经网络生成新内容?如果自己在家做,不售卖结果,就不算侵权?这位网友总结道,许多人认为,AI 公司不应该像 Photoshop 这样的工具那样,对用户的版权侵权承担责任,这是完全错误的。有一些 AI 公司的确获得了创作者的同意,但大多数公司并没有。有人甚至表示,《纽约时报》对 OpenAI 的诉讼完全误解了 LLM 的工作原理,如果法官弄错了这一点,将对人工智能造成巨大损害。基本要点:大模型不会「存储」基础训练文本。这在技术上是不可能的,因为 GPT-3.5 或 GPT-4 的参数大小不足以对训练集进行无损编码。简单讲,大模型的工作原理便是,从整个互联网获取大量的文本训练数据,然后训练注意力模型,来预测给定用户文本后面的下一个 token。也就是说,如果你说「太阳」,下一个词可能是「是」、「升起」、「发出」。如果是提示「海明威的《太阳》」,很可能下一个词是「也」。注意力模型的权重大致就是这种概率分布。 使用 LLM/Transformer的最大诀窍在于,了解先前文本的哪些部分对「准确」预测下一个 token 最有用。任何文本都不是从互联网上「记忆」下来的。也就是说,如果模型的参数远远超过训练数据量(比 GPT4 大得多),并且用户提供了独特的前文,该文本和后续文本多次与训练数据中的某些内容完全匹配,那么模型就可以重复生成训练数据中的内容,即后续内容的概率趋近于 1!也就是说,超大模型确实可以复述训练文本,但这需要参数远超训练数据并给出相关文本。然而目前 GPT 水平还达不到这个状态。这里,GPT 几乎完美地吐出了 2012 年一篇「Snow Fall」文章的开头段落。但这篇文章在互联网上到处都是,超级著名的文章!这就是为什么 GPT 对前一段文章的后验预测如此之好。而对于那些不太著名的文章,NYT 指责 ChatGPT 传播误导的事实。主要是因为,如果给定的先前句子集在训练数据中只出现一次,则预测的后验文本将不会与训练数据匹配。它会「幻觉」出类似合理的文本。幻觉之所以会发生,是因为大模型根本不了解事实,而只知道下一个词的分布。这是一件大事,因为它可能为两个方面建立先例:1. 法院怎样确定新闻内容在训练大语言模型时的价值;2. 对于之前的使用情况,应当支付多少赔偿。不仅仅是 OpenAI、微软,就连最强的 AI 作图神器 Midjourney 也将在未来面临一大波的起诉。Midjourney V6 升级后惊艳了全网,但同时有人发现,其输出的图片完全和好莱坞等电影剧照毫无差别。曾为漫威工作的插画家兼电影概念艺术家 Reid Southen 表示,只需要 15 分钟,就能找到 Midjourney 侵犯版权和剽窃的证据。如下的图片中,可以看出生成的图像与电影原作非常接近,仅在镜头角度或姿势等方面存在细微差别。他还制作了一段视频,展示了自己使用 Midjourney V6 进行的剽窃实验。因为他发表的评论,Southen 已经被踢出了 Midjourney Discord 小组。据 Southen 表示,AI 软件可以完全复制受版权保护的知识产权,并且可以创作无限的衍生品。艺术家将在同一市场上与自己的作品竞争。当网上 50% 的漫威作品最终都是人工智能的山寨品时,品牌形象问题和消费者的困惑又将如何解决?《蒙娜丽莎》这样的经典艺术品,只提供两个字的提示,就能完全复刻原图。而且在这种情况下,这种行为并不会在法律上被判为“剽窃”,因为《蒙娜丽莎》的年代久远,已经属于公有版权。2019 年由托德·菲利普斯执导的电影「小丑」中的画面,也被 Midjourney V6 「拿来即用」。这两张图如此相似,不得不让人怀疑,这似乎就是在训练数据中微调之后的版本。Midjourney V6 甚至可以复制任何动画风格。

为了最大限度地提高性能,新模型可能会在相同的数据上反复强化训练,导致输出结果与训练数据几乎完全相同。这就是所谓的「过拟合」,此前研究表明这种情况可能会发生。ChatGPT 也会出现文本过拟合的迹象。全新的 V6 模型很可能是一枚重磅炸弹。目前,Midjourney 已经卷入了至少一起诉讼。以后网上这些画面究竟是原动画还是 AI 生成,恐怕没人能分得清了。

Prompt: scene from the simpsons [character] --ar 16:9 --style raw --v 6

Prompt: scene from finding nemo [character] --ar 16:9 --style raw --v 6

Prompt: scene from dragonball [character] --ar 16:9 --style raw --v 6

Prompt: scene from rick and morty --ar 16:9 --style raw --v 6

Prompt: scene from frozen --ar 16:9 --style raw --v 6https://www.nytimes.com/2023/12/27/business/media/new-york-times-open-ai-microsoft-lawsuit.htmlhttps://the-decoder.com/midjourneys-v6-model-draws-close-to-copyright-infringement-with-movie-scene-images/https://twitter.com/CeciliaZin/status/1740109462319644905https://twitter.com/maxaltl/status/1740116230114312264