Elasticsearch 内置的分词器对中文不友好,会把中文分成单个字来进行全文检索,不能达到想要的结果,在全文检索及新词发展如此快的互联网时代,IK可以进行友好的分词及自定义分词。

IK Analyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。从2006年12月推出1.0版,目前支持最新版本的ES6.X版本。

ik 带有两个分词器

ik_max_word :会将文本做最细粒度的拆分;尽可能多的拆分出词语

ik_smart:会做最粗粒度的拆分;已被分出的词语将不会再次被其它词语占有

1. 安装插件

如果是集群模式,则每个节点都需要安装ik分词,安装插件完毕后需要重启服务,创建mapping前如果有机器未安装分词,则可能该索引可能为RED,需要删除后重建。

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.0.0/elasticsearch-analysis-ik-6.0.0.zip

2. 创建索引

可以使用CURL命令,6.0版本+也可以在Kibana插件x-pack的DevTools中进行调试API

curl -XPUT http://localhost:9200/index

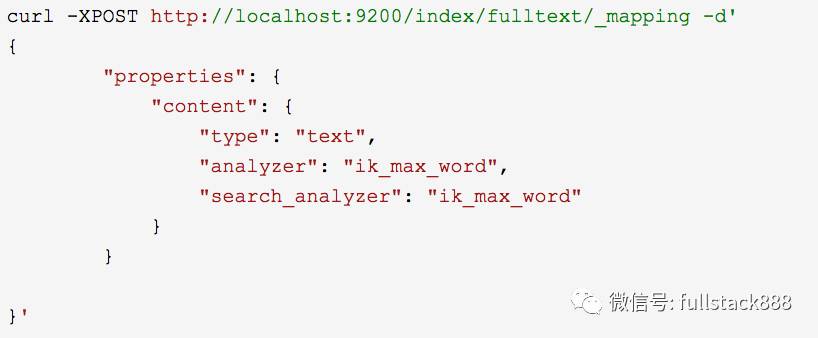

3. 创建mappiing

4. 创建文档

curl -XPOST http://localhost:9200/index/fulltext/1 -d' {"content":"美国留给伊拉克的是个烂摊子吗"} ' curl -XPOST http://localhost:9200/index/fulltext/2 -d'

{"content":"公安部:各地校车将享最高路权"} ' curl -XPOST http://localhost:9200/index/fulltext/3 -d' {"content":"中韩渔警冲突调查:韩警平均每天扣1艘中国渔船"} ' curl -XPOST http://localhost:9200/index/fulltext/4 -d' {"content":"中国驻洛杉矶领事馆遭亚裔男子枪击 嫌犯已自首"} '

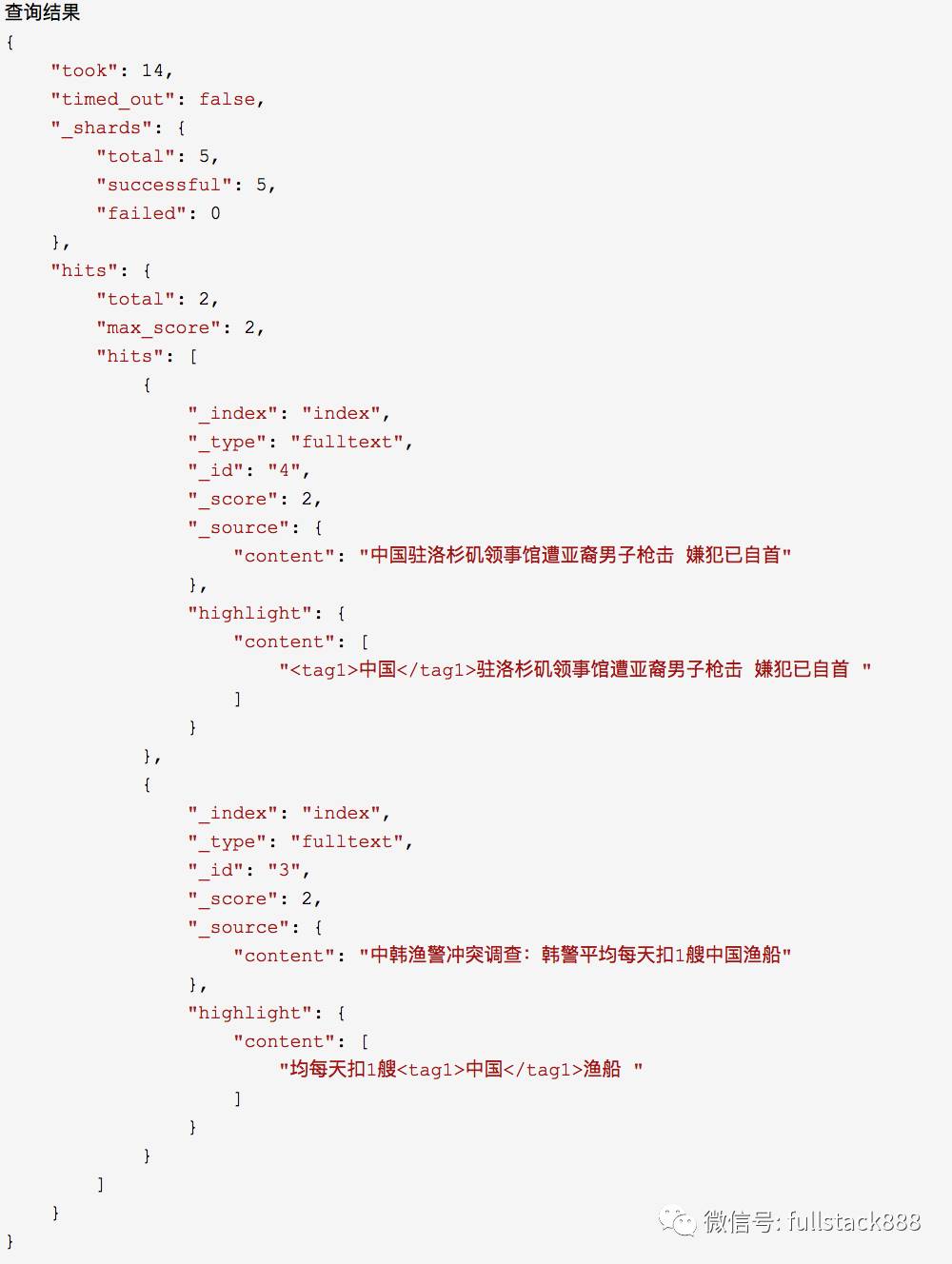

5. 查询文档

IK支持自定义配置词库,配置文件在config文件夹下的analysis-ik/IKAnalyzer.cfg.xml,字典文件也在同级目录下,可以支持多个选项的配置,ext_dict-自定义词库,ext_stopwords-屏蔽词库。

同时还支持热更新配置,配置remote_ext_dict为http地址,输入一行一个词语,注意文档格式要为UTF8无BOM格式,如果词库发生更新,只需要更新response header中任意一个字段Last-Modified或ETag即可。

version="1.0" encoding="UTF-8"?>/span>properties SYSTEM "http://java.sun.com/dtd/properties.dtd"><properties>

<comment>IK Analyzer 扩展配置comment>

<entry key="ext_dict">custom/mydict.dic;custom/single_word_low_freq.dicentry>

<entry key="ext_stopwords">custom/ext_stopword.dicentry>

<entry key="remote_ext_dict">locationentry>

<entry key="remote_ext_stopwords">

http://xxx.com/xxx.dicentry>properties>

github地址:

https://github.com/medcl/elasticsearch-analysis-ik

拼音分词

https://github.com/medcl/elasticsearch-analysis-pinyin