作为2020年人工智能学界的第一个顶会,AAAI 2020正在美国纽约举行,最佳论文等各大奖项已经揭晓,详见:AAAI 2020最佳论文公布,800人缺席!Bengio支持的远程参会请愿书火了。

AAAI 2020的一大亮点是主办方特邀图灵奖获得者、深度学习三巨头Geoffrey Hinton、Yann LeCun、Yoshua Bengio同台,分享各自最新研究成果。三位一致表示深度学习可以克服诸如对抗性示例之类的障碍,甚至可能获得常识。

新智元整理了“三巨头”的演讲和讨论,下面和大家分享。

Geoffrey Hinton:堆栈式胶囊自编码器

首先,Geoffrey Hinton登台,做了题为“Stacked Capsule Autoencoders”的演讲,这也是他去年一篇论文的题目。

论文地址:https://arxiv.org/abs/1906.06818

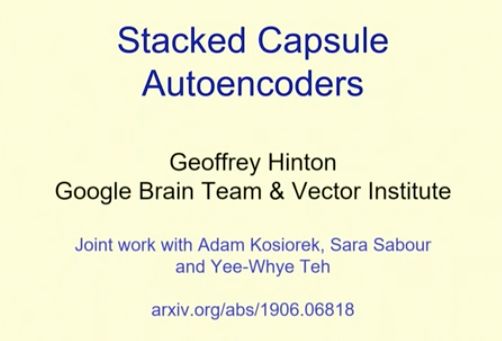

Hinton首先介绍了识别物体的两种方法的优劣势:

- 传统模型使用模块化表示形式(例如计算机图形学中使用的表示形式),但是它们通常涉及很多手动操作,这让深层次结构很难实现。

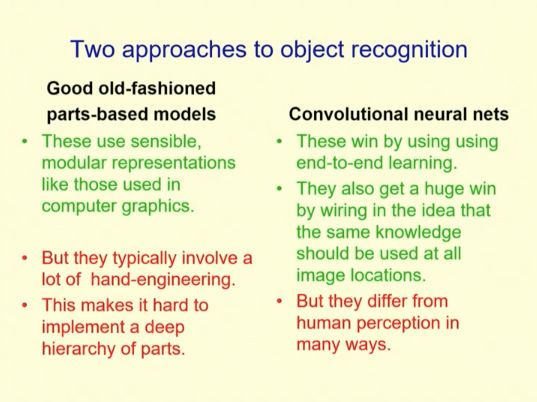

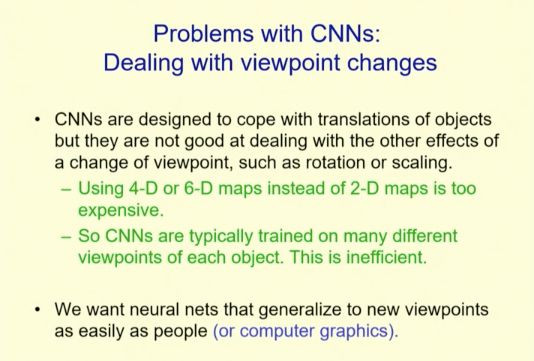

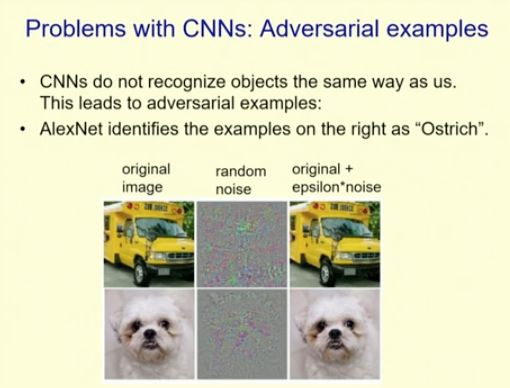

- 卷积神经网络使用端到端学习,通过在所有图像位置使用相同的知识,它们获得了巨大的胜利。但是它们在很多方面与人类的感知不同。

用Hinton的话讲,CNN就是"rubbish",问题很多,比如处理视角的变化、解析图像、对抗性例子等等。

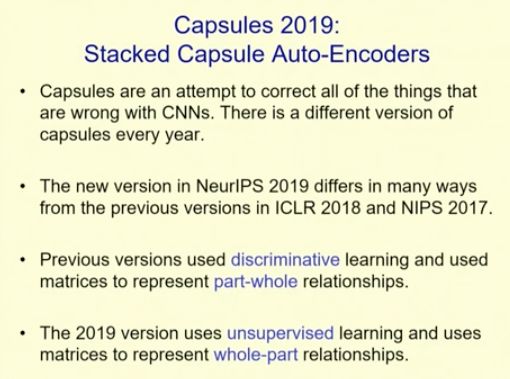

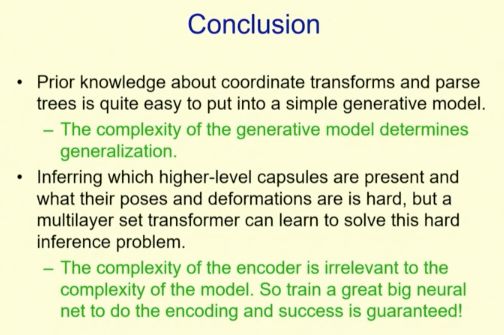

吐槽完CNN,Hinton开始介绍重头戏:Capsules 2019: Stacked Capsule Auto-Encoders。

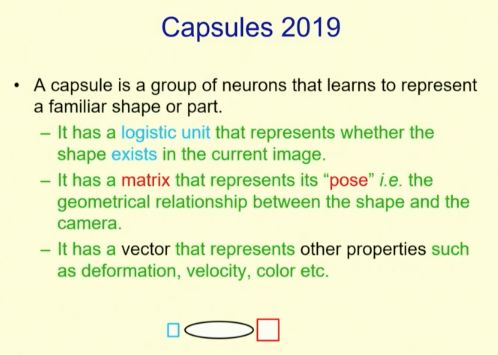

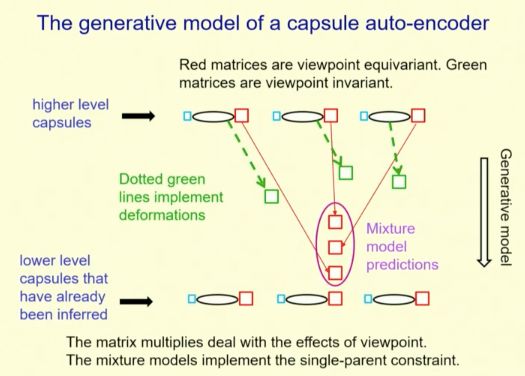

在这项研究中,Hinton等人提出一个无监督版本的胶囊网络,通过可查看所有部件的神经编码器,进而推断物体胶囊的位置与姿势。

该编码器通过解码器进行反向传播训练,通过混合式姿势预测方案来预测已发现部件的姿势。同样是使用神经编码器,通过推断部件及其仿射变换,可以直接从图像中发现具体的部件。

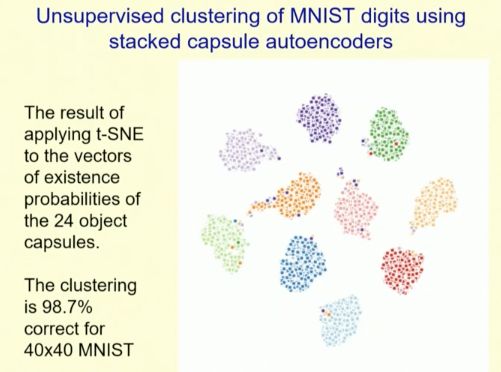

换句话说,每个相应的解码器图像像素建模,都是仿射变换部分做出的混合预测结果。他们通过未标记的数据习得物体及其部分胶囊,然后再对物体胶囊的存在向量进行聚类。

最后,该成果在 SVHN 上获得了最先进的无监督分类结果 (55%),同时在 MNIST 上获得了接近最先进的分类结果。

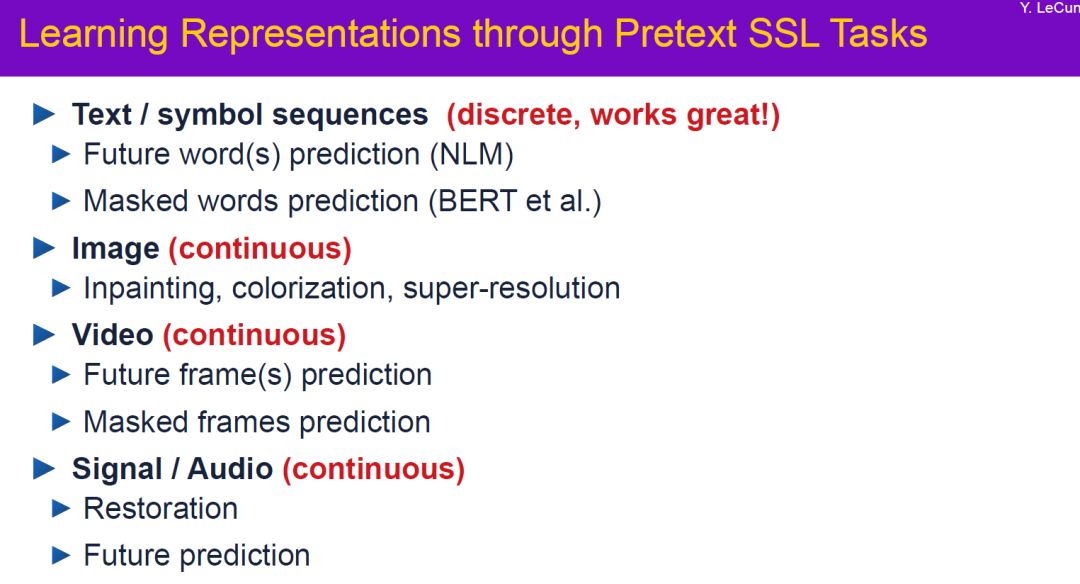

Yann LeCun:自监督学习赋予机器 “常识” ,实现“真正的”人工智能

接着,Facebook人工智能总监、图灵奖得主Yann LeCun上台,继续推广他的自监督学习概念。

这位被誉为卷积神经之父的图灵奖得主,对自监督学习给予了深厚的希望以及非常坚实的肯定。

他认为自监督学习因为更接近人类的学习程序,能够突破现有深度学习的局限。

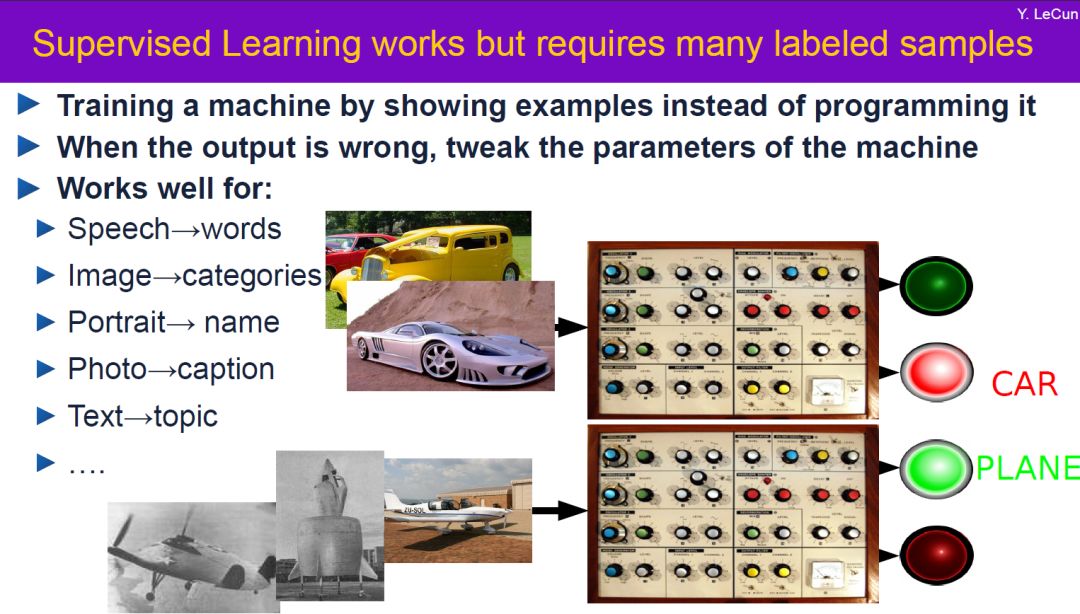

目前被广泛使用的监督学习,对人工标记的依赖性交大,不仅耗时耗力,且无法完全保证人工标记过程中准确性的问题。另外,机器只能根据已标记的特征学习。

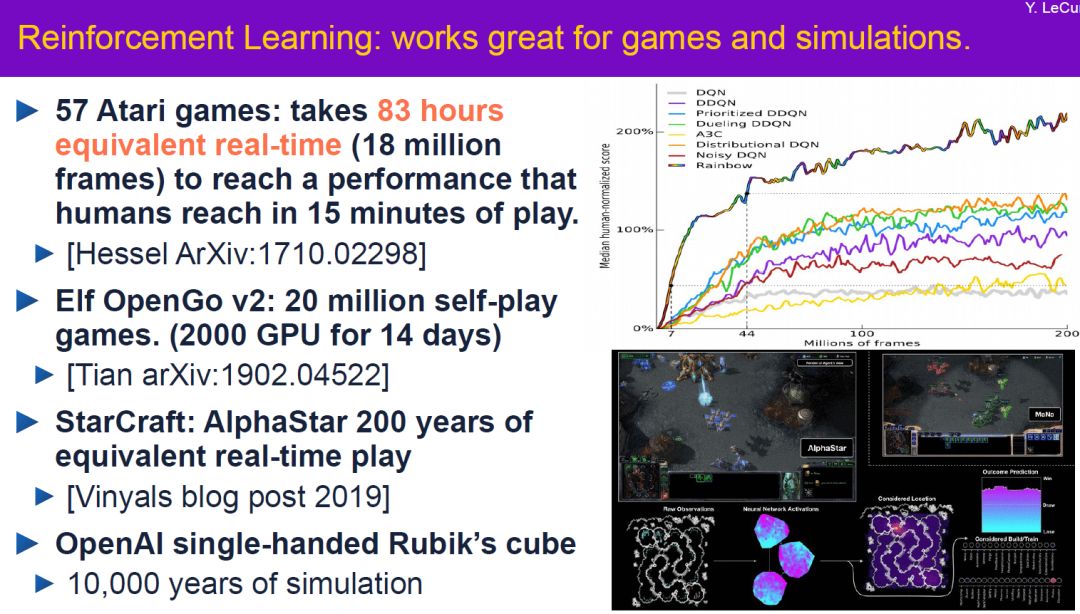

强化学习是透过奖罚机制,让机器在虚拟情境中不断试错(trial and error),累积经验来学习。强化学习已经被证明在竞技游戏中体现出强大的能力,甚至远超人类,但性价比太低。

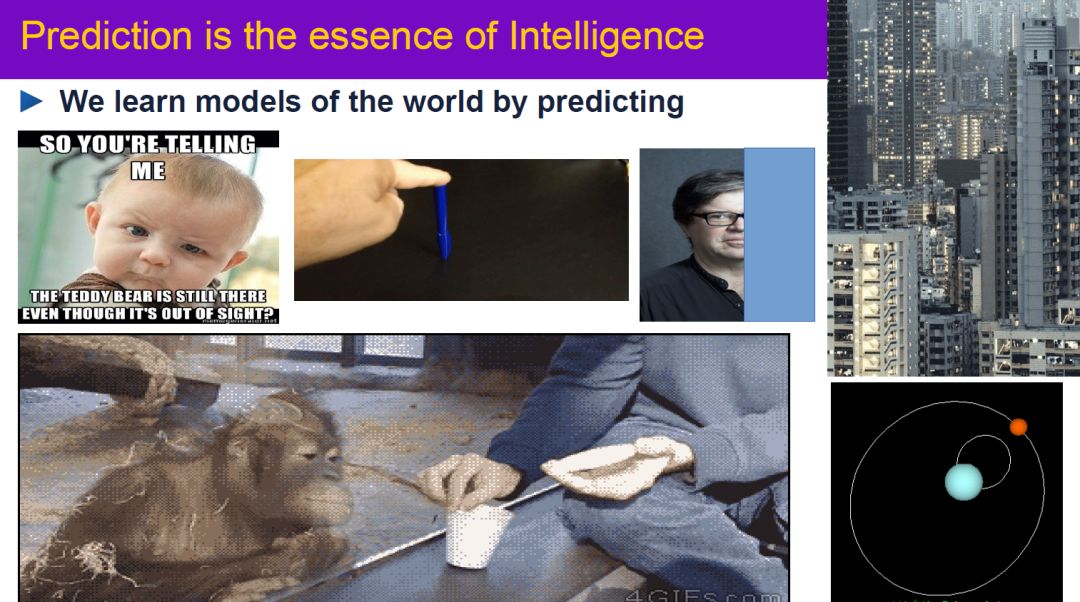

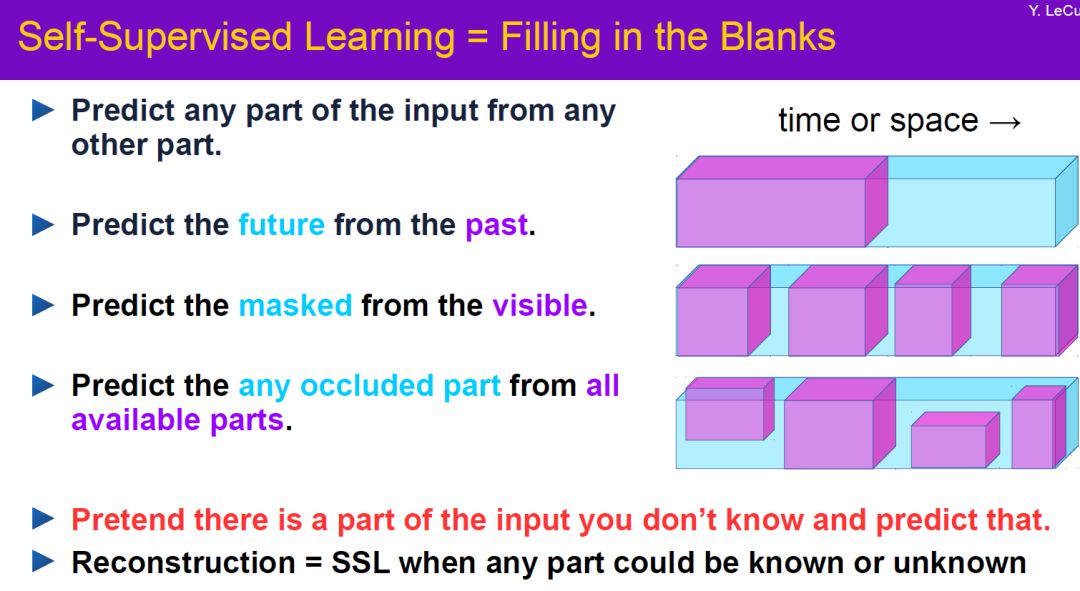

Yann LeCun认为自监督学习是克服上述问题的有效解决方案。自监督学习通过构建一个庞大的神经网络,透过预测来认识世界。这一点就非常类似于我们人类的学习过程,不断透过已知部分预测未知。

预测是自监督学习的强力武器,例如预测到车子可能会撞到前方路障,就提前进行规避动作,而不需要人工标注这是路障需要避开,更不需要试错去积累经验。

Yann LeCun认为现今的深度学习方法,虽然在自动驾驶、语言翻译、聊天机器人等方面取得进展,却无法创造出“真正的”人工智能。

他所谓的“真正的”人工智能,是具备常识、聪明、敏捷且灵活的机器人。他认为更接近人类学习行为的自监督学习方法,将会是实现这个宏远的第一步。

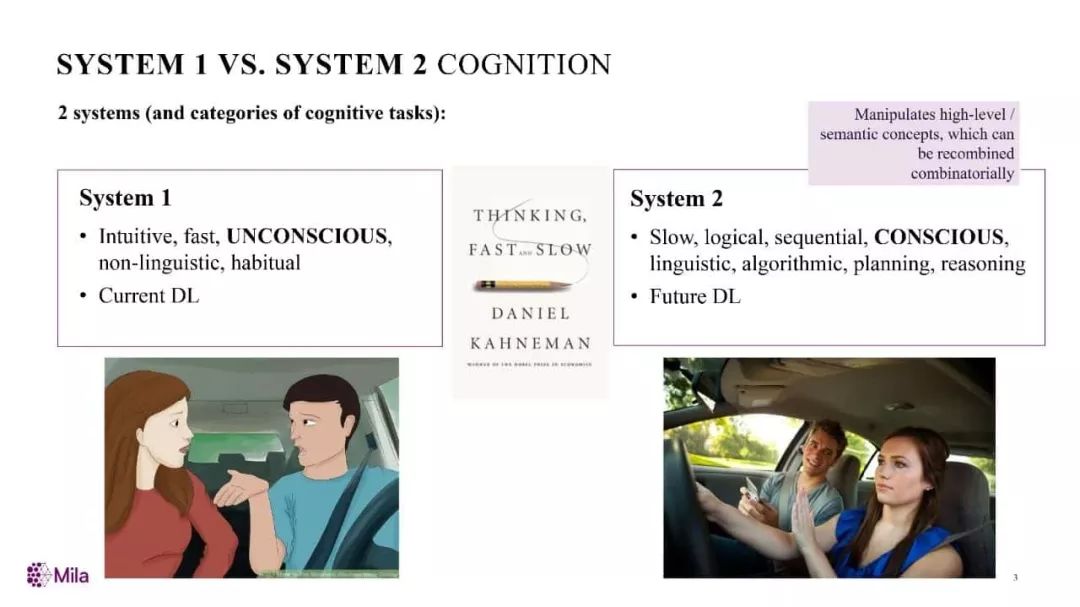

Yoshua Bengio:从“系统1”向“系统2”进发

最后,深度学习三巨头之一、图灵奖得主Yoshua Bengio在会上做了题为“深度学习在系统2处理中的应用”(Deep Mind in System 2 Processing)的演讲。Bengio认为,深度学习的瓶颈已经出现,并指明了突破方向。

Bengio首先介绍了深度学习的发展困境。他引用了Daniel Kahneman的认知系统理论。

Kahneman认为,人的认知系统主要分为“系统1”和“系统2”两个部分。“系统1”所主导的思维是直觉性的、下意识的和非语言的,它使得人类能在熟悉的情况下做出不假思索的快速反应;而“系统2”则是有意识的思维,注重逻辑、规划、推理和因果关系,它使得人类能在全新的情况下做出判断和决策。

Bengio说,目前的深度学习类似于“系统1”的思维模式,想要提升至人类水平的智能,则需要开发出类似“系统2”的认知系统,他认为这必将是未来的发展方向,也是目前深度学习发展所遇到的瓶颈。

Bengio指出,为突破该瓶颈,或许可以向自然智能身上获取灵感,模拟人类婴儿的学习模式。

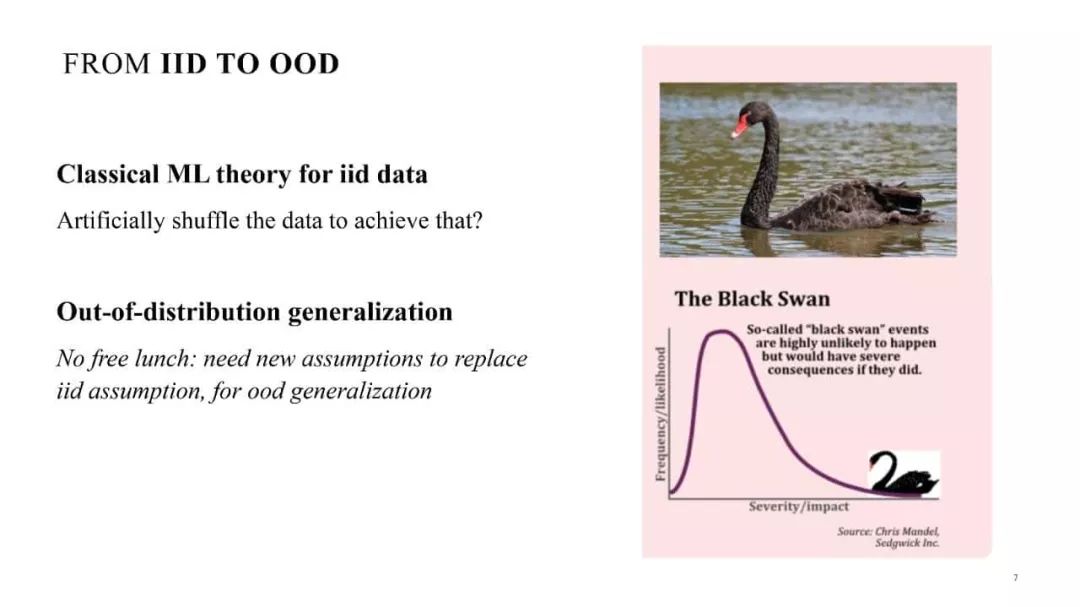

目前深度学习都是基于独立同分布的假设,但实际现状是,我们感兴趣的往往是出现次数非常少的数据。因此,Bengio认为,分布外泛化(out-of-distribution generalization)是目前深度学习所欠缺的,而且是向“系统2”推进的关键。

同时,他还提出,提升深度学习需要从“个体”(agent)的角度考虑。个体之间的互动也将影响深度学习的发展,因此需要采取包括建设更好的模型等措施。

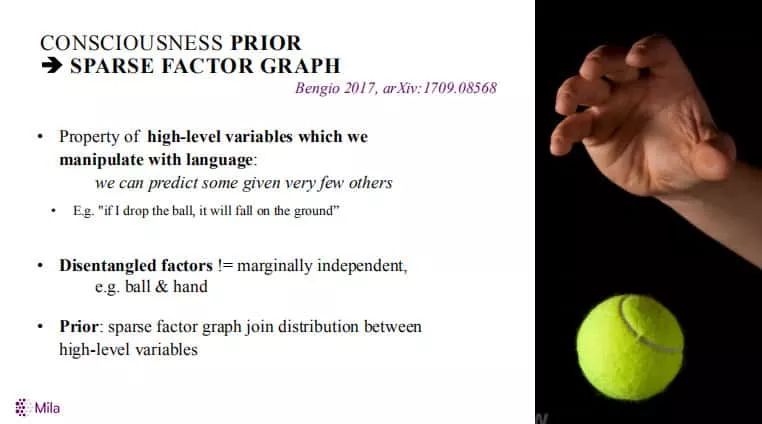

Bengio还提到,“系统2”的两大关键是注意力和意识。注意力是近年深度学习发展的一个重要技术,目前已有大量的实现和探讨。而人类意识往往是先验的。他提出,这可以通过稀疏因子图(sparse factor graph)实现。稀疏因子图可用于学习变量间的因果关系,从而构造变量间的因果关系。

演讲结束后,Hinton、LeCun、Bengio“三巨头”进行了对话讨论。

深度学习三巨头的再次聚首是深度学习的一次胜利的转折,该学科曾经被抛弃,甚至也被AAAI淘汰。这也有点自相矛盾,因为这三场演讲似乎都借用了通常被认为属于AI的对立面(即“符号性” AI理论家)的术语,他们是几年前抛弃了Bengio,Hinton和LeCun的人。

“然而,你们中的一些人对符号性的人工智能世界有点轻蔑,”主持人、麻省理工学院教授Leslie Kaebling注意到了术语的借用。 “我们能成为朋友吗?还是不能?”她问道,引得观众哄堂大笑。

Hinton站在会议桌旁,没有坐下,干脆地打趣道:“好吧,我们有着悠久的历史,比如,”引起了更多的笑声。

“上一次我向AAAI提交论文时,得到了我有史以来最差的评价,而且很刻薄!” Hinton说。

“上面说,Hinton已经研究这个想法7年了,没人感兴趣,是时候继续前进了,”Hinton回忆说,LeCun和Bengio笑了,他们也默默无闻地工作了几十年,直到2012年的深度学习取得突破。“忘记这个需要一段时间,”Hinton说,虽然也许忘记过去并继续前进会更好,他也承认。

Kaebling的问题击中了要害。三位科学家的演讲都暗示了他们的成果曾受到怀疑论者的攻击。

LeCun表示,他在“社交媒体上还算活跃,并注意到很多人对于深度学习是什么并不清楚”。LeCun影射的正是之前与他在推特上来回争论的深度学习评论家Gary Marcus等人,他们的争论有时甚至有些剑拔弩张。LeCun在演讲的最开始用一张幻灯片定义了深度学习,回应的正是12月Marcus和Bengio之间的一场争论。

但当晚的大多数情况下,三人之间还是显现出惺惺相惜之意。当有听众提问,对于彼此的观点有什么无法认同的地方时,Bengio打趣道:“这招Leslie已经在我们身上使过了,没有用。”Hinton则表示:“我可以告诉你有啥我不认同他们的。Bengio的邮件地址以‘魁北克’结尾。而我认为,在‘魁北克’之后还应该加上国家代码,但他没加。”

他们还趁机损了对方几句。Hinton在他演讲的一开始就说明,他就是针对LeCun的。LeCun在30年前实现了卷积神经网路,并使其成为实用技术。Hinton表示,他要证明为何卷积神经网络完全是“垃圾”,应该以自己的胶囊网络代替。Hinton还自嘲称,过去三年中,他每年都会推出一个新版本的胶囊网络。他笑着说道:“忘记你们所熟悉的老版本胶囊网络吧,它们都是错的,这个版本才是对的。”

作为一门学科,其中的有些困难将越来越难以解决。当Kebling问及,是否有人对于大公司使用AI的目的和打算表示担忧时。Hinton笑着指指LeCun,LeCun也笑着回指了Hinton。LeCun主管Facebook的AI研究部门,而Hinton则是谷歌AI团队成员。Hinton说:“呃,我觉得他们应该管管假新闻的事,但……”他说着,声音小了下去。与此同时,LeCun回应道:“实际上,我们正在处理这事。”这次交锋引发了现场最大的掌声和笑声。

对于该领域的整体架构和如何改进,三位科学家提出了一些想法。Bengio指出,如今年轻学者们发表论文的压力比他读博士学位时大多了。他认为必须从结构上做出改变,让学者们能够更加关注长期的问题。LeCun同时也是纽约大学的教授。他表示作为一名教授,“我都不会录取我这样的学生。”

Hinton多年来默默无闻地努力。他用慢吞吞温柔的英国腔,设法以轻松的方式阐释了这种短视的研究所带来的问题。

他说:“对于这个过程我提出这样一个模型。人们就某个想法研究了很短的时间,取得了一点点进展就发表了论文。“

“这就好比有人拿了一本很难的数独书,浏览了一遍,将每个数独题里简单的几个空填了。这给别人带来了大麻烦。”

参考链接:

https://www.zdnet.com/article/deep-learning-godfathers-bengio-hinton-and-lecun-say-the-field-can-fix-its-flaws/

想要了解更多资讯,请扫描下方二维码,关注机器学习研究会

转自:新智元