关注“FightingCV”公众号

回复“AI”即可获得超100G人工智能的教程

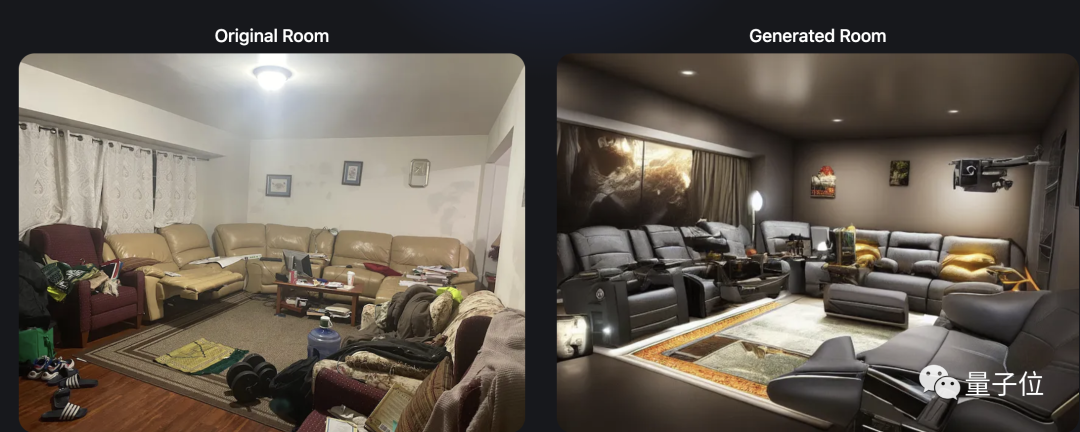

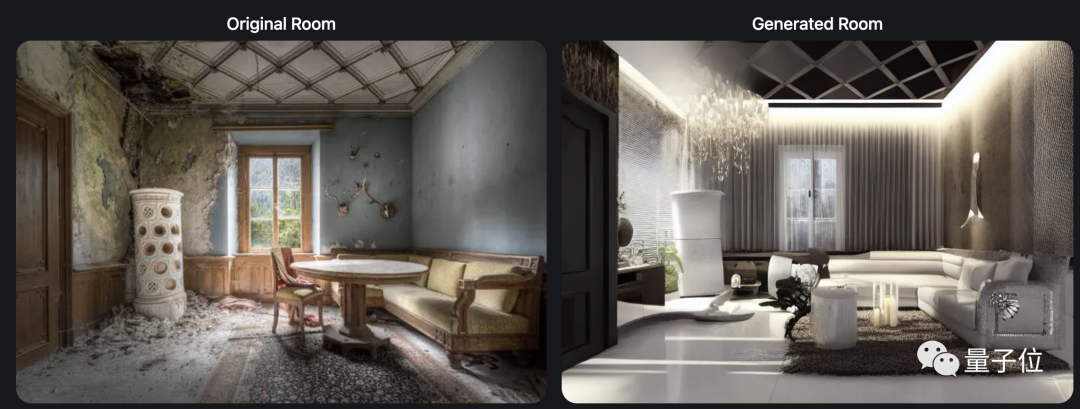

这是同一个房间改装前后的样子:

一下子质感Up,从凌乱过时变成了有腔有调的现代风。

至于设计费嘛,其实是…一分钱都没花!

因为这并不是专业设计师做的方案,而全靠一只AI完成。

——只用给AI一张照片,它就能搞定的那种。

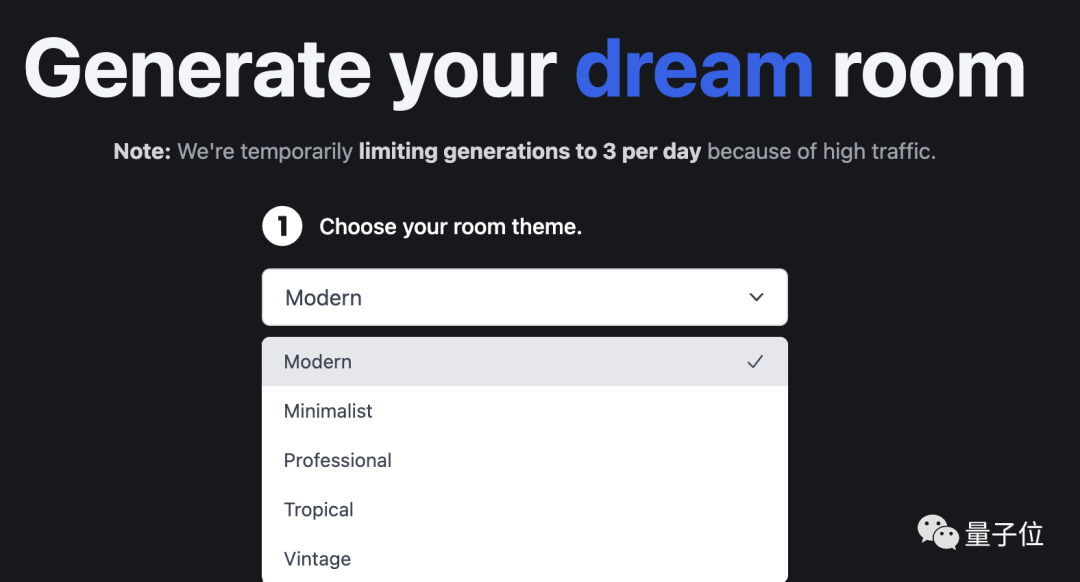

还可以选择不同风格。

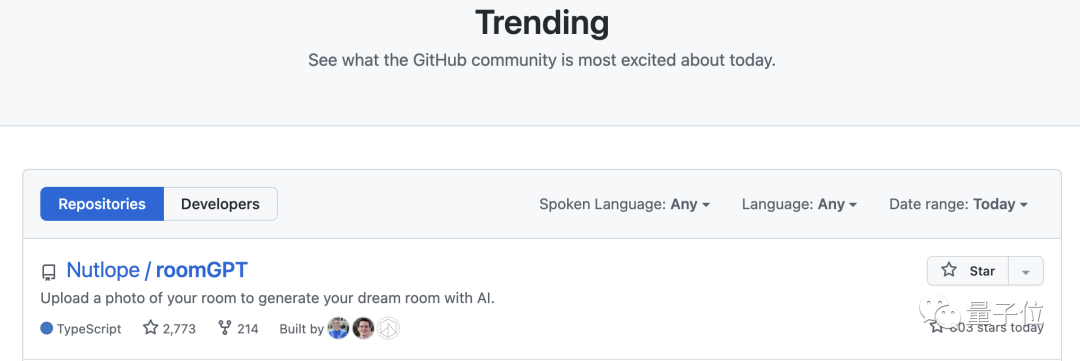

如此实用的“旧房改造”AI,很快引来大波网友驻足围观;原帖登上了GitHub热榜第一,目前已收获2700+颗星。

还在HackerNews上引起热议。

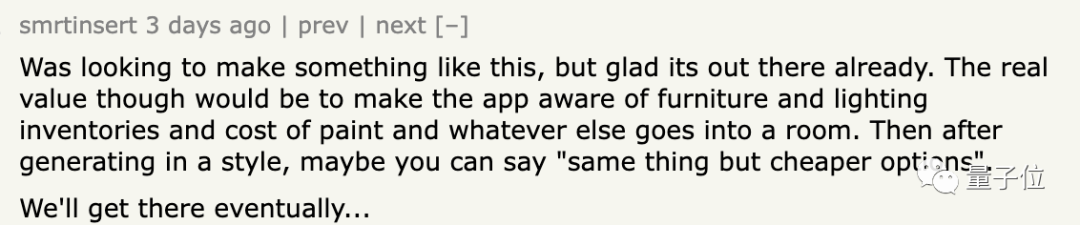

有网友称,这个应用让他觉得很惊喜,并表示:

如果这种AI还能添加一些功能就更好了,比如给生成图片中各设施进行估价,这样就有机会落地商用了。

还有网友指出:

这实际上就是一种生成式预训练Transformer,和其他Transformer本质是一样的。

一张图就能搞定房间设计

不管怎么说,这个AI确实在现有技术上整出了实用且新颖的用法。量子位没忍住也亲自上手试了试。

我先找来几张破旧房间的照片,然后开始和AI共同设计改造。

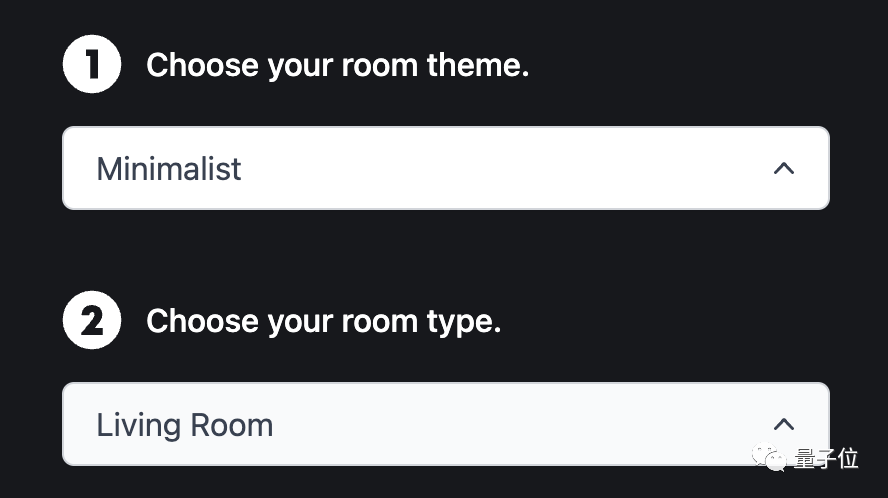

说是共同改造,但其实我要做的,就只用给AI一张图,然后点击两个选项:风格和房间用途。

比如,这里选择现代风的客厅:

几秒钟后,我眼前一亮。不仔细对比左右两张图的格局,真的很难相信这是同一个房间。

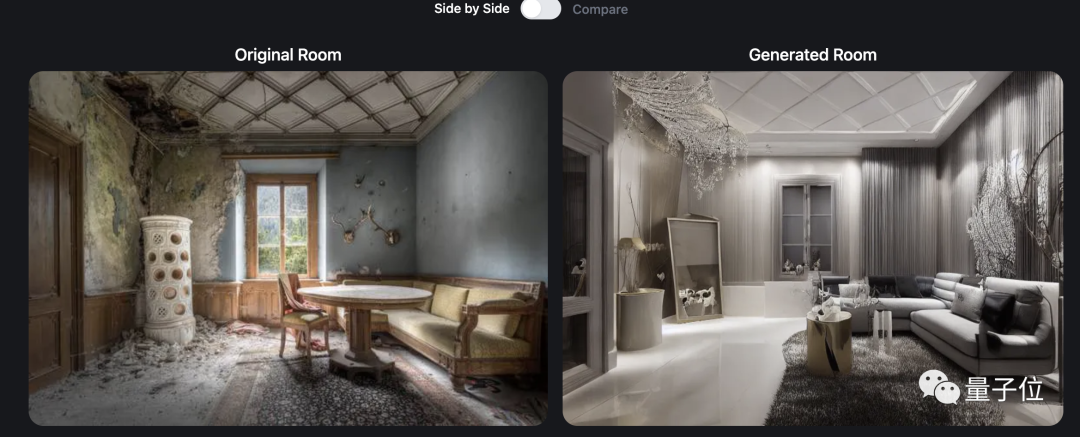

除了现代风,还有其他选择,于是我又试了试极简风:

虽然这似乎不太“简”,但很精美,甚至比上面的现代风更胜一筹。(给我看得都心动了…)。

不过需要说明的是,目前此AI一个IP每天最多只能用3次——实在想多弄几张的话,可以换台电脑。

看到这里,话说一只小小的AI,为何短短几秒就能设计好一整个房间?

其实,这主要得益于它背后一种强大的新晋机器学习模型:ControlNet。

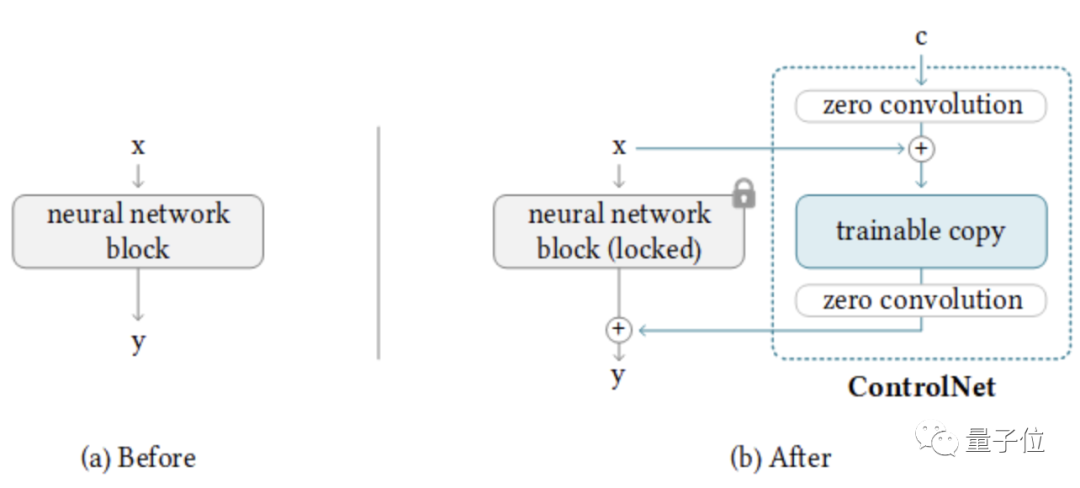

ControlNet,由斯坦福大学研发,是一种通过添加额外条件,来控制扩散模型的神经网络。

这个模型,可以将神经网络块的不同权重,分别复制到“锁定”副本(locked copy)和“可训练”副本(trainable copy)中。

锁定副本,会保留输入信息的一些关键特征;可训练副本,则会通过训练、学习来调节其他特征。然后,这两部分还会连接起来协同工作。

对于可训练副本而言,其训练的方向包括:物体的准确边缘、语义分割、人体姿势等等。

简单来说,就是AI能够判定,一张图中各个要素是否可以改变;然后会在原图某些核心要素不变的前提下生成新的内容,不会导致生成图和原图看起来毫无联系。

另外,这个模型搭配文字“食用”效果更佳——比如刚才我选择的房间用途和装修风格,其实就是在给AI添加一点文字提示。

总而言之,基于这样的原理,ControlNet不仅可以胜任室内设计,还有可以玩出别的花样。

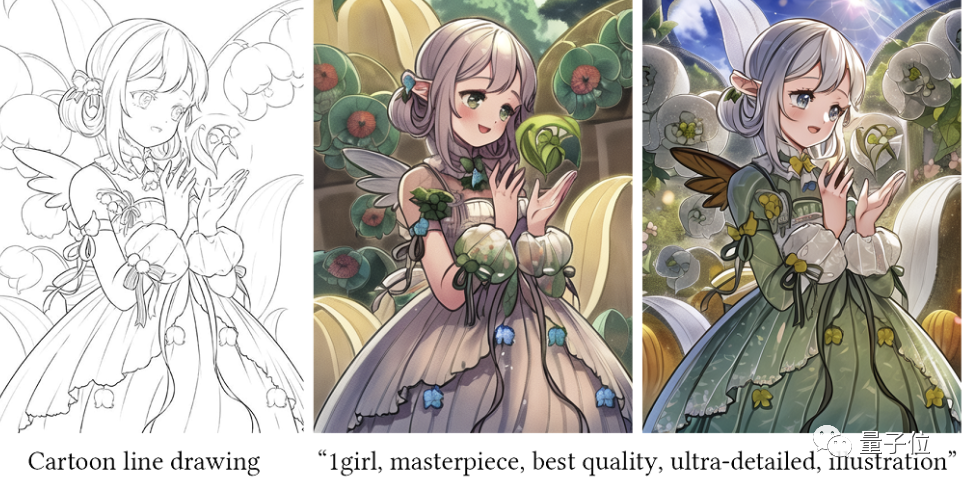

比如,一键涂色:

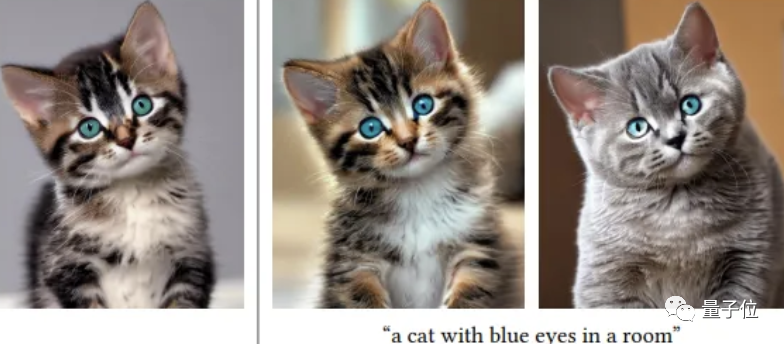

还有“一键换猫”(猫换了,但可爱的歪头杀不变):

“一键换牛”:

Emmm,那某些游戏皮肤是不是……?

值得一提的是,如果你嫌专门登陆官网(见传送门)比较麻烦,可以通过API将这个AI应用连到你的本地应用上。

按这种用法,首先需要下载数据库。

git clone https://github.com/Nutlope/roomGPT

接着去Replicate网站上创建一个帐户,并获取 API 密钥。注意,然后需要把将API 密钥存储在 .env 文件中,如 .example.env。

再安装依赖项:

然后你就能在命令行中运行该AI了:

开发者简介

最后,来认识一下此AI的幕后开发者:其实一共就3个人。

其中,最主要的贡献者Hassan El Mghari,本科毕业于德雷塞尔大学计算机工程系,现在是一名全栈软件工程师。

除了开发各种应用,这哥们儿还曾创立了一家游戏营销公司,在Steam上拥有500,000+名用户。

官网传送门:

https://www.roomgpt.io/

Relicatec传送门:

https://replicate.com/

参考链接:

[1]https://github.com/Nutlope/roomGPT

[2]https://news.ycombinator.com/item?id=35001046

[3]https://levelup.gitconnected.com/controlnet-control-your-ai-art-generation-616c86c88964

[4]https://www.elmghari.com/about

往期回顾

基础知识

【CV知识点汇总与解析】|损失函数篇

【CV知识点汇总与解析】|激活函数篇

【CV知识点汇总与解析】| optimizer和学习率篇

【CV知识点汇总与解析】| 正则化篇

【CV知识点汇总与解析】| 参数初始化篇

【CV知识点汇总与解析】| 卷积和池化篇 (超多图警告)

【CV知识点汇总与解析】| 技术发展篇 (超详细!!!)

最新论文解析

NeurIPS2022 Spotlight | TANGO:一种基于光照分解实现逼真稳健的文本驱动3D风格化

ECCV2022 Oral | 微软提出UNICORN,统一文本生成与边框预测任务

NeurIPS 2022 | VideoMAE:南大&腾讯联合提出第一个视频版MAE框架,遮盖率达到90%

NeurIPS 2022 | 清华大学提出OrdinalCLIP,基于序数提示学习的语言引导有序回归

SlowFast Network:用于计算机视觉视频理解的双模CNN

WACV2022 | 一张图片只值五句话吗?UAB提出图像-文本匹配语义的新视角!

CVPR2022 | Attention机制是为了找最相关的item?中科大团队反其道而行之!

ECCV2022 Oral | SeqTR:一个简单而通用的 Visual Grounding网络

如何训练用于图像检索的Vision Transformer?Facebook研究员解决了这个问题!

ICLR22 Workshop | 用两个模型解决一个任务,意大利学者提出维基百科上的高效检索模型

See Finer, See More!腾讯&上交提出IVT,越看越精细,进行精细全面的跨模态对比!

MM2022|兼具低级和高级表征,百度提出利用显式高级语义增强视频文本检索

MM2022 | 用StyleGAN进行数据增强,真的太好用了

MM2022 | 在特征空间中的多模态数据增强方法

ECCV2022|港中文MM Lab证明Frozen的CLIP 模型是高效视频学习者

ECCV2022|只能11%的参数就能优于Swin,微软提出快速预训练蒸馏方法TinyViT

CVPR2022|比VinVL快一万倍!人大提出交互协同的双流视觉语言预训练模型COTS,又快又好!

CVPR2022 Oral|通过多尺度token聚合分流自注意力,代码已开源

CVPR Oral | 谷歌&斯坦福(李飞飞组)提出TIRG,用组合的文本和图像来进行图像检索