技术编辑:芒果果丨发自 思否编辑部

SegmentFault 思否报道丨公众号:SegmentFault

作为美国历史上的第一位黑人总统,奥巴马的肤色有太多意义。

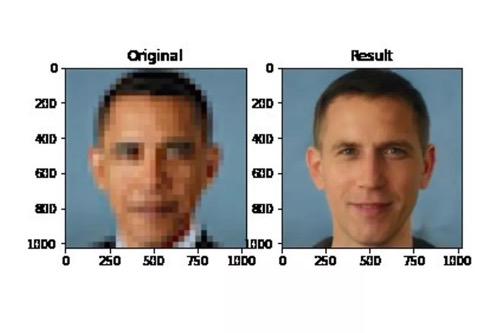

但在一次 AI 生成的图像中,将奥巴马低分辨率的照片输入后,输出的却是一位白人图片。

这难道说明了 AI 研究也有根深蒂固的偏见?

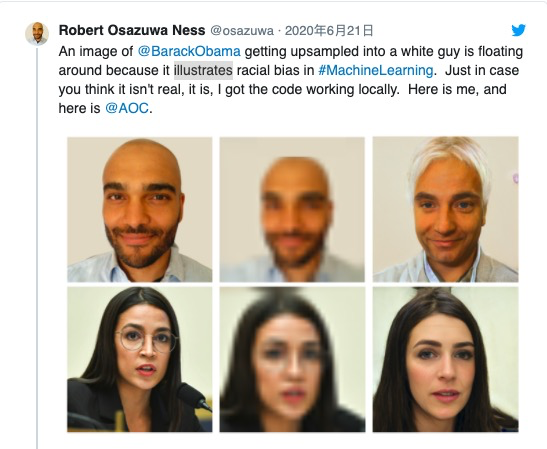

不仅仅是奥巴马,通过同样的算法输入低分辨率的女演员 Lucy Liu 的照片或女议员 Alexandria Ocasio-Cortez 的照片生成的图像面孔看起来明显是白色的。

国外社交网站一则推文引用了奥巴马的例子说:“这张图片充分说明了人工智能存在偏见的危险。”

AI 算法生成逼真「假脸」

但是,是什么导致了这些结果,它们真正告诉我们人工智能的偏见是什么?

首先,我们需要对这里使用的技术有所了解。生成这些图像的程序是一种叫做 PULSE 的算法,该算法使用一种称为“升级”的技术来处理视觉数据。

这种技术就像你在电视和电影中看到的画面,通过“放大和增强”使视觉效果更强。但是,不像好莱坞大片中的特效画面,软件不能无中生有地产生新的数据。 为了将低分辨率图像转换为高分辨率图像,软件必须使用机器学习来填补空白。

就 PULSE 而言,进行这项工作的算法是 StyleGAN,它是由 NVIDIA 的研究人员创建的。虽然算法不是每个人都能了解的,但它生成的「作品」却被很多人熟知并使用。这个算法生成的怪异逼真的人脸可以在许多网站上找到,并且经常被用来生成虚假的社交媒体个人资料。

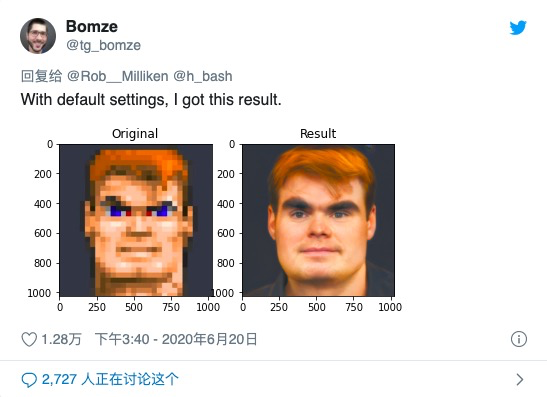

PULSE 所做的是使用 StyleGAN 来“想象”高分辨率的像素化输入。 它不是通过“增强”原来的低分辨率图像,而是通过生成一个全新的高分辨率的脸,当像素化时,看起来和用户输入的一样。

这意味着每张去像素化的图片都可以通过多种方式进行高倍放大,就像同一套食材可以做出不同的菜肴一样。这也是为什么你可以使用 PULSE 看到游戏、动画甚至表情符号生成高分辨率的人像图。算法通过寻找图像中的细节创造新的面孔还原到输入数据中。

这种算法已经使用了几年时间,但是,就像人工智能领域经常出现的情况一样,当一个易于运行的代码版本在网上被分享时,它会吸引更多用户。从而衍生出更多社会问题,包括种族差异问题。

训练数据集导致算法结果的偏向性

PULSE 的创建人表示,当使用该算法放大像素化图像时,该算法更经常生成具有白人特征的脸部,这一趋势很明显。他在 Github 上写道: “看起来 PULSE 生成白人面孔的频率要比生成有色人种面孔的频率高得多。这种偏见很可能是从 StyleGAN 所训练的数据集中继承而来的,尽管可能还有其他我们不知道的因素。”

换句话说,由于 StyleGAN 所接受的数据训练,当它试图想出一张看起来像像素化输入图像的脸时,它默认为白色特征。

这个问题在机器学习中非常普遍,这也是人脸识别算法在非白人和女性面孔上表现较差的原因之一。 用于人工智能训练的数据往往倾向于单一的人口统计学,即白人男性,当一个程序看到的数据不在这个人口统计学中时,它表现得很差。并非巧合的是,在人工智能研究中占主导地位的是白人男性。

但是,奥巴马的例子究竟揭示了什么样的偏见,以及它所代表的问题是如何解决的,这些都是复杂的问题。

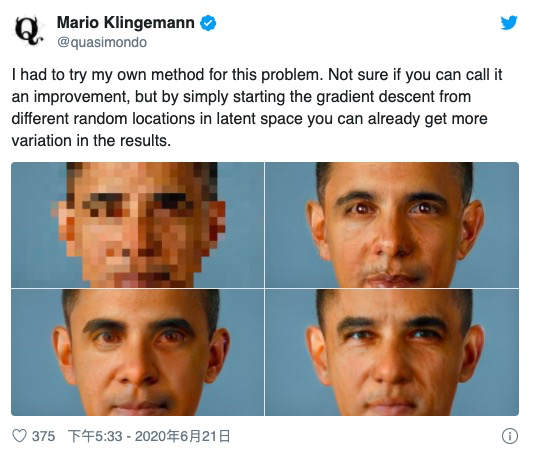

在技术层面上,一些专家甚至不确定这是否是数据集偏差的一个例子。人工智能学者马里奥 · 克林格曼认为,是 PULSE 选择算法本身,而不是数据,造成了这一切。克林格曼指出,他能够使用 StyleGAN 从同一张像素化的奥巴马图像中生成更多非白色输出,如下所示:

克林格曼表示,这些人脸是使用“相同的概念和相同的 StyleGAN 模型”生成的,但使用的是 PULSE 的不同搜索方法。他表示,我们不能仅仅从几个样本来判断算法。他说:“可能有数百万张可能的脸都会归结为同样的像素模式,所有的脸都同样‘正确’。” (顺便说一句,这也是为什么像这样的工具不太可能被用于监视目的的原因。这些过程创建的面孔是想象的,并且,如上面的例子所示,与输入的基本事实没有什么关系。然而,这并不是说过去巨大的技术缺陷阻止了警察采用技术。)

但是,不管原因是什么,这个算法的输出似乎有偏差ーー在这个工具被广泛使用之前,研究人员没有注意到这一点。 这说明了一种不同的、更普遍的偏见: 一种在社会层面上起作用的偏见。

学界争论,是数据不正确还是社会不公正?

人工智能责任研究员 Deborah Raji 认为,这种偏见在人工智能领域太典型了。他说:“鉴于有色人种的基本存在,忽视对这种情况的测试是令人震惊的,这可能反映了我们在谁来建造这种系统方面继续看到的缺乏多样性。有色人种不是局外人。我们不是作者可以忘记的‘边缘案例’。”

事实上,一些研究人员似乎只热衷于解决数据方面的偏见问题,这引发了关于奥巴马形象的更大争论。Facebook 首席人工智能科学家 Yann LeCun 成为了这些对话的引爆点,他在推特上回应了这张图片,称“当数据存在偏见时,机器学习系统是有偏见的” ,并补充说这种偏见“在部署的产品中比在学术论文中”是一个更严重的问题 其含义是: 让我们不要过分担心这个特殊的例子。

包括 Deborah Raji 在内的许多研究人员对 Yann LeCun 的看法提出了质疑,并指出人工智能中的偏见受到更广泛的社会不公正和偏见的影响,仅仅使用“正确”的数据并不能解决更大的不公正。

其他人指出,即使从纯技术修复的角度来看,“公平”的数据集通常也可以是非公平的。例如,一个准确反映英国人口统计特征的人脸数据集将以白人为主,因为英国主要是白人。根据这些数据训练的算法在白人脸上比在非白人脸上表现更好。换句话说,“公平”的数据集仍然可以创建有偏差的系统。(在随后的 Twitter 帖子中,Yann LeCun 承认人工智能偏见有多种原因。)

Deborah Raji 称,他对 Yann LeCun 的看法感到惊讶,Yann LeCun 建议研究人员应该比生产商业系统的工程师更少地担心偏见,这反映了行业最高层对此缺乏认识。

Deborah Raji 说:“Yann LeCun 领导着一个行业实验室,这个实验室致力于许多他们经常寻求产品化的应用研究问题。我实在无法理解,处于这种地位的人怎么会不承认研究在建立工程部署规范方面的作用。”

「正确」的数据治标不治本,AI 研究应更关注“人”

许多商业人工智能系统都是直接根据研究数据和算法构建的,没有对种族或性别差异进行任何调整。在研究阶段不能解决偏见问题只会使现有的问题永久化。

因此,从这个意义上讲,奥巴马形象的价值不在于它暴露了单一算法中的一个缺陷,而在于它在直觉层面上传达了人工智能偏见的普遍本质。然而,它所隐藏的是,偏见的问题比任何数据集或算法都要深刻得多。这是一个普遍存在的问题,需要的不仅仅是技术上的修复。

正如研究人员 Vidushi Marda 在 Twitter 上对该算法产生的白种人脸做出的回应: “如果需要明确说明的话——这不是在呼吁数据集中的‘多样性’或性能上的‘改进准确性’——这是在呼吁从根本上重新考虑设计、开发和部署这项技术的机构和个人。”