每周两更!李沐老师已在GitHub 开源了《深度学习论文精读》,挑选了近10 年来深度学习必须文章,知乎B站油管同步视频讲解!深度学习应该看哪些文章?大神李沐甩出了一份《深度学习论文精读》宝典,给大家抄作业啦!目前精读文章已在 GitHub 开源,速览!

GitHub地址:github.com/mli/paper-reading

个人主页:https://github.com/mli

从本月初做论文推荐和精读以来,现已上传5条视频,已经逐段式逐句式精读了2篇论文。话不多说,趁着还能上车,赶紧追呀!!!

每次精析近60分钟,时长感人!从发布时间来看,老师你为啥总是周四周五上传视频?莫非我已经掌握了你的输出节奏!新一期的视频预计在3天后,前排蹲起!

从李老师已经推荐的论文来看,开头就是两篇重头戏---

深度学习奠基作之一:AlexNet

9年后重读,原来AlexNet的报告也被大佬们喷过?

AlexNet论文中有多少观点现在看都不对?

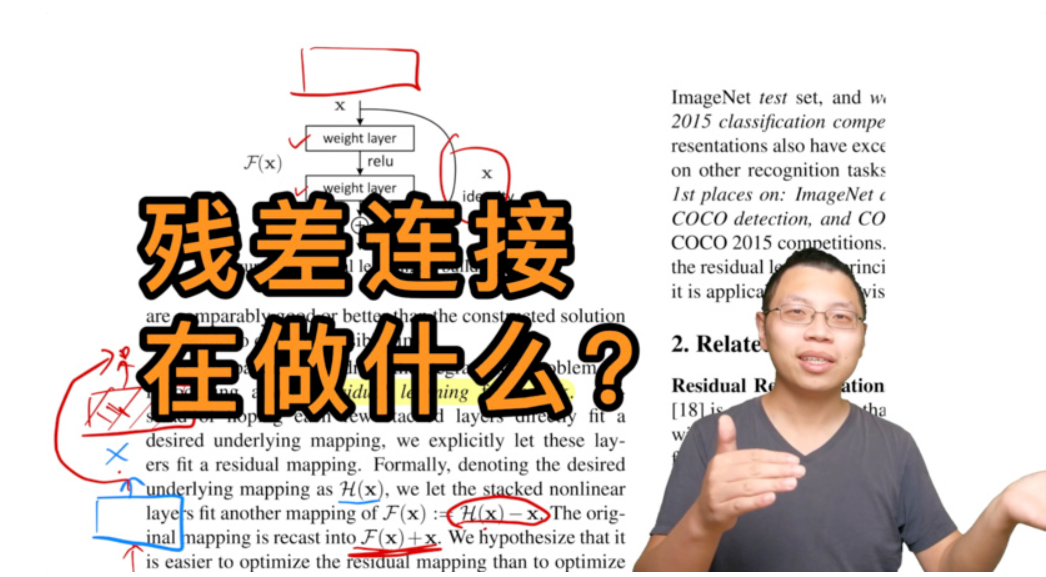

撑起计算机视觉半边天的:ResNet

为什么网络越深,效果越差?

残差连接在做什么?

从当下最热火的深度学习问题入手,再重读经典深度学习论文,经典还能回应时代之声吗?

李老师不仅从专业角度“亮剑式”解析论文,还光明正大领着大家吃起了瓜!原来大佬的的论文也被喷过!

看李老师做过的视频讲解,真真是读书“破”万卷!

怎么老师您的笔法越邪魅狂狷,我心越踏实!这样的论文结构解析和技术分析,一眼就能把论文读“薄”!

在开篇之作如何读论文中,沐神总结了读论文的一种套路:

论文结构通常分为六个部分,要按照“读三遍”的方法快速掌握论文的精华。

1.title

2.abstract

3.introduction

4.method

5.experiments

6.conclusion

第一遍:标题、摘要、结论。可以看一看方法和实验部分重要的图和表。花费十几分钟时间了解到论文是否适合你的研究方向。

第二遍:确定论文值得读之后,快速把整篇论文过一遍。不需要知道所有的细节,但需要了解重要的图和表,知道每一个部分在干什么,圈出相关文献。如果觉得文章太难,可以读引用的文献。

第三遍:重点读论文提出了什么问题,用到了什么解决方法,实验是怎么做的。

在读方法的部分中,思考自己如何完成作者所提出的问题,用什么方法实现;

在读实验的部分时,思考自己能不能比作者做得更好;能用什么方法优化。

在沐神的接下来的论文精读中,同样是按照这种方法指导大家拆分论文,懂得如何读论文是科研入门的第一步。

当然我们从李老师的GitHub 主页中发现,他在15个小时之前已经悄悄更新了下一期目录:

Transformer:新的大一统架构?

图神经网络的可视化介绍。

这样勤奋的老师谁能不爱!难怪大家对沐神的评价是:不用催更反而督促粉丝跟上节奏的神奇up主!

李老师官方透露:

录一篇文章的时间大概是5个小时(拍摄、剪辑、上传),一般是每天深夜找半个小时或者一个小时做一点。如果没有其他更紧要的事情的话,10天左右可以出一篇。如果大家热情的话,可以多赶一赶!

考虑在之后视频中将要介绍的论文,选取的原则是10年内深度学习里有影响力文章(必读文章),或者近期比较有意思的文章。当然这十年里重要的工作太多了,不可能每篇都过。在选取的时候会偏向一些之前直播课中没讲到过的。欢迎大家在讨论区里提供(点)建议(歌)。

现在的候选论文已经列出,将持续更新(数字不代表讲析顺序)。

链接:https://arxiv.org/abs/1412.6980

链接:https://arxiv.org/abs/1905.11946

链接:https://arxiv.org/abs/1810.04805

链接:https://arxiv.org/abs/2005.14165

链接:https://arxiv.org/abs/1406.2661

链接:https://openai.com/blog/clip/

链接:https://arxiv.org/pdf/2110.07641.pdf

链接:https://cacm.acm.org/magazines/2021/3/250713-understanding-deep-learning-still-requires-rethinking-generalization/fulltext

链接:https://distill.pub/2021/gnn-intro/

链接:https://deepmind.com/research/case-studies/alphago-the-story-so-far

十篇论文已经安排好,意味着至少有两个半的时间,李老师将和我们一起云学习!

从李老师敲定的论文来看,篇篇都有讨论价值。

因此有网友表示:重读论文很有必要,技术需要时间验证。

至于一部经典作品是什么作品,哪怕它与时代的旋律格格不入,它也至少成为一种时代的背景噪音。

回顾李老师自己的生命历程,"大神",是很多人对李沐的印象。作为一经推出便大受追捧的 MXNet 深度学习框架的主要贡献者之一,李沐功不可没。

以倒叙时间线来看,李沐目前为止的职业和学习生涯大致是这样的:

但是再看李沐近来的感悟,他更像是一位用理性审视生命历程的“有心人”,最近提出用随机梯度下降来优化人生的箴言:多向四处看看,每一步的方向都是你对世界的认识。

随机梯度下降的第一个词是随机,就是你需要四处走走,看过很多地方,做些错误的决定,这样你可以在前期迈过一些不是很好的舒适区。

重读论文大抵如此。优秀的经典论文就是要敢于直面权威的审视,也要在时间的流动中经久不衰。提到这十年以来的论文,李老师也谈到文中部分观点的失效,但能再从中锤炼出什么,从字缝里翻出什么细节,从段落中抖搂出什么字碴儿,正是重读经典的意义。

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为

星标账号,以及常点文末右下角的“在看”。