老话说:隔行不取利。但时过境迁,目前不管是娱乐圈还是学术界,跨界方可大红大紫。在娱乐圈,相声演员客串脱口秀,歌手跨界演员,赚的钵满盆满。而在学术界,如果我们的眼界仅仅局限于自己的专业领域,那么很可能错过一些难得的火花。在本文中,作者详细介绍了物理学——这个古老、严谨、充斥着各种智商怪物争相斗法的传统学术方向,是如何与机器学习和深度学习擦出智慧的火花的。作者 | Don

编辑 | 青暮

神经网络,对于这个熟悉的名词,我们一听之下便知它深受生物学的影响,尤其是脑神经科学。虽然神经网络的灵感最初源于生物学,但是随着人们研究的深入,生物学这个母体学科中可用资源日渐枯竭。但是与生物一墙之隔的物理学还是处于一片蓝海,这片科研的处女地中的很多经验和研究方法论有望帮助神经网络的研究变得更加优秀,找到更多的真理。因此,近些年不少工作开始琢磨如何在机器学习和物理学之间建立更强的纽带,设计出更加强大的计算方法。

自诞生之初,机器学习和物理学便有着十分紧密的关联。早在1982年,John Hopfield就进行了第一步尝试,他在神经网络和物理学之间建立了第一座互通有无桥梁。Hopfield发现,在物理学中,一个由相互作用的粒子组成的粒子群物理系统中,粒子间通常会产生一些形似磁性力的作用现象。

Hopfield于是将这种相互作用的现象借鉴到了神经网络模型的设计当中,尤其是网络中的那些具有自发计算特性的神经元结构。因此,Hopfield发明出了“Hopfield network”,而它则是递归神经网络(RNN)的前身。

时至今日,RNN的广泛应用无需赘述,它大量的应用在时序分析、自然语言处理等领域。只要数据之间具有时间依赖性、时序动态特征,那么RNN就是一个十分优秀的备选方案。

换个角度来看,理论物理学有望帮助人们从基础上重新认识机器学习领域。早在1984年,L. G. Valiant就发表了一篇经典论文《A theory of the learnable》,在其中,他便对此定下了基调。

论文地址:https://dl.acm.org/doi/10.1145/1968.1972

这篇论文介绍了一个严格的学习统计理论,可以看作是一切可学习的基础。它突破了现在深度学习、机器学习中以数学为根基的可学习或学习算法的范畴,而以更高、更宏观的角度来讨论模型、人类、或各种事件的“可学习性”。

概括来说,作者将学习行为定义为一种“在没有显示程序化的情况下获取知识的现象”,文章从计算的角度给出了研究学习现象的具体方法,包括选择正确的信息收集方法、学习方法、以及搜索选择合理的描述计算方法、计算步骤的数学概念类型。

但当时间来到2010年代,经历了漫长蛰伏的深度学习异军突起,在诸多领域中以迅雷不及掩耳之势大肆霸榜,刷新各种记录并吊打其他传统算法。深度学习凭借其彪悍强大的泛化能力,以及不可理喻的非线性学习能力赢得了世人的惊叹和承认。但是随之而来的,也有质疑和困惑,这个黑箱家伙的背后,究竟隐藏着什么未解之谜?

在最近发表在《Nature Physics》杂志上的一篇评论论文中,Lenka Zdeborová研究员呼吁科研人员尝试重新使用“物理学启发的方法(Physics-inspired approaches)”来解决实际生活中那些复杂而毫无头绪的建模问题。

在这篇名为《Understanding deep learning is also a job for physicists》的文章中,作者首先赞扬了深度学习的广泛应用,以及在诸多领域中的卓越表现。

文章地址:https://www.nature.com/articles/s41567-020-0929-2

但是也一针见血的指出这种“无脑”训练的方法在某种意义上不够“优雅”,它浪费了大量了计算资源和泛化能力,可能费劲千辛万苦训练出一个庞大复杂的模型结果只是解决了一个y=kx+b的问题。

换句话说,深度学习的研究很多情况下没有剖析到问题的本质,他们没有深入的分析数据,没有细致的观察数据之间的关联和变化,因而也没有对其背后的规律和真正的核心模型进行理解和探究。极有可能的是,我们训练出了一把举世无双的屠龙宝刀,目的是给装修公司刮大白——虽然好使,但是物理学家们还是觉得腻子铲好使……当然,作者也有呼吁物理学家借鉴深度学习这个工具加速各自理论研究和模型研究的初衷。

具体来说,Lenka指出:物理学家擅长于归纳总结,总能够透过数据看到其后的本质。物理学家们拥有丰富的经验,他们可以轻松的处理数量庞大、异构、多模态且量级各异的实验数据,并且从中抽丝剥茧,像福尔摩斯一样找到问题背后的规律。

因此,物理学家们总能找到问题背后的本质,并且对其中重要的那部分合理建模。而对于数据中那些无关紧要的噪声和细节,物理学家们也能够把它们准确的剔除出来并且忽略。可怕的是,物理学家甚至还总能通过分析和调查来测试这些猜想和模型。

一个典型的例子是物理学中十分成功的磁学模型-Ising模型。Ising没有使用任何关于磁相互作用或材料特性的量子力学先验细节,但它却可以准确的模拟出自然界中的若干种类型的实验现象。

事实上,计算科学家们在之后也尝试对同样的问题基于数据建立了机器学习方法。他们曾经设计了一个Hopfield网络,喂给它超大规模的数据后,训练出来的模型居然和Ising别无二致,二者结果完全相同。

可以说,这就是一个机器学习版本的Ising网络。这也从侧面说明了Ising模型的成功。所以说,如果我们想对深度学习的理论有进一步的理解、如果我们想揭开深度学习黑盒背后的神秘面纱,那物理学所启发的归纳思路可能是个不错的突破口。

我们可以稍微展开来讲,为什么说物理学有望成为深度学习理论的突破口呢?我们知道,深度学习的可解释性研究或合理性理论研究一直是一个热门的领域。由于深度学习黑盒不可解释的特性,它被例如医疗等领域严格限制着。如果一个产品想通过CFDA、CE的认证,那么你需要将算法的理论讲的一清二楚,毕竟人命关天。

因此,如果我们可以从物理学的角度对深度学习的可解释性进行系统的阐述和研究,甚至哪怕是一点点微小的进步,也将会被业界和学界当作救命稻草一样牢牢抓住并异常珍惜。

那么针对深度学习可以计算什么?我们如何训练它们?信息是如何通过它们传播的?为什么它们可以泛化?我们如何教它们想象……等等的灵魂拷问,都将是研究的重点。目前,有些工作比如《Statistical Mechanics of Deep Learning》从统计力学的物理分析角度来为这些问题提供根源概念上的解释。

论文地址:https://www.annualreviews.org/doi/10.1146/annurev-conmatphys-031119-050745

这些解释方法将深度学习与各种物理和数学主题联系起来,包括随机景观、自旋玻璃、干扰、动态相变、混沌、黎曼几何、随机矩阵理论、自由概率和非平衡统计力学。

事实上,统计力学和机器学习领域,自古以来就有着很强的耦合性,以及丰富的互动历史,而统计力学和深度学习交叉点的最新进展表明,这些互动有望会进一步繁衍生息,并最终为我们深度学习的理论研究和可解释性,提供振奋人心突破的可能!

从实际应用的角度来看,深度学习有着“大力出奇迹”的属性。只要有足够多的数据和足够复杂的神经元结构,很多实际生活中和物理学中的“百年未解之谜”都能迎刃而解。比如流体力学、高能物理学或天气预报。

例如在Christian等人发表在Nature的工作《Deep recurrent optical flow learning for particle image velocimetry data》中,他们就提出了一种用来学习物理位移场( displacement fields)的端到端深度学习模型。其重点关注了粒子图像测速(PIV)的物理性质和动态特点。

论文地址:https://www.nature.com/articles/s42256-021-00369-0

PIV是实验流体动力学中的一种核心的关键技术,它在汽车、航空航天和生物医学工程等多种应用中具有至关重要的意义。目前的PIV数据处理方法都是纯手工设计的,其泛化能力和估计的因素受到了开发人员的限制,其中也有不少需要手动设置的参数,其适用范围和大规模应用受到极大的挑战。

相比之下,作者所提出的基于深度学习的PIV方法则基于了最近的光流学习体系结构(称为递归全对场变换),这个模型的应用范围更加广泛,具有通用的使用属性。其中的大部分参数设定、计算泛化和结构调整也都是自动化的,还能提供极高的空间分辨率。

现在学界一个活跃的方向,便是使用机器学习模型来估计出偏微分方程形式的数学公式解,这些数学公式解的规则是紊流(turbulence)等复杂动态现象的理论基础。在《Nature Reviews Physics》最近的一篇评论文章中,George Karniadakis及其同事便对其进行了相当细致的讨论。他们认为,物理学可以结合深度学习方法来解决复杂的动态问题,并给出了多个结合的思路,也阐述了一些具体的例子,包括地震预测和分子动力学等。

另一个很有前途的研究方向是用深度学习来解决优化问题,特别是组合优化(combinatorial optimization)问题。在该类问题中,算法必须在一个非常大的有限可能配置空间中找到最优解。这个配置空间的大小会随着问题的输入规模呈指数级增长。因此,基于穷举搜索的解决策略是不可行的,这会导致维度灾难。

具体来说,为了解决组合优化问题,Yoshua Bengio的很多工作开始逐渐从研究统筹学解过渡到利用深度学习求解的领域。

论文地址:https://arxiv.org/pdf/1811.06128v2.pdf

这些组合优化的求解问题通常十分困难,其数学难度较大。但是目前主流的算法都是靠手工设计的启发式算法,它们的可解释性和灵活性较高,但是其设计代价较大,而且其决策结果在某种程度上具有计算或数学定义不明确的问题。

因此,很多人转投到机器学习的阵营。相对而言,机器学习方法具有更好的决策原则可追溯性和优化方式的优越性。当然,也有一些工作主张进一步加强机器学习和组合优化的集成。简要来说,它们主要是将一般优化问题视为数据点,并询问在给定任务中用于学习的问题的相关分布情况。

其实,为了避免维度灾难而使用机器学习求解的例子有很多,举几个典型的:Rubik’s Cube魔方问题、旅行商问题和寻找蛋白质的三维结构问题。

Rubik's cube其实就是我们常说的魔方,Magic Cube,是因为1974年Rubik教授发明了它因此得名。在2019年Nature上发表的一篇文章中,作者就提出使用深度学习方法DeepCubeA来解决魔方问题。DeepCubeA可以学习如何在没有任何特定领域知识的情况下,从目标状态反向解决越来越困难的魔方问题。

论文地址:https://www.nature.com/articles/s42256-019-0070-z

而在更难的蛋白质序列预测、蛋白质三维结构的工作中,Brain等人综述了学术界目前已经使用的深度学习方法。

文章地址:https://www.nature.com/articles/s41580-019-0163-x

这些方法都是用来解决蛋白质领域中的一个难题——设计折叠成特定三维结构的氨基酸序列。在过去的十年中,蛋白质结构的预测和设计方法进步神速。而计算能力的提高以及蛋白质序列和结构数据库的快速增长也同步推动了新的数据密集型和计算要求高的结构预测方法的发展。

因此很多算法可以经过计算来设计“蛋白质折叠”和“蛋白质-蛋白质界面”,并也被应用于新的高阶蛋白质组装体的设计,以及从0设计具有新颖或增强性质的荧光蛋白质,以及具有治疗潜力的信号蛋白质。

其中,比较具有代表性的是Mohammed Hibat-Allah等人提出的一种融合了经典和量子物理学以及深度学习的设计,这种方法可以用来寻找无序Ising系统的基态(Ground State)。

论文地址:https://www.nature.com/articles/s42256-021-00401-3

在统计物理学中,优化问题可以用一种叫做模拟退火的计算方法来解决。这是一个受到冶金学中的退火过程的启发而被提出来的启发式算法过程。

在冶金工业的退火工艺过程中,固体加温至充分高,再让其徐徐冷却,加温时,固体内部粒子随温升变为无序状,内能增大,而徐徐冷却时粒子渐趋有序,在每个温度都达到平衡态,最后在常温时达到基态,内能减为最小。简单来说材料被快速加热,随后缓慢冷却。在冷却的过程中,材料在微观上重新排列成具有所需特性的最佳配置。

而受到这个现象的启发,科学家总结出了传统的模拟退火算法。简而言之,它是基于Monte-Carlo迭代求解策略的一种随机寻优算法,其出发点是基于物理中固体物质的退火过程与一般组合优化问题之间的相似性。

模拟退火算法从某一较高初温出发,伴随温度参数的不断下降,结合概率突跳特性在解空间中随机寻找目标函数的全局最优解,即在局部最优解能概率性地跳出,并最终趋于全局最优。

模拟退火算法是一种通用的优化算法,理论上算法具有概率的全局优化性能,目前已在工程中得到了广泛应用,诸如VLSI、生产调度、控制工程、机器学习、神经网络、信号处理等领域。

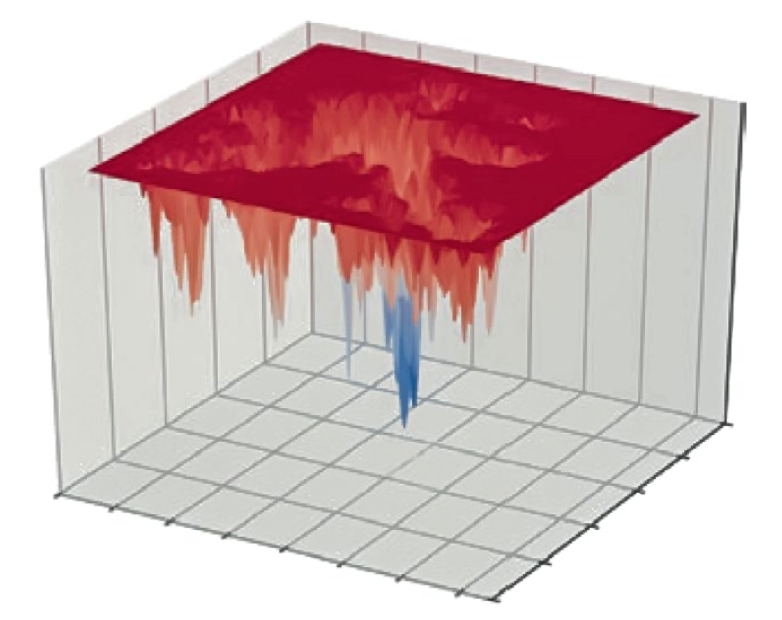

模拟退火算法通过逐渐减少 "热波动 "来探索在能量的角度中的全局损失最小值(见图中一个具有明显全局最小值的粗糙能量视角的例子)。

一个简化的、非常粗糙的能量可视化图,它展示了蛋白质的折叠分析。图源:Kuhlman & Bradley. Nat. Rev. Mol. Cell Biol. 20, 681-697 (2019). Springer Nature Ltd

无论是经典还是量子版本的模拟退火算法,对优化问题都是很有用的。但其通过"冷却"(减少热波动)来探索优化的算法部分通常是一个缓慢的过程。Hibat-Allah等人将模拟退火与所谓的变异方法相结合,通过一个循环神经网络(RNN)来对系统状态的联合分布进行参数化。这种方法被称为“变异神经退火”方法。这种新方法大大加快了模拟退火的算法执行过程。

有必要补充的是,前文所说的经典模拟退火算法便是1974年Kirkpatrick大神提出的传统模拟退火算法。

论文地址:https://www.science.org/doi/10.1126/science.220.4598.671

而量子版本则是Santoro等人在2002年的后续研究,他们通过比较二维随机Ising模型(自旋玻璃原型/a prototype spin glass)上的经典和量子Monte Carlo退火算法,证实了量子退火相对于经典退火的优越性。

论文地址:https://www.science.org/doi/10.1126/science.1068774

他们还提出了一种基于Landau-Zener隧道级联事件的量子退火理论,证明了复杂系统的最低能量组态比经典的热对应物更有效。

可以预计,物理学和机器学习之间还有许多富有成效的互动。围绕着将机器学习与量子信息方法合并的美好期许,人们一定会非常兴奋和鼓舞。

其中一个值得重点关注的方向则是用量子计算机加速机器学习——这种方法将关注的重心投注于可靠的量子硬件,具体来说,他们假设并且讨论了量子计算机相对于经典计算在机器学习任务上的好处。

相关论文:https://www.nature.com/articles/nature23474

促进其实是相互的,机器学习的概念也在推动量子计算的进步。例如Juan等人便提出了一种基于神经网络生成模型的密度矩阵重构方法,来对可扩展多体量子技术中状态准备的基准测试进行描述。

论文地址:https://www.nature.com/articles/s42256-019-0028-1

感兴趣的读者可以在Giuseppe Carleo等人的综述文章中找到进一步的论述。

论文地址:https://www.nature.com/articles/s42256-019-0028-1

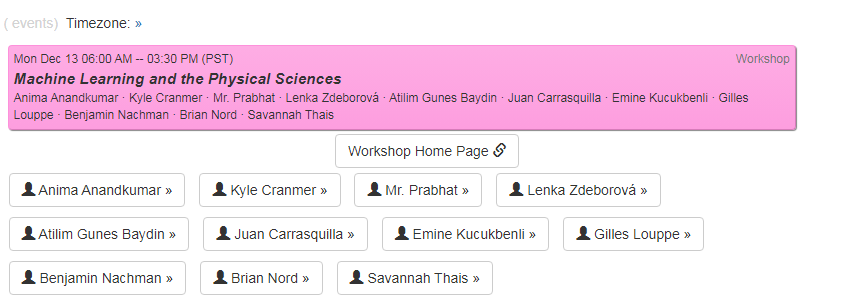

或者参加即将到来的NeurIPS机器学习和物理科学研讨会。

相关链接:https://neurips.cc/Conferences/2021/Schedule?showEvent=21862

参考链接:

https://www.nature.com/articles/s42256-021-00416-w

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为星标账号,以及常点文末右下角的“在看”。