我们正处在计算领域一个千载难逢的转折点上。传统的计算基础设施设计和构建方式已不再适应生成式人工智能(AI)和大型语言模型(LLMs)等工作负载呈指数增长的需求。事实上,过去五年中,LLMs中的参数数量每年增加了10倍。因此,客户需要既经济实惠又可扩展的AI优化基础设施。

二十年来,谷歌构建了业界领先的人工智能能力:从创造了使生成式AI成为可能的谷歌Transformer架构,到我们的AI优化基础设施,旨在提供满足谷歌产品需求的全球规模和性能,这些产品为数十亿用户提供服务,如YouTube、Gmail、Google Maps、Google Play和Android。我们很高兴将数十年的创新和研究成果带给追求人工智能变革机会的谷歌云客户。我们为人工智能提供完整解决方案,从为人工智能优化的计算基础设施以及端到端的软件和服务,支持模型训练、调优和全球规模部署的完整生命周期。

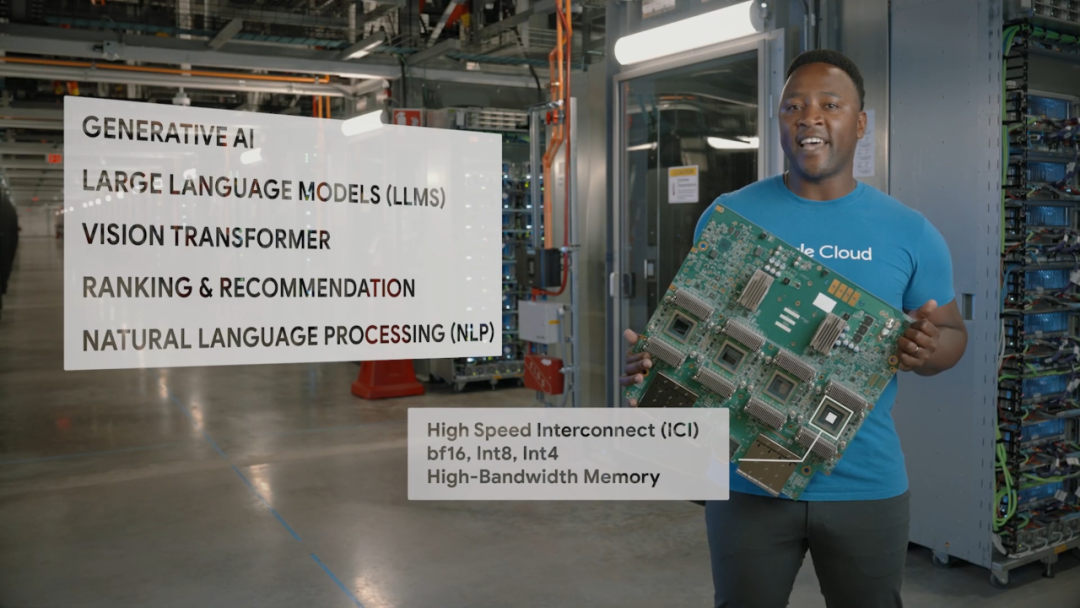

谷歌云提供领先的人工智能基础设施技术,包括TPUs和GPUs,今天,我们自豪地宣布对这两个产品组合进行了重大增强。首先,我们通过Cloud TPU v5e来扩展我们的AI优化基础设施组合,这是迄今为止成本最低、最多功能且可扩展性最强的Cloud TPU,现已推出预览版。TPU v5e与Google Kubernetes Engine(GKE)、Vertex AI以及Pytorch、JAX和TensorFlow等主流框架集成,因此您可以通过易于使用且熟悉的界面开始。我们还非常高兴地宣布,基于NVIDIA H100 GPU的A3 VMs将作为GPU超级计算机于下个月正式推出,为您的大规模AI模型提供动力。

TPU v5e:性能与成本效益的完美平衡点

Cloud TPU v5e旨在为中大规模训练和推理提供所需的成本效益和性能。与Cloud TPU v4相比,TPU v5e每美元的训练性能提高了高达2倍,每美元的推理性能提高了高达2.5倍,适用于LLMs和生成式AI模型。在不到TPU v4一半的成本下,TPU v5e使更多组织能够训练和部署更大、更复杂的AI模型。

而且为了获得这些成本效益,您并不需要牺牲性能或灵活性:我们通过TPU v5e Pod在性能、灵活性和效率之间取得平衡,每个Pod最多可以连接256个芯片,聚合带宽超过400 Tb/s,提供100 petaOps的INT8性能。TPU v5e也非常灵活,支持八种不同的虚拟机(VM)配置,从一个芯片到一个切片内的250多个芯片。这使客户可以选择适合各种LLM和生成式AI模型大小的配置。

“Cloud TPU v5e在运行我们的生产ASR模型推理时,每美元提供的性能比市场上其他类似解决方案高出多达4倍。谷歌云的软件堆栈非常适用于生产型AI工作负载,我们能够充分利用专为运行高级深度学习模型而构建的TPU v5e硬件,这种强大的硬件和软件的组合极大地加速了我们向客户提供经济实惠的AI解决方案的能力。” — Domenic Donato,技术副总裁,AssemblyAI

我们的速度基准测试显示,当在Google Cloud TPU v5e上进行训练和运行AI模型时,速度提升了5倍。我们还在推理指标的规模方面取得了巨大的改进,我们现在能够在一秒钟的实时时间内处理1000秒的数据,用于内部语音转文本和情感预测模型 — 这是提高了6倍。” — Wonkyum Lee,机器学习负责人,Gridspace

TPU v5e:易用、多功能和可扩展

在过去,通过扩展基础设施编排大规模的AI工作负载通常需要手动处理故障、日志记录、监控和其他基本操作。如今,我们正在通过在业内拥有最具可扩展性的领先Kubernetes服务之一的GKE中普遍提供Cloud TPU,使操作TPU变得更加简单。现在,客户可以通过借助GKE来管理Cloud TPU v5e以及Cloud TPU v4上的大规模AI工作负载编排,从而提高AI开发的生产效率。

而对于更青睐托管服务简便性的组织,Vertex AI目前也支持使用Cloud TPU VMs进行多种框架和库的训练。

Cloud TPU v5e还为领先的AI框架(如JAX、PyTorch和TensorFlow)提供了内置支持,同时还支持Hugging Face的Transformers和Accelerate、PyTorch Lightning和Ray等受欢迎的开源工具。今天,我们很高兴地分享,我们将在即将发布的PyTorch/XLA 2.1版本中进一步加强对PyTorch的支持,其中包括Cloud TPU v5e支持,以及用于大规模模型训练的模型和数据并行等新功能。

最后,为了更轻松地扩展训练作业,我们正在引入Multislice技术,该技术允许用户轻松将AI模型扩展到超出物理TPU Pod边界的范围,高达数万个Cloud TPU v5e或TPU v4芯片。迄今为止,使用TPU的训练作业仅限于一个TPU芯片切片,最大切片大小为TPU v4的3072个芯片。借助Multislice,开发人员可以在单个Pod内通过芯片间互连(ICI)将工作负载扩展到数万个芯片,或者在数据中心网络(DCN)上跨多个Pod进行扩展。Multislice技术支持了我们先进的PaLM模型的创建;现在,我们很高兴将这一创新技术提供给谷歌云客户。

“对于我们的开发团队来说,其中一个最令人兴奋的特性是统一工具集。通过不再需要使不同的工具相互匹配,他们可以避免浪费时间和麻烦,从而简化将AI从构思到训练再到部署的流程。例如,将AI模型配置和部署到Google Kubernetes Engine和Google Compute Engine以及Google Cloud TPU基础设施上,使我们的团队可以在大规模上加速最新基础模型的训练和推断,同时享受自动缩放、工作负载编排和自动升级的支持。” — Yoav HaCohen,核心生成AI团队负责人,LightricksA3虚拟机:为生成式AI工作负载提供强大的GPU超级计算能力

为了使客户能够充分利用快速进步的人工智能,谷歌云与NVIDIA紧密合作,提供新的AI云基础设施,开发针对NVIDIA GPU的尖端开源工具,并构建专门为生成式AI设计的负载优化的端到端解决方案。谷歌云与NVIDIA共同致力于使AI更加适用于广泛的工作负载,并且这一愿景正在得以实现。例如,今年早些时候,谷歌云成为第一个提供NVIDIA L4 Tensor Core GPU的云提供商,推出了G2虚拟机。

今天,我们非常高兴地宣布,A3虚拟机将于下个月正式推出。A3虚拟机由NVIDIA的H100 Tensor Core GPU提供动力,该GPU配备了Transformer引擎,用于处理万亿参数模型。A3虚拟机是专为训练和服务特别苛刻的生成式AI工作负载和LLMs而构建的。将NVIDIA GPU与谷歌云的领先基础设施技术相结合,可以提供大规模和高性能,这是在超级计算能力方面的一大飞跃,比上一代产品的训练速度快3倍,网络带宽大10倍。A3还可以实现大规模操作,用户可以将模型扩展到数万个NVIDIA H100 GPU。

A3虚拟机配备了双路下一代第四代英特尔至强可扩展处理器,每个虚拟机配备八个NVIDIA H100 GPU,以及2TB的主机内存。基于最新的NVIDIA HGX H100平台构建,A3虚拟机通过第四代NVIDIA NVLink技术在八个GPU之间提供3.6 TB/s的双向带宽。A3网络带宽的改进得益于我们的钛网络适配器和NVIDIA Collective Communications Library(NCCL)的优化。总之,A3为希望构建最先进的AI模型的创新者和企业提供了巨大的提升。

"Midjourney是一个独立的研究实验室,探索新的思维媒介,扩展人类物种的想象力。我们的平台由谷歌云的最新G2和A3 GPU提供动力。G2相比T4的效率提高了15%,而A3的生成速度比A100快2倍。这使我们的用户能够在探索和创造时保持流畅状态。" — David Holz,创始人兼首席执行官,Midjourney

谷歌云AI基础设施的灵活性选择

在处理AI工作负载时,没有一种大小适用于所有情况——像Anthropic、Character.AI和Midjourney这样的创新客户不仅要求改进性能、价格、规模和易用性,还需要能够灵活选择为其工作负载精确优化的基础设施。因此,与我们的行业硬件合作伙伴(如NVIDIA、Intel、AMD、Arm等)合作,我们为客户提供了一系列在TPUs、GPUs和CPUs上进行训练和服务计算密集型模型的AI优化计算选项。

“Anthropic是一家专注于构建可靠、可解释和可控AI系统的AI安全和研究公司。我们很高兴与谷歌云合作,一直在协作高效地训练、部署和分享我们的模型。通过Google Kubernetes Engine(GKE),我们能够大规模运行和优化GPU和TPU基础设施,而Vertex AI将使我们能够通过Vertex AI Model Garden将模型分发给客户。搭载A3和TPU v5e与Multislice的谷歌下一代AI基础设施将为我们的工作负载带来价格性能优势,我们将继续构建下一波AI的发展。” — Tom Brown,联合创始人,Anthropic

参考链接:

https://cloud.google.com/blog/products/compute/announcing-cloud-tpu-v5e-and-a3-gpus-in-ga

相关阅读:

TPU演进十年:Google的十大经验教训

最新最全 2020 云状态报告「69页PDF下载」

RightScale 2019年云状况调查报告:35% 的云支出被浪费「附50页PDF下载」

更多文章请关注

文章好看点这里[在看]👇