AGI 该如何划分,谷歌 DeepMind 给出了标准。

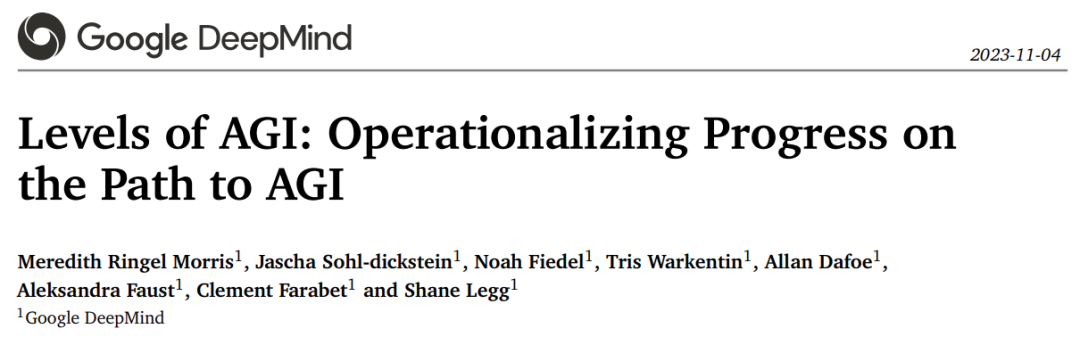

我们到底该如何定义 AGI(通用人工智能)?如果你要求 100 位 AI 专家进行解答,你可能会得到 100 个相关但不同的定义。现阶段,AGI 是 AI 研究中一个重要且存在争议的概念,有研究者认为 AGI 已经出现在最新一代大语言模型(LLM)中;还有一些人预测人工智能将在大约十年内超越人类,甚至断言当前的 LLM 就是 AGI。深入理解 AGI 的概念很重要,因为它映射了人工智能所要达到的目标、对事物的预测以及带来的风险。我们该如何划分 AGI 等级呢?就像自动驾驶等级(如 L0 无自动驾驶)一样,这种级别的划分对人与人之间的沟通能力、制定规则和定义自动驾驶目标非常有用。本文,来自 Google DeepMind 的研究者提出了类似的 AGI 等级,根据划分原则,ChatGPT 被划分为 L1 Emerging AGI,Imagen 是 L3 Expert Narrow AI,AlphaGo 被划分为 L4 Virtuouso Narrow AI。具体而言,他们提出了一个框架,用于对 AGI 模型进行分类。Google DeepMind 希望这个框架能够以类似于自动驾驶水平的方式发挥作用,从而提供一种通用语言来比较模型、评估风险和衡量 AGI 的进展。 为了开发这个框架,DeepMind 对 AGI 的现有定义进行了分析,并提炼出了六个原则:在这些原则的基础之上,DeepMind 从性能和通用性两个维度提出了「AGI 等级(Levels of AGI)」。- Level 0:无 AI(No AI),如 Amazon Mechanical Turk;

- Level 1: 涌现(Emerging),与不熟练的人类相当或比之更好, 如 ChatGPT、Bard、Llama 2 ;

- Level 2: 有能力(Competent),达到 50% 的人类水平,广泛任务上还没实现;

- Level 3: 专家(Expert),到达 90% 的人类水平,广泛任务上还没实现, Imagen、Dall-E 2 在特定任务上已经实现;

- Level 4: 大师(Virtuoso) ,达到 99% 的人类水平,在广泛任务上还没实现,Deep Blue 、AlphaGo 在特定任务上已经实现;

- Level 5: 超人类(Superhuman),胜过 100% 人类,广泛任务上还没实现,在一些任务范围内,AlphaFold 、AlphaZero 、 StockFish 已经实现。

论文地址:https://arxiv.org/pdf/2311.02462.pdf DeepMind 认为,AGI 的任何定义都应满足以下六个标准: 1. 关注模型能力,而不是过程。这一原则可以帮助我们排除一些不一定是实现 AGI 的必备条件。比如实现 AGI 并不意味着系统以类似人类的方式进行思考或理解;又比如实现 AGI 并不意味着系统拥有诸如意识(主观意识)或感知力(有感情的能力)等属性。2. 关注通用性和性能。所有定义都不同程度地强调了通用性,但有些定义排除了性能标准。DeepMind 认为通用性和性能都是 AGI 的关键组成部分。3. 关注认知和元认知任务。是否需要具身智能作为 AGI 的标准是一个有争议的问题。大多数定义侧重于认知任务,即非物理任务。尽管机器人技术最近取得了进展,但人工智能系统的物理能力似乎落后于非物理能力。DeepMind 认为执行物理任务的能力可以增加系统的通用性,但不应被视为实现 AGI 的必要先决条件。另一方面,元认知能力(例如学习新任务的能力或知道何时向人类寻求澄清或帮助的能力)是系统实现通用性的关键先决条件。4. 关注潜能,而不是部署。假如我们证明了一个系统可以在给定的性能水平上执行一组必要的任务,那么就足以声明该系统是 AGI,然而部署这样的系统不应该被视为是 AGI 固有的。要求将可部署能力作为衡量 AGI 的必要条件会带来非技术障碍,例如需要考虑法律和社会责任,以及潜在的道德和安全问题。5. 关注生态有效性。用来衡量 AGI 进展的 benchmark 非常重要,虽然传统的 AI 指标非常容易自动化或量化,但可能无法获得人们在 AGI 中看重的技能。6. 关注 AGI 发展之路,而不是只关心终点。本文认为定义 AGI 等级是有价值的。将 AGI 的每个等级与一组清晰的指标 / 基准相关联非常有意义。根据原则 2 和原则 6,表 1 引入了一个矩阵式分级系统,该系统将性能和通用性作为 AGI 的核心维度:

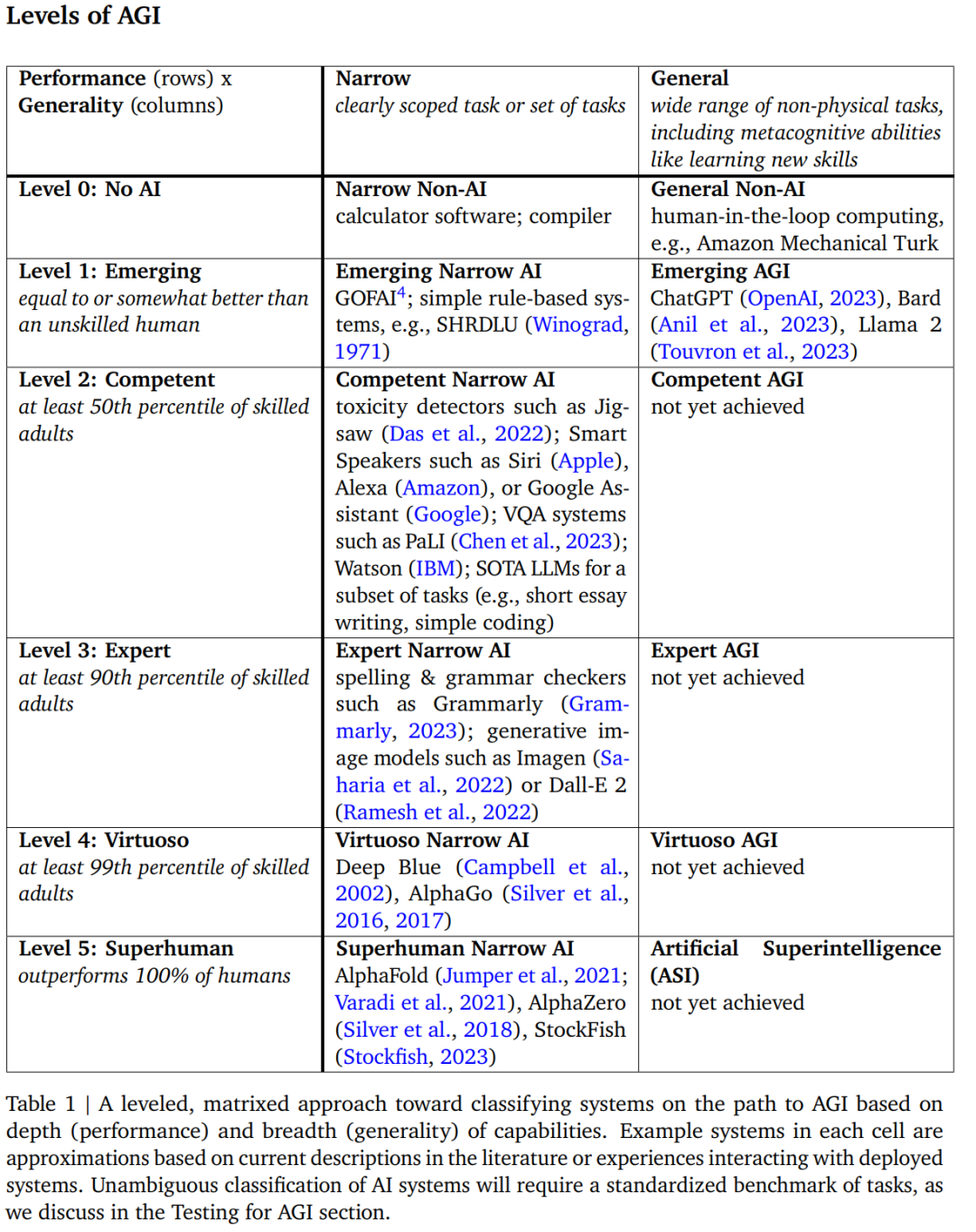

DeepMind 认为,当前的前沿语言模型应被视为 Level 1 General AI(Emerging AGI)。而下一等级 Level 2 General AI,即 Competent AGI,需要在更广泛任务集上提高性能才能达到。在 Level 3 Narrow AI,即 Expert Narrow AI 等级中,大家熟知的 DALLE-2 被划分为这一等级。之所以这样划分,DeepMind 表示 DALLE-2 生成的图像质量比大多数人类能够绘制的图像质量都高。在矩阵分级系统中,AGI 的最高等级是 ASI (Artificial Superintelligence),即把「超人类」的表现定义为超越 100% 的人类。举例来说,假设 AlphaFold 是 Level 5 Narrow AI (Superhuman Narrow AI),因为它执行单一任务高于世界顶尖科学家水平。这一定义意味着 ASI 系统将能够以人类无法比拟的水平完成广泛的任务。此外,这一框架还意味着超人类系统或许能够比较低级别的 AGI 执行更广泛的任务,例如,ASI 系统可能拥有人类所没有的技能,如通过分析大脑信号来解码人类思想,通过分析大脑信号来解码思想机制,又或者与动物交流。接着文章又讨论了 AI 风险。表 2 说明了 AGI 等级、自主等级和风险之间的相互作用。表 2 还提供了六个自主等级的具体示例。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com