专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

我们经常会看到在介绍大语言、扩散等模型时,会在后面或前缀加上100亿、500亿、2000亿等各种参数,你可能会纳闷这到底是个啥呀,是体积大小、内存上限、还是使用权限?

在ChatGPT发布一周年的日子,「AIGC开放社区」用通俗易懂的方式为大家介绍一下这个参数的含义。由于OpenAI没有公布GPT-4的详细参数,我们就用GPT-3的1750亿来说说。

OpenAI曾在2020年5月28日发布了一份名为《Language

Models are Few-Shot Learners》的论文,就是GPT-3,对模型的参数、架构、功能进行了详细的阐述。

论文地址:https://arxiv.org/abs/2005.14165

大模型的参数含义

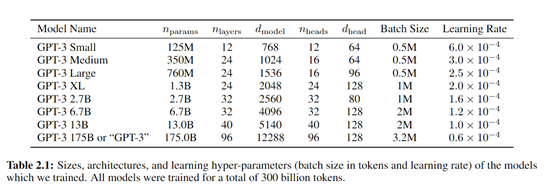

按照该论文的说法,GPT-3的参数达到了1750亿,而GPT-2只有15亿,整整提升了100多倍。

参数的大幅度提升主要体现在存储、学习、记忆、理解、生成等能力全面得到增强,这也是为什么ChatGPT可以无所无能。

所以,大模型中的参数通常指的是模型内部用于存储知识和学习能力的数值。这些参数可以被看作是模型的“记忆细胞”,它们决定了模型如何处理输入的数据、如何做出预测和生成文本等。

在神经网络模型中,这些参数主要是权重和偏置,在训练过程中通过不断的迭代来优化。权重控制着输入数据之间的相互影响,而偏置则是添加到最终计算中以调整输出的数值。

权重是神经网络中的核心参数,它们表示输入特征与输出之间的关系强度或重要性。在网络层之间的每个连接上都有一个权重,决定了一个节点(神经元)的输入在计算下一个层的节点输出时的影响程度。

偏置则是另一种类型的网络参数,它们通常与每个节点的输出相加以引入一个偏移量,使得激活函数能够在零附近有更好的动态范围,从而改善和调整节点的激活水平。

简单来说,可以把GPT-3看作是一间超级大办公室的助理,里面有1750亿个抽屉(参数),每个抽屉里都放着一些特定的信息,包括单词、短语、语法规则、断句原则等。

当你向ChatGPT提问时,例如,帮我生成一个用于社交平台的鞋子营销文案。GPT-3这个助理就会去装有营销、文案、鞋子等抽屉中去提取信息,然后按照你的文本要求进行排列组合重新生成。

在预训练过的程中,GPT-3会像人类一样阅读大量的文本来学习各种语言和叙述结构。

每当它读到新信息或尝试生成新的文本方法时,都会打开这些抽屉查看里面的信息,并尝试找出最好的信息组合来回答问题或生成连贯的文本。

当GPT-3在某些任务上表现得不够好时,会根据需要调整抽屉里的信息(更新参数),以便下次能做得更好。

所以,每个参数都是模型在特定任务上的一个小决策点。更大的参数意味着模型可以有更多的决策能力和更细致的控制力,同时可以捕捉到语言中更复杂的模式和细节。

模型的参数越高,性能就一定越好吗

从性能上来看,对于ChatGPT等大型语言模型而言,参数量多通常意味着模型有更强的学习、理解、生成、控制等能力。

但随着参数的增大,也会出现算力成本高,边际效应递减,过拟合等问题,尤其是对于没有开发能力、算力资源的中小企业和个人开发者来说非常困难。

更高的算力消耗:参数越大,所消耗的算力资源就越多。这意味着训练更大的模型需要更多的时间和更昂贵的硬件资源。

边际效应递减:随着模型规模的增长,从每个新增参数获得的性能提升越来越少。有时候,增加参数量并不能带来显著的性能改进,而是带来更多的运营成本负担。

优化困难:当模型的参数量极大时,它可能会遇到“维度的诅咒”,即模型变得如此复杂以至于很难找到优化的解决方案,甚至在某些区域出现性能退化。这一点在OpenAI的GPT-4模型上体现的非常明显。

推理延迟:参数量大的模型在执行推理时通常响应较慢,因为他们需要更多的时间找出更优的生成路径。相比GPT-3,GPT-4同样有这个问题。

所以,如果你是在本地部署大模型的中小型企业,可以选择那些通过高质量训练数据打造的参数小性能强的模型,例如,Meta发布的开源大语言模型Llama 2。

如果你没有本地资源希望在云端使用,那么就可以通过API使用OpenAI的最新模型GPT-4

Turbo、百度的文心大模型或者微软的Azure OpenAI等服务。

本文素材来源OpenAI论文、网络,如有侵权请联系删除

END

《遇见未来 发现AI视觉艺术》故事接龙AI短片大赛

《遇见未来 发现AI视觉艺术》故事接龙AI短片大赛