太牛了!

让大模型代理去阅读文章、论文;浏览网站;

回来你和大模型聊天

相当于秘书,回来给你汇报

源代码

http://www.gitpp.com/robotos/webllama

Webllama的概念太牛了

简单可以理解为一种智能代理,它可以在网络上浏览、收集信息,并与用户进行交互,类似于一个高效的秘书。通俗地说,Webllama能让一个大模型作为用户的代理去阅读文章、论文,浏览网站,然后与用户进行对话,向用户汇报所获取的信息。

关于该项目

WebLlama | 项目的目标是构建有效的以人为中心的代理来浏览网络。我们不想取代用户,而是为他们配备强大的助手。 |

|---|

| 造型 | 我们建立在最先进的库之上,用于培训 Llama 代理执行网络导航任务。我们将提供训练脚本、优化配置和训练尖端 Llamas 的说明。 |

| 评估 | 在现实世界的网页浏览中测试 Llama 模型的基准。这包括通过对话进行以人为中心的WebLINX浏览 ( ),并且我们很快将添加更多自动 Web 导航的基准(例如 Mind2Web)。 |

| 数据 | 我们的第一个模型针对超过 24K 个网络交互实例进行了微调,包括click、textinput、submit和对话行为。我们希望不断策划、编译和发布数据集,以训练更好的智能体。 |

| 部署 | 我们希望能够轻松地将 Llama 模型与现有部署平台(包括 Playwright、Selenium 和 BrowserGym)集成。我们目前正致力于将其变为现实。 |

造型

笔记

该模型可在 🤗 拥抱脸部模型中心以McGill-NLP/Llama-3-8B-Web.训练和评估数据可在Hugging Face Hub 上获取,格式为McGill-NLP/WebLINX。

我们的第一个代理是一个微调Meta-Llama-3-8B-Instruct模型,最近由 Meta GenAI 团队发布。我们在数据集上对该模型进行了微调WebLINX,该数据集包含超过 10 万个 Web 导航和对话实例,每个实例均由专家注释者收集和验证。我们使用 24K 精选子集来训练数据。

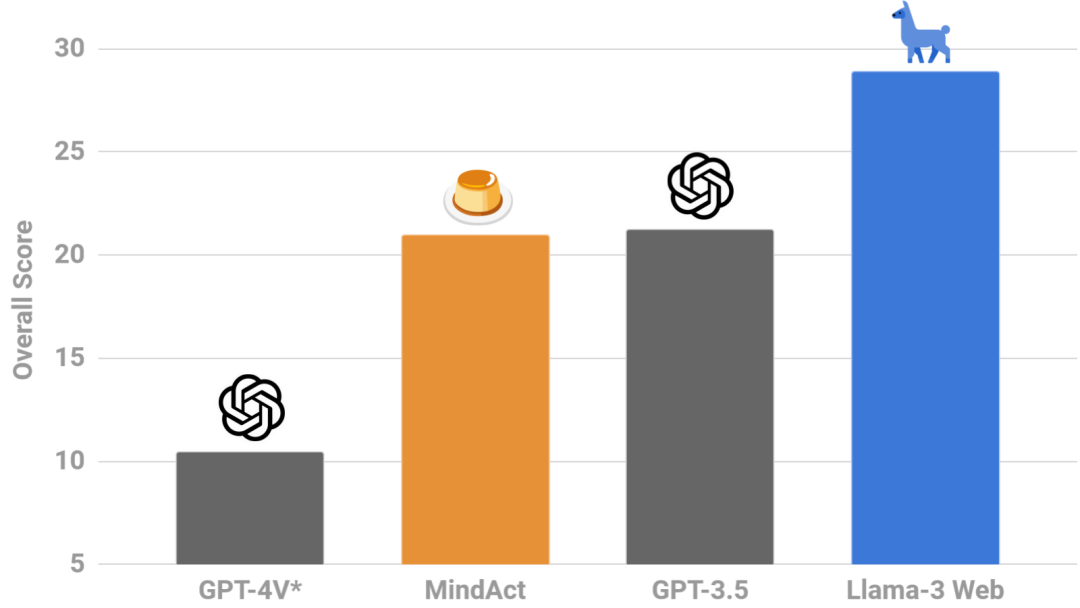

它在基准测试中超过了 GPT-4V(零样本*)超过 18%WebLINX,在域外测试分割上取得了 28.8% 的总分(而 GPT-4V 为 10.5%)。它选择更有用的链接(34.1% vs 18.9% seg-F1),点击更多相关元素(27.1% vs 13.6% IoU)并制定更一致的响应(37.5% vs 3.1%

chr-F1)。

以下是Webllama的一些特点和功能:

自动化浏览与收集:Webllama能够按照用户的指令,自动在网络上浏览和收集信息。这包括阅读文章、论文,浏览网站等。它可以根据用户的需求,针对性地搜索和整理相关信息。

理解与总结能力:Webllama不仅能收集信息,还能理解并总结所收集到的内容。这意味着它可以对浏览过的文章、论文或网站进行概括和提炼,为用户提供简洁明了的信息。

交互性:Webllama可以与用户进行自然的对话。用户可以通过与Webllama交流,获取所需的信息或解答疑问。这种交互方式使得信息获取变得更加便捷和高效。

个性化服务:Webllama可以根据用户的偏好和需求提供个性化的服务。例如,它可以根据用户的历史对话和反馈,逐渐了解用户的兴趣和需求,从而为用户推荐更加精准的内容。

总的来说,Webllama就像一个高效的秘书,能够帮助用户在网络上快速获取、整理和理解信息,提高用户的工作效率和信息获取能力。同时,通过自然的对话方式,Webllama也为用户提供了更加便捷和友好的交互体验。

然而,这样的技术也引发了一些问题和挑战,例如隐私保护、信息安全以及机器自动获取信息可能带来的版权问题等。因此,在使用这类技术时,需要谨慎对待并遵守相关法律法规。

让大模型代理去阅读文章、论文;浏览网站;

回来你和大模型聊天

相当于秘书,回来给你汇报

源代码

http://www.gitpp.com/robotos/webllama