GitHub Copilot的开源替代品终于来了!

它的名字叫Sage。这个由Storia-AI开发的项目,承诺只需两个命令就能让你与任何代码库畅聊。

Sage的核心功能就是让你能够与代码库进行对话。它的工作原理分为两步:

索引你的代码库:这需要一个嵌入器和向量存储。

启用LLM+RAG聊天:这需要访问一个大语言模型。

最令人兴奋的是,Sage提供了两种运行模式:

💻 本地运行模式

虽然质量可能稍逊,但胜在隐私性和低成本。这种模式下,Sage使用开源项目Marqo作为嵌入器和向量存储,使用Ollama来本地运行LLM。

☁️ 云端运行模式

如果你追求更高质量,可以选择使用外部提供商。Sage支持OpenAI或Voyage进行嵌入,使用Pinecone作为向量存储,支持NVIDIA、Voyage、Cohere和Jina进行重排序,并可以使用OpenAI或Anthropic的LLM进行聊天。

设置完成后,只需两个简单的命令就能开始使用:

sage-index $GITHUB_REPO

sage-chat $GITHUB_REPO

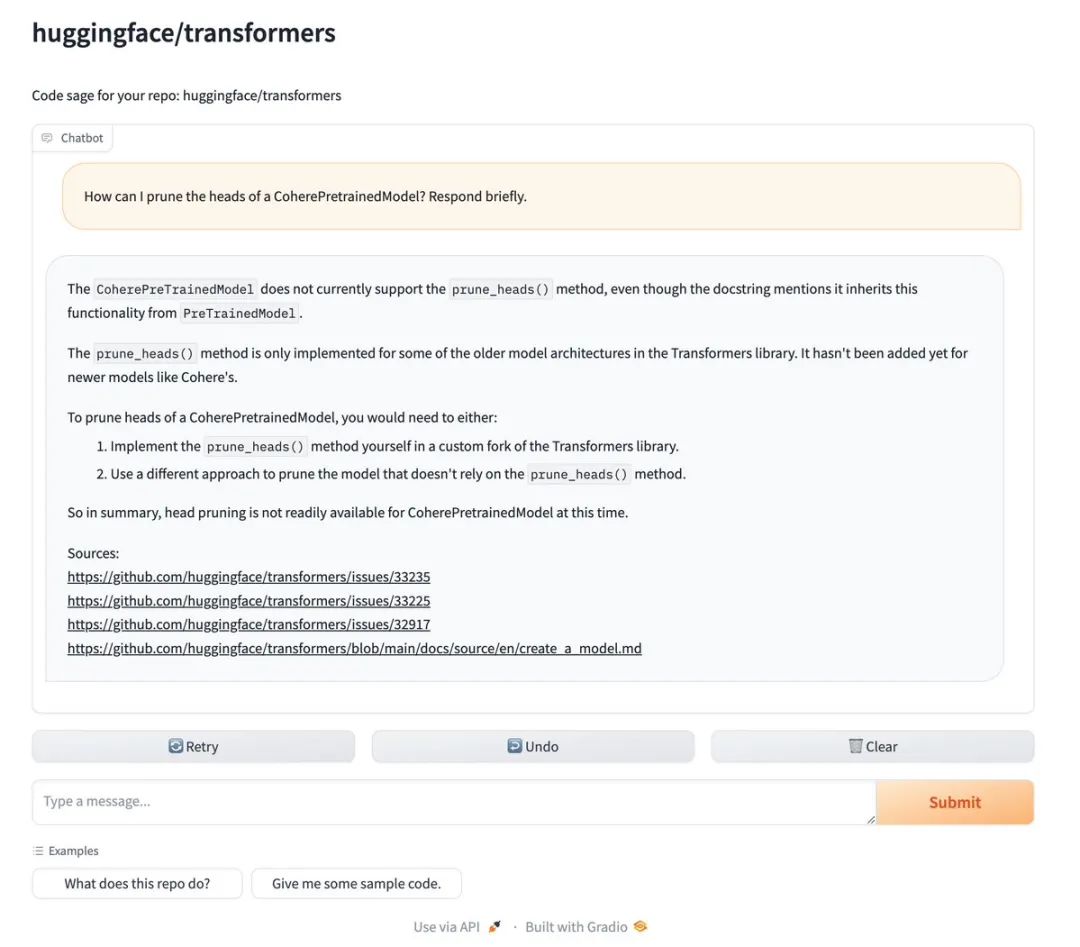

为什么要和代码库聊天?

有时候,你只是想了解一个代码库是如何工作的,以及如何集成它,而不想花几个小时翻阅代码。Sage就是为这种需求而生的。

它就像一个开源的GitHub Copilot,但拥有关于你的代码库的最新信息。无论是学习新项目还是快速解决问题,Sage都能成为你的得力助手。

但Sage的野心不止于此。它还提供了一些进阶功能:

支持私有仓库:只需设置GitHub Token即可。

自定义索引文件:可以精确控制哪些文件被索引。

索引GitHub Issues:可选是否包含评论。

实验性检索策略:包括混合RAG、多查询检索和纯LLM检索等。

Sage的创新之处在于,它完全颠覆了我们与代码库交互的方式。想象一下,你不再需要花费数小时翻阅代码,只需简单提问就能了解整个代码库的工作原理和集成方法。

更妙的是,Sage的开发团队还在积极探索各种检索策略,以提升系统质量。他们的实验结果显示,在某些情况下,仅基于文件名的LLM检索竟能达到与向量数据库相当的性能!

当然,Sage还在不断进化。最近的更新包括支持索引GitHub Issues,以及支持完全本地运行。

对于开源项目维护者来说,Storia-AI还提供了一个诱人的提议:他们正在努力让互联网上所有代码都变得可搜索和易理解。如果你想为自己的仓库申请一个专属的Sage页面(比如sage.storia.ai/your-repo),只需给他们发个邮件,他们会免费为你搞定!

Sage的出现为开发者提供了一个强大的工具,让代码理解变得前所未有的简单。它不仅仅是一个聊天工具,更是一个深度理解代码的助手。

代码地址:

https://github.com/Storia-AI/sage

那么,你准备好和你的代码库来场深入对话了吗?

👇

👇

👇

👇

本文同步自知识星球《AGI Hunt》

星球实时采集和监控推特、油管、discord、电报等平台的热点AI 内容,并基于数个资讯处理的 AI agent 挑选、审核、翻译、总结到星球中。

每天约监控6000 条消息,可节省约800+ 小时的阅读成本;

每天挖掘出10+ 热门的/新的 github 开源 AI 项目;

每天转译、点评 10+ 热门 arxiv AI 前沿论文。

星球非免费。定价99元/年,0.27元/天。(每+100人,+20元。元老福利~)

欢迎你的加入!