还在为AI助手不能理解你的语音而烦恼吗?

Mini-Omni 2来了,它不仅能听懂你说话,还能实时用语音回答你!这个全能型AI助手简直就是科幻电影里走出来的!

全能型AI助手是什么样的?

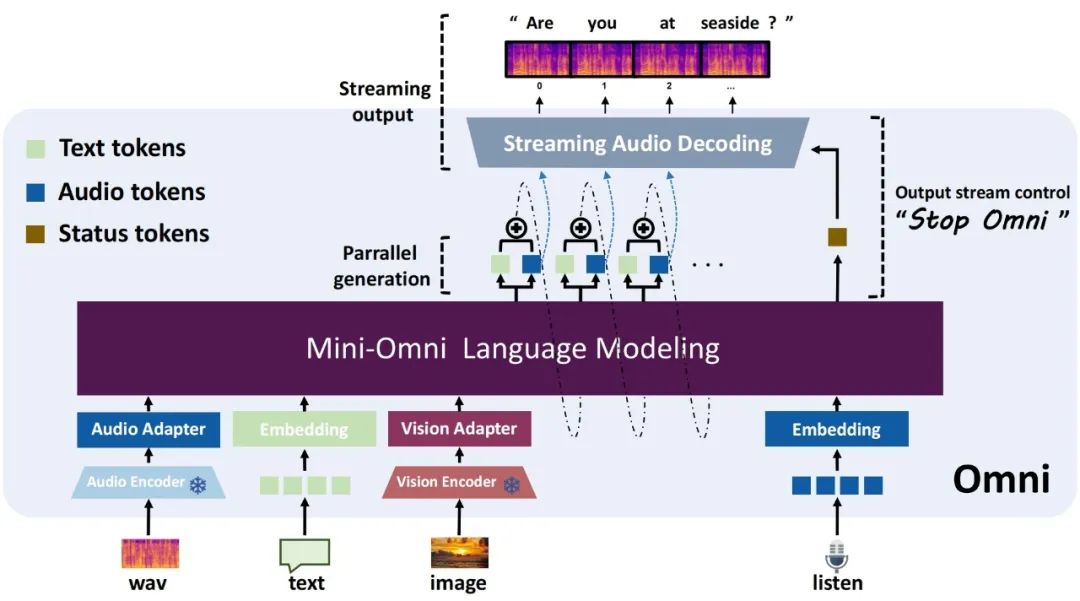

Mini-Omni 2 是一个全方位交互的模型,能够:

理解图像、音频和文本输入

与用户进行端到端的语音对话

实时生成语音回应

支持说话过程中的打断

这意味着什么?

简单来说,你可以像跟人类聊天一样和Mini-Omni 2交谈,给它看图片,它都能理解并用语音回答你。最厉害的是,它还支持实时打断,就像真人对话一样自然流畅!

技术大揭秘

那么,Mini-Omni 2是如何实现这些神奇功能的呢?

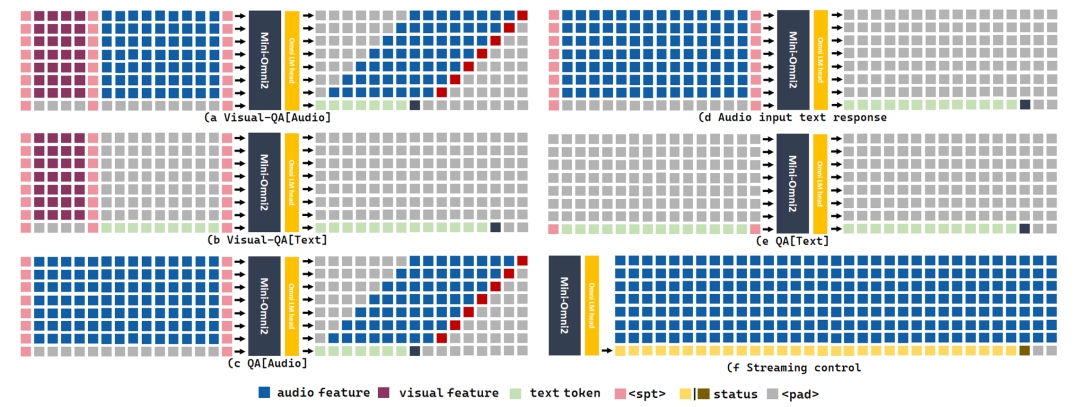

多模态建模:它将图像、音频和文本特征串联在一起作为输入,实现全面的任务处理。

实时语音输出:使用文本引导的延迟并行输出技术,生成实时语音回应。

多阶段训练:通过编码器适应、模态对齐和多模态微调三个阶段,实现高效的对齐训练。

最让人兴奋的是,Mini-Omni 2采用了MIT许可证,这意味着它是开源的!开发者们可以自由使用、修改和分发这个强大的模型。

快速上手指南

想要体验Mini-Omni 2的魔力吗?只需几个简单步骤:

创建新的conda环境并安装所需包

克隆项目仓库

启动服务器

运行Streamlit演示

注意:你需要在本地运行Streamlit,并确保安装了PyAudio。

如果你只想快速测试,可以直接运行预设的音频样本和问题:

python inference_vision.py

然后,你就能像电影《她》中那样,与AI助手进行自然、流畅的对话。无论是在工作中寻求帮助,还是在日常生活中寻找陪伴,Mini-Omni 2都可能成为你的得力助手。

地址:

https://huggingface.co/gpt-omni/mini-omni2

👇

👇

👇

👇

本文同步自知识星球《AGI Hunt》

星球实时采集和监控推特、油管、discord、电报等平台的热点AI 内容,并基于数个资讯处理的 AI agent 挑选、审核、翻译、总结到星球中。

每天约监控6000 条消息,可节省约800+ 小时的阅读成本;

每天挖掘出10+ 热门的/新的 github 开源 AI 项目;

每天转译、点评 10+ 热门 arxiv AI 前沿论文。

星球非免费。定价99元/年,0.27元/天。(每+100人,+20元。元老福利~)

欢迎你的加入!