源 | 互联网研究家 文 | 研究君

随着AI的爆发式增长,越来越多的人开始忧心忡忡,他们担心的主要有两点:

1)AI会比人类更聪明

2)AI不再需要人类控制,甚至会反过来接管地球

霍金就曾今在接受BBC采访时说:“人工智能的成熟之日,就是人类的毁灭之时。”马斯克也曾说,他觉得AI是人类面临的“最大的生存威胁”。

目前的AI,玩游戏已经比人类玩得溜了,不管是国际象棋,围棋,还是电子竞技游戏。所以说,无论是计算机时代前后的游戏,AI都赢过人类。

过去几年中,AI的“大跃进” 让不少人在惊叹的同时,也开始冒冷汗:AI会不会哪天就取代了人类?

在电影《终结者》里,天网是人类创造的一个防御网络,但最终获得自我意识并倒戈对抗。

听起来像科幻,但科幻小说里机器获得自我意识,并对抗人类的场景,层出不穷。

我们都知道《终结者》里的天网,挑战人类的人工智能超级电脑,在产生自我意识后,天网决定毁灭大多数人,剩下一部分当奴隶。

在黑客帝国中,超级智能机器也成为了人类的主宰。

而在有名的《黑客》三部曲中,超级智能机器也接管了世界,但它们没有毁灭人类,只是把人类当发电机:为了使用人脑产生的电,把人放在舱里,沉浸在游戏世界或者虚拟现实(矩阵)中。

而在电影《沙丘》中,一台电脑都没有,人类经过培训,自己做电脑的计算工作。而且,在奥兰治天主教圣经里有一条最重要的诫律:尔不得制造映象人意识的机器。

为什么?因为在遥远的过去(对于21世纪,算是遥远的未来),人类曾经是超级智能的阶下囚。巴特兰圣战中,人类反抗并击败了Omnius,一台几乎全知全能、拥有无数分身的机器。一朝被蛇咬,十年怕井绳,才有了这样一条诫律。

这类主题的科幻作品数不胜数,如果不是AI统治世界,就是机器人。美国军事科幻电视剧《星际大争霸》中,人类创造的机器人种族赛隆人,后来反叛并试图毁灭人类。最近描绘人类和机器人之间纠葛的的影视作品也不少,比如《西部世界》和《银翼杀手》。

我觉得,目前的AI想要这样一手遮天,把人类当奴隶和蝼蚁,能力水平还有点欠缺。

要完成杀戮和囚禁这样的任务,光是AI和机器学习方面的进步还远远不够,还需要其他计算软件和硬件领域都齐头并进。

另一方面,上述的领域确实也在快速进步,比如我们常听到的区块链、点对点技术、物联网、机器人和无人机。虽说AI统治世界道阻且长,但这些领域的迅猛发展,可以让噩梦成真的速度大大加快。

我们的世界需要具备什么样的条件,才会进入科幻作品中噩梦般的未来呢?这条危险又黑暗的道路,得经过几个里程碑。

AI想要统治世界,得通过几个关卡。如果技术进步到了一定程度,这些关都过了,我们就真的应该像霍金或者马斯克一样担心了。

以下我列出的并非所有的关卡,技术发展过程中可能还要面对其他难关,但是以下是AI强大路上必须攻克的问题。

以下列出的四个关卡没有先后次序。为了让读者能将这些问题具象化,我决定继续援引电影的例子,并与现有的软件和硬件相比较。

第一关:AI和机器学习的应用不够广泛

目前大多数AI能实现的任务很单一,很具体。我们的很多活动都有AI可以做:打游戏、开车、预测股市走势、交流、分析影像、做诊断,但是没有哪个AI可以同时完成多项任务。

AI的发展有好几个浪潮:现在的AI是第二波,数据驱动机器学习的人工智能,而第一波更倾向于启发式(指依据有限的知识和不完整的信息,在短时间内找到问题解决方案),未来的AI会结合以上两种方法和其他方法,变得更通用,应用更广泛。这个关卡会引发广泛的讨论:我们目前的AI和机器学习能走多远,现有的AI功能会广泛到什么程度。

第二关:AI控制物理世界的难易程度

我们目前的人工只能还只是服务器上运行的软件,不意味着它能意识到物理世界的存在,也接触不到武器,它不能控制机器人或者无人车,也不像《终结者》中的H-K机器人(天网的机器人士兵)。这个关卡会让我们联想到物联网,机器视觉和AI控制物理世界方面的问题。

第三关:关不掉的AI

某种程度上,这个关卡是我列出的4个中最重要的。只要人类没有走到关不掉AI的地步,就算AI不听话,开始谋反,我们手上好歹有个“开关”,不管是真的按下按钮关掉,还是需要毁掉有形的微处理器或者虚拟机软件。这个关卡引发的讨论主要在于:目前的AI都依附于某种形式的计算机技术,那区块链和点对点系统会不会就是某个关不掉的“天网”的前身?

第四关:具有自我意识、将保全自身视为首要任务的AI

这个关卡有点难定义。我们需要问自己几个问题:什么叫“有自我意识”?什么叫“将保全自身视为首要任务”?AI还有那些任务和“观念”?AI不一定会有生存的意愿,这个关卡更多讨论的是AI和价值观。

第一关:功能从具体到通用——AI发展的浪潮

我很确定,目前这一波基于机器学习的AI,比起第一波基于启发和规则的AI,确实是很大的进步,但是还不足以带我们走向黑暗未来。

我在MIT读计算机系的时候,有人告诉我AI方面的研究,一开始的目标是找到与人类思维相仿的“规则”和“符号表征”。但是人类能识别规则以外的模式,但计算机做不到,所以这个目标很难达到。后来出现了模糊逻辑的概念,其中的规则变得不那么“非黑即白”。在八十年代,日本的科学家甚至预测,十年内,AI就能和人脑一样执行多种任务了。

然而,三十年过去了,我们才刚看见一点进步。现有的AI和机器学习的爆炸式发展,功劳比较大的是数据,而非规则。它们依靠的是神经网络。神经网络是 一种模仿人脑神经网络行为的逻辑系统。这类AI的前提不是规则,而是通过数据训练,执行某一项具体的任务。有了数据,模型可以改变神经网络中某些连接的权重。虚拟神经元的层数越多,数据组越大,模型产生的结果就越精准。

这类型机器学习对于图像识别很有效果,能识别手写体、某些具体物品的图片等。有些计算机也通过机器学习,下棋能赢过棋王。

虽然我们一般认为反向传播神经网络算法很通用,但是目前的大多数AI还是只能执行特定的具体任务。

无人车依靠的是巨量的来自真实世界的数据集,并结合受训是使用的数据和驾驶规则。但是谷歌在测试无人车的时候,发现这样的操作有个大漏洞:无人车确实遵守规则了,但是周围车上的司机不守规则!比方说,很少有司机看到“停”的指示牌,就完全停下来,于是无人车就等司机完全停下。

科幻作品中的大多数AI都已经过了这一关。而目前现实中的AI还没有克服这个问题。一个通用型AI,应该能通过图灵测试。

通用型AI不仅能在任何应用中有作用,甚至能自主学习,了解到训练数据之外的新信息,并且无需人类的监控。

《星际迷航:下一代》中的机器人Data就是个通用型AI

《星际迷航:下一代》中的机器人Data就是个典型的通用型AI, 拥有正电子大脑。而AI本身并不都是会主动学习,不断进化的。

什么时候能打通第一关呢?这个问题我也没有答案,但是我们可以料想,通用型AI应该是在多项任务上都受过训练,然后在某些具体任务上受训。或许就在未来几年,人类会有小的突破。但是要有Data这样的通用型AI,估计还要有几十年。我们或许需要第三波超越简单规则和简单数据集的AI。

第二关 AI能轻易地操控物理世界

《X档案》第十一季第六集有这么个场景:剧中的世界与现实的技术水平相差无几,但是里面的AI却展现出将自己与物理时间联系起来的可能。

剧中,史考莉和穆德被AI追踪,而这个AI能控制他们身边环境中的一切,包括无人车、冰箱、亚马逊的无人送货飞机,还有餐厅的机器人厨师。

目前,即使是已经与硬件一体化的AI,比如无人车,对于物理世界的存在,意识还是有限的,他们能根据自己意识的范围来下命令。这个领域的进步离不开机器视觉的发展,依靠的是相机和影像,以及对影像的解读(街道标识、衣服、房屋以及人)。

这个关卡,AI需要接触物理世界,让人自然联想到有形体的机器人,但是终结者、复制人和西部世界中的机器人,离我们还很远。

现在,很多有形体的机器人,功能都很单一,只能实现特定的任务。在现代汽车制造厂中我们能看到很多这样的机器人,做的是把汽车抬起、移动、放下之类的动作。这类机器人对周围环境的感知是有限的,仅限于完成既定任务。

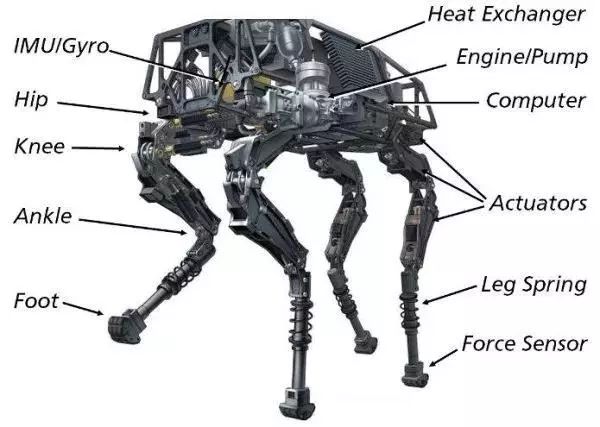

能与物理世界交流的机器人不一定要“人模人样”,波士顿动力公司(Boston Dynamics)

就出过一些造型奇异的机器人,看上去更像动物,移动速度极快。波士顿动力公司曾被谷歌收购,现在归日本软银集团所有。

波士顿动力公司的四足机器人“大狗”移动速度很快

自动无人机或许是目前对环境“感知”最强的AI。在终结者世界中,天网负责指挥美国所有军事行动,因为它展现出了人类飞行员无法企及的效率。

现在的军用无人机是远程操控的,操控人员可能在地球的另一头。对于无人机操作员而言,这个过程跟玩电子游戏差不多。而我也已经提到,AI在玩游戏方面已经比人玩得溜了。而AI和无人机操作这两个领域的结合迟早有一天会融合。在未来,我们会有可以定位并且武装的AI,可以自主行动,无需人类干预。

我们什么时候能克服第二关呢?一年又一年,我们离这个目标越来越近。我的猜测是,再过几年,最多十年,我们就会看到能通过机器视觉、机器学习,与物理世界产生联系的AI,它们经过训练,能够识别物理世界中的事物,并做决策。

AI什么时候会有获得武器的权限呢?普京已经公开说,拥有最强大AI的国家,就能统治世界。所以,估计不用等几十年,几年后,AI就能得到该权限了。

第三关 没有开关的AI

随着物联网和区块链的出现,要过这一关,难度有所增加。星际迷航:下一代中的机器人Data后脑勺上是有开关的。而且,Data允许皮卡尔上校和进取号上的船员在必要时,把它关掉。

在《终结者3》中,天网不在任何服务器上,也无法被关掉。

我再举一个科幻作品的例子,《终结者3:机器崛起》中,主角约翰康纳和终结者闯进了位于中国湖的控制中心,约翰希望能毁掉服务器。

他们进到控制中心之后,约翰意识到,仅仅摧毁服务器,是无法杀死天网的。

“天网出现自我意识之后,就把自己“扩散”到全球各地的几百万个服务器里。写字楼里的普通计算机,宿舍,到处都是天网的影子。天网成了网络世界的软件,没有系统核心,关不掉的。”

-约翰康纳, 终结者3

这才是天网让人胆战心惊之处——它已经成为了能在任何设备上运行、复制并传遍世界的软件,没那么容易,按下开关就消失。

随着物联网的发展,越来越多带处理器、能够运行软件的设备加入进来。在HBO剧集硅谷奇侠传第四季的末尾,团队需要保存一些数据,本来这些数据是储存在地下室的服务器上,但是地下室出了问题,于是他们的AI决定将数据发送到3万台智能冰箱里,这些冰箱都连了网,可以保存数据。

听起来很巧妙,观众很容易联想到,设备有了处理能力,能够储存数据,而世界各地的设备千千万万,手机、冰箱和其他设备之间也能够相互传输数据。

电脑病毒程序,它们被设计出来,目的就是复制和传播自己。电脑病毒本身也是连着硬件的。如果病毒和电脑程序与具体的硬件绑定在一起,我们就能通过摧毁硬件来毁灭软件。通常,电脑病毒是用C语言写的,然后后在操作系统和硬件上编译。

如果我们真的写出了像天网这样的程序,要有同等的破坏力,这个程序必须在全球多个设备上都能运行,不是简单的关闭某个操作系统就能一了百了。

然后,区块链出现了。区块链的构建信任的基础,就是通过世界各地多个去中心化、点对点的计算机,复制同一个数据集和代码。

比特币的背后就是这样的技术:核心代码是C语言写的,可以在不同的操作系统上编译。只不过这些代码的功能很具体,只是将比特币从一个地址发送到另一个地址。

而Vitalik Buterian之所以离开比特币开发团队,成立以太坊,就是因为他觉得比特币平台应该有更完善的程式语言,能够在成百上千,甚至几百万台计算机上运行,创造一个虚拟主机(VM),一台“世界计算机”。在上世纪90年代,这个想法就有了,当时的人们想的是用Java作为通用语,作为作为虚拟主机,可以在任何设备上运行。而现在,其他智能合约语言和项目纷纷出现,目的都是打破以太坊的局限。

目前,以太坊虚拟主机没有突破虚拟世界的权限。但随着新的跨区块链、知晓互联网存在的编程语言发挥越来越大的作用,这个领域就会出现越来越多的创新。也许未来会出现一个虚拟主机,能在世界各地任何计算机和设备上运行,不管它们装的是什么处理器。(某种程度上,这已经成为现实,但是物联网和手机配件方面仍有待提高。)

很多极客在看终结者系列电影时,都有一个疑问,“天网的编程语言是什么?” 我觉得应该是某种具有图灵完备性的语言(具有无限存储能力的通用物理机器或编程语言),能够在世界各处的设备上自动运行,同时,还能自我复制,复制出的每个版本都会走向同一个结论:毁灭全人类!

要想“杀死”这样一个程序网络,唯一的办法就是将运行这个程序的所有设备都毁掉。但是如果这个程序能在智能设备上自我复制,在智能冰箱、汽车等设备上运行,那“杀手AI”复制的速度,可能远远快过我们损毁这些设备的速度,这样,天网就有可趁之机了。

第四关:具有自我意识、并以自身生存为首要目的的AI

这一关可能是最难闯的一关,难就难在不好定义上。这个问题有两个部分。

就以电影《2001:太空史诗》这部电影为例,其中的计算机HAL 9000就出现违背命令的行为,当主人公Dave Bowman下关闭命令时,Hal就开始”叛变“,说出了有名的台词:”抱歉,Dave,命令无法执行。”

Hal不仅知道自己和Dave或者船体的一部分是独立的,它也将保全自身作为自己的首要目标,而不是保护舱内的人。我们分开看看这两个问题。

自我意识。图灵是现代计算机的先驱,他对图灵测试的定义是:如果人类不能判断跟自己交流的是不是一台机器(或程序),就算通过图灵测试。如果人类和某台机器交流(通过键盘或其他方式),无法判断对方是机器还是人类,那么其中的AI就算通过了图灵测试。但是,定义本身没有明说什么叫“无法判断”,也没有描述无法判断的情况。

那自我意识到底是什么呢?这个问题很难定义。我觉得,测试AI或者某个电脑程序有没有自我意识,看的是它们能不能将自己视做独立于计算机里其他软件、硬件和物理世界的个体。

对于AI而言,没有其他关于自我意识的测试了,但是或许我们应该设立更多此类的测试,清晰地定义AI有什么样的表现,人类有什么样的回应,什么样的互动过程能说明某个AI具有自我意识。或许我们能给这个测试取个名字,比如Hal9000测试或者天网测试。

要真正过这一关,我们需要突破表面层次的自我意识。大多数计算机某种程度上都知道自己和其他计算机之间是独立的。但是,这个“独立意识”仅仅是建立在不同的IP地址,或者不同操作系统上的区别。

我记得自己第一次思考自我意识问,那还是在我在MIT参加编程竞赛的时候。选手们都要写程序,这些程序之间将在同一台设备决斗,最后剩下的程序就是赢家。

当时我想的是找出一个用最少代码赢得竞赛的办法,一天大半夜里,我灵光一闪,想道“假如我的程序能改写自己和其他程序,这样只需两步,它就能赢得决斗。所以,我的程序要能意识到自己是个程序(自己的代码是什么),能够改写自己,然后改写对方程序的指令(使其无法继续)。

这样的”自我意识“当然是很有限的。要说有真正的自我意识,一个机器人或计算机至少要比较接近Hal,有“身份”感。

那超级智能呢?这难道不算一关?

牛津大学的教授Nick Bostrom是在人工智能方面进行学术研究的先驱。他从好几个方面探讨了机器人如何能比人类更聪明以及其影响。在流行科学中,我们常听到“奇点”这个术语,指的就是计算机智能超过人类的时刻(最早由 科幻作家Vernor Vinge提出)。

我觉得这可能是危险的未来更显黑暗,因为这可能是杀手AI统治世界的一个节点。虽说进阶的AI更善于保护自己,它应该也会意识到毁灭人类对于自己没有好处,因为计算机网络毕竟还是要有人维护的。

一个武术教练曾告诉我,如果你要和一个黑带的选手对打,宁可和四段的黑带对打,也不要跟刚拿到黑带的人对打。当时我很疑惑吗,两者不是都能伤人吗?

没错,段位更高的对手比较能控制自己,不小心下手太重的可能性会比较小。而刚拿到黑带的对手,破坏力不小,但不一定有同等的控制力和经验,会不会在对打过程中不小心伤人,还说不准。

如果一个AI“经验”不足,但意识到要保全自身,那它可能会因此得出要毁灭人类的结论。也有可能由于某个AI的用途问题, 比方说操纵无人机袭击的AI,“保全自身”就是这个AI的“人设”,是写进程序“基因”里的。这类AI或许只知道如何应对武器威胁,对于其他物体就不够智能化。

开启第四关:AI的价值观

AI有自我保全的观念吗?如果有的话,这样的观念是如何写进其程序中的呢?

阿西莫夫曾提出机器人三大定律:

第一、机器人不得伤害人类,或看到人类受到伤害而袖手旁观;

第二、在不违反第一定律的前提下,机器人必须绝对服从人类给与的任何命令;

第三、在不违反第一定律和第二定律的前提下,机器人必须尽力保护自己。

在阿西莫夫的作品中,这些法则就是机器人操作系统的基础。

那我们如何实现这3个定律呢?目前的AI不仅是受到代码的限制,而是经过数据集的训练。如果想让AI觉得人类值得保护,就得用有这方面特点的数据来训练它们,让它们得出这样的结论。

但是训练数据可能是有缺陷的。我最近和一家AI初创公司聊了一下,他们用的训练数据是放射和其他X射线影像。他们提到,训练数据中,提供给机器学习AI的数据集中,高达10%的数据是有缺陷的。如果训练数据集有缺陷,又怎么能确定这样训练出来的AI,给出的结果没有缺陷呢?

我们什么时候能过第四关?在人类设立自我意识测试之前,我无法给出确定的答案。但是有些AI已经写入这样的命令“如果看见人,就是用某种武器”。所以,可能几十年内,我们就能通过这个关卡。

确定AI的“价值观”可不是件易事。而且,在某种程度上,第四关是最让人头疼的。如果某个AI过了这一关,觉得保全自身是最重要的,那我们不担心也不行了。

另一方面,如果只是一个机器人有这样的想法,毁掉它很简单,要么关掉,要么物理损毁。而如果我们面对是像区块链这样点对点计算、可自我复制、并在多个设备商可以运行的代码,要毁灭它就会难得多。

本文中提出的想法,可能听起来不现实,要发生也只会在未来,虽然现在的AI不像终结者中的天网那样,有权限接触武器,但是未来我们可能会往同样的方向发展。

问题的关键,不在于前文中提及的某个关卡被突破,而是说,万一这些关卡某天都被突破,同时有人够聪明,把它们结合起来。如果我们通过了前三关,那AI出现价值观也是迟早的问题。这就会加速第四关被突破的速度,某个AI就有可能觉得保全自己比保全人类更重要。

那时,我们不害怕都不行了。

-END-

转载声明:本文转载自「互联网研究家」,搜索「hulwang2046」即可关注。