领域相关介绍

在自动驾驶领域,3D MOT扮演着重要角色整个感知系统中的关键任务,确保车辆导航和运动规划的高效和安全。随着自动驾驶技术越来越普及,并在城市智能交通系统中发挥越来越重要的作用,安全已成为首要问题。通过使用目标检测和多目标跟踪来更好地了解车辆周围环境,并了解和预测周围目标的轨迹,车辆可以更安全地驾驶。

自动驾驶感知系统通常分为两个重要任务:检测和跟踪。最近有一些端到端框架同时处理这两个部分,但这些方法的性能和稳定性仍在讨论中。在这一阶段,基于检测的跟踪仍然是3D MOT的主要方法,由于近年来3D目标检测算法(如PointRCNN、PointRGNN和CenterPoint)的巨大改进,跟踪结果也得到了极大改善。然而,这些结果的准确性仍然受到传感器本身特性的限制。在3D MOT中,通常使用激光雷达(光检测和测距)作为传感器来获取数据。然而,由于线束和距离的限制,激光雷达获得的点云在长距离(>80m)处通常非常稀疏,因此对象的尺寸或标签通常难以准确检测和定位。另一方面,由于摄像机的像素分辨率非常高,基于图像的检测可以获得高质量的检测结果,即使距离很长。此外,该阶段的2D检测器可以很好地解决遮挡问题。因此,研究基于传感器融合的3D MOT方法具有重要意义。

在3D MOT的这一阶段,存在各种挑战,例如:目标之间的遮挡和长距离丢失目标的问题。[10]中提出的多传感器融合方案可以在一定程度上解决这些问题。此外,合理的运动模型设计[11]也是一个很好的解决方案。3D MOT中的另一个挑战是如何在预测状态和观测数据之间关联数据;即,通过建立观测状态量和预测状态量之间的成本函数来找到它们之间的对应关系。大多数3D MOT框架倾向于使用3D框之间的联合交集(IoU)进行数据关联,这确实是一种简单有效的方法。然而,通过这样做,很容易忽略其他功能之间的连接,此外,可能会出现一些没有重叠区域的情况。因此,还提出了一些基于欧几里得距离[14]或马氏距离[13]的数据关联方法,结合匈牙利算法[15]或贪婪算法[16]。

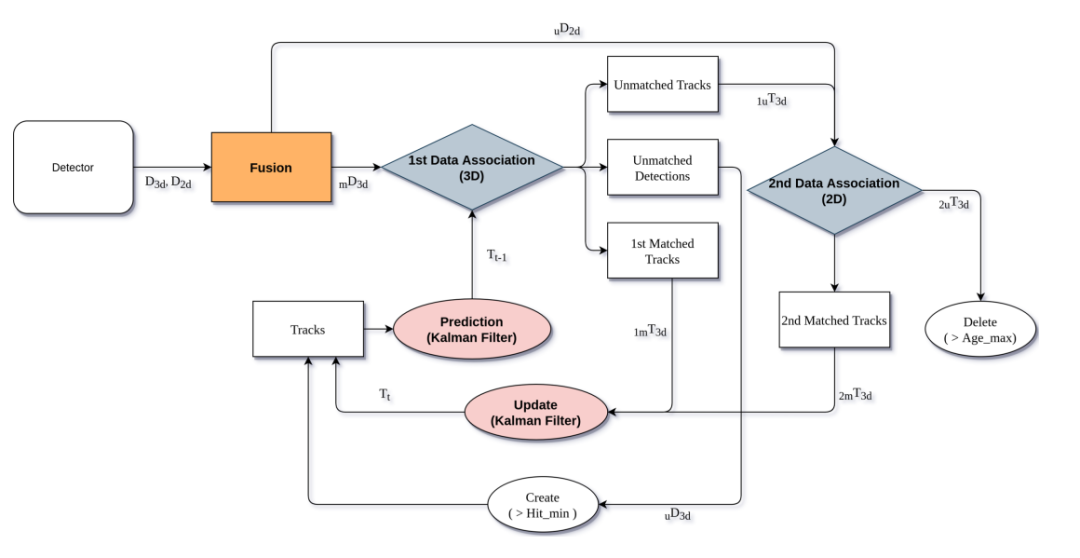

本文提出了一种基于传感器融合的加权几何距离数据关联3D MOT方法(WGDMOT)。具体而言,首先融合了激光雷达和摄像机的3D MOT检测结果,并使用加权几何距离作为数据关联方法。该方法以Avergemot为基线,首先使用透视投影将3D检测投影到2D图像平面上,然后使用2D IoU对2D和3D检测进行匹配和融合,以找到匹配良好的3D检测和不匹配的2D检测。最后,使用当前轨迹上的卡尔曼滤波器,使用先前轨迹获得预测的3D对象。使用论文提出的基于加权几何特征代价距离的数据关联方法在3D空间中匹配预测结果和匹配检测结果。然后,来自第一步骤的不成功预测成为2D图像平面中第二数据关联的第二步骤的输入,最后,基于数据关联结果更新状态。

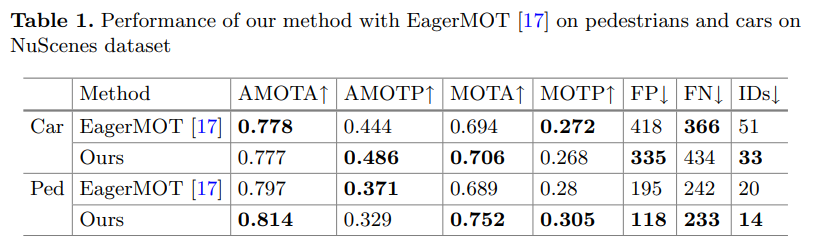

论文在NuScenes上进行性能评估,提出的方法显著提高了baseline EagerMOT(尤其是在行人跟踪上)!

2D和3D目标跟踪

2D跟踪任务

在这个阶段,2D MOT的大部分研究工作仍然集中在基于检测的跟踪,其中两个最重要的方面实际上是

检测和数据关联方法。一些方法的想法是寻找更好的检测器,基于RCNN家族、YOLO、SSD和RetinaNet等检测器,很明显,在不进行很大改变的情况下,可以超越许多以前的2D MOT方法。其它方法侧重于设计数据关联的鲁棒成本距离,如[27,28]使用匈牙利语进行数据关联,以及[16]使用贪婪算法。随着深度学习研究的进一步发展,研究人员也开始不仅仅关注单个检测,还有一些方法提出了端到端[19,29]方法,将检测和跟踪作为一个整体进行训练,然后输出结果。然而,鲁棒性和泛化仍在讨论中。

3D跟踪任务

大多第一批3D MOT方法基于传统的聚类检测方法,例如使用下采样、接地点分割和非接地点聚类。然而,这些方法非常容易受到噪声的影响,因为它们依赖于边界盒过程的计算来获得检测结果。此外,边界框的尺寸的精度和估计是非常真实的值,具有相对较大的误差。随着端到端检测方法[7,31]的出现及其有效性的不断提高,3D MOT的检测组件已逐渐被端到端方法取代。最近,[32]提出了一个非常简单的3D MOT框架,AB3DMOT[32],该框架使用3D IoU作为数据关联的成本距离,能够实现非常高的FPS。然而,该方法非常依赖于3D检测器的结果,并且容易被遮挡。随后,[33]提出使用马氏距离代替3D IoU作为基于AB3DMOT[32]的成本距离,从而解决了不存在重叠区域的情况。这是对AB3DMOT[32]的一个相对较大的改进,但仍然受到3D探测器的限制。由于单传感器检测总是存在相对较大的局限性,[17]分别提出了激光雷达和摄像机的融合方法,建议将预测轨迹和融合检测结果按比例距离关联起来。然而,马氏距离和标度距离都没有考虑不同变量之间的加权关系。因此,论文提出了一种新的代价距离,它考虑了不同几何特征之间的加权关系,可以有效地提高小目标的跟踪性能。

论文方法

论文提出了基于最近Eargemot[17]架构的WGFMOT方法。方法首先融合2D和3D检测的检测结果,然后基于融合结果和卡尔曼滤波器预测的结果执行两阶段数据关联。数据关联的第一阶段在3D空间上执行,其中论文建议使用加权几何特征作为数据关联的成本距离,第二阶段在2D图像平面上执行,使用投影变换和2D IoU进行二次匹配,最后更新跟踪轨迹。该方法能够充分利用相机和激光雷达的检测结果:

(1)相机可以提供比较的2D检测结果,从而减少3D检测中错误检测的机会;

(2) 激光雷达可以提供更精确的3D检测对象位置信息;

(3) 使用提出的加权几何特征距离,可以考虑不同几何特征之间的加权关系,以实现更好的跟踪性能;

论文使用centerpoint作为3D检测器!

融合通常分为前融合和后融合,其中前融合是使用不同传感器数据的组合作为输入,以便输出检测结果。在论文提出的方法中,使用了后融合,它融合了不同检测的结果。这种融合方法比前融合更简单、更有效,并且不需要对原始数据进行额外的变换。

如下图所示,基于来自截面A的检测结果D2d和D3d,首先将3D边界框投影到2D图像平面上。然后,计算用于匹配的2D IoU,并将匹配结果mD3d输出到第一数据关联部分,而将不匹配检测uD2d输出到第二数据关联部分。这样做部分解决了FP(假阳性)的问题,因为3D检测器比2D检测器更容易出现错误检测。

状态初始化和预测

MOT本质上是一个多变量状态估计问题,即预测通过使用前一个目标,确定当前阶段目标的状态和运动模型。为了简化论文的模型,建议使用常数速度模型(CA)和卡尔曼滤波器(KF)[34]预测状态St(xi,yi,zi,li,wi,hi,thetai,vxi,vyi,vzi)的三维对象。其中t表示第t帧,i表示该帧的第i个对象。

数据关联

论文提出的方法中,数据关联分为两个阶段。第一阶段是在3D空间中,使用提出的加权几何距离计算成本,第二阶段是在2D图像平面中,使用匈牙利算法的2D IoU。

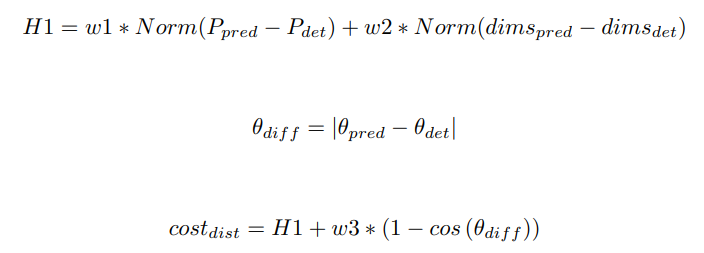

第一阶段,从步骤B获得融合检测结果mD3d,在步骤C中,获得预测结果P3d,为了合理计算匹配相关性,设计了用于计算检测和预测之间相似性的加权几何距离:

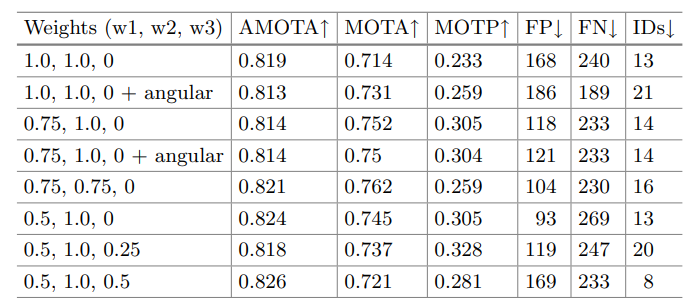

EagerMOT [17]提出的缩放距离考虑了dimensions和坐标具有相同的权重(重要性),但实际上不同跟踪的属性不同,因此dimensions和坐标应不能承受同等的权重。论文提出的成本距离通过调整w1、w2和w3的大小来调整它们的重要性,这导致小目标跟踪的显著改进。成本距离也优于基于3D IoU和基于欧几里得距离的方法。通过执行此步骤,论文获得了关联的检测和预测结果(Di3d,Tj3d),其被输入到更新阶段,以及没有关联的预测结果uT3d,其被输入数据关联的第二阶段:

第二阶段,未成功匹配的D2d在第一阶段中进一步与uT3d输出匹配,这通过使用简单的2D IoU和匈牙利算法将uT3d投影到2D图像平面上来执行。该过程主要用于对FN(假阴性)情况执行附加关联。该步骤可以解决部分遮挡导致的漏检情况,进一步提高跟踪的稳定性,匹配预测2mT3d被输出到更新阶段。

状态更新

给定由数据关联驱动的检测和预测的匹配对,可以使用卡尔曼滤波器来更新该帧中的轨迹,主要更新状态量为[x,y,z,θ,l,w,h,vx,vy,vz]。

实验评估

论文基于NuScenes评估了所提方法,NuScenes包含1000个场景,每个场景长20秒,并使用具有23个类和8个属性的3D边界框进行完整注释。数据集使用2Hz的频率对关键帧(图像、激光雷达)进行采样,并使用语义类别、属性(可见性、活动性和姿势)和矩形(包含x、y、z、宽度、长度、高度和偏航)为23个对象类别中的每一个对每个关键帧中的每个目标进行注释。

本文遵循NuScenes跟踪挑战,并通过以下指标评估:

AMOTA(平均多目标跟踪精度):主要评估指标(不同召回阈值下MOTA[35]指标的平均值)

AMOTP(平均多目标跟踪精度)

MOTA(多目标跟踪精度):这项措施结合了三个方面(误报、漏检目标和身份切换)

MOTP(多目标跟踪精度):注释边界框和预测边界框之间的未对齐

FP(误报数):误报总数

FN(假阴性数):假阴性(漏检)总数

ID(标识开关的数量):标识开关的总数

在行人追踪上加权几何距离加权系数的消融实验:

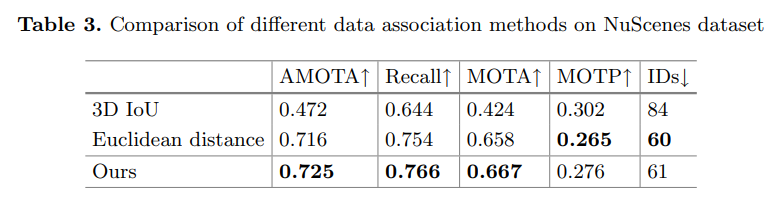

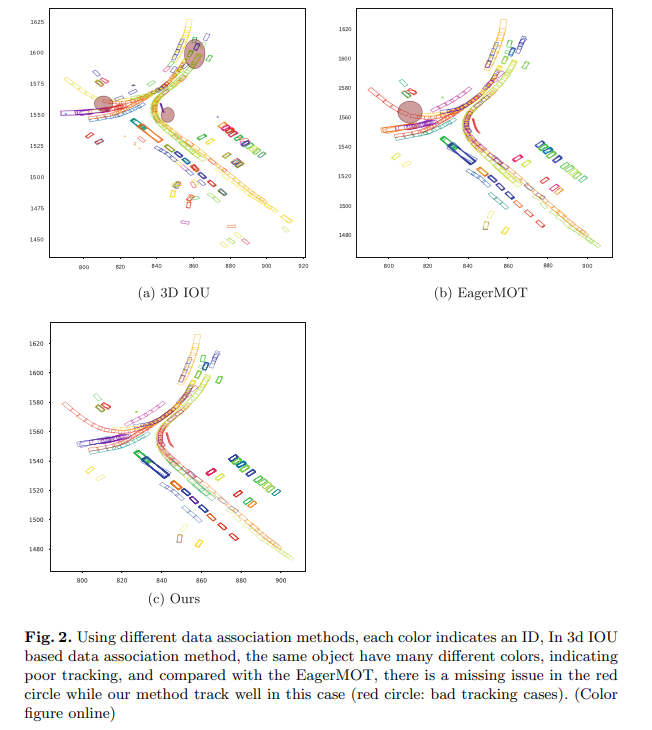

NuScenes数据集上不同数据关联方法的比较:

参考

[1] Sensor Fusion Based Weighted Geometric Distance Data Association Method for 3D Multi-object Tracking.