编辑 | 绿萝

根据麦肯锡(McKinsey)最近的一份报告,机器学习应用每年飙升至 1650 亿美元。但在机器能够执行诸如识别图像细节等智能任务之前,必须先对其进行训练。训练现代人工智能 (AI) 系统(如特斯拉的自动驾驶仪)需要数百万美元的电力消耗,并且需要类似超级计算机的基础设施。

这种激增的 AI 「需求」,使得计算机硬件与 AI 需求之间的差距越来越大。光子集成电路(或简称为光学芯片),已成为提供更高计算性能的可能解决方案。然而,尽管他们已经证明改进了用于数据分类的机器智能的核心操作,但光子芯片尚未改进实际的前端学习和机器训练过程。

来自来自乔治华盛顿大学、女王大学、不列颠哥伦比亚大学和普林斯顿大学的一个多机构研究团队开发了一种可以训练机器学习硬件的光学芯片。提出了由 CMOS 兼容的硅光子架构支持的神经网络片上训练,以利用大规模并行、高效和快速数据操作的潜力。该高效、超快的神经网络训练方法展示了光子学作为执行 AI 应用程序的有前途的平台。

该研究以「Silicon photonic architecture for training deep neural networks with direct feedback alignment」为题,于 2022 年 11 月 23 日发布在《Optica》上。

论文链接:https://doi.org/10.1364/OPTICA.475493受深度学习最新进展的推动,AI 和神经形态计算领域在过去十年中经历了复兴。随着摩尔定律接近饱和,并且随着对高级机器学习算法的需求呈指数级增长,神经形态计算作为标准电子技术的替代品重新引起了人们的兴趣数字计算机体系结构。

由于硅光子学与成熟的硅集成电路行业的兼容性以及高质量的绝缘体上硅(SOI)晶圆的可用性,它已被证明是发展神经形态系统的一个有前途的平台。与用于神经形态应用的电子对应物相比,光子系统具有低延迟、高带宽密度和波特率、低成本通信以及使用光复用的固有并行性。

机器学习的一个领域将受益于光子学带来的低功耗和高信息处理带宽,那就是大型神经网络的训练。目前,基于模拟硬件的神经网络主要是离线训练,使用在数字平台上实现的训练算法模拟系统,然后将优化的网络参数映射到硬件平台进行推断。然而,这些模型可能无法捕获物理神经元及其互连的所有制造缺陷和变化。此外,与原位训练相比,准确模拟物理系统所需的计算开销可能导致执行时间变慢。

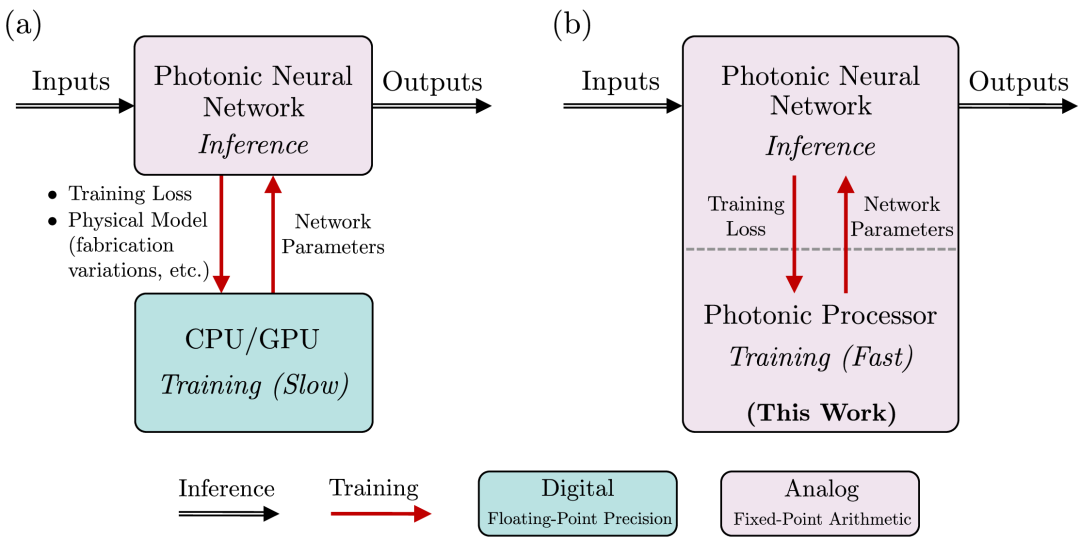

图 1:离线和原位训练光子神经网络。(来源:论文)最近提出的直接反馈对齐 (DFA) 监督学习算法作为流行的反向传播训练算法的生物合理替代方案引起了人们的兴趣。DFA 算法是一种监督学习算法,在反向传播过程中,通过固定的随机反馈连接将误差直接从输出层传播到隐藏层。该算法成为使用光子学进行高效并行化的合适候选者。

在这项工作中,研究人员提出了:(1)一种在片上实现训练算法 (DFA) 的硅光子架构;(2) 表明 DFA 非常适合光子实现,因为所有网络层都可以在反向传递期间并行更新;(3) 证明使用 DFA 进行的原位训练对噪声具有稳健性,因为固有地考虑了硬件的非理想性。

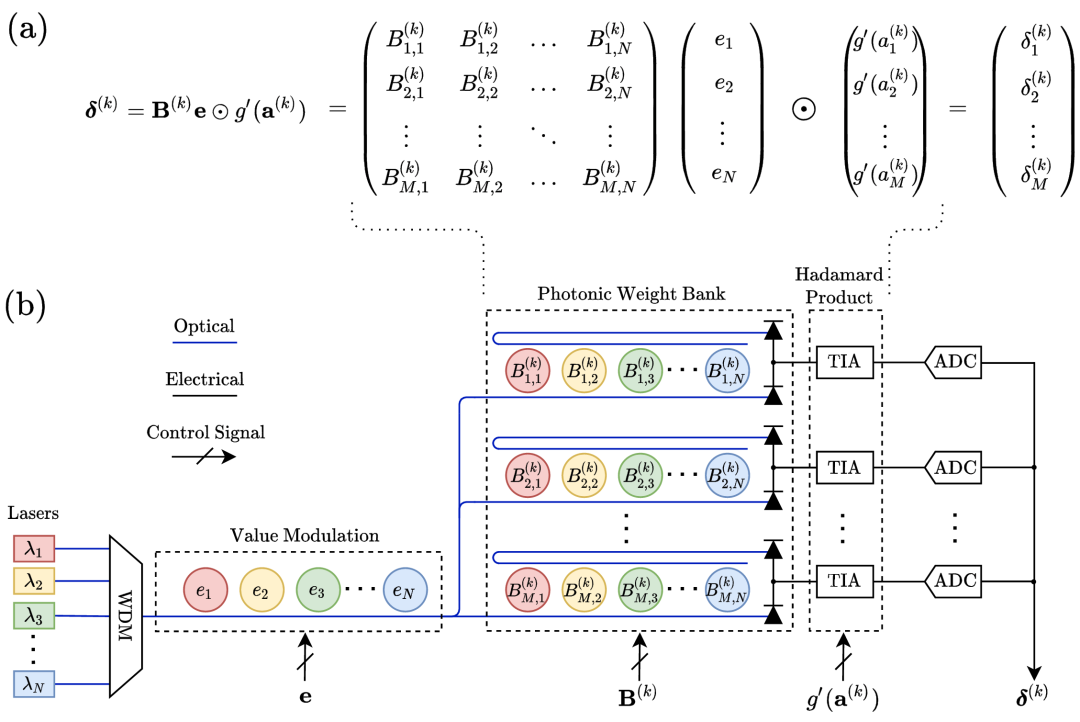

所提出的硅光子架构使用电光电路来原位计算每个隐藏层的梯度向量,这是在向后传递期间执行的计算量最大的操作。所提出的架构利用光子学的速度和能量优势来确定单个操作周期中每个隐藏层的梯度向量。本文的范围仅限于 DFA 算法反向传递的实现。在反向传播过程中,来自网络推理步骤的错误被编码在多通道光学输入上。然后电光电路计算每个隐藏层的梯度向量,用于使用外部数字控制系统更新存储在内存中的网络参数。

研究人员还演示了使用实验性片上结果在 MNIST 数据集上训练前馈神经网络来验证光子架构。

研究人员使用两个相似的电路(具有固有不同的噪声)进行了两组光子内积操作测量,以验证所提出的架构。然后,使用这些结果在 Python 模拟中的 MNIST 数据集上训练前馈神经网络。

图 4:使用具有不同特征噪声的两个光子电路在 MNIST 数据集上进行神经网络训练的实验演示。(来源:论文)片外光电探测电路实验内积运算的误差标准差为0.098(4.35位),均值为0.003,而集成 BPD 电路的标准差较大,为0.202(有效分辨率3.31位),平均值为 0.003。

使用片外和片上 BPD 电路的仿真分别实现了 97.41±0.15% 和 96.33±0.16% 的测试精度,而在没有注入噪声的情况下实现了 98.10±0.13% 的测试精度。

这些仿真结果表明 DFA 算法对噪声和低精度计算具有显著的稳健性。神经网络在推理和训练过程中对加性和乘性噪声失真的显著稳健性使模拟光子硬件成为执行原位训练的有前途的平台。

「这种新颖的硬件将加速机器学习系统的训练,并充分利用光子学和电子芯片所提供的优势。这是人工智能硬件加速的重大飞跃。正如最近通过的《芯片法案》(CHIPS Act)所强调的,这些都是我们在半导体行业所需要的进步。」乔治华盛顿大学电气和计算机工程教授、初创公司 Optelligence 的创始人 Volker Sorger 说。

「AI 系统的训练会消耗大量的能源和碳足迹。例如,单个 AI transformer 所消耗的二氧化碳大约是一辆汽油车一生消耗的五倍。我们在光子芯片上的训练将有助于减少这种开销。」女王大学物理系助理教授 Bhavin Shastri 补充道。

参考内容:https://techxplore.com/news/2022-11-optical-chip-machine-hardware.html

人工智能

× [ 生物 神经科学 数学 物理 材料 ]

「ScienceAI」关注人工智能与其他前沿技术及基础科学的交叉研究与融合发展。

欢迎关注标星,并点击右下角点赞和在看。

点击阅读原文,加入专业从业者社区,以获得更多交流合作机会及服务。