数学和物理是一对老朋友。长期以来,它们见证了技术发展的起落,包括计算尺、计算器和Wolfram Alpha等辅助工具。如今,随着机器学习的最新进展应用于解决数学和物理问题,这些进展提出了一个根本性的问题:让算法学会我们思考方式有何意义?

“计算机非常擅长数学,指的是它们很擅长解决非常具体的问题。”谷歌研究院的机器学习专家盖伊•古尔阿里(Guy Gur-Ari)说。计算机擅长运算,填入数字并计算是相对简单的。但在形式结构之外,计算机则举步维艰。解决数学文字问题或“定量推理”看起来比较棘手,因为它需要更为稳健和严密,而解决许多其他问题也许并不需要。虽然机器学习模型接受训练的数据越多,产生的错误越少,但对于定量推理,改进的程度却很有限。研究人员开始意识到,对于机器学习生成模型在解决语言文字问题时产生的错误,需要更有针对性的方法。2021年,来自加州大学伯克利分校和OpenAI的两个不同团队分别发布了MATH和GSM8K两个数据集,这两个数据集包含了涉及几何、代数和微积分基础等的数千个数学问题。“我们就是想要看看,数据集是否有问题。”在人工智能安全中心研究MATH的研究员史蒂文•巴萨特(Steven Basart)说。用格式更好的、更大的数据集进行训练,是否能够修复机器学习定量推理的错误?MATH团队发现,定量推理对最高级的机器学习语言模型也颇具挑战,其得分不到7%。(人类研究生的得分为40%,而国际数学奥林匹克竞赛冠军的得分为90%。)GSM8K数据集则是更简单的小学阶段问题,受训模型的准确率达到了约20%。为了实现这种准确率,OpenAI的研究人员使用了两种技术:精调和验证。在精调中,研究人员采用一个包含不相关信息的预训练语言模型,在训练中仅展示相关信息(数学问题);验证则允许模型重新审视其错误。当时,OpenAI预测,需要使用100倍的数据对模型进行训练,才能在GSM8K上达到80%的准确率。但2022年6月,谷歌的Minerva宣布,小规模扩大训练即可实现78%的准确率。OpenAI的机器学习专家卡尔·科布(Karl Cobbe)说:“这超出我们所有的预期。”巴萨特表示同意,他说:“这太令人震惊了,我还以为要花很长的时间。”Minerva使用了谷歌自己的通路语言模型(PaLM),根据来自arXiv的科学论文和其他来源进行格式化数学精调。此外,帮助Minerva的还有另外两个策略。在“思维链提示”中,要求Minerva将较大的问题分解为更容易接受的小问题。该模型还使用多数投票,而不是仅要它提供一个答案或将一个问题解算100次。在这些结果中,Minerva选出最常见的答案。这些新策略带来了巨大的好处。Minerva在MATH上实现了高达50%的准确率,在GSM8K上的准确率接近80%。在MMLU上也是这样,MMLU是一个包含化学和生物的STEM普通问题集。对问题略微调整后随机取样,让Minerva重新进行计算,其表现也很好,这表明,这个能力不仅源自记忆。关于数学,Minerva了解哪些、不了解哪些,是很模糊的。这与数学家使用的带有内置结构的“证明助手”不同,Minerva和其他语言模型没有形式结构。它们可能会产生奇怪、混乱的推理,但仍然可得出正确的答案。随着数字的增大,语言模型的准确度会下降,这对于可靠的老式TI-84 Plus计算器,是绝不会发生的。“它到底是聪明?还是不聪明?”科布问。虽然像Minerva一样的模型也许能够得出与人类一样的答案,但其遵循的实际过程可能完全不相同。另一方面,曾被要求“展示自己的作业”的学生都很熟悉“思维链提示”。谷歌研究院的机器学习专家伊桑•戴尔(Ethan Dyer)说:“我认为人们有这样一个概念,做数学的人有某种严格的推理系统,在已知和未知之间有明显的区别。”但人也可能得出不一致的答案、会犯错误和未能应用核心概念。在机器学习的这一前沿,边界是模糊的。

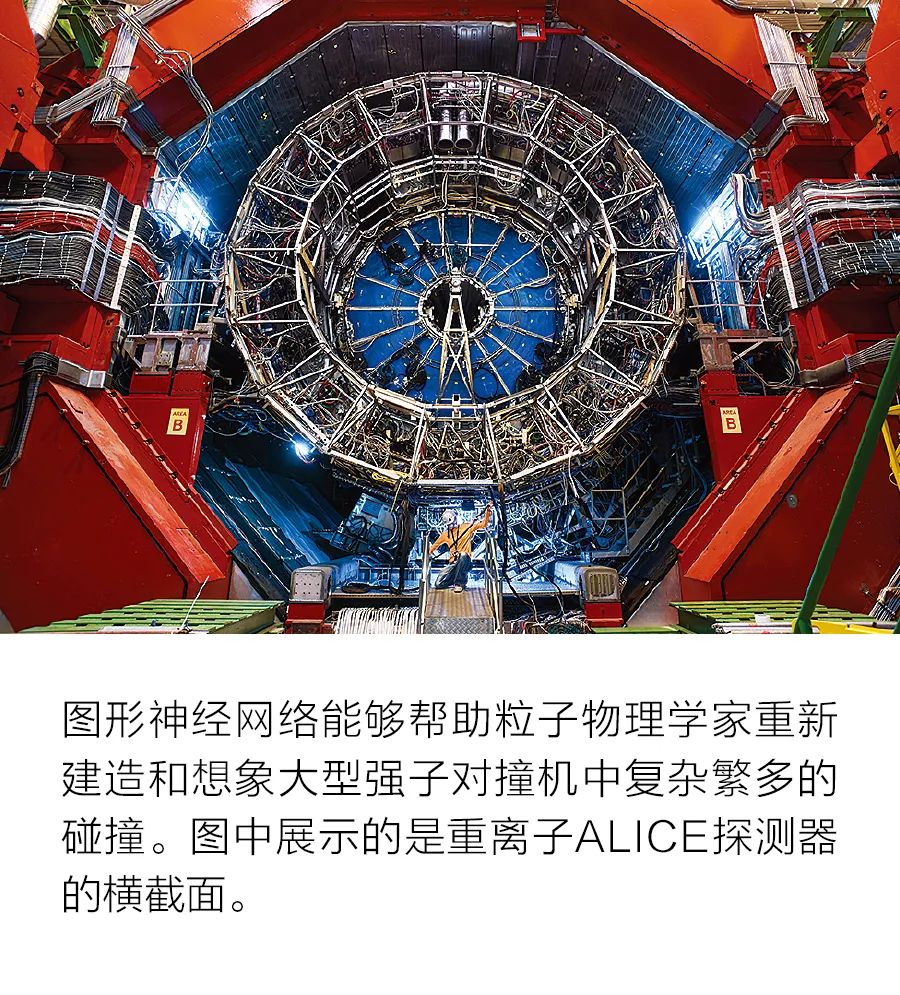

粒子物理的数据与众不同。虽然已经证实卷积神经网络(CNN)对树木、猫和食物等日常物体图片的分类非常高效,但它并不适合粒子碰撞。加州大学圣地亚哥分校的粒子物理学家哈维尔•杜尔特(Javier Duarte)表示,问题在于来自大型强子对撞机(LHC)的碰撞数据无法作为图像。华而不实地描述LHC碰撞可误导甚至堵塞整个探测器。实际上,在数百万个输入中只有少量几个输入在记录信号,就像白屏中有几个黑色像素。这导致卷积神经网络中的图像质量很差,但在一个被称为图形神经网络(GNN)的不同新框架中,效果则很好。除了格式奇怪以外,还有大量的数据,大约为每秒约1拍字节,其中只有少量高质量数据被保存下来。为了更好地筛选数据,研究人员想要训练更敏锐的算法。杜尔特说,要想提高效率,这种算法要具备惊人的速度,在微秒内执行。剪裁和量化等机器学习技术能使算法达到目标。借助机器学习,粒子物理学家可以从不同的角度观察数据。他们不仅关注单个事件,还学习和思考碰撞期间发生的几十个其他事件,例如希格斯玻色子衰变为两个光子。虽然任意两个事件之间没有因果关系,但研究人员现在接受一个更全面的数据视图,而不仅是单个事件分析得出的零碎视图。

更引人注目的是,机器学习还迫使物理学家重新审视基本概念。麻省理工学院的理论粒子物理学家杰西•泰勒(Jesse Thaler)说:“过去,我自己对对称性的看法不严密,强迫自己教授计算机什么是对称,也是帮助自己理解对称到底是什么。”对称需要参考系,换言之,镜子中变形的球体图像到底是否对称?如果不知道镜子本身是否变形,就无法知道答案。粒子物理学中的机器学习仍然处于早期阶段,实际上,研究人员现在对待相关技术就像对待厨房的洗碗池。杜尔特承认:“它也许不适合粒子物理学中的每一个问题。”在一些粒子物理学家深入研究机器学习的同时,脑中浮现出一个令人不安的问题:他们是在研究物理学还是在研究计算机科学?往往不被视为“真正的物理学”的编程已经存在;类似的担忧也在困扰机器学习。有的研究人员担心机器学习会遮掩非常复杂的情况,他们正在构建算法,使用人类能够理解的语言来提供反馈。而算法也许不是唯一负责沟通的主体。泰勒说:“另一方面,我们希望机器能够学习如何像物理学家那样思考。我们也要多学习如何像机器那样思考。我们需要学会讲对方的语言。”

IEEE Spectrum

《科技纵览》

官方微信公众平台