在应用层面,大模型自身已经成为一个框架,可作为任何应用领域的AI模型的基础。整个行业也都在期待大模型能在更多垂直领域发光发热,包括智能创作、智能交互等多种AIGC场景。

但是,在更基础的训练层面,大模型还面临着大量的优化挑战。同时,在学习范式方面,深究后也会发现,大模型还可以有更多的变化。

为了在训练、学习、应用等方向更深入探索大模型落地实践,引领人工智能未来,DataFun将上线大模型与AIGC峰会,邀数据智能从业者共襄盛举!

本届峰会将邀请业内顶尖专家,分享大模型的训练方法、学习范式等前沿技术,为从业者揭秘大模型在数据清洗、自动化评估、分布式训练等方面的关键技术,以及基于大模型的知识学习、工具学习、视觉-语言模型对齐等学习范式,带你深入体验大模型的魅力。

此外,峰会还将展示大模型在搜索广告、辅助创作、智能问答、智能客服、信息抽取等领域的最新应用。

了解和掌握大模型的训练和应用,将为企业运营和技术发展提供优质的支撑和推动。敬请莅临大模型与AIGC峰会,畅享人工智能新时代。陈宇 Meta AI 研究科学家

个人介绍:

陈宇博士现任 Meta AI 硅谷总部研究科学家。陈博士在2020年从美国伦斯勒理工学院取得计算机科学博士学位,并获校优秀博士学位论文奖及系优秀研究生奖。当前研究方向为机器学习和自然语言处理。其学术成果先后发表在 NeurIPS,ICLR,IJCAI,NAACL,KDD,WSDM,TheWebConf 等多个国际顶级会议上,曾获 AAAI DLGMA’20 最佳学生论文奖,并被包括 World Economic Forum,TechXplore,TechCrunch,Ad Age,Adweek,机器之心,新智元等在内的国内外众多媒体报道。陈博士参与了图神经网络书籍《Graph Neural Networks: Foundations, Frontiers, and Applications》的章节写作。陈博士参与的 DLG4NLP (Deep Learning on Graphs for Natural Language Processing) 系列 tutorial 在包括 NAACL’21,IJCAI’21,KDD’21,SIGIR’21,AAAI’22,TheWebConf’22 在内的多个国际顶级会议累计吸引了上千名听众。陈博士多次担任国际顶级会议(如 ACL,EMNLP,NAACL,IJCAI)和期刊(如TNNLS,TKDE,TASL,IJIS)的程序委员会成员和审稿人。陈博士是4项美国专利的发明人

黄非 达摩院 语言技术实验室负责人

个人介绍:黄非博士,阿里巴巴达摩院语言技术实验室负责人。他带领自然语言处理(NLP)团队研发通义AliceMind自然语言大模型体系,在机器阅读理解(MRC),图文问答(VQA)和中文理解(CLUE)等任务上实现首次超越人类结果;建设AliNLP平台和产品在阿里巴巴集团内支持数百个场景日均数万亿级调用,对外以智能技术赋能司法,电商,健康,海关等行业合作伙伴,也是AI开源魔搭社区NLP模型的主要提供者。加入达摩院之前,他曾在卡耐基梅隆大学攻读博士,之后在IBM Watson和Facebook从事并领导NLP研究等工作。他在人工智能顶级会议和期刊发表文章60+篇,中美专利20项,曾担任ACL,AACL等学术会议领域主席等。

个人介绍:武威,现为北京澜舟科技有限公司合伙人、首席科学家,负责孟子大模型的研发。在加入澜舟前,他是美团自然语言处理中心负责人。他带领团队建设了全球最大的生活服务知识图谱,打造了美团公司级智能对话平台、预训练平台、以及自然语言开放平台。其中知识图谱项目荣获了2022年中国人工智能学会吴文俊科技进步三等奖。武威于2012年至2020年就职于微软(中国)有限公司。在微软期间,他致力于智能人机对话前沿算法的研究,在对话上下文理解,对话生成,低资源对话建模,知识对话模型方面做出了很多开创性的工作,为微软的聊天机器人产品微软小冰的每一代升级贡献了核心算法。武威本科和博士均毕业于北京大学数学科学学院。 他在国际顶级会议期刊上发表了超过60篇论文,在Google Scholar上有超过3300次的引用,H-index是27。他是IEEE的高级会员,常年担任自然语言处理、人工智能、机器学习、信息检索、以及数据挖掘等国际顶级会议的程序委员,并受邀担任了NeurIPS 2023、ACL 2021、EMNLP 2021、NLPCC 2021的领域主席。▌详细介绍

个人介绍:张永锋,罗格斯大学计算机系助理教授、博导,互联网智能与经济实验室主任,研究兴趣包括机器学习、机器推理、信息检索、推荐系统、自然语言处理、人工智能的可解释性与公平性、人工智能伦理等,研究成果发表于SIGIR, WWW, RecSys, ACL, NAACL, CIKM, WSDM, AAAI, IJCAI, TOIS等领域内主要会议或期刊。担任期刊ACM Transactions on Information Systems、ACM Transactions on Recommender Systems和Frontiers in Big Data副主编。曾获得AIRS最佳论文奖、ACM TOIS杰出编辑奖、美国自然科学基金杰出青年奖(NSF CAREER Award)。刘焕勇 360人工智能研究院 算法专家

个人介绍:360人工智能研究院算法专家、知识图谱方向负责人,“老刘说NLP”公众号作者,曾就职于中国科学院软件研究所。主要研究方向为大模型数据挖掘与自动化评估、领域知识/事件图谱的构建与落地应用,主持或参与研制全行业事理图谱、百科图谱、知识图谱平台、事件情报分析、右侧推荐、大模型研发等落地项目,申请发明专利十余项、论文数篇。近年来在OGB-Wikikg2、CCKS多模态实体对齐、可解释类案匹配等评测中获得多项冠亚军。致力于自然语言处理技术开源共享,在github开源项目60+,收获star数超2W+。

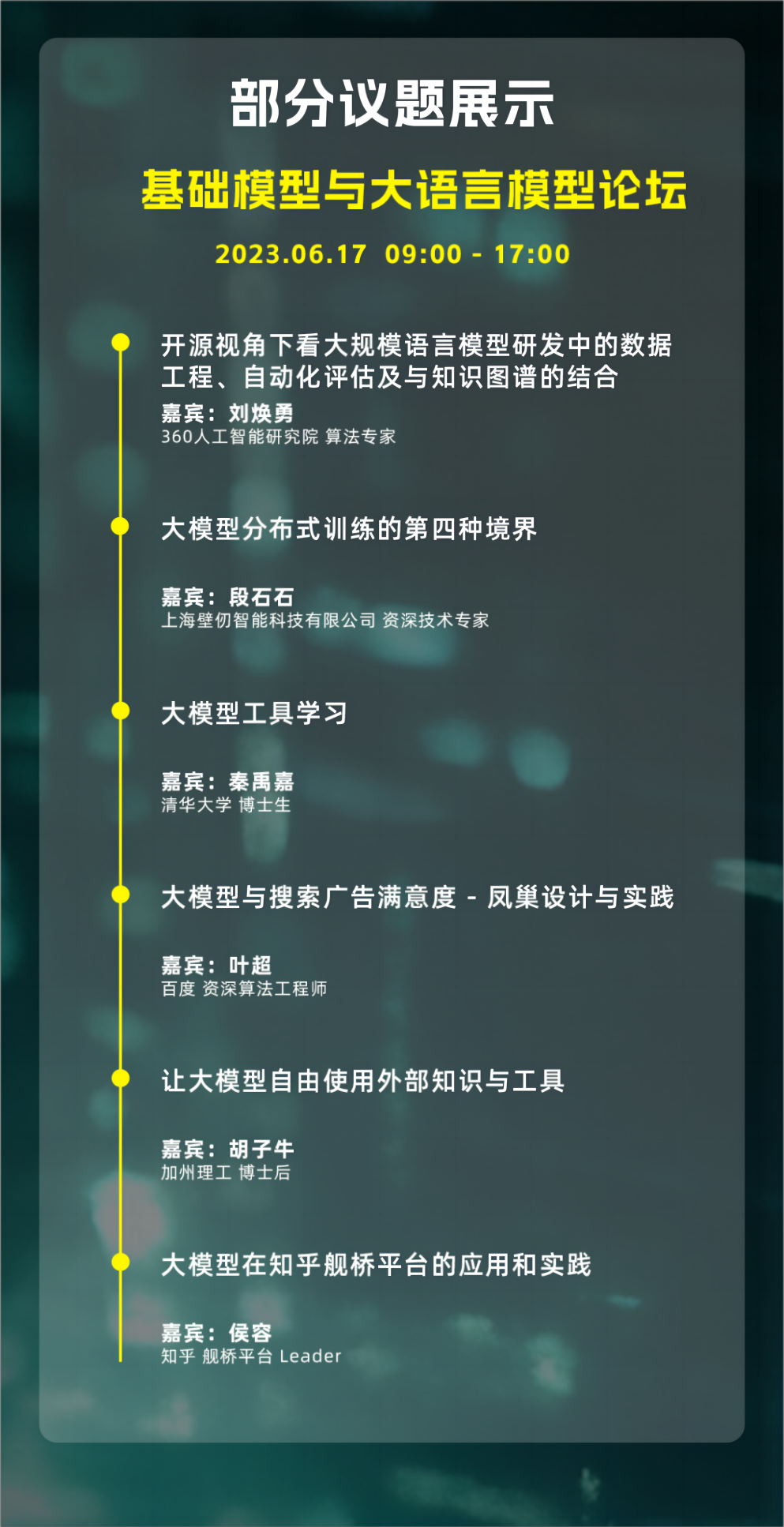

演讲题目:开源视角下看大规模语言模型研发中的数据工程、自动化评估及与知识图谱的结合演讲提纲:数据以及自动化评估是大规模语言模型研发过程中十分重要且有趣的问题,其中涉及到数据如何进行清洗,如何进行质量把控以及如何对模型进行全方位的性能评估。在当前时期,知识图谱作为一个数据科学,其又该如何在语言模型的研发和应用过程中发挥其价值,也尤为重要。本演讲将围绕上述话题展开介绍,供大家一起参考。1. 大模型数据清洗,目前有哪些公开的方案?

2. 大模型在自动化评估上有哪些可以值得借鉴的开源方案?

3. 当前时期下知识图谱与语言模型有哪些结合点?

演讲提纲:从机器学习火热到如今, 大模型的定义一直被刷新,而以分布式的方法支持大模型的训练一直是极有挑战性的工作。本次分享将从分布式训练历史演化趋势、现阶段大模型场景下遇到的包括显存、计算效率等方面技术挑战与解决方案、未来的挑战以及对自动并行的思考,来系统性地分享分布式训练在大模型场景的相关工作。2. 了解常见大模型分布式训练的技术挑战、以及相关的技术方案3. 了解分布式训练未来可能的挑战以及自动并行相关的技术思路个人介绍:秦禹嘉,男,清华大学计算机系2020级直博生。主要研究方向为大规模语言模型的高效预训练与下游智能化应用,曾在ACL、NAACL、EMNLP、ICLR、NeurIPS等会议发表多篇一作论文。演讲提纲:人类拥有非凡的创造和利用工具的能力。随着基础模型的出现,人工智能系统有潜力与人类同样熟练地使用工具。基础模型的工具学习的范式,结合了专用工具和基础模型的优势,能够提高解决问题的准确性、效率和自动化。尽管其潜力巨大,但对于该领域的关键挑战、机遇和未来的努力仍缺乏全面的理解。为此,我们对工具学习进行了系统的研究。

1. 如何提高大模型使用工具的能力?

个人介绍:叶超,本硕均毕业于上海交通大学。2017年加入百度凤巢至今,担任百度凤巢资深算法工程师,主要工作方向为搜索相关性、用户个性化行为预估等,于2021年获得百度最高奖。

演讲题目:大模型与搜索广告满意度 - 凤巢设计与实践

听众收益:

1. 如何定义搜索广告满意度

2. 大模型落地业务的工业实践

陶仕敏 华为 技术专家

个人介绍:现华为2012文本机器翻译实验,技术研究及创新负责人,技术专家。曾任百度运维平台及智能运维技术经理。主要研究方向:机器翻译,NLP for ICT,AIOps等。胡子牛 加州理工 博士后

个人介绍:胡子牛于2023年毕业于UCLA,之后将在加州理工(caltech)进行博士后研究,并于2024年加入伦斯勒理工作为助理教授。

演讲题目:让大模型自由使用外部知识与工具

演讲提纲:My ultimate research vision is to develop an AI model that can emulate human reasoning and thinking, which requires building a differentiable Neural-Symbolic AI. This approach involves enabling neural models to interact with external symbolic modules, such as knowledge graphs, logical engines, math calculators, and physical/chemical simulators. This will facilitate end-to-end training of such a Neural-Symbolic AI system without annotated intermediate programs.

During this talk, I will introduce my two research endeavors focused on building differentiable neural symbolic AI using knowledge graphs. Firstly, I will discuss how Symbolic Reasoning can help Neural Language Models. I designed OREO-LM, which incorporates knowledge graph relational reasoning into a Large Language Model, significantly improving multi-hop question answering using a single model. Secondly, I will discuss how Neural Embedding can help Symbolic Logic Reasoning. I solve complex first-order logic queries in neural embedding space, using fuzzy logic operators to create a learning-free model that fulfills all logic axioms. Finally, I will discuss my future research plans on applying differentiable neural-symbolic AI to improve program synthesis, architecture design, and scientific discovery. Last, I will introduce how to enable existing Large Language Models (e.g., GPT-4) as autonomous agent to use external tools (APIs) for solving complex domain-specific reasoning tasks.

听众收益:

1. 如何让通用大模型使用外部工具(api)从而解决垂直领域的问题

2. 如何利用外部知识增强视觉语言模型

3. 如何让语言模型进行逻辑推理和自主探索

扫码免费报名

出品人:赵宇 京东零售 算法专家

个人介绍:北京大学博士,加州大学洛杉矶分校访问学者。就职于京东零售-搜推算法部,负责搜索生态方向,设计研发了京东大促流量调控系统(登月计划)、新品激励系统、营销联动激励系统,参与设计京东百亿补贴、春晓计划等核心算法模块,带来显著业务价值。曾就职于阿里妈妈精准定向团队,负责转化率预估校准、点击合约工作。发表高水平论文3篇,申报发明专利14项。胡裕靖 网易伏羲 人工智能研究员

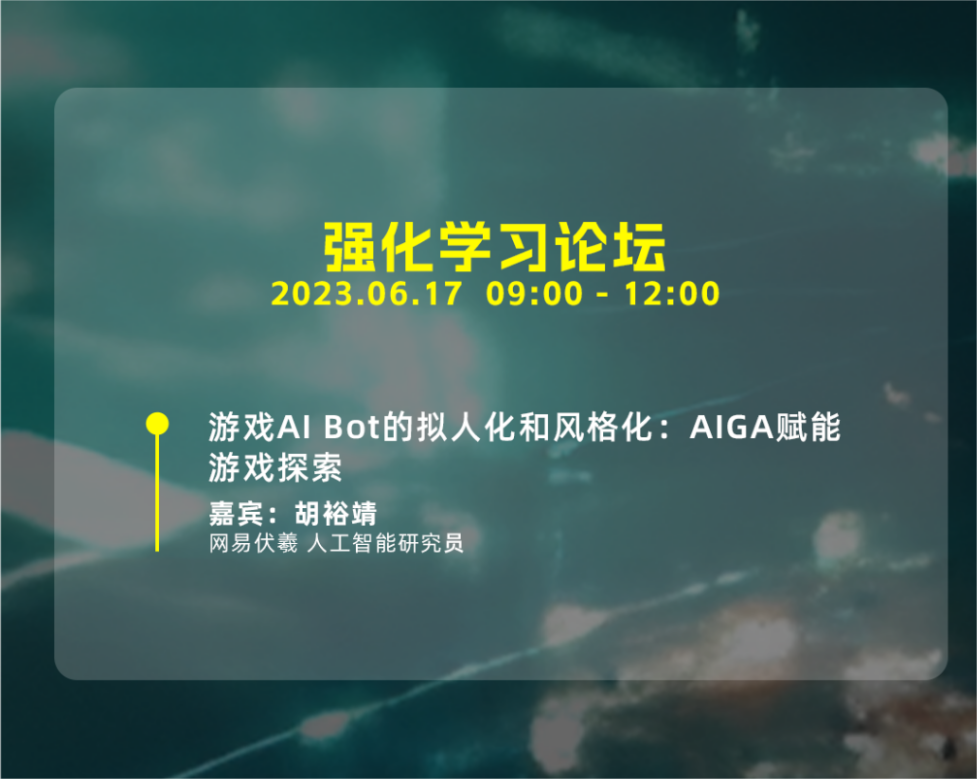

个人介绍:胡裕靖先后在2010年和2015年于南京大学计算机科学与技术系获得学士和博士学位。胡裕靖于2016年加入阿里巴巴,从事强化学习在搜索推荐方面的应用研究工作;又于2018年加入网易伏羲实验室,担任人工智能研究员,主要从事在强化学习在游戏AI方面的研究工作。胡裕靖目前为网易伏羲强化学习研究负责人,已在人工智能和机器学习国际顶级会议和期刊上发表论文30余篇,包括:NeurIPS、ICML、ICLR、IJCAI、AAAI、AAMAS、KDD等。

演讲题目:游戏AI Bot的拟人化和风格化:AIGA赋能游戏探索

演讲提纲:游戏机器人的拟人化和多风格化一直是人类玩家对游戏机器人的两个核心诉求。智能决策技术(如:强化学习、MCTS)能够很好地提升游戏机器人的技能水平,但却很难直接用于解决拟人化和多风格化问题。其原因主要在于拟人化和风格化是偏主观的优化目标,目前也并不存在统一的量化标准。本次分享将介绍我们在游戏机器人拟人化和多风格化方面的研究探索,包括:模仿学习与强化学习的结合、人在回路的强化学习、以及在网易最新篮球游戏《全明星街篮派对》中的实际效果。主要内容包括:

1. 从 AIGC 到 AIGA

2. 网易伏羲在游戏 AI Bot 拟人化、风格化方面的技术探索

3. 基于人类反馈的强化学习微调游戏 AI Bot 模型

听众收益:

1. 强化学习如何与模仿学习结合用于游戏 AI Bot 的拟人化和风格化问题

2. 基于人类反馈的强化学习如何用于游戏 AI Bot 的生成

3. 网易最新篮球游戏《全明星街篮派对》中拟人化、风格化 AI Bot 的实际效果

出品人:刘琦 腾讯 高级研究员

个人介绍:毕业于大连理工大学,研究兴趣包括知识抽取、文本生成、多模态学习、预训练语言模型。在游戏智能创编、信息流内容质量业务场景有丰富的算法实践经验。当前负责游戏短视频AI创作的算法开发和项目落地。

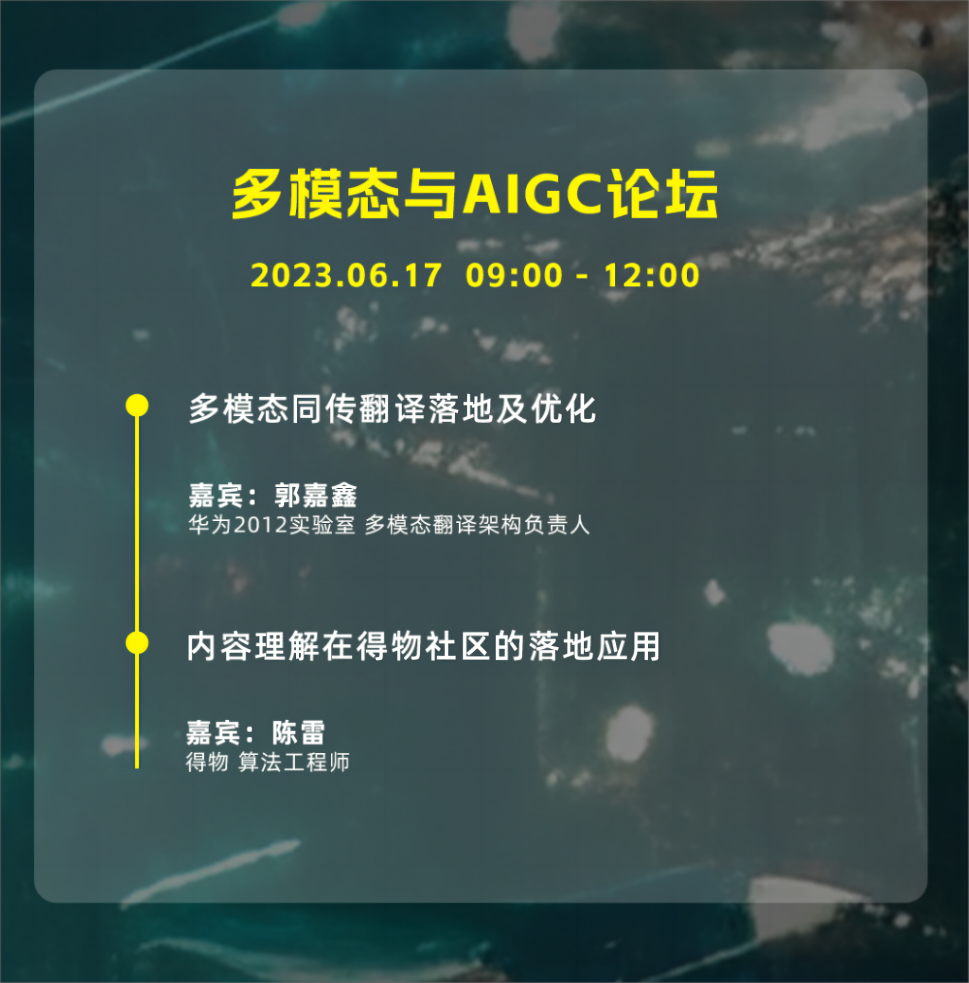

郭嘉鑫 华为2012实验室 多模态翻译架构负责人

个人介绍:现主要负责华为多模态同传翻译的实现和落地,参与华为机器翻译从 0 到 1 的构建。华为机器翻译现已支持 100 多种语言互译,除了有力支撑华为 20 万员工内部办公交流等场景外,还支撑着华为各个产品的翻译服务,包括华为手机、华为音箱、华为手表和 HMS 以及华为云等业务。本科毕业于西安交通大学,硕士毕业于香港城市大学。长期从事机器翻译/多模态翻译领域的研究,在ACL、ICASSP、INTERSPEECH、INLG 等自然语言处理和语音信号处理领域的国际会议上发表论文十余篇。参加国际机器翻译比赛 WMT、IWSLT、WAT 等,获得多项第一名。

演讲题目:多模态同传翻译落地及优化

演讲提纲:

1. 多模态同传翻译及工程落地简介

2. 华为多模态同传翻译整体架构

3. 总结:面向用户场景,忠于用户体验

听众收益:

1. 多模态同传翻译领域的主流技术路线

2. 针对不同的用户场景如何深度理解业务并针对性制定策略

陈雷 得物 算法工程师

个人介绍:毕业于同济大学地理信息系统专业,从事内容理解算法研究6年,任职云从/阿里/得物等公司,在CV/多模态/AIGC方向均有相关经验,欢迎志同道合的小伙伴一起交流分享。

演讲题目:内容理解在得物社区的落地应用

演讲提纲:

1. 多模态SOTA介绍

2. 得物多模态模型模型优化

3. 多模态特征泛化

4. 业务产出-召回排序应用

5. 业务产出-话题推荐

6. 多模态视频结构化

7. 展望

听众收益:

1. 多模态训练优化 Tricks

2. 多模态特征的在推荐场景的使用姿势

扫码免费报名

出品人:赵天祺 NVIDIA 开发者关系经理

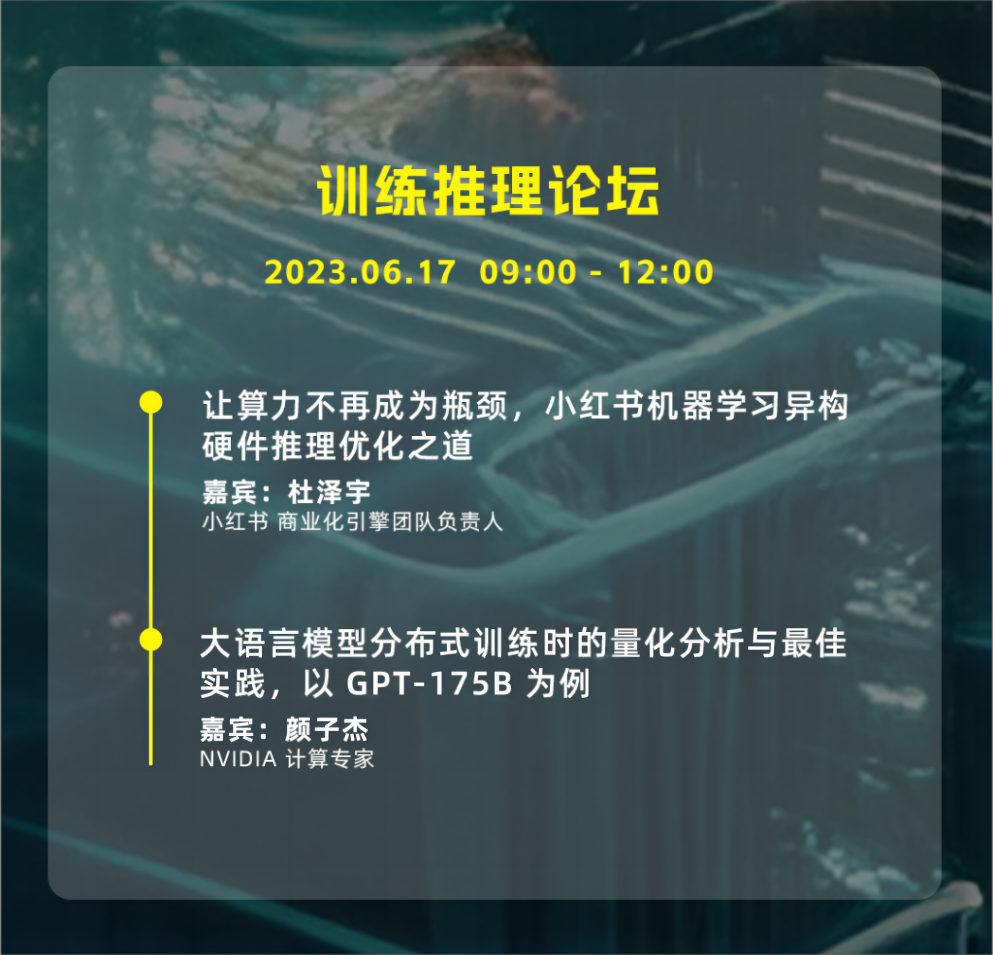

个人介绍:NVIDIA 消费互联网行业客户经理,开发者关系经理。专注于 NVIDIA 互联网行业客户技术合作与开发者生态建立。杜泽宇 小红书 商业化引擎团队负责人

个人介绍:毕业于华东师范大学计算机系,曾任百度商业化 Feed 流工程师,2018年加入小红书, 任小红书机器学习引擎工程师, 主要负责推理引擎、特征引擎,从 2021 年开始到 2022 年底, 通过不断优化,小红书推理计算算力增加 30 倍,关键用户指标提升 10%+ ,同时累积节约集群资源 50%+。2023年至今,任小红书商业化引擎团队负责人,主要负责商业化在线引擎, 结合业务打造算力引擎。

演讲题目:让算力不再成为瓶颈,小红书机器学习异构硬件推理优化之道

演讲提纲:

1. 前言

2. 背景

3. 模型服务架构概览

4. GPU优化实践

5. 总结

6. 团队

听众收益:小红书是如何在结合 GPU 的算力发展,探索出适合自己的机器学习问题解决方案的。颜子杰 NVIDIA 计算专家

个人介绍:硕士毕业于中山大学,分布式深度学习方向。毕业后在商汤科技负责视觉大模型系统方向的技术预研、规划、落地以及团队管理。加入 NVIDIA 后负责 LLM 训练系统方面工作,在 LLM 训练框架、MoE 框架、性能分析与优化、显存优化等领域有丰富的经验。

演讲题目:大语言模型分布式训练时的量化分析与最佳实践,以 GPT-175B 为例

演讲提纲:通过深入了解大语言模型在大规模集群上的显存、通信与计算开销,了解不同并行在系统层面的影响,进而对大语言模型的分布式训练优化建立更深的理解:

1. LLM Training and Megatron V3

2. 大语言模型训练时的通信、显存与计算开销

3. 最佳实践

听众收益:

1. 了解大语言模型主流并行技术、显存优化技术的原理

2. 了解大语言模型性能的量化分析方法

扫码免费报名

出品人:刘邦 蒙特利尔大学 & Mila 助理教授

个人介绍:Bang Liu is an Assistant Professor in the Department of Computer Science and Operations Research (DIRO) at the University of Montreal. He is a core member of the RALI laboratory (Applied Research in Computer Linguistics) of DIRO, an associate member of Mila – Quebec Artificial Intelligence Institute, and a Canada CIFAR AI (CCAI) Chair. He received his B.Engr. degree in 2013 from University of Science and Technology of China (USTC), as well as his M.S. degree and Ph.D. degree from University of Alberta in 2015 and 2020, respectively. His research interests primarily lie in the areas of natural language processing, multimodal & embodied learning, theory and techniques for AGI (e.g., understanding and improving large language models), and AI for science (e.g., health, material science, XR).刘辉 腾讯 算法研究员

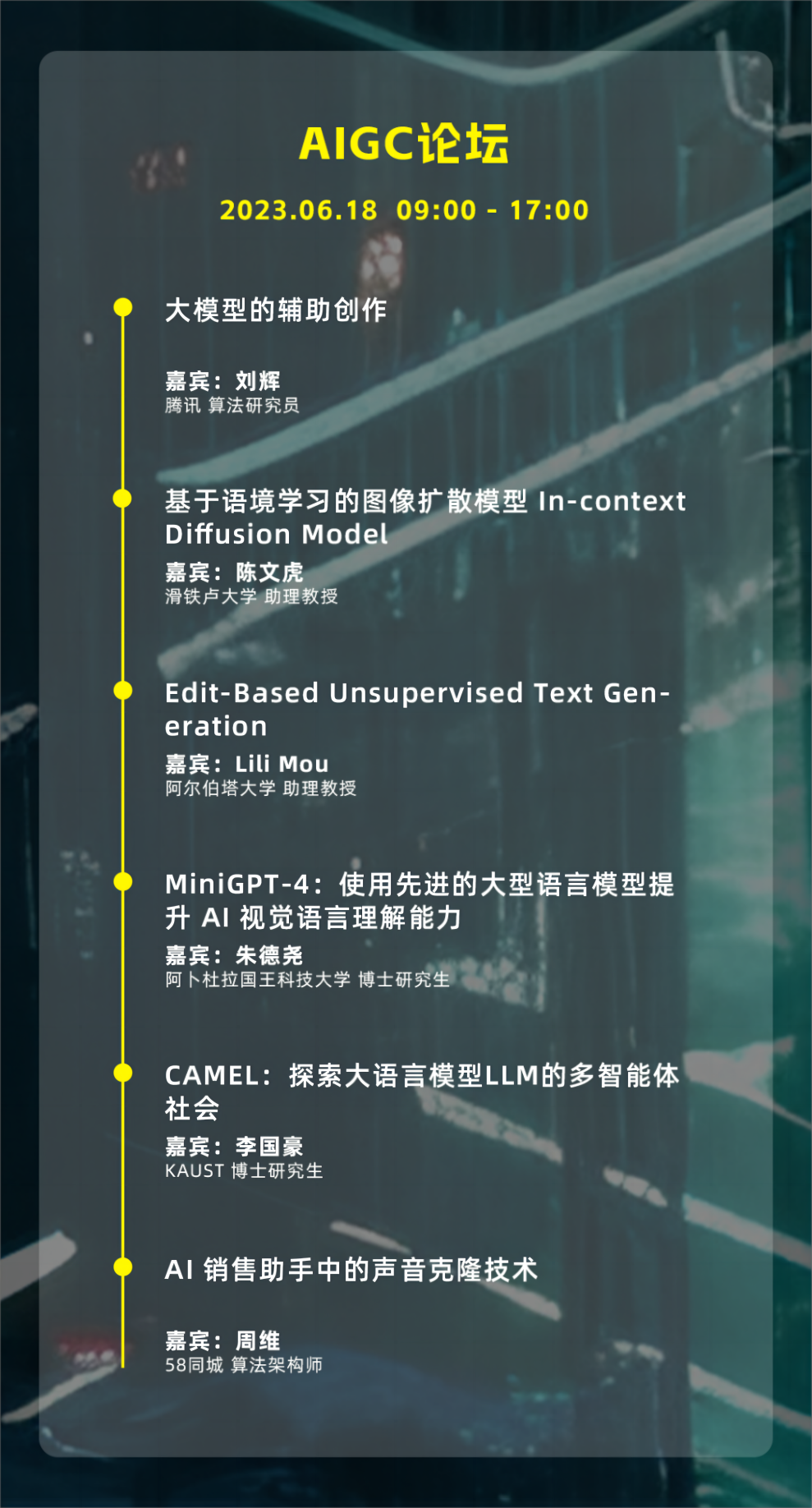

个人介绍:中国科学院大学硕士学历,毕业之后一直在腾讯从事 NLG 和 AIGC 相关工作。

演讲题目:大模型的辅助创作

演讲提纲:

1. 目前辅助创作的应用现状

2. 融合作者风格的自动标题生成

3. 大模型如何应用辅助创作

听众收益:

1. 业界辅助创作的应用和原理

2. 如何将风格信息融入辅助创作?

陈文虎 滑铁卢大学 助理教授

个人介绍:本人目前是滑铁卢大学助理教授,向量学院核心成员,加拿大CIFAR AI Chair。研究自然语言处理和图像生成,尤其对多步推理的问题感兴趣。博士毕业于加州大学圣塔芭芭拉分校,获得过博士毕业最佳论文奖。

演讲题目:基于语境学习的图像扩散模型 In-context Diffusion Model

演讲提纲:Recent text-to-image generation models like DreamBooth have made remarkable progress in generating highly customized images of a target subject, by fine-tuning an ``expert model'' for a given subject from a few examples. However, this process is expensive, since a new expert model must be learned for each subject. In this paper, we present SuTI, a Subject-driven Text-to-Image generator that replaces subject-specific fine tuning with in-context learning. Given a few demonstrations of a new subject, SuTI can instantly generate novel renditions of the subject in different scenes, without any subject-specific optimization. SuTI is powered by apprenticeship learning, where a single apprentice model is learned from data generated by massive amount of subject-specific expert models. Specifically, we mine millions of image clusters from the Internet, each centered around a specific visual subject. We adopt these clusters to train massive amount of expert models specialized on different subjects. The apprentice model SuTI then learns to mimic the behavior of these experts through the proposed apprenticeship learning algorithm. SuTI can generate high-quality and customized subject-specific images 20x faster than optimization-based SoTA methods. On the challenging DreamBench and DreamBench-v2, our human evaluation shows that SuTI can significantly outperform existing approaches like InstructPix2Pix, Textual Inversion, Imagic, Prompt2Prompt, Re-Imagen while performing on par with DreamBooth.

听众收益:

1. 如何快速的进行图像生成模型的个人需求化

2. 如何通过蒸馏学习得到类比学习的能力

Lili Mou,University of Alberta,Assistant Professor(牟力立 阿尔伯塔大学 助理教授)

个人介绍:Dr. Lili Mou is an Assistant Professor at the Department of Computing Science, University of Alberta. He is also an Alberta Machine Intelligence Institute (Amii) Fellow and a Canada CIFAR AI (CCAI) Chair. Lili received his BS and PhD degrees in 2012 and 2017, respectively, from School of EECS, Peking University. After that, he worked as a postdoctoral fellow at the University of Waterloo. His research interests include deep learning applied to natural language processing as well as programming language processing. He has publications at top conferences and journals, including AAAI, EMNLP, TACL, ICML, ICLR, and NeurIPS. He also presented tutorials at EMNLP'19 and ACL'20. He received a AAAI New Faculty Highlight Award in 2021.

演讲题目:Edit-Based Unsupervised Text Generation

演讲提纲:In this talk, I will present an edit-based approach to unsupervised text generation. The basic idea is to define a heuristic scoring function that estimates the quality of a candidate sentence. Then, we apply discrete search algorithms to generate a sentence by maximizing the score. In this way, we are able to generate high-quality text for a task without labeled training data. Moreover, the approach can be combined with prompting methods, where we prompt a large language model as the scoring function. Results on three style-transfer benchmark datasets show that our approach largely outperforms the state-of-the-art prompting systems that have 20 times more parameters.

听众收益:

1. 如何进行无监督文本生成?

2. 如何进行离散搜索?

朱德尧 阿卜杜拉国王科技大学 博士研究生

个人介绍:朱德尧,阿卜杜拉国王科技大学计算机科学专业博士生。主要研究兴趣与领域为人工智能决策,离线强化学习以及多模态大语言模型。MiniGPT-4作者。朱德尧本科就读于同济大学机械电子工程专业,硕士就读于汉诺威工业大学电子信息专业。

演讲题目:MiniGPT-4:使用先进的大型语言模型提升 AI 视觉语言理解能力

演讲提纲:GPT-4 展现出了前所未有的视觉语言能力,例如解释表情包的笑点,或者根据网站草图直接生成网页代码,等等。这样的能力是之前的视觉语言模型所无法企及的。然而,OpenAI 并没有公开 GPT-4 的任何技术细节,其非凡的视觉语言能力的来源是一个谜。我们认为 GPT-4 的秘密在于其强大的语言模型。为了验证我们的想法,我们构建了一种新颖的训练方法,将开源的视觉模型与开源的先进的大型语言模型进行对齐。我们的模型系统,MiniGPT-4,成功地复现了许多 GPT-4 的视觉语言能力,验证了我们的猜想。

听众收益:

1. GPT-4 多模态能力的可能来源是什么?

2. 如何低成本地复现 GPT-4 的多模态能力?

李国豪 KAUST 博士研究生

个人介绍:

http://xn--camel-ai-ox6n445d77rm8ch47a2y0abm1eklxb.org,DeepGCNs.org的发起人。他在沙特阿拉伯国王阿卜杜拉科技大学(KAUST)获得计算机科学博士学位,导师是Bernard Ghanem教授。在攻读博士学位期间,他在英特尔ISL担任研究实习生,并作为访问研究员访问了瑞士苏黎世联邦理工学院(ETHz)的计算机视觉实验室(CVL)。他还在Kumo.AI担任首位实习生,并作为核心成员为PyG.org做出了贡献。他主要研究方向包括自治智能体、图机器学习、计算机视觉和具身人工智能。他在国际顶级会议和期刊,如ICCV、CVPR、ICML、NeurIPS、RSS、3DV和TPAMI上发表了相关论文。

演讲题目:CAMEL:探索大语言模型LLM的多智能体社会

演讲提纲:ChatGPT等基于聊天的语言模型的快速发展在复杂任务解决方面取得了显著进展。然而,它们的成功严重依赖于人类输入来引导对话,这可能具有挑战性和耗时。本文探讨了构建可扩展技术以促进通信智能体之间自主合作并洞察其“认知“过程的潜力。为了解决实现自主合作的挑战,我们提出了一种名为角色扮演的新型通信智能体框架。我们的方法包括使用起源提示来引导聊天代理完成任务,同时保持与人类意图的一致性。我们展示了如何利用角色扮演生成对话数据以研究聊天代理的行为和能力,为研究会话语言模型提供了宝贵的资源。该项目的GitHub存储库可以在以下网址公开访问:https://github.com/lightaime/camel。

周维 58同城 算法架构师

个人介绍:周维,58同城TEG-AI Lab语音算法部负责人。负责语音识别、语音合成算法研发。2016年硕士毕业于中国科学院大学,毕业后参与对话式AI产品方向创业,2018年5月加入58同城,曾先后参与智能客服、智能外呼、智能写稿等AI项目的NLP算法研发,2019年开始主攻语音算法方向,带领团队从0到1自主研发58同城语音处理引擎中的语音算法。

演讲题目:AI 销售助手中的声音克隆技术

演讲提纲:58同城打造的 AI 销售助手能够大幅提升销售工作效率,而自然的音色、舒适的节奏和熟悉的口音都可以进一步提升机器人的对话效果,为此我们研发了多说话人多口音的声音克隆服务。本次分享将介绍声音克隆在 AI 销售助手中的实际应用方案。首先,将介绍少样本多说话人多口音克隆方案;接着,讨论在真实对话数据下的自然度优化方案,包括音质优化、稳定性优化和文本风格迁移;最后,简要介绍声音克隆的部署方案。

听众收益:

1. 少样本多说话人多口音克隆方案

2. 真实对话数据下的音质与稳定性优化方案

扫码免费报名

出品人:徐一翀 character.ai,Member of Technical Staff

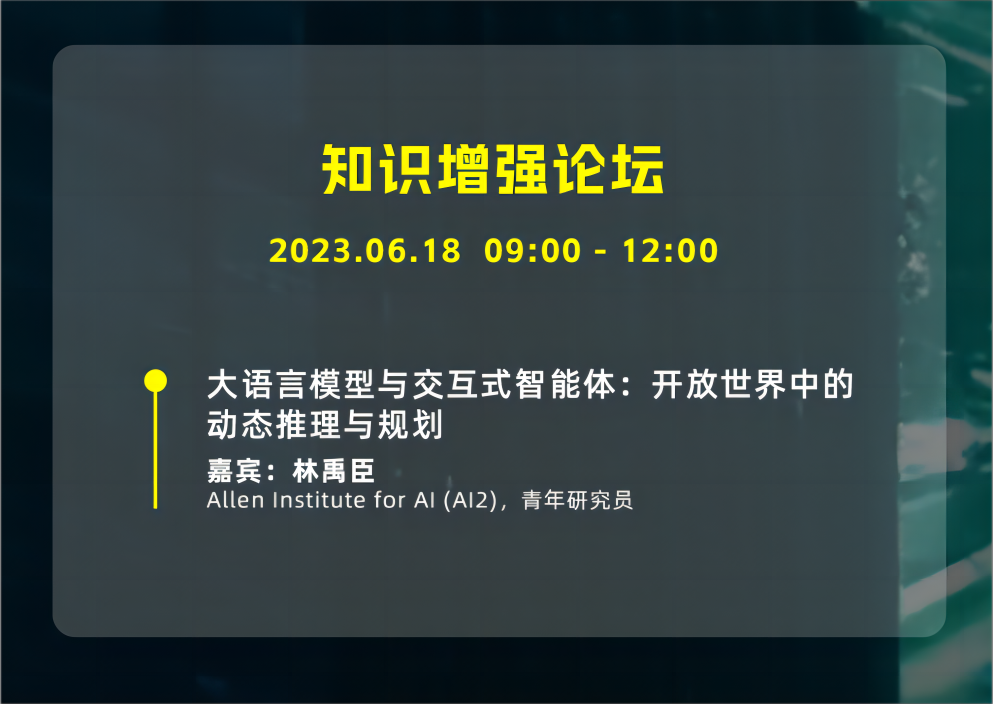

个人介绍:徐一翀,目前在character.ai做大模型训练和应用相关的工作。之前在微软认知科学研究组(Cognitive Services Research)任高级研究员。本科毕业于清华大学姚班,在2020年于卡内基梅隆大学取得机器学习博士学位。研究方向包括交互式机器学习,自然语言处理,多模态机器学习等。工作发表在机器学习和自然语言处理的顶级会议和期刊(NeurIPS, ICML, JMLR, ACL, NAACL, EMNLP等),相关成果被引用1000次以上,曾多次担任顶级会议和期刊审稿人。林禹臣 Allen Institute for AI (AI2),青年研究员

个人介绍:林禹臣是Allen Institute for AI(AI2)博士后青年研究员,师从Yejin Choi教授。他于2022年获得南加州大学博士学位,导师是Xiang Ren教授。他的研究专注于常识知识推理(Commonsense Reasoning)与大语言模型(Large Language Models)旨在构建具有人类思考和交流模式的智能系统。此外,他还对持续学习和联邦学习主题感兴趣。他曾于上海交通大学IEEE试点班获得学士学位,曾在Google AI,FAIR担任实习研究生。他一直担任 ACL、EMNLP、ICML、NeurIPS、ICLR、AAAI会议审稿人。他曾多次组织了研讨会(Workshop),并在ACL 2022和2023参与讲习(Tutorial),曾任ACL 2023的区域主席 (Area Chair)。

演讲题目:大语言模型与交互式智能体:开放世界中的动态推理与规划

演讲提纲:

在本次演讲中,我将介绍如何利用语言模型(LLM)来辅助交互式智能体(interactive agent)在动态世界中进行动态推理和行为规划。很多最近的研究表明大语言模型比如GPT-4具备了一定的通用推理能力,但是他们仍然不擅长与真实物理世界进行交互,尤其是在规划(planning)方面。开发这种交互式智能体去帮助我们在现实世界完成一定的任务需要非常复杂推理以及多方面的能力(比如多模态的信息处理)。在本次演讲中,我们聚焦在如何在纯文本的物理引擎中模拟并开发交互式智能体。我们会介绍最近的相关工作比如 SayCan,ReAct 和 Reflexion 等,并介绍本人最近的两篇论文:G-PlanET 与 SwiftSage。

听众收益:

1. 如何在纯文本引擎中开发并测试交互式智能体?

2. 如何将大语言模型与真实世界进行连接并辅助智能体进行推理?

3. 如何结合大模型与小模型从而提高效果并降低功耗?

出品人:张佶 达摩院 资深算法专家

个人介绍:张佶,达摩院自然语言实验室资深算法专家,13年NLP领域研究经历,带领团队在国际顶级会议发表论文30多篇,在多个权威评测榜单中取得第一且首次超越人类基准的成绩,目前负责大模型应用研究方向。

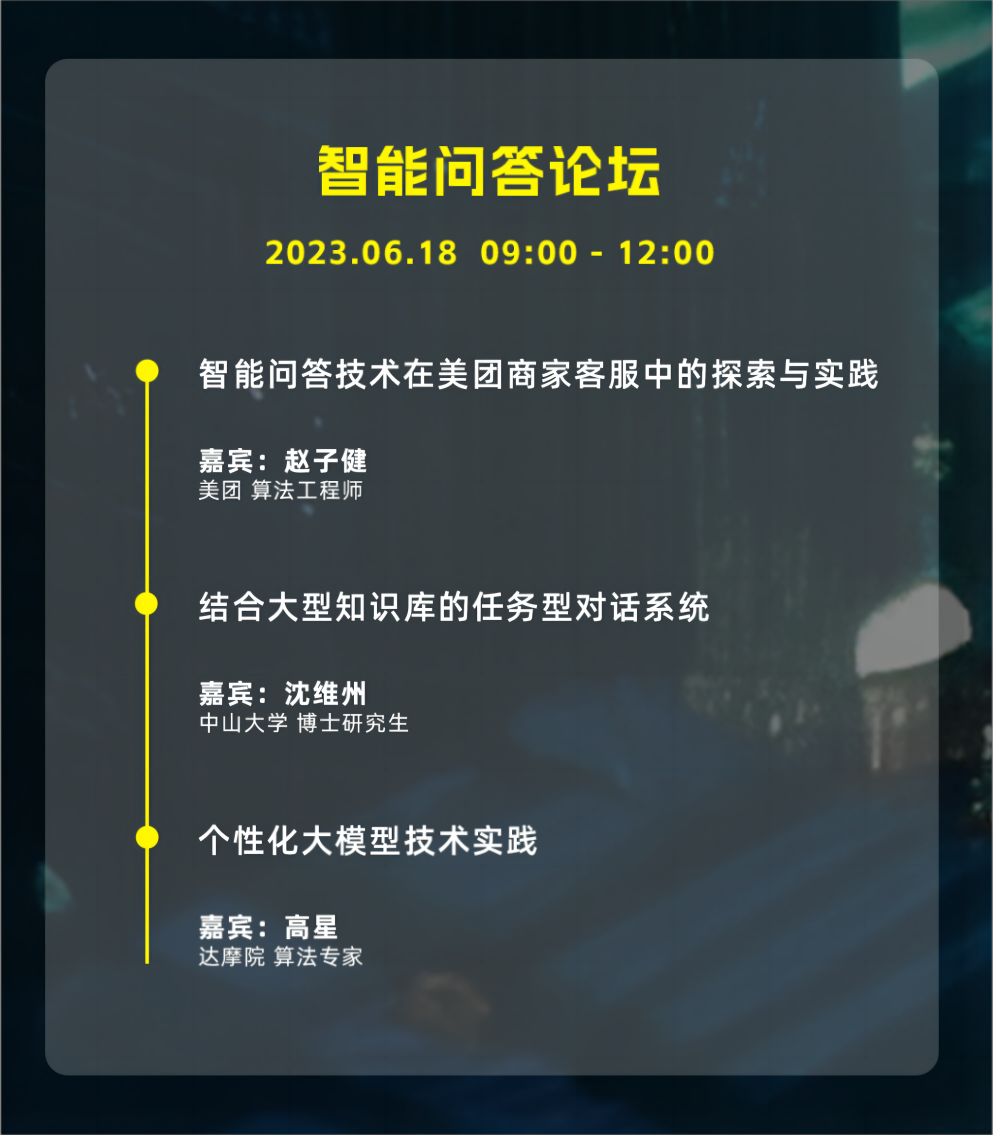

赵子健 美团 算法工程师

个人介绍:美团语音交互部算法工程师,本硕均毕业于上海交通大学,主要研究方向为自然语言理解与对话系统。2020年加入美团,主要工作为语义理解与对话系统的研究与应用,目前主要负责商家端智能客服。

演讲题目:智能问答技术在美团商家客服中的探索与实践

演讲提纲:主要介绍智能问答技术在美团商家客服中的探索与实践,包括:

1. 美团业务与智能问答背景

2. 智能问答传统做法(FAQ、DocQA、KBQA)

3. 基于大语言模型的智能问答

听众收益:

1. 了解智能问答(FAQ、DocQA、KBQA)相关做法

2. 大语言模型背景下智能问答如何做?

沈维州 中山大学 博士研究生

个人介绍:沈维州,中山大学计算机学院在读博士研究生。在AAAI,ACL,ICASSP,IEEE TAFFC等国际顶级期刊会议中发表论文9篇,目前主要研究方向为文本生成,强化学习,外部知识端到端任务型对话系统和大模型工具学习。

演讲题目:结合大型知识库的任务型对话系统

演讲提纲:完成任务型对话需要结合外部的酒店、天气等大型数据库中的实体信息。然而,受限于模型输入的长度限制,我们无法将大型数据库的所有实体完整输入到模型中,因此在对话系统中结合检索系统成为必然。现有数据中往往只有对组成的训练数据,缺少中间生成回复所需检索实体的标注结果,因此如何仅通过对来训练检索模型成为一项研究重点。该主题主要介绍两个工作:(1)结合多粒度的检索器的任务型对话系统,通过对话回复生成模型的知识蒸馏和远程监督来训练检索器,从而提高检索器性能与生成性能。(2)利用极大边界似然进行检索器与回复生成模型协同训练,同时提出在输入生成器的模型输入中加入“知识摘要”的方法来解决生成模型无法合理使用检索器检索出来的知识的问题。

演讲提纲:

1. 背景介绍

2. 结合多粒度的检索器的任务型对话系统

3. 极大边界似然与知识摘要

听众收益:

1. 如何在任务型对话中结合外部大型知识库

2. 如何在没有检索标注的情况下端到端的训练检索器

高星 达摩院 算法专家

个人介绍:智能客服小蜜问答,个性化对话大模型落地天猫精灵;现在投入做千问大模型的业务应用落地。

演讲题目:个性化大模型技术实践

演讲提纲:

1. 背景和现状

2. 概念和定义

3. 数据和模型

4. 评测与应用

5. 总结

出品人:谢朋峻 达摩院 语言技术实验室 高级算法专家

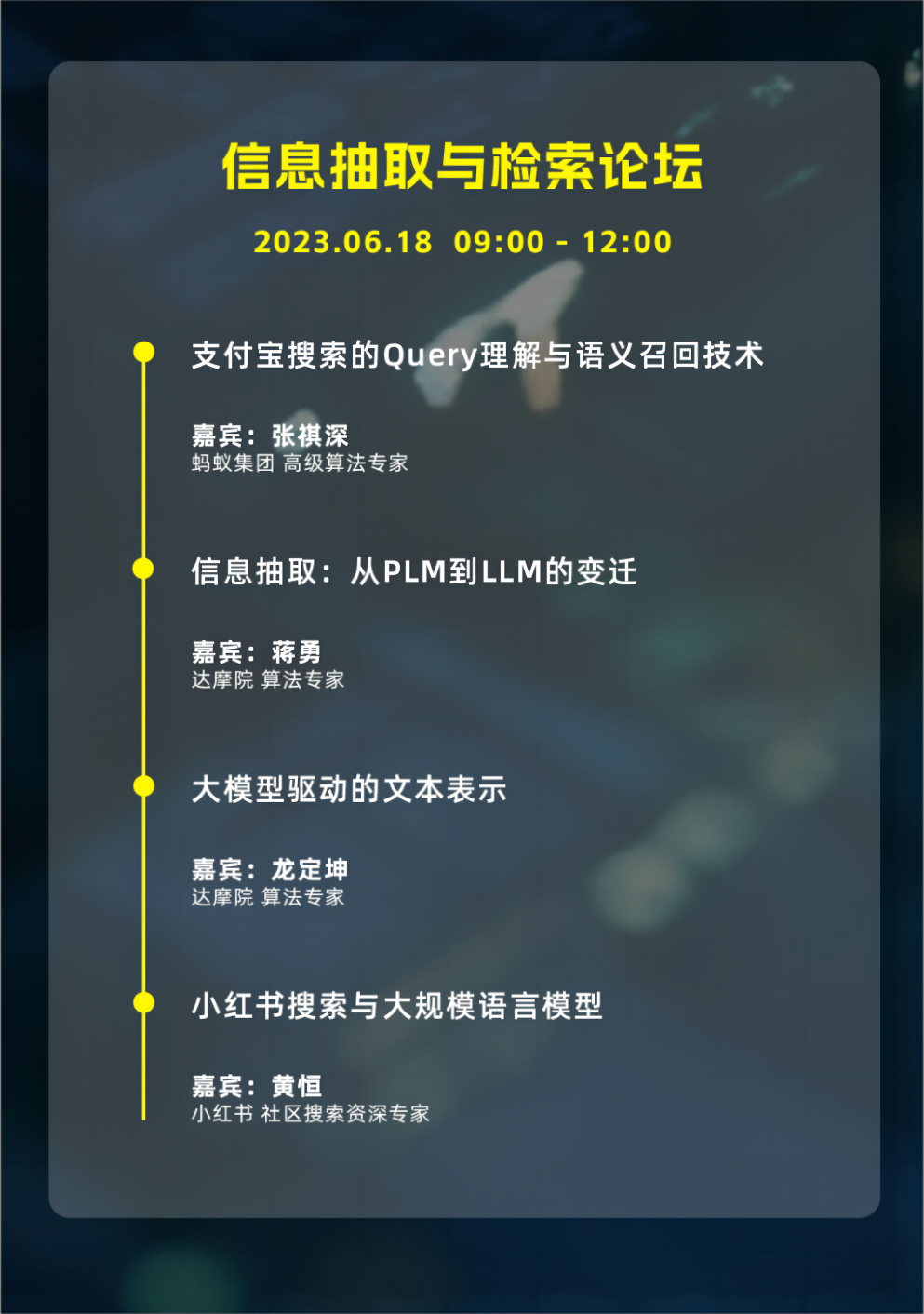

个人介绍:谢朋峻,达摩院语言技术实验室高级算法专家,2012 年南京大学硕士毕业后加入阿里,先后在淘宝搜索、电商知识图谱、达摩院 NLP 等团队工作 10 余年。目前在达摩院负责基于大模型的语义理解和搜索技术。带领团队在 ACL、EMNLP、NAACL 等会议发表论文 50 余篇,在 MS Marco、SemEval、TREC 多次获取冠军。张祺深 蚂蚁集团 高级算法专家

个人介绍:本硕毕业于北京理工大学,曾任职于百度商务搜索部广告算法,目前负责支付宝搜索的召回、query 理解与引导算法。

演讲题目:支付宝搜索的Query理解与语义召回技术

演讲提纲:Query理解和语义向量召回是搜索引擎中重要的技术课题,针对移动搜索引擎中检索Item包含多种结构化信息并在语义匹配过程中需要针对结构化信息进行综合匹配的问题,我们介绍了一种通用的多属性信息语义匹配算法。在Query理解方面,我们将分享基于样本生成的大规模文本多分类任务样本增强框架。以上两个工作分别发表在2023年的WWW和ACL会议中。

听众收益:了解搜索引擎语义检索方向的最新问题和解决方法。为生成式模型融合传统NLP任务提供扩展思路。蒋勇 达摩院 算法专家

个人介绍:达摩院自然语言处理基础技术组算法专家,博士毕业于中国科学院大学和上海科技大学,加州大学伯克利分校访问学者,从事自然语言处理相关的技术研发,并将先进性技术落地产品和平台。目前在国际顶级会议ACL/EMNLP/NAACL/AAAI等发表40多篇论文,在SemEval 2022、SemEval 2023、NLPCC 2022信息抽取国际比赛摘取20个子赛道的冠军,并获得SemEval 2022最佳系统论文奖,当前研究方向包括信息抽取、大模型预训练与下游应用技术。

演讲题目:信息抽取:从PLM到LLM的变迁

演讲提纲:在数字化信息理解问题中,信息抽取是最广泛的应用之一。最近大模型的出现改变了信息抽取领域的研发和应用范式,本场分享主要是介绍在信息抽取方向,我们过去几年面向PLM架构的研究工作,以及在LLM新范式下的一些尝试和思考。

听众收益:

1. 信息抽取任务的模型建设方案

2. 对于研究者来说,大模型范式下信息抽取任务的机会和挑战龙定坤 达摩院 算法专家

个人介绍:阿里巴巴达摩院机器智能实验室算法专家,2019年北京航空航天大学硕士毕业后加入阿里巴巴,一直从事自然语言处理相关的研究和工业落地,研究方向主要包括基础词法、信息检索、预训练语言模型等。

演讲题目:大模型驱动的文本表示

演讲提纲:

1. 文本表示背景介绍

2. 大模型对文本表示的推动

3. 未来发展方向

听众收益:

1. 了解文本表示的背景,常见的下游应用,表示模型训练方法

黄恒 小红书 社区搜索资深专家

个人介绍:毕业于浙江大学,曾在阿里搜索、达摩院工作,目前就任小红书搜索算法。

演讲题目:小红书搜索与大规模语言模型

演讲提纲:介绍小红书搜索的一些重要算法更新。

听众收益:

1. 介绍小红书搜索算法

2. 介绍小红书语言模型的发展与应用

▌关于我们

DataFun 专注于大数据、人工智能技术应用的分享与交流。发起于2017年,在北京、上海、深圳、杭州等城市举办超过500场线上线下沙龙、论坛及峰会,已邀请近1600位专家和学者参与分享。旗下公众号 DataFunTalk 累计生产原创文章1000+,百万+阅读,17万+精准粉丝。