近年来,随着大模型技术的迅猛发展,手机厂商纷纷亮相大模型应用,成为手机发布会上的焦点。从OPPO的语音助手升级到vivo的官方宣布自研手机AI大模型,再到小米将大模型直接整合到手机系统中,各厂商的竞争可谓激烈异常。这一切的背后,是智能终端已然成为各类AIGC(AI Generated Content)应用的新战场。首先,大模型的应用范围不断扩展,从图像生成到文本生成,各类应用层出不穷。国内厂商推出的文心一言、智谱清言APP,以及国外的OpenAI移动版ChatGPT、Llama 2手机版等,都是大模型在手机上的典型应用。这使得智能终端逐渐成为大模型应用的新滩头。算力

在将大模型引入手机时,算力是首当其冲的问题。高通在其《混合AI是AI的未来》白皮书中谈到:“面对每日超过 100 亿次的搜索量且移动端搜索占比超过 60%的情况,生成式 AI 的应用将推动所需算力的实质性增长,尤其是来自智能手机端的搜索请求。由于基于生成式 AI 的查询能够提供更令人满意的答案,用户的搜索方式已经开始发生转变。”高通的第三代骁龙8移动平台通过强调硬件加速器,如Hexagon NPU,实现在手机上运行100亿参数大模型。此外,它还改进了传感器中枢,通过Sensing Hub有助于大模型在手机端的“定制化”,提升了AI处理效率。

内存和能耗

限制大模型进入手机的第二道关卡是有限的内存和电池压力。

联发科表示:“虽然大模型可以带来更好的生产力,但本地运行13B的体量就意味着需要占用约 13GB 的内存,再加上安卓本身的 4GB和其他APP内存,已经超过了大多数手机16G的内存容量。天玑 9300 使用的内存硬件压缩技术,通过量化和压缩把大模型的内存占用降低,只有这样才能让大多数用户在日常跑得起大模型应用。”

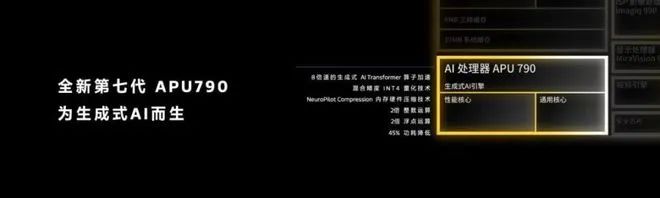

高通在第三代骁龙8中采用LPDDR5X内存,提高了数据传输速度和带宽,支持更大更复杂的AI模型。同时,AI引擎的升级,如Hexagon NPU性能提高了98%,功耗降低了40%,在内存和能耗平衡上实现了更好的性能。联发科也不甘示弱,天玑 9300 集成了 MediaTek 第七代 AI 处理器 APU 790,专为生成式 AI 而设计,其性能和能效相较上一代得到显著提升,整数运算和浮点运算的性能是前一代的两倍,功耗降低了45%。

互联

目前,AI 已广泛应用于各种物联网垂直领域,包括零售、安全、能源和公共设施、供应链和资产管理。AI 依靠近乎实时的数据采集和分析改进决策质量,优化运营效率,并赋能创新以打造差异化竞争优势。通过生成式 AI,物联网细分领域将进一步从 AI 的应用中受益。在高通的Snapdragon Seamless技术展示了智能终端的互联。这一技术能够在不同设备之间无缝传输数据,为用户提供更加便捷的跨终端操作体验。这种互联不仅使得大模型应用在不同设备之间实现共享,也为AI解决方案的跨平台适用性提供了可能。

专注AI任务处理

移动AIGC手机AP相比传统手机AP更专注于处理AI相关任务。例如vivo的自研芯片、高通的骁龙平台以及苹果M3都是为了提供更出色的AI推理处理而专门设计的,突显了其在AI任务处理方面的专业性。多核心异构处理

为了更好地处理不同类型和规模的AI模型,移动AIGC手机AP可能会支持多核心异构处理。让我们简单回顾手机处理器到目前为止的提升历史,初期性能的提升主要是依靠CPU内核架构(比如从Arm Cortex-A5~A15)、提升CPU主频、同类CPU内核数量。但问题也随之浮现, CPU内核性能及数量的提升带来的功耗也越来越大,比如单纯的依靠四核A15/A17内核的处理器,如果用到移动平台,都已经出现了严重的功耗问题。而为了解决这一问题,Arm在2011年就研发了全新的big-Little架构,即通过大核CPU+小核CPU的组合来平衡性能和功耗问题。

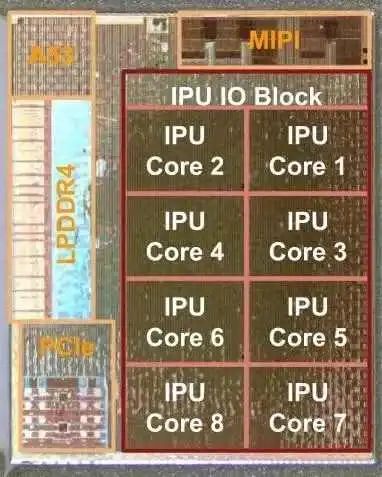

在此之后,三星和联发科都先后推出了“大小核”架构的手机处理器,新的变革出现在2017年,Arm正式发布了全新的有针对人工智能及机器学习进行优化的DynamIQ技术。而新的DynamIQ big-little将允许在单一计算集群上进行大小核配置,将可配置性提升到了一个新的台阶。同时,DynamIQ big.LITTLE还可以对每一个处理器进行独立的频率控制以及开、关、休眠三种状态的控制,可以实现在不同任务间丝滑切换的处理器。2019年,Google博客公布的Pixel Visual Core结构图中就显示了AIGC手机AP中需要多核异构,这颗芯片内部集成了8个图像处理核心(lmage Processing Unit,简称:IPU),一颗来自ARM的A53核心,同时还拥有MIPI/LPDDR4/PCle控制器。 此后,包括联发科在内的众多手机芯片厂商开始全面采用八核“三丛集”架构设计,很多手机处理器厂商也纷纷效仿。比如,高通最新推出的骁龙8 Gen3采用的就是采1+5+2的八核“三丛集”架构。联发科的天玑9300则首次采用了“全大核”CPU设计,即1个3.25GHz Cortex-X4超大核+3个2.85GHz Cortex-X4超大核+4个主频2.0GHz Cortex-A720 大核。

更低功耗和高效能

AI 创业公司 Hugging Face 和卡内基梅隆大学的研究人员分析了 13 种生成式 AI 任务的耗能,除了生成图像和文本,还有摘要、对象检测、文本分类等。每项任务研究人员都会运行 1000 个提示词,收集期间消耗的电力。结果显示图像生成最高,文本分类最低。生成图像的平均耗电量为 0.007 度电(KWh),是文本分类的三倍以上(0.002 度电)。

因此,移动AIGC手机AP需要在AI任务执行时提供高效的性能,但同时要求较低的功耗。这是为了确保在移动设备上能够实现可持续的性能,同时维持较长的电池寿命。灵活的软硬件结合

移动AIGC手机AP可能会支持灵活的软硬件结合,以便在不同的AI任务场景下进行适应性优化。这可以通过软件更新来改进AI处理的效能,使手机能够不断适应新的AI算法和模型。例如,高通的AI 硬件加速和简化开发的软件解决方案(比如高通 AI 软件栈),已经在引领终端侧 AI 推理。联发科则提供了生成式AI开发套件NeuroPilot,支持快速部署生成式AI模型并在APU上高效运行,同时提供全面的工具链以供开发丰富的AI应用程序。

在AI模型需求高算力和高功耗的大背景下,智能终端芯片的评判标准已经发生了变化,小模型对处理器提出了更具体的技术需求,尤其在移动端应用场景下。与传统手机AP相比,移动AIGC手机AP更专注于提供高效的AI推理处理,注重多核心异构处理、低功耗和高效能的设计。这种技术差异使得移动设备能够更好地满足未来AI应用对于移动终端处理器的不断提升的需求,为用户提供更出色的人工智能体验。