基于拇指的机器学习微姿势识别系统

(映维网Nweon 2024年10月18日)AR/VR设备已经开始采用裸手交互来代替控制器。然而,今天的手部输入主要依赖于一个姿势:捏合。另外,与使用摇杆或触控板相比,在内容滚动等用例中,当前的手部运动映射涉及更复杂和更大的手臂运动。

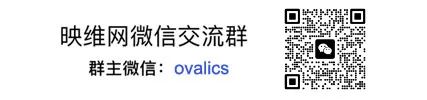

针对这个问题,Meta提出了一种名为STMG的基于拇指的机器学习微姿势系统。STMG微姿势是指拇指在食指桡侧的轻触和滑动。团队将它们映射为移动命令:拇指轻触传送,向左滑动快速转左,向右滑动快速转右。他们同时将它们映射为垂直滚动:向前滑动为向上滚动,向后滑动为向下滚动。

STMG主要通过在头戴设备运行的骨骼追踪识别额外的基于拇指的微姿势来增加姿势空间。团队采用机器学习方法,在食指表面执行的七种拇指姿势中实现了95.1%的识别准确率:四种方向拇指滑动(向左,向右,向前,向后),拇指轻触,指尖按压开始和按压结束。

基于视觉的手部追踪为增强现实和虚拟现实提供了一种方便的输入方式。不需要控制器或外设,用户可以直接用手与虚拟对象进行交互。对于远距离的交互,例如间接或远场交互,当前的头显设备提供基于拇指和食指捏合的输入。

捏合是一种简单的姿势:只需将拇指和食指同时接触,用户就可以向姿势识别器发出明确的意图信号。然而,当捏合是唯一使用的姿势时,开发者需要结合额外的手和手臂动作来区分不同的捏合交互。

通过骨骼追踪微姿势STMG,Meta扩展了捏合姿势集,以包括更多的单手拇指到食指的微姿势。相关的额外姿势不同于“捏合”,不需要眼睛就能映射到其他命令。由于它们与智能手机交互的相似性,所述姿势非常容易学习。拇指和食指之间的相互作用所提供的自触觉反馈强化了姿势动作。

当然,识别微姿势是一项具有挑战性的任务,很难与手部追踪抖动或噪点区分开来。尽管姿势很容易描述,但在用户之间也有很大的差异,这使得很难通过简单的启发式来识别姿势动作。

针对这个问题,团队采用机器学习方法,将时间神经网络应用于Meta Quest的自中心单色摄像头生成的骨骼手部运动,不需要额外的可穿戴传感器。

在20个用户的离线测试数据集上,七种姿势(拇指轻触、四向拇指滑动、按压开始、按压结束)实现了95.1%的F1得分。对于STMG微姿势模型,团队证明了基于拇指的姿势是VR/AR用例的可行输入方法。

另外,拇指轻触和滑动可用于VR中的移动控制,例如瞬间移动和快速转向。团队提出了一项移动机制研究,并发现24名用户中有17名更喜欢微姿势而不是VR控制器,24名用户中有22名更喜欢微姿势而不是基于按压的移动机制技术。同时,团队提出了一个滚动设计(适用于VR和AR),以将离散的微姿势信号映射到短距离和长距离的滚动。

现有产品的手控输入一般在间接交互中使用捏点进行选择。为了区分不同的基捏交互,姿势需要设计成带有额外的手或手臂运动,例如,捏合和上下移动代表着滚动。

STMG支持的基拇指微姿势则通过更小的低热量拇指运动来增加姿势空间,而手可以静止,手臂和肩膀放松。

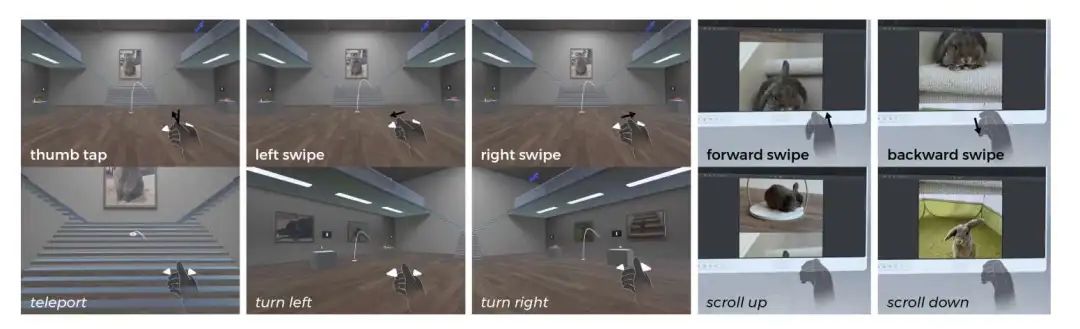

手以握姿开始,手指微微卷曲,好像拿着一个想象中的控制器。食指的桡侧是拇指滑动的交互面,很像智能手机的表面。拇指滑动自然映射到四个基本方向:左、右、前、后。

相关滑动类似于我们熟悉的输入,包括游戏方向板或操纵杆、电视遥控器、键盘上的箭头和手机的滑动。

滑动是一种流畅的动作,从拇指与食指的侧面接触开始,在四个方向中的一个方向快速滑动,然后抬起。向前和向后滑动时,食指可能与拇指的方向相反,更容易在拇指和食指之间产生较大的相对运动。注意,团队最初将向前和向后滑动称为向上和向下滑动,但这给特定用户带来了误解,令其认为滑动是垂直进行,就像向上滑动是拇指向上的姿势,或者向下滑动意味着拇指向下插入手掌。

另外,系统支持拇指轻触,这包括拇指接触的侧面食指,然后抬起。出于两个原因,团队选择不将拇指轻触分解为拇指接触和拇指抬起事件:

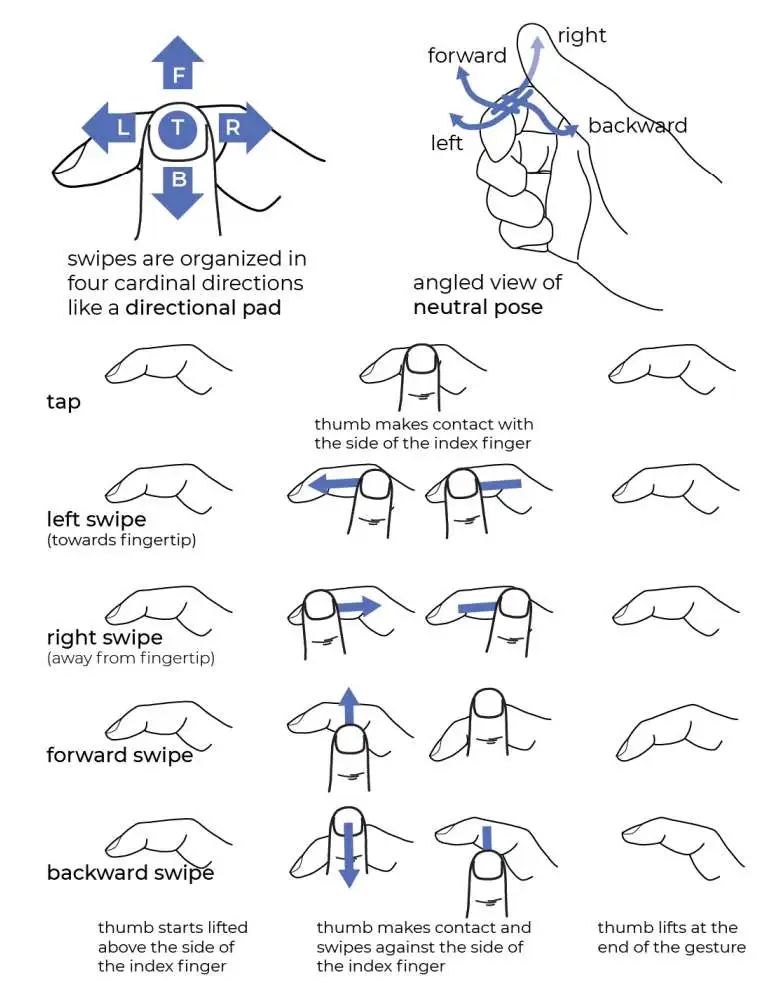

另外,为了更容易地将微姿势与基于捏合的输入整合在一起,团队希望模型能够学习滑动和捏的区别。如果没有一个能同时理解这两种姿势的模型,就很可能出现捏击和滑动之间的干扰。例如,在右手向右滑动时,拇指很容易接触到食指。一个统一的模型将避免错误。

所以,STMG手势集包含捏开始和捏结束。决定拇指接触和抬起是捏合还是轻触的边界是食指远端关节。

相关论文:STMG: A Machine Learning Microgesture Recognition System for Supporting Thumb-Based VR/AR Input

https://paper.nweon.com/15735

总的来说,Meta提出的STMG系统可以识别微姿势:拇指滑动,拇指轻触和捏合,准确度为95.1% F1分数。所述姿势为VR/AR用户提供了更小幅度的、基于拇指的姿势来控制设备。

---

原文链接:https://news.nweon.com/125229