本文约1000字,建议阅读5分钟

我们提出了一种新型的联合监督/自监督损失函数,大大提高了深度估计的精度。

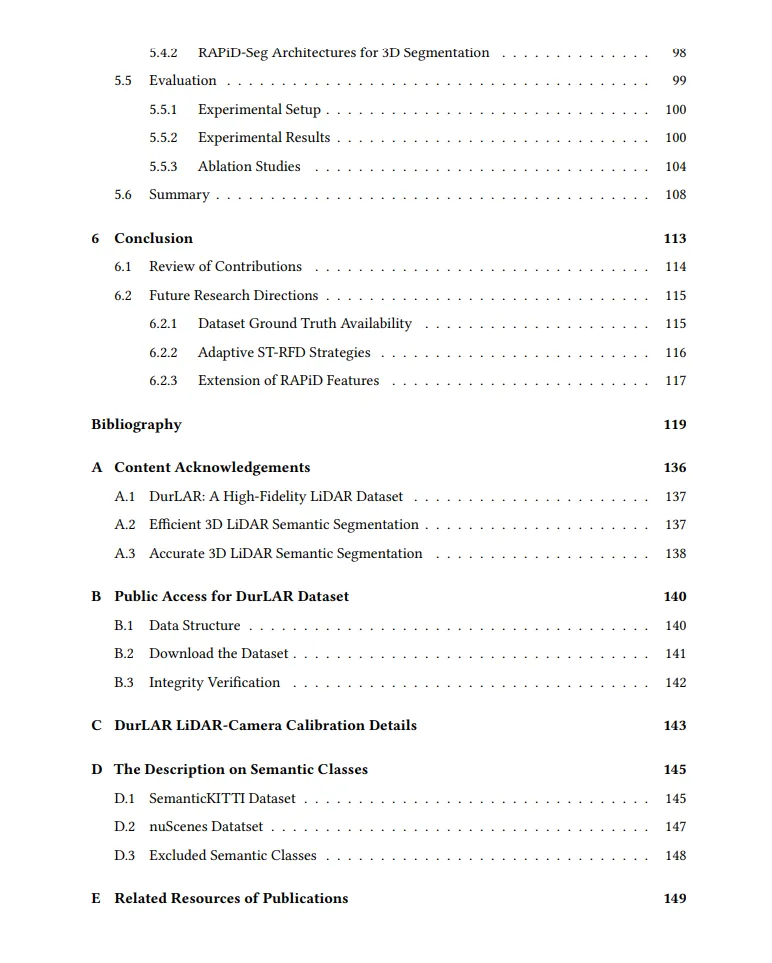

基于车载3D LiDAR的几何与语义场景理解深度学习研究3D LiDAR点云数据在计算机视觉、机器人学和自动驾驶中的场景感知中起着至关重要的作用。涉及3D点云的几何与语义场景理解是推动自动驾驶技术发展的关键。然而,仍然存在许多挑战,特别是在提高这些系统的整体准确性(如分割精度、深度估计精度等)和效率方面。为了解决与LiDAR任务相关的准确性问题,我们提出了DurLAR,这是首个高保真128通道3D LiDAR数据集,具有全景环境(近红外)和反射率图像。利用DurLAR,超越了先前基准的数据集分辨率,我们着手解决单目深度估计任务。利用这种高分辨率但稀疏的真实场景深度信息,我们提出了一种新型的联合监督/自监督损失函数,大大提高了深度估计的精度。为了在确保精度的同时提高3D分割的效率,我们提出了一种新颖的管道,采用更小的架构,所需的真实标签注释更少,同时在分割精度上超越了现有方法。这一创新通过一种新型的稀疏深度可分卷积(SDSC)模块得以实现,该模块显著减少了网络的参数量,同时保持了任务的整体性能。此外,我们还引入了一种新的时空冗余帧下采样(ST-RFD)方法,该方法利用传感器运动知识提取多样化的训练数据帧样本,从而提高计算效率。此外,近年来在3D LiDAR分割方面的进展重点关注点云的空间定位和分布,以提高分割精度。然而,坐标和点强度的依赖性导致了性能的亚优表现和较差的等距不变性。为了提高分割精度,我们引入了基于距离感知的点距离分布特征(RAPiD)及其相关的RAPiD-Seg架构。这些特征展示了刚性变换不变性,并能适应点密度变化,专注于邻近结构的局部几何。利用LiDAR的各向同性辐射和语义分类,它们增强了局部表示和计算效率。通过广泛的实验和定性分析,我们验证了方法的有效性。我们的方法在语义分割的mIoU和深度估计的RMSE上超越了现有的最先进技术(SoTA)。所有贡献已被同行评审的会议接受,进一步证明了我们在自动驾驶中3D LiDAR应用的准确性和效率方面的进展。

数据派THU作为数据科学类公众号,背靠清华大学大数据研究中心,分享前沿数据科学与大数据技术创新研究动态、持续传播数据科学知识,努力建设数据人才聚集平台、打造中国大数据最强集团军。

新浪微博:@数据派THU

微信视频号:数据派THU

今日头条:数据派THU