本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博 @唐僧_huangliang,以便更好地与读者互动。

上一篇《DTW2019新品抢先看:Unity XT、VxFlex OS 3.0、PowerProtectX400》之所以写的早了点,本来我是想五一假期多休息一些,更多的考虑不必在此细讲。但今天我还是想跟大家聊聊Dell Technologies World 2019(前身为EMC World)上的另一款新品——DSS 8440服务器。

Dell EMC DSS 8440这张高清大图,大家可以从https://corporate.delltechnologies.com/en-us/newsroom/dtw-presskit.htm查看或下载。

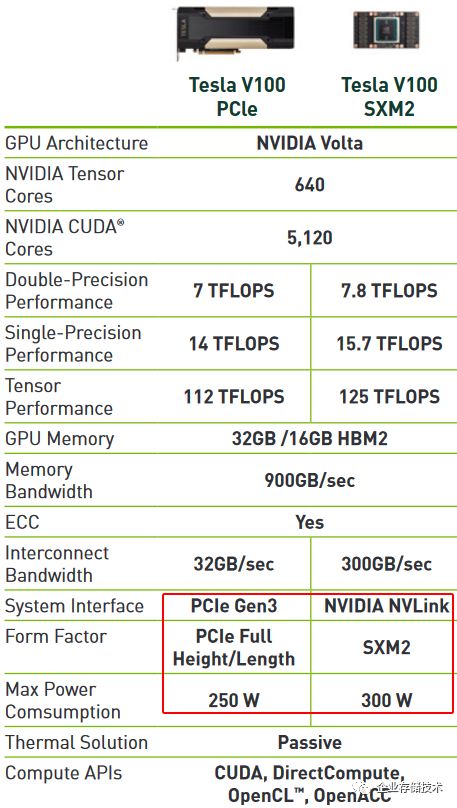

不难看出这机箱是4U的,里面最多可以插10块NVIDIA双宽度GPU计算卡——现在也没啥太多选择,就是300W功耗的Tesla V100。单纯从计算密度来看,有的朋友可能知道1U4卡、2U 8卡的机型,乍一看起来4U 10卡显得并不算多?其实这里面是有讲究的,是权衡多方面因素之后的结果,您慢慢跟着我往下看。

散热:一个贯穿全文的话题

首先是散热设计,DSS 8440位于前端的12个大尺寸风扇也比较显眼的。进入机箱的气流首先照顾到GPU,然后CPU和系统内的其它组件。该机型可以在满配下支持到标准的35℃散热进风,这一点可是那些1U 4卡、2U 8卡(300W)GPU服务器做不到的哦。

上图是一台Dell PowerEdge C4140测试机,在1U机箱内支持4块300W加速卡,可以是NVIDIA Tesla系列也可以兼容Intel Xeon Phi等。

C4130和C4140 GPU服务器的散热风扇排在偏机箱中部,也就是GPU的后面。如果将风扇改到机箱前部进风口出,我觉得对GPU的散热效果可能稍会好一点,但是从吸风变为吹风,40mm小尺寸风扇在这样狭长的空间内估计会产生更大的风阻,对后面的CPU等散热可能不利。

其实这方面话题我在4年前的《四路服务器进化:R930内存板瘦身、偏置CPU散热》中就讨论过,也许不够专业,但早年我毕竟还是做过散热测试工作的。

PCIevs. NVLINK: AI应用别忽视能效比

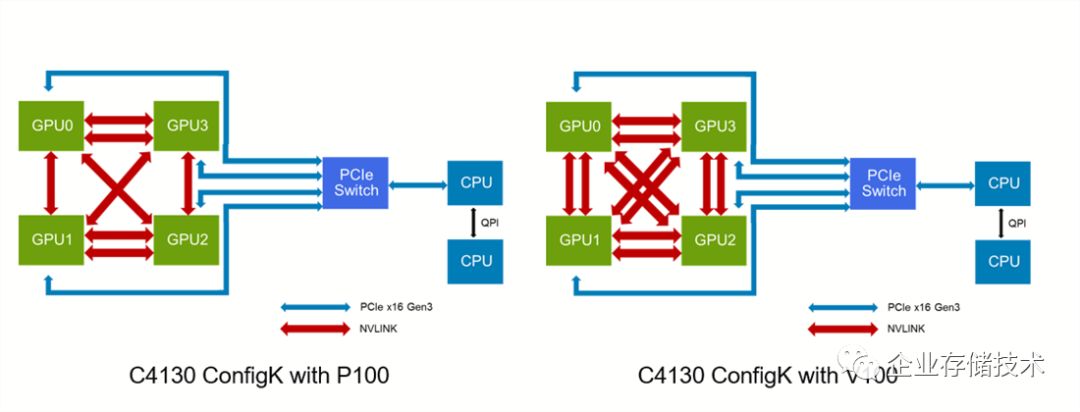

如上图,PowerEdge C4130和C4140除了支持双宽PCIe计算卡,还可选一种4个SXM形态Tesla P100/V100的配置,价值是除了PCIe互连之外,GPU之间还有专用的NVLINK高速通道,主要适合一些对数据交换带宽敏感的HPC应用。

回过头来再看新发布的DSS 8440,好像不是业内第一个做到4U 10卡的密度,那么它还有哪些特点呢?似乎没有NVLINK的支持,会不会有性能上的影响?

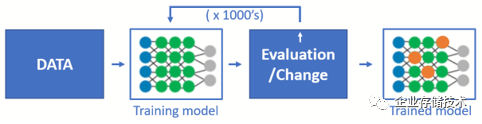

机器学习中的训练(Training)——根据初始模型不断经过数据集的训练,这样一个优化的过程。

其实DSS 8440

一开始就把自身主要定位在机器学习(AI)应用,如今这方面的市场需求和增速都比较大。并且在机器学习/深度学习领域,如TensorFlow 、PyTorch、MXNet这些框架对GPU之间的数据带宽没那么敏感,大家可以看看下边PCIe和NVLINK的测试对比:

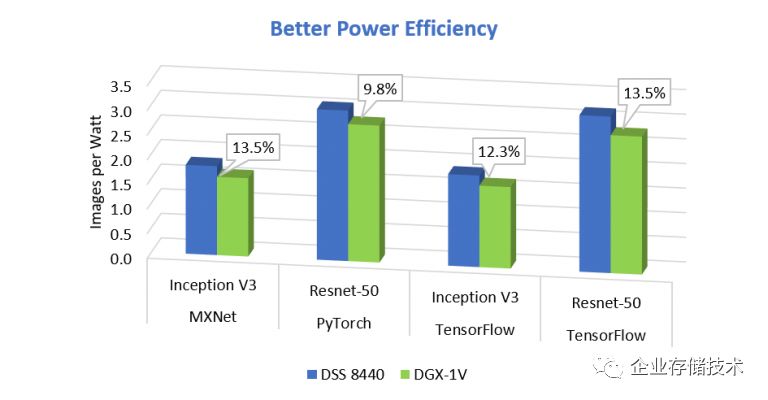

注意:该图表对比的是电源效率,即能耗比。

根据Dell EMC给出的数据,DSS 8440在配置8个Tesla V100的情况下,AI训练的绝对性能比DGX-1低大约5%,但上图中却能看到前者使用的PCIe GPU有更好的能耗比,这是为什么呢?

SXM2模块支持NVLINK也是有代价的,它会比PCIe Gen3的V100卡多出50W功耗,但单卡性能远没有高出20%哦。另外对于DSS 8440服务器而言,将散热进风温度限制提高到35℃,可以支持的机房范围更广,可以降低空调的耗电,同时有助于数据中心在保持风冷的情况下获得更好的PUE。

扩展阅读:《后IB时代的GPU服务器:48V和液冷哪个先行?》

存储、I/O扩展更均衡

这张照片引用自国外网站https://www.servethehome.com/dell-emc-dss-8440-10x-gpu-4u-server-launched/,人家估计是去了DTW大会现场。

从后面看DSS 8440最下面有4个2400W电源模块。然后右侧有10个2.5英寸热插拔驱动器位,据了解其中最多可选支持8个NVMe SSD。没有3.5英寸HDD支持我觉得应该问题不大,因为HPC、AI应用的海量数据大多是连接外部的网络存储,比如Lustre集群啥的。

我还看到机箱后部大量的散热开孔,这些都是为了保证10块300W GPU的热量能够顺利排出。至于PCIe扩展,还有8个全高槽位,高速网卡如InfiniBand啥的也不发愁了吧。

除了GPU,还支持Graphcore

根据我的经验,深度学习中的训练通常使用单精度浮点(FP32)或者半精度浮点(FP16)计算,而推理(Inference)的计算精度可能会用到INT4、INT8整数或者FP8浮点计算。比如说Intel最新一代的Xeon Scalable X200系列CPU加强的AI指令集,应该主要就是为了补强FP8性能。

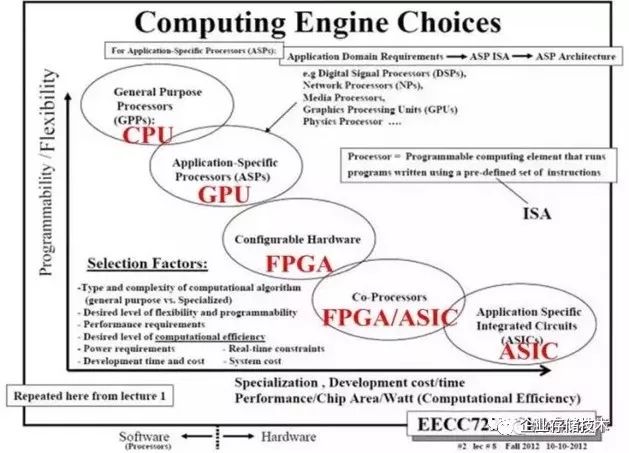

大家可能见过上面这一类的图,CPU做为通用处理器可编程性和灵活性最好;而越是偏向专用计算领域,其性能效率的排名就是CPU。FPGA的两大厂商许多朋友应该都不陌生了;ASIC比如Google的TPU不对外单独卖,我还写过《FacebookAI基础架构(上):Intel Nervana推理加速器》,而本次Dell发布DSS 8440时提到的Graphcore也是同一类产品。

Graphcore的计算卡称为IPU,号称能提供2PFLOPs的性能。4.8GB片上内存与后面的720TB/s看上去有点恐怖?我怀疑这个带宽数字可能是整个DSS 8440里面多卡(多芯片)的总和,不过也够猛了吧。

编程框架支持C++,这一点有点像CUDA,还不知实际用起来如何。DSS 8440支持8个IPU卡,Graphcore之间的互连——IPU-LINKS带宽为2.5Tb/s(≈250GB/s)。怎么样,值得期待不?

关于GeForce支持问题:纯技术讨论

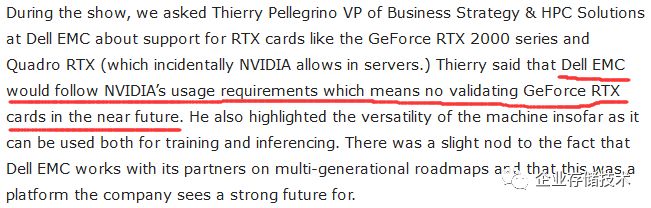

尽管NVIDIA已经明令禁止在数据中心使用GeForce显卡(区块链/挖矿除外),但想追求性价比的用户似乎国内外还是有。到了RTX图灵这一代GPU,GeForce和(不低于2060)Quadro(不低于RTX4000)应该都具备了Tensor Core和混合精度;而除了低功耗的Tesla T4之外,NVIDIA还未正式发布更多Tesla新型号,于是也开始放开Quadro专业显卡用在一些服务器上。

Tesla和Quadro是企业级产品,3年质保、高负载下的稳定性要比GeForce更好,挖过矿的朋友估计会深有体验:)游戏显卡大多只提供1年保修(随系统提供商政策可能不同)。

上面这段英文是Serverhome网站对Dell EMC的提问,回答比较官方——“DSS 8440不会在近期验证对GeForce RTX的支持”。这里我还想补充一点技术理由,如下图:

这是一块涡轮风扇公版的RTX 2080,从后挡片出风的散热设计。与Tesla不同的是,GeForce/Quadro有数个显示输出接口,因此I/O挡片上的出风孔面积要小一些。如果传统上显卡位于机箱风道的最后端,那么主动散热不会有什么问题。但别忘了在DSS 8440中GPU是位于机箱前部,GeForce的散热设计可能会影响到系统整体的散热气流。还是那句话:术业有专攻!

另外我还担心一点,2块250-300W的GeForce显卡并排挨着还好,但如果是4-10块中间没有间隔,涡轮风扇这种设计是否还能长期保证显卡的散热?我不是很确定。相比来说,下面这种结构应该会相对好些。

这张照片是塔式/5U的PowerEdge T630/640服务器,官方支持4块300W Tesla GPU,如果选配专门加在后面的排气风扇,对机箱内部风速/风道的要求估计会降低。尽管它也没看到有GeForce出厂的配置,但至少左右两边各2块卡的设计,热量没有那么集中,当然密度也是不DSS 8440水平的。

从某种角度来说,对Quadro和GeForce支持最好的应该还是工作站,比如Precision T7920和2U机架的R7920,都能支持到3块高功耗双宽显卡。并且前者是塔式工作站,如果想放在办公室有静音的需求只能用这类机型。

参考资料:Dell EMC DSS 8440: A Dynamic Machine Learning Server

https://blog.dellemc.com/en-us/dell-emc-dss-8440-dynamic-machine-learning-server/

注:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。进一步交流技术,可以加我的QQ/微信:490834312。如果您想在这个公众号上分享自己的技术干货,也欢迎联系我:)

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:HL_Storage

长按二维码可直接识别关注

历史文章汇总:http://chuansong.me/account/huangliang_storage