论文是学术研究的精华和未来发展的明灯。小白决心每天为大家带来经典或者最新论文的解读和分享,旨在帮助各位读者快速了解论文内容。个人能力有限,理解难免出现偏差,建议对文章内容感兴趣的读者,一定要下载原文,了解具体内容。

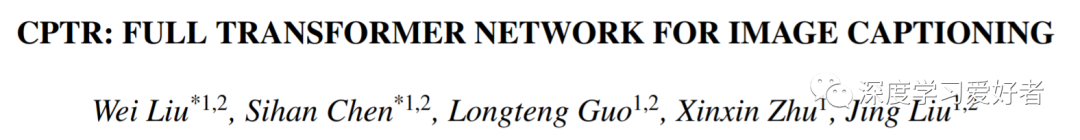

本文从一个新的序列到序列预测的角度来考虑图像字幕任务,提出了以序列化后的原始图像作为输入的字幕转换器(CPTR)。与CNN+Transformer的设计范式相比,作者的模型可以从一开始就对每个编码器层的全局上下文建模,而且完全不需要卷积。大量的实验证明了该模型的有效性,作者在MSCOCO数据集上超越了传统的CNN+Transformer方法。此外,作者提供了编码器中补丁之间的自我注意和解码器中单词到补丁的注意的详细可视化,这得益于完整的变压器架构。

相对于CNN+Transformer范式,CPTR是一种更加简单而有效的方法,完全避免了卷积运算。由于卷积的局部算子本质,CNN编码器在全局上下文建模方面存在局限性,只能随着卷积层的深入逐步扩大接受域来实现。然而,CPTR的encoder可以通过自我注意机制从一开始就利用序列化补丁之间的长期依赖关系。在词的生成过程中,CPTR对译码器交叉注意层中的词到补丁的注意进行了建模,证明了该方法的有效性。作者在MSCOCO图像字幕数据集上对作者的方法进行了评估,结果表明该方法优于CNN+RNN和CNN+Transformer字幕模型。

提出的CPTR模型的整体架构

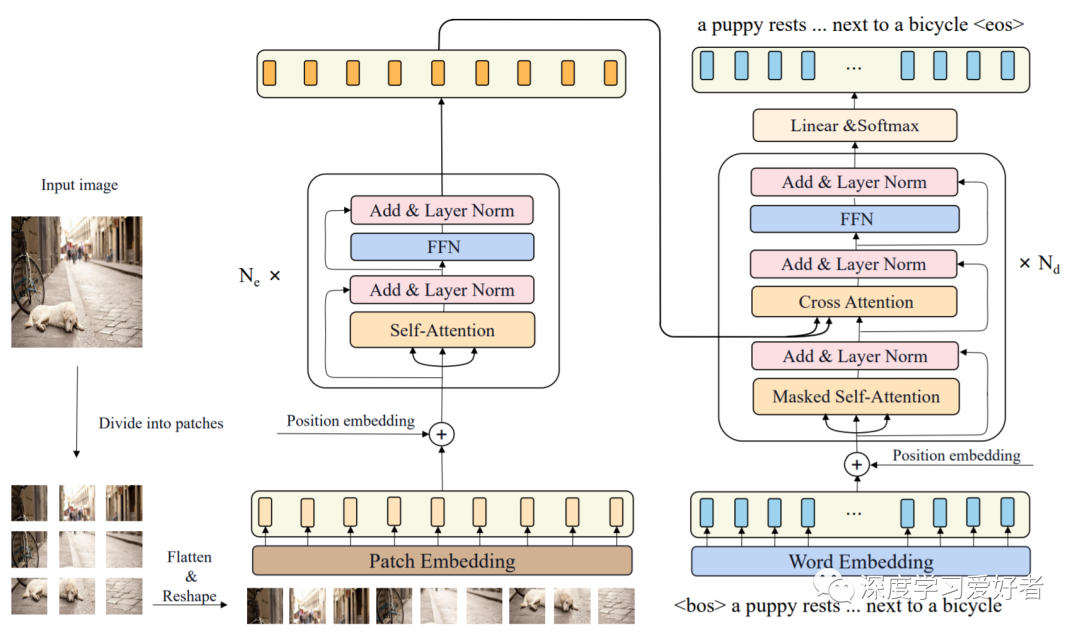

预测编码器不同层次的自我注意权值和注意头的可视化。左上角的图像是原始图像,上面的红点是选择的查询补丁。第1、2、3行分别是第1、6、12个编码器层的注意权值可视化。列在给定的层中显示不同的头。

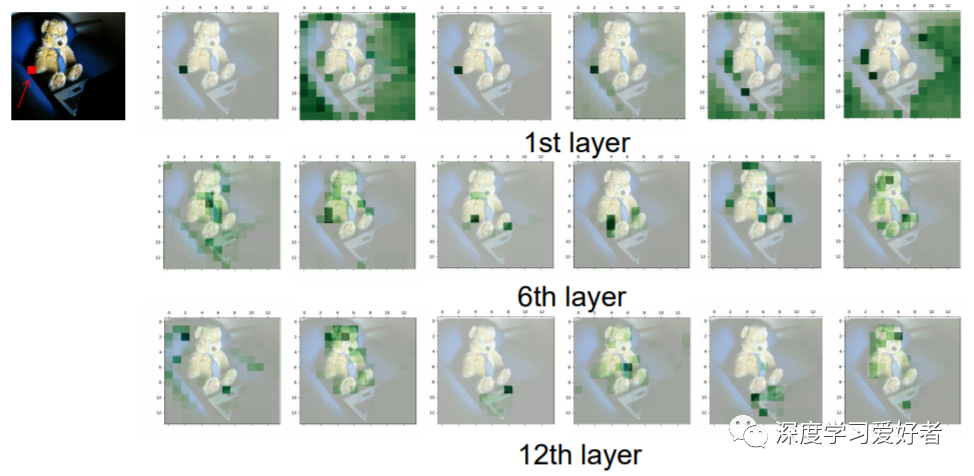

在最后的解码器层中,由字到块交叉注意计算的注意权值的可视化。一个坐在蓝色椅子上的泰迪熊和一台笔记本电脑是作者的模型生成的标题。

在本文中,作者重新思考了图像字幕作为一个序列对序列的预测任务,并提出了一个全变压器模型CPTR来代替传统的CNN+变压器过程。作者的网络是完全无卷积的,并具有从一开始就在编码器的每一层建模全局上下文信息的能力。在流行的MS COCO数据集上的评估结果证明了作者的方法的有效性,并且作者超越了CNN+Transformer网络。详细的可视化结果表明,作者的模型可以从一开始就利用长距离的依赖关系,解码器的单词到补丁的注意力可以精确地注意到相应的视觉补丁来预测单词。

论文链接:https://arxiv.org/pdf/2101.10804.pdf

声明:部分内容来源于网络,仅供读者学术交流之目的。文章版权归原作者所有。如有不妥,请联系删除。

- 机器学习交流qq群955171419,加入微信群请扫码