---- 本周为您解读 ③ 个值得细品的 AI & Robotics 业内要事 ----

1. AR 赛道距离它的 ChatGPT 时刻只差一个 LMM 了吗? LMM(大型多模态模型)为什么这么重要?为什么说 LMM 是从 GUI 到 NUI 的核心技术?NUI 是下一代消费级计算平台的破局点吗?Meta、OpenAI 等大厂在业务上有哪些布局?投身多模态大模型的大厂,谁未来最有可能在 AR 赛道取得领先优势?...LLM 发展至今都有哪些挑战?为什么大语言模型会存在“逆转诅咒”现象?幻觉问题、推理延迟等等,LLM 发展至今都有哪些病例?... 3. 硅谷 AI 独角兽两大阵营:Anthropic VS OpenAI 全线历程盘点 亚马逊、谷歌纷纷向 Anthropic 投资,他们能做什么?Anthropic VS OpenAI,各自阵营形式如何?从对标产品、融资、合作网络关系看,谁输谁赢?......本期完整版通讯含以上 3 项专题解读 + 38 项本周 AI & Robotics 赛道要事速递,其中技术方面 10 项,国内方面 8 项,国外方面 12 项...

本期通讯总计 23833 字,可免费试读至 6 % 消耗 99 微信豆即可兑换完整本期解读(约合人民币 9.9 元)

要事解读 ① AR 赛道距离它的 ChatGPT 时刻只差一个 LMM 了吗?

日期:9 月 26 日 - 9 月 30 日

事件:近日,Meta 推出了多模态版Llama2,即 AnyMAL;OpenAI 推出了 GPT-4V (ision)LMM;与此同时,Meta 推出 Meta Quest 3 VR头显,并与 Ray-Ban 合作打造的智能眼镜 Ray-Ban,两款设备均计划接入MetaAI 智能助理;随着多模态LLM技术的日益成熟,AR赛道似乎又迎来了新的曙光?

Meta 和 OpenAI 最新的 LMM 了解一下?

1、Meta 推出了多模态版 Llama2,即 AnyMAL(Any-Modality Augmented Language Model)。AnyMAL 基于 Llama 2 模型,可以对不同模态输入内容(文本、图像、视频、音频、IMU 运动传感器数据)实现理解,并生成文本响应。具体来说,这是一个经过训练的多模态编码器集合,可将来自各种模态(包括图像、视频、音频和 IMU 运动传感器数据)的数据转换到 LLM 的文本嵌入空间。[17]

2、OpenAI 上线了 GPT-4V (ision) 大模型,用户可以使用基于更新后的 ChatGPT 上传一张或多张图像配合进行对话,获取相关帮助和见解。同时,用户还可以使用设备的触摸屏圈出希望 ChatGPT 关注的图像部分。

3、OpenAI 在发布时仅放出了 18 页的技术文档,后续微软方面公布了一份长达 166 页的报告,定性地探讨了 GPT-4V 的功能和使用情况。

4、微软的报告共分为 11 个章节,重点介绍了 GPT-4V 可以执行的任务,包括:

① 用测试样本来探索 GPT-4V 的质量和通用性,现阶段 GPT-4V 能够支持的输入和工作模式,以及提示模型的有效方法。

② 对这些样本的观察表明,GPT-4V 在处理任意交错的多模态输入方面具有前所未有的能力,并且其功能的通用性使 GPT-4V 成为强大的多模态通用系统。

③ GPT-4V 对图像独特的理解能力可以催生新的人机交互方法,例如视觉参考提示(visual referring prompting)。报告最后深入讨论了基于 GPT-4V 的系统的新兴应用场景和未来研究方向。该研究希望这一初步探索能够激发未来对下一代多模态任务制定的研究,开发和增强 LMM 解决现实问题的新方法,并更好地理解多模态基础模型。[18]

5、 报告中提及 LMM 的未来趋势方向如下

① LMM 应该能够生成交织的图像文本输出,以支持全面的多模态内容理解和生成。

② LMM 应该能够从各种信息源持续学习,如网上内容、真实世界环境等,以实现持续自我进化。

③ 未来的 LMM 不应该仅仅依赖组织良好的数据进行学习,它应该能够处理更加杂乱的数据源。

④ 未来 LMM 的学习过程不应该仅仅依赖于图像-文本对的数据集,应该是更加通用和连续的。[23]

LMM 为什么这么重要?为何基于 LMM 的 NUI 已成为科技大厂必争之地?[19][20][21][22]

1、AR 技术的目标是为用户提供一个沉浸式、真实和自然的体验。尽管 AR 技术已经取得了一定的进展,但它仍未真正达到类似 ChatGPT 上线时令用户惊叹的 “aha moment”。核心的问题在于 NUI(自然用户界面)的体验尚不完善。

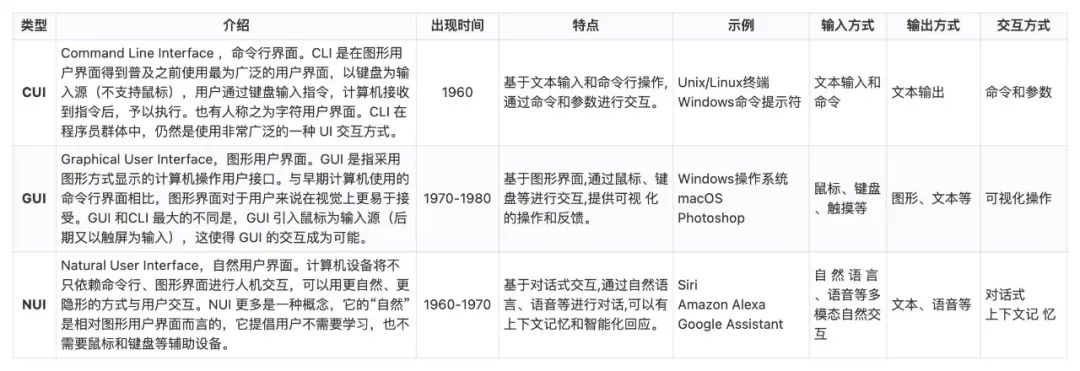

2、NUI 是指一种用户界面设计哲学,旨在使用户与计算机系统或设备的交互尽可能自然和直观。这通常涉及触摸、手势、语音和其他自然的交互方式。

3、为了实现真正的沉浸式体验,AR 应用通常需要用户能够以最自然、直观的方式与其互动,这就是 NUI 的核心。例如,用户可能通过手势、眼动、语音命令或身体动作与 AR 内容进行交互。这种交互方式不仅更符合 AR 的沉浸式特性,而且在许多情况下(如穿戴 AR 眼镜时)也更为实用和方便。

4、LMM 可以处理多种类型的输入,如文本、图像、声音等,从而为用户提供更加丰富和多样化的交互体验。这些模型的能力不仅仅是识别和生成内容,更重要的是理解和响应用户的需求,为他们提供有价值的反馈。

① 多模态是指将多种感官进行融合,而多模态交互是指人通过声音、肢体语言、信息载体(文字、图片、音频、视频)、环境等多个通道与计算机进行交流,充分模拟人与人之间的交互方式。

② 多模态技术的目标是让 AI 能够同时处理和理解多种类型的输入,如文本、图像、声音等,从而为用户提供更加自然和直观的交互体验。

5、基于 LMM 的 AI Agent、智能助理等交互式 AI 可以为 NUI 提供智能,使其能够理解和响应用户的需求,而 NUI 为交互式 AI 提供了一种自然、直观的交互方式。