©作者 | 钟楠、徐怡然等

单位 | 复旦大学多媒体智能安全实验室

研究方向 | 多媒体与人工智能安全

随着 AIGC 技术的发展,由 AI 所生成的虚假图像的检测正成为一个新的研究热点。然而,现有检测方法的实验条件与测试数据集不完全相同,无法直接横向对比检测性能。为此,复旦大学计算机学院多媒体智能安全实验室针对现有主流AIGC 图像检测方案进行全面分析与比较,并提出了性能更好的 AIGC 图像检测 新方法。

更进一步,课题组提供了一个综合测试与评估平台,在保证相同训练集与实验条件的情况下,分析并测试了目前检测算法的检测准确率与泛化性等性能指标,为 AIGC 生成图像检测领域提供一项基准的实验对比平台(Benchmark),同时整合并开源了多种现有 AIGC 生成图像的检测算法,供同行研究比较。欢迎大家下载源代码、测评比较,并引用课题组在 arXiv 公开的论文。

论文标题:

Rich and Poor Texture Contrast: A Simple yet Effective Approach for AI-generated Image Detection

钟楠,徐怡然,钱振兴,张新鹏

https://fdmas.github.io/AIGCDetect/

https://github.com/Ekko-zn/AIGCDetectBenchmark

https://arxiv.org/abs/2311.12397

引言

近年来,AI 生成图像在视觉质量、语义复杂度、运行时间效率等方面都有了显著提升。生成虚假图像所需的专业知识和成本也都有了明显下降,各大生成图像平台纷纷涌现,人人都可以使用在线工具(如 Midjourney,DALL·E 等),根据自己的需求生成虚假图像。

Midjourney 是近年来最火爆的在线图像生成平台,目前已经更新到了第 5.2 代,用户可以付费使用。DALL·E 由 OpenAI 公司研发,用户可以付费后将 DALL·E 3 模型和 ChatGPT Plu 版、企业版结合使用。微软公司还将 DALL·E 模型整合到了 Bing 聊天功能中,在 Microsoft Edge 浏览器中向用户提供服务。

Stability AI 公司研发的 Stable Diffusion 已经开源了 Stable Diffusion v2.0, v2.1 和 XL 等多个版本的预训练模型。用户可以使用在线接口或者使用开源模型在本地计算。这些都是强大的 text-to-image 工具,根据用户输入的文字生成相应内容的高质量图像。除此之外,Pixeling、wukong 等等在线平台还支持中文输入的 text-to-image 功能。

这前所未有的可访问性引发了人们对虚假信息普遍传播的担忧。

根据 Lago 等人的研究 [1] ,受访者将 StyleGAN 生成图像中的 68% 标记为“真实的”,却将真实图像中的 48% 标记为“虚假的”。可见生成图像已经能够“欺骗”人类的眼睛,开发有效的检测工具迫在眉睫。

目前,已有许多针对 AI 生成虚假图像的检测工作 [2-9],然而,它们在性能分析实验中存在着一定的不一致性和不足。

1. 训练集的不一致:在实际应用中,由于待检测的AI生成图像的生成模型是不可知的,因此检测器的泛化性,即检测器对在训练阶段未见过的数据的检测性能,是评估检测器的一个重要标准。为了保证比较的公平性,所有检测器都应在同一训练集上训练而得。然而目前 SOTA 检测方法所提供的预训练模型普遍使用了不同的训练集,无法公平地对比泛化性。

2. 测试集的多样性不足:大部分检测方法都致力于准确、高效地区分 GAN 生成图像和真实图像,却忽视了扩散模型的强大能力,并没有测试在扩散模型生成图像数据集上的准确率。因此无法评估这些方法在扩散生成模型上的泛化性。

上述问题对后续的研究工作产生了一定的阻碍。相关研究人员需要花费大量的时间、精力和计算资源来复现现有检测方法,来进一步补充验证实验。为了解决这一问题,我们使用同一训练集来训练各种不同的 AI 生成图像检测器,并进行了一系列针对现有方法的基准测试,来评估现有方法在泛化性、鲁棒性上的能力。

我们共选取了 9 个 SOTA 检测方法 [2-10],在 16 个生成图像数据集上进行了大量测试。旨在提供一种标准化的方式来比较不同方法的性能,以便发现现有方法存在的优缺点,为后续工作的开展提供方便的基准分析框架,以及有价值的参考指标和改进方向。此外,我们还整合了现有 SOTA 方法的测试接口,并开源了所有检测器的预训练模型。

我们进行了一系列的实验来分析这些检测方法在各类 GAN、Diffusion Model 生成图像上的泛化性和鲁棒性。

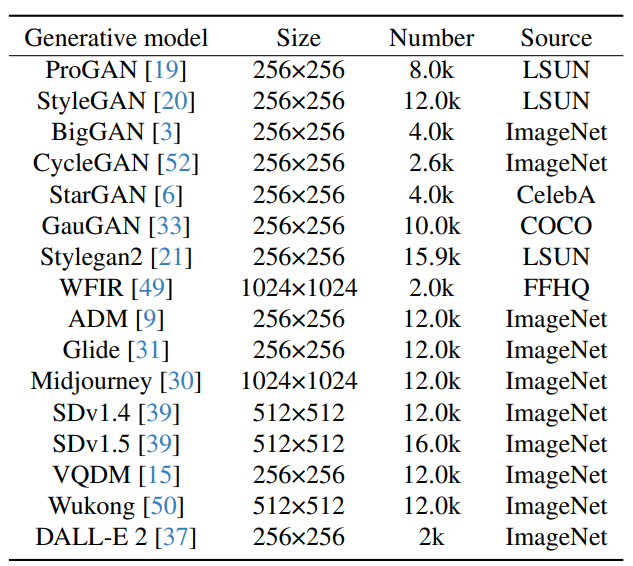

▲ 表1. 测试数据集概览

我们采用的训练数据集是由 Wang 等人 [2] 提供的 ProGAN 生成图像数据集。测试数据集的构建则使用了各种生成模型,包括一些先进的商用生成器(如 Midjourney,DALL·E 2),以更全面地评估和比较每种检测器的泛化性。测试集包含 Wang 等人 [2] 和 Zhu [11] 等人提供的数据集、以及我们自己构造的生成图像数据集,共计 16 个。部分实验结果如下所示:

▲ 图1. 各检测方法在不同数据集上的检测准确率

图 1 中,各雷达图的中心表示检测准确率为 0%,最内侧的圆环表示检测准确率为 20%,以此类推,最外侧的圆环表示检测准确率为 100%。最外侧标记了 16 个数据集,每个数据点表示该检测方法在对应数据集上的检测准确率。数据点越靠外侧圆环,说明在该数据集上的准确率越高。从整体上来说,一个更靠外的十六边形(更接近圆的图形)表示该检测方法具有更好的泛化性能。

实验中我们用到的检测方法有:

[CNNSpot] Wang 等人 [2] 提出了使用 ResNet50 模型训练用于分辨真实图像和生成图像的二分类器,并在训练过程中加入了对图像的随机预处理(JPEG 压缩、高斯模糊、图像大小调整等)来提升模型的泛化能力。

[FreDect] Frank 等人 [3] 分析了多种流行的 GAN 模型生成的虚假图像在频域上的特征,并发现这些虚假图像在频域上都存在着类似的,由上采样操作留下的伪影。基于这个发现,提出了基于频域特征的二分类器。

[Gram-Net] Liu 等人 [4] 把检测重心放在 GAN 生成的虚假人脸上。发现合成人脸在纹理统计上与真实人脸图像有着明显的区别,并且,全局纹理信息可以有效提升检测器的泛化性和对各种图像失真的鲁棒性。在 CNN 模型的基础上,引入了 Gram 模块来提取图像的全局纹理信息,构成了 Gram-Net。

[Fusing] Ju 等人 [5] 使用双分支框架,将全局图像特征与信息丰富的局部块特征相结合,以增强合成图像检测的泛化能力。此外,借助基于注意力机制的块选择模块,能够自动选择多个块,无需手动标注即可有效提取局部微小伪造特征。

[UnivFD] Ojha 等人 [8] 分析了 CNNSpot 分类器学习到的决策边界具有不对称性,虽然可以有效区分出 GAN 生成的虚假图像,但是真实图像的特征空间并不具有独立性,即所有非 GAN 生成的图像(真实图像、Diffusion 生成图像)都被归为了一类。因此,Ojha 等人认为,要提升检测器的泛化性,使其合理区分真实图像和虚假图像,即学习到平衡的决策边界,需要一个合适的特征空间。Ojha 等人使用了预训练的 CLIP:ViT 模型来提取特征空间。

[LGrad] Tan 等人 [7] 在开始训练分类器之前,使用一个预训练 CNN 模型(如 VGG16, ResNet50, ProGAN 的鉴别器等等)将图像转换成梯度图,并归一化到 [0,255]。在梯度图数据集上训练得到一个区分真实图像和生成图像的二分类器。

[LNP] Liu 等人 [6] 对真实图像的噪声模式进行了频域分析,发现在真实图像之间,这种噪声模式存在着一致性,而生成图像之间的噪声模式则差距很大,因此可以根据图像的噪声模式来分类。噪声模式是原始图像减去去噪图像后,得到的没有语义干扰的模式。

[DIRE] Wang 等人 [9] 注意到了现有生成图像检测方法在扩散模型上的性能有明显下降,因此提出了一个新的检测方法。他们发现与真实图像相比,通过预先训练的扩散模型可以更准确地重建扩散过程产生的图像。在此预设基础上,提出了扩散重构错误(DIffusion REconstruction Error, DIRE),用于检测基于扩散模型的生成图像。

[RPTC] Zhong 等人 [10] 利用了图像内丰富和贫乏纹理区域之间的像素间相关性对比度来检测 AI 生成图像。他们发现纹理复杂区域中的像素表现出比纹理平坦区域中更显著的波动。基于这一原理,他将图像划分为多个块,并将其重建为两个图像,分别包括复杂纹理块和平坦纹理块。随后,提取了复杂纹理区域和平坦纹理区域之间的像素间相关性差异特征,作为一种通用“指纹”,用于不同生成模型中的生成图像取证。

[1] Lago F, Pasquini C, Böhme R, et al. More real than real: A study on human visual perception of synthetic faces [applications corner][J]. IEEE Signal Processing Magazine, 2021, 39(1): 109-116.[2] Wang S Y, Wang O, Zhang R, et al. CNN-generated images are surprisingly easy to spot... for now[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020: 8695-8704.[3] Frank J, Eisenhofer T, Schönherr L, et al. Leveraging frequency analysis for deep fake image recognition[C]//International conference on machine learning. PMLR, 2020: 3247-3258.

[4] Liu Z, Qi X, Torr P H S. Global texture enhancement for fake face detection in the wild[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020: 8060-8069.

[5] Ju Y, Jia S, Ke L, et al. Fusing global and local features for generalized ai-synthesized image detection[C]//2022 IEEE International Conference on Image Processing (ICIP). IEEE, 2022: 3465-3469.

[6] Liu B, Yang F, Bi X, et al. Detecting generated images by real images[C]//European Conference on Computer Vision. Cham: Springer Nature Switzerland, 2022: 95-110.

[7] Tan C, Zhao Y, Wei S, et al. Learning on Gradients: Generalized Artifacts Representation for GAN-Generated Images Detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023: 12105-12114.

[8] Ojha U, Li Y, Lee Y J. Towards universal fake image detectors that generalize across generative models[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023: 24480-24489.

[9] Wang Z, Bao J, Zhou W, et al. DIRE for Diffusion-Generated Image Detection[J]. arXiv preprint arXiv:2303.09295, 2023.

[10] Zhong N, Xu Y, Qian Z, et al. Rich and Poor Texture Contrast: A Simple yet Effective Approach for AI-generated Image Detection[J]. arXiv preprint arXiv:2311.12397, 2023.

[11] Zhu M, Chen H, Yan Q, et al. GenImage: A Million-Scale Benchmark for Detecting AI-Generated Image[J]. arXiv preprint arXiv:2306.08571, 2023.

多媒体智能安全实验室(MAS Lab)现有教师3位(张新鹏教授、钱振兴教授、李晟副教授)、在站博士后2位、在读博士生19位、在读硕士生30位,主要研究多媒体与人工智能安全,包括信息隐藏、多媒体取证、人工智能安全、虚拟机器人、多媒体应用等五个方向。实验室团队已发表学术论文400余篇,多篇论文发表在IEEE TPAMI、TIFS、TIP、TDSC、TCSVT、TMM、TCYB、TCC、TASPL、AAAI、IJCAI、NeurIPS、ACM MM、ICCV、CIKM等顶刊顶会上。欢迎青年才俊加入复旦多媒体智能安全实验室!

复旦大学多媒体智能安全实验室主页:

https://fdmas.github.io/

神经网络模型研究资源:

https://fdmas.github.io/research/Neural_Network_Watermarking.html

虚假新闻检测研究资源:

https://fdmas.github.io/research/fake-news-detection.html

AIGC取证主页:

https://fdmas.github.io/AIGCDetect/

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧