点击“计算机视觉life”,选择“星标”

机器人AI干货第一时间送达

在视觉SLAM中,长期视觉定位是非常关键且有挑战性的工作。主要涉及到光照变化和动态物体的问题。因此,深度学习如何解决室内动态物体和提高地图的光照、视角不变性则是目前更为可行的研究内容。

针对实际的工程落地中面临的鲁棒性和精度问题,我们能做的是:使用在嵌入式NPU或GPU的运行的轻量级网络,将视觉SLAM中难以用手工方法表达的、难以建立精确模型的模块用数据驱动的方法替换掉,而将传统SLAM中精确的建模和求解过程保留。这样既保留了传统方法的优势,又能有效利用深度学习的强大表达能力,使得整体算法在鲁棒性、精度等方面上一个台阶。

针对结合深度学习方法和传统方法解决长期视觉定位问题,计算机视觉life联合华中科技大学博士LIN YI合作了《基于深度学习特征的长期视觉定位系统》项目实践课程。他的代表性工作是LET-NET,将学习方法和传统的光流结合,首次提出了混合光流法的概念。获得ICCV2023年的视觉SLAM挑战赛亚军。并发表多篇一区期刊论文。

https://github.com/linyicheng1/LET-NET

https://github.com/linyicheng1/LET-NET

在视觉SLAM中,如何保存视觉地图并重复用于机器人定位是目前较为欠缺的一环。尽管ORB-SLAM3等系统提供了保存地图的定位模式,但是在光照变化场景中的精度和鲁棒性都难以保障。

另一方面,深度学习特征在大视角、大光照场景下实现了稳定的匹配效果,尽管通常计算量较大。因此,如何实现高效、稳定的长期视觉定位系统便成了本项目尝试解决的问题。

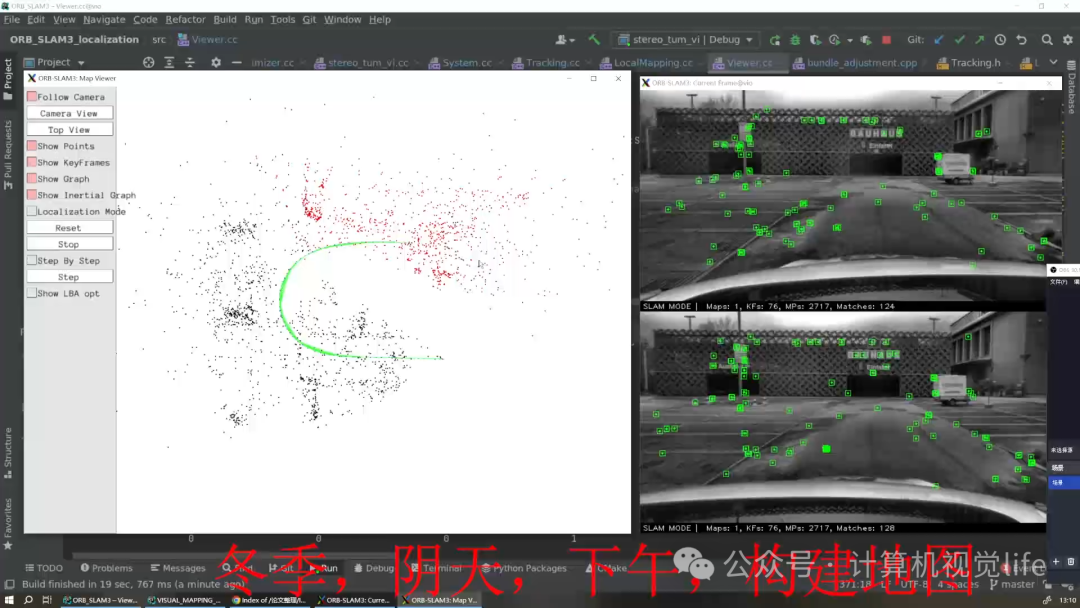

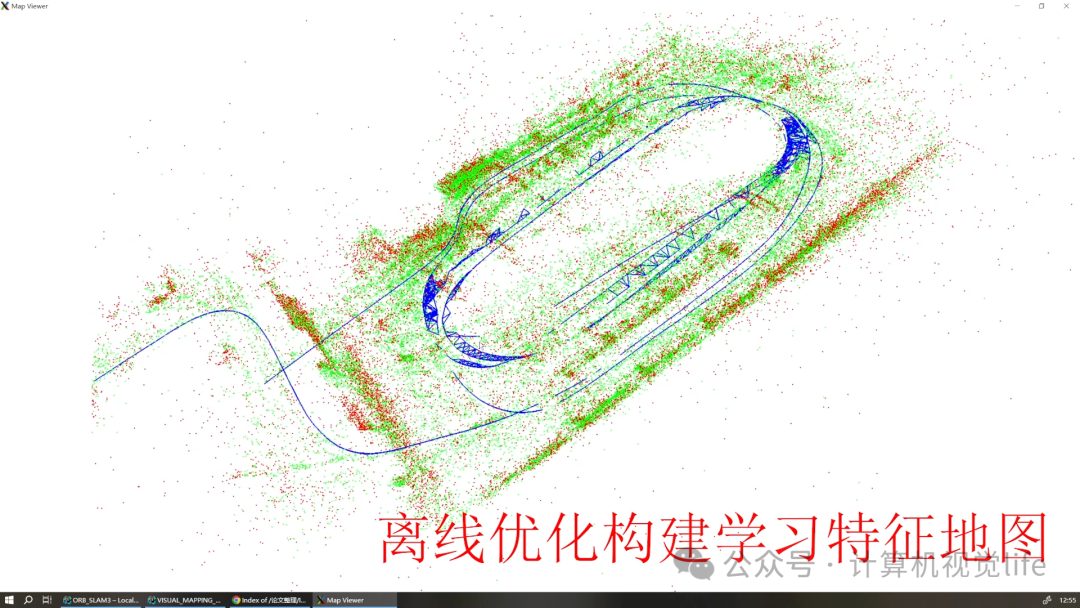

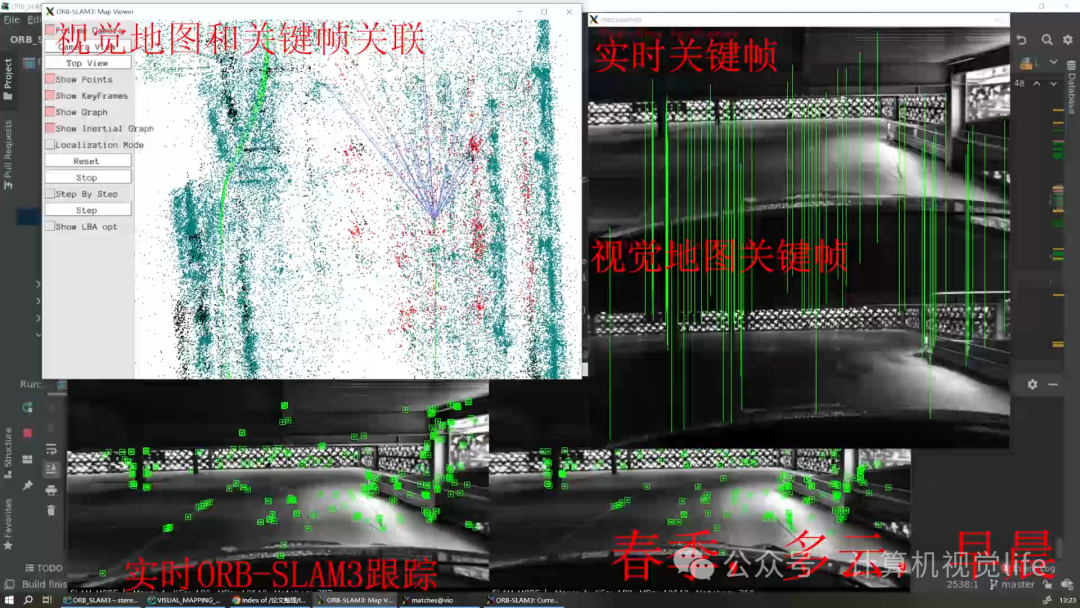

本项目以ORB-SLAM3的双目模式为基础,首先构建ORB特征地图并获得运动轨迹。然后基于目前主流的深度学习特征如SuperPoint、D2-Net等离线构建深度学习特征视觉地图。最后,实现在OBR-SLAM3系统中的定位模式修改,在关键帧中添加深度学习特征约束,实现长期视觉定位。效果如下

视频demo见下

这次项目课程理论和实践并重,老师带领大家在2个月内复现该项目。大家动手改进代码的方式帮助大家开启真正的项目实战,并提高学员的基础,编程、项目实战能力,找到问题以及解决实际面临问题的能力。

不要错过这次的重磅项目课程,《基于深度学习特征的长期视觉定位系统》小班教学,限额8人(报满提前截止)。主要亮点:

详细介绍及报名见下面海报