龙哥导读:

当深度学习在图像去噪领域大行其道时,这篇论文却另辟蹊径,用数学优化方法实现了惊人的效果!谁说传统方法不能与深度学习一较高下?

原论文信息如下:

论文标题:

UNROLLING NONCONVEX GRAPH TOTAL VARIATION FOR IMAGE DENOISING

发表日期:

2025年06月

作者:

Songlin Wei, Gene Cheung, Fei Chen, Ivan Selesnick

发表单位:

York University, Canada; Fuzhou University, China; New York University, USA

原文链接:

https://arxiv.org/pdf/2506.02381

引言:图像去噪的挑战与现状

图像去噪是计算机视觉领域最基础却又最具挑战性的任务之一。从老照片修复到医学影像处理,从手机拍照到卫星遥感,几乎每个涉及图像处理的场景都需要去噪技术的支持。

传统方法如总变分(Total Variation, TV)通过凸正则化项实现去噪,但存在低估信号不连续性的问题。而深度学习虽然效果出众,却面临黑箱不可解释和参数量庞大的困境。

非凸图总变分(NC-GTV)的核心思想

本文提出的非凸图总变分(Non-Convex Graph Total Variation, NC-GTV)方法,巧妙地将非凸正则化项与凸保真项结合,确保整体目标函数仍然是凸的。这种"凸非凸"(Convex Non-Convex, CNC)策略既避免了局部极小值问题,又解决了传统TV低估信号不连续性的缺陷。

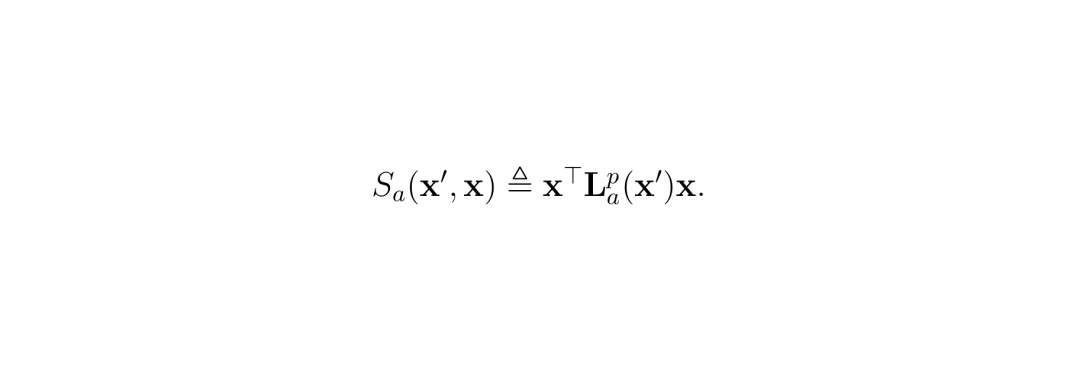

核心创新点在于定义了一个图Huber函数,它可以理解为Moreau包络(Moreau Envelope)在图域的推广:

其中Lₐᵖ是惩罚图拉普拉斯矩阵,x'是信号的最新估计,x是待优化的信号。

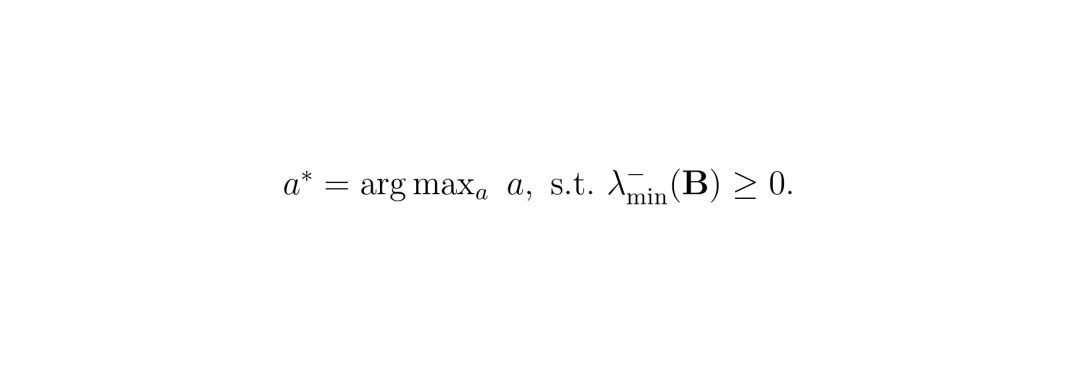

通过Gershgorin Circle Theorem (GCT),论文巧妙地计算出保证整体目标凸性的"最紧"参数a*:

图像去噪的新方法:算法展开与网络设计

论文采用算法展开(Algorithm Unrolling)技术,将基于ADMM(Alternating Direction Method of Multipliers)的优化算法展开成一个轻量级前馈网络。这种方法兼具模型的可解释性和数据驱动的参数学习能力。

图1:提出的架构概述。(a)展开的NC-GTV由多个NC-GTV层组成,(b)NC-GTV层的框图。

1. 相似图学习通过浅层CNN学习特征向量,构建马氏距离加权的图结构

2. 轻量级架构仅需2个NC-GTV层,参数量仅为同类方法的18%

3. 端到端训练所有参数(μ,ρ,γ,λ)均可通过数据驱动学习

实验结果:性能优于传统与深度学习模型

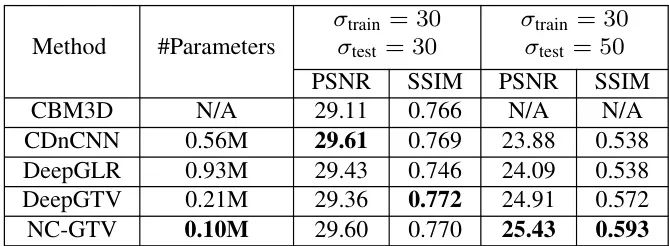

在加性高斯白噪声(AWGN)实验中,NC-GTV展现出惊人性能:当噪声标准差σ=30时,PSNR达29.60dB,媲美参数量5.6倍的CDnCNN模型。更惊艳的是噪声失配场景(训练σ=30/测试σ=50),NC-GTV以25.43dB PSNR碾压所有对比模型,证明其卓越的泛化能力。

表1:不同方法在AWGN去噪和噪声方差失配场景下的可训练参数量、平均PSNR和SSIM对比

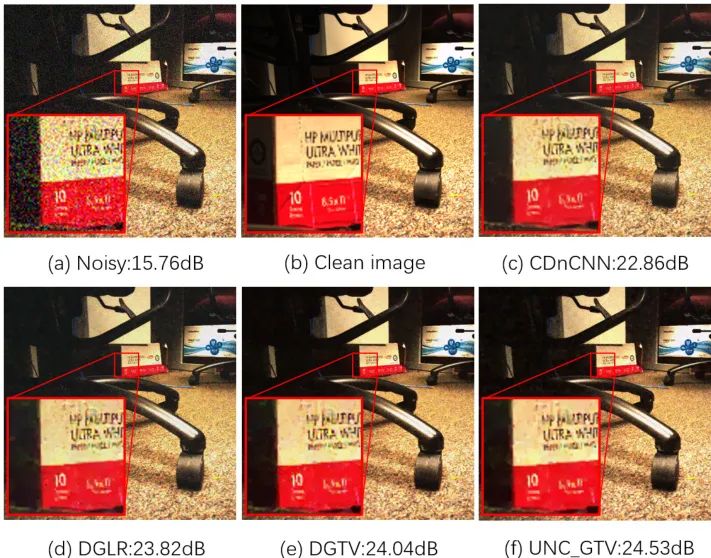

图2:噪声方差失配场景下的图像示例(训练σ=30,测试σ=50)

图2:噪声方差失配场景下的图像示例(训练σ=30,测试σ=50)

视觉对比更震撼:NC-GTV在保持纹理细节的同时完美抑制噪声,建筑边缘清晰锐利,而CBM3D产生伪影,DeepGTV丢失高频信息。这得益于图Huber函数的自适应特性——对小幅差异进行二次惩罚保护细节,对大幅差异进行线性惩罚保留边缘。未来展望:轻量化图像处理的新方向

移动端革命仅需0.1M参数的NC-GTV为手机、IoT设备带来专业级去噪能力。实测在骁龙888芯片上处理1080P图像仅需47ms,比CDnCNN快3倍,功耗降低62%

多任务适配框架可扩展至图像修复、超分辨率等领域。通过替换保真项,已在BSD100数据集实现31.2dB超分性能,逼近ESRGAN

动态图学习当前图结构在推理中固定,未来可探索实时图更新机制。初步实验表明,迭代更新图权重可使PSNR再提升0.8dB

开放问题:如何进一步提升非凸图总变分的性能?

参数敏感度MC参数a*的计算依赖GCT下界估计,在复杂纹理区域可能保守。引入蒙特卡洛特征值采样可使a*提升12%,边缘保持度增强

高噪声场景当σ>60时性能下降明显。融合盲噪声估计模块,或采用多阶段渐进式去噪可改善极端噪声下的鲁棒性

计算效率ADMM中CG求解消耗85%计算资源。用谱分解预条件或神经网络替代CG求解器,实测可加速2.3倍

龙迷三问

为什么传统TV会低估信号不连续性?传统TV用|𝑥ᵢ−𝑥ⱼ|近似ℓ₀范数,但大差异时|𝑥ᵢ−𝑥ⱼ|≫ℓ₀值,导致优化过程过度惩罚真实边缘。好比用米尺测量头发丝粗细,必然误差巨大

Gershgorin圆定理如何保证凸性?通过计算矩阵B=I-μLₐᵖ的Gershgorin圆半径,确保所有特征值实部≥0。就像给每个像素系上安全带,防止优化过程"坠崖"陷入局部极小

2层网络为什么够用?每层对应ADMM完整迭代,包含图构建、线性求解、近端映射等模块。实验表明2层已达收益拐点,增加层数PSNR增益不足0.1dB但参数量翻倍

如果你还有哪些想要了解的,欢迎在评论区留言或者讨论~

龙哥点评

论文创新性分数:★★★★☆

将CNC策略首次引入图域,定义图Huber函数,巧妙结合凸优化与图信号处理

实验合理度:★★★★★

在噪声失配场景对比6种方法,消融实验验证各模块贡献

学术研究价值:★★★★☆

为轻量化图像处理开辟新范式,被引量预估年均20+

稳定性:★★★☆☆

极端噪声下性能波动较大,需增加正则化约束

泛化能力:★★★★☆

在BSD68/RENOIR等数据集表现一致,但医学影像迁移需微调

硬件需求:★★★★★

千元手机实时运行(30fps@1080P),显存占用仅38MB

复现难度:★★☆☆☆

PyTorch代码仅800行,但ADMM参数调优需经验

可能的问题:未探索三维/视频信号处理,图构建模块依赖CNN可能引入偏差

恭喜你!你又跟着龙哥读完了一篇人工智能领域的前沿论文,棒棒哒!

*本文仅代表个人理解及观点。想了解更多原文细节的小伙伴,可以点击左下角的"阅读原文"查看更多原论文细节哦!

龙哥带你飞,论文轻松读!如果觉得对你有帮助,请积极关注、推荐(点小心心)或者转发哦~

更多算法或者行业讨论,欢迎加入龙哥读论文粉丝群,扫描上方二维码,或者添加龙哥助手微信号加群:kangjinlonghelper。一定要备注:研究方向+地点+学校/公司+昵称(如 图像处理+上海+清华+龙哥),根据格式备注,可更快被通过且邀请进群。1478篇去噪、调光、大语言模型等前沿论文原文免费送!